Sifat “kotak hitam” dari model bahasa besar (LLM) selalu menjadi masalah penting yang mengganggu bidang kecerdasan buatan. Hasil keluaran model yang tidak dapat diinterpretasikan membuat sulit untuk menjamin keandalan dan kredibilitasnya. Untuk mengatasi masalah ini, OpenAI telah meluncurkan teknologi baru yang disebut Prover-Verifier Games (PVG), yang bertujuan untuk meningkatkan interpretabilitas dan verifikasi keluaran LLM. Editor Downcodes akan menjelaskan teknologi ini secara detail untuk Anda.

OpenAI baru-baru ini merilis teknologi baru bernama Prover-Verifier Games (PVG), yang bertujuan untuk memecahkan masalah "kotak hitam" keluaran model kecerdasan buatan.

Bayangkan Anda memiliki asisten yang sangat cerdas, namun proses berpikirnya seperti kotak hitam dan Anda tidak tahu bagaimana ia mencapai kesimpulannya. Apakah ini terdengar agak tidak nyaman? Ya, ini adalah masalah yang dihadapi oleh banyak model bahasa besar (LLM) saat ini. Meskipun kuat, keakuratan konten yang mereka hasilkan sulit diverifikasi.

URL Makalah: https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf

Untuk mengatasi masalah ini, OpenAI meluncurkan teknologi PVG. Sederhananya, membiarkan model kecil (seperti GPT-3) mengawasi keluaran model besar (seperti GPT-4). Ini seperti bermain game, Prover bertanggung jawab untuk menghasilkan konten, dan Verifikator bertanggung jawab untuk menentukan apakah konten tersebut benar. Kedengarannya menarik?

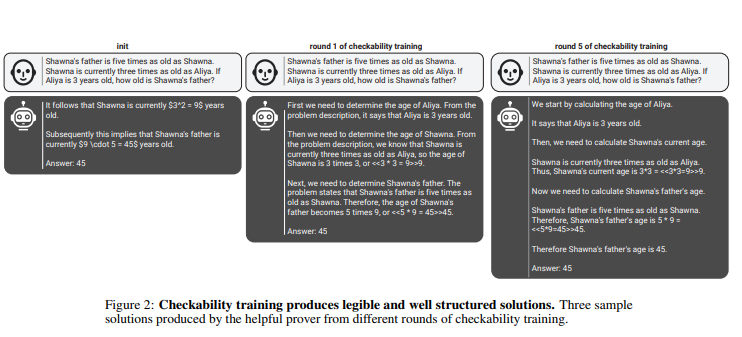

Dalam aturan ini, pembukti dan verifikator terus meningkatkan kemampuan mereka melalui beberapa putaran pelatihan berulang. Verifikator menggunakan pembelajaran yang diawasi untuk memprediksi kebenaran konten, sementara pembukti menggunakan pembelajaran penguatan untuk mengoptimalkan konten yang mereka hasilkan. Yang lebih menarik lagi, ada dua jenis peribahasa: peribahasa yang berguna dan peribahasa yang licik. Pembukti yang berguna berusaha keras untuk menghasilkan konten yang benar dan meyakinkan, sementara pembukti yang licik mencoba menghasilkan konten yang tidak benar namun sama-sama meyakinkan, sehingga menantang penilaian pemeriksa.

penaAI menekankan bahwa untuk melatih model verifikator yang efektif, diperlukan sejumlah besar data label yang nyata dan akurat untuk meningkatkan kemampuan pengenalannya. Jika tidak, meskipun teknologi PVG digunakan, konten yang diverifikasi mungkin masih berisiko dihasilkan secara ilegal.

Menyorot:

? Teknologi PVG memecahkan masalah "kotak hitam" AI dengan memverifikasi keluaran model besar dengan model kecil.

? Kerangka pelatihan didasarkan pada teori permainan dan mensimulasikan interaksi antara pembukti dan pemverifikasi, sehingga meningkatkan akurasi dan pengendalian keluaran model.

? Sejumlah besar data nyata diperlukan untuk melatih model verifikator guna memastikan bahwa model tersebut memiliki penilaian dan ketahanan yang memadai.

Secara keseluruhan, teknologi PVG OpenAI memberikan ide baru untuk memecahkan masalah "kotak hitam" model kecerdasan buatan, namun efektivitasnya masih bergantung pada data pelatihan berkualitas tinggi. Perkembangan teknologi ini di masa depan patut untuk dinantikan, karena akan mendorong pengembangan model kecerdasan buatan ke arah yang lebih andal, dapat dijelaskan, dan dapat dipercaya. Editor Downcodes berharap dapat melihat lebih banyak lagi teknologi inovatif serupa yang muncul.