Editor Downcodes akan memberi Anda pemahaman mendalam tentang rahasia model Transformer! Baru-baru ini, sebuah makalah berjudul "Lapisan Transformator sebagai Pelukis" dengan gamblang menjelaskan mekanisme kerja lapisan tengah model Transformer dari sudut pandang "pelukis". Melalui metafora dan eksperimen cerdas, makalah ini mengungkap cara kerja hierarki Transformer, memberikan ide-ide baru bagi kita untuk memahami pengoperasian internal model bahasa besar. Dalam makalah tersebut, penulis membandingkan setiap lapisan Transformer dengan seorang pelukis, bekerja sama untuk menciptakan gambaran bahasa yang besar, dan memverifikasi pandangan ini melalui serangkaian eksperimen.

Dalam dunia kecerdasan buatan, terdapat kelompok pelukis khusus - struktur hierarki dalam model Transformer. Mereka ibarat kuas ajaib, melukis dunia penuh warna di atas kanvas bahasa. Baru-baru ini, makalah berjudul Transformer Layers as Painters memberikan perspektif baru bagi kita untuk memahami mekanisme kerja lapisan tengah Transformer.

Model transformator, sebagai model bahasa skala besar paling populer saat ini, memiliki milyaran parameter. Setiap lapisannya ibarat seorang pelukis, bekerja sama untuk melengkapi gambaran bahasa yang agung. Namun bagaimana para pelukis ini bekerja sama? Apa perbedaan kuas dan cat yang mereka gunakan? Tulisan ini mencoba menjawab pertanyaan-pertanyaan tersebut.

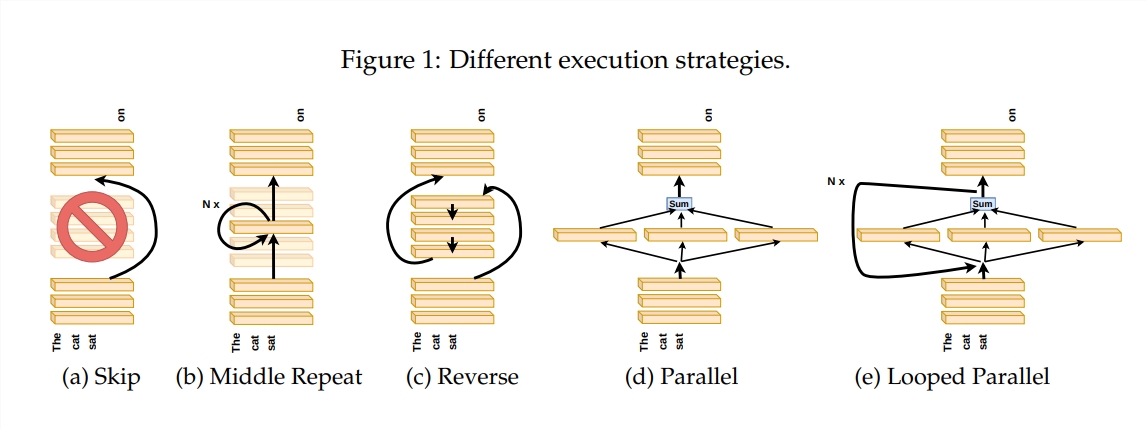

Untuk mengeksplorasi cara kerja lapisan Transformer, penulis merancang serangkaian eksperimen, termasuk melewatkan lapisan tertentu, mengubah urutan lapisan, atau menjalankan lapisan secara paralel. Eksperimen ini seperti menetapkan aturan melukis yang berbeda bagi para pelukis untuk melihat apakah mereka dapat beradaptasi.

Dalam metafora "pipa pelukis", masukan dipandang sebagai kanvas, dan proses melewati lapisan perantara seperti melewati kanvas di jalur perakitan. Setiap "pelukis", yaitu setiap lapisan Transformer, akan memodifikasi lukisan sesuai dengan keahliannya masing-masing. Analogi ini membantu kita memahami paralelisme dan skalabilitas lapisan Transformer.

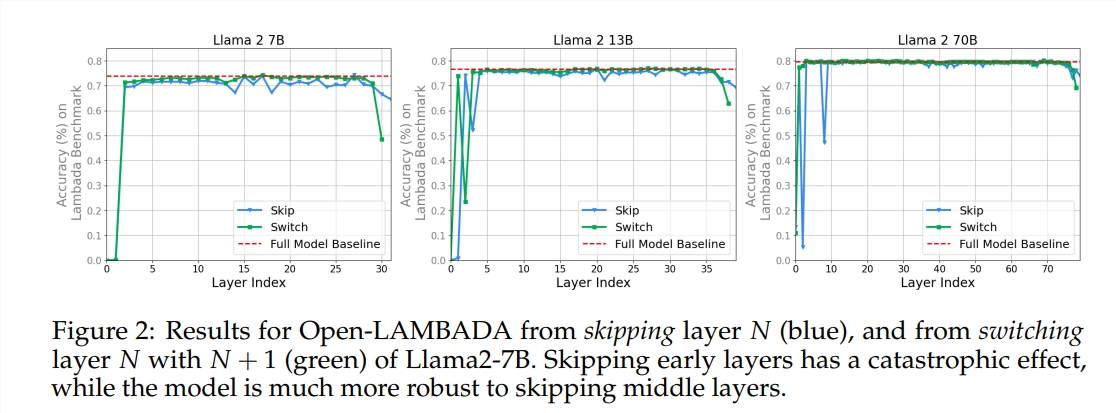

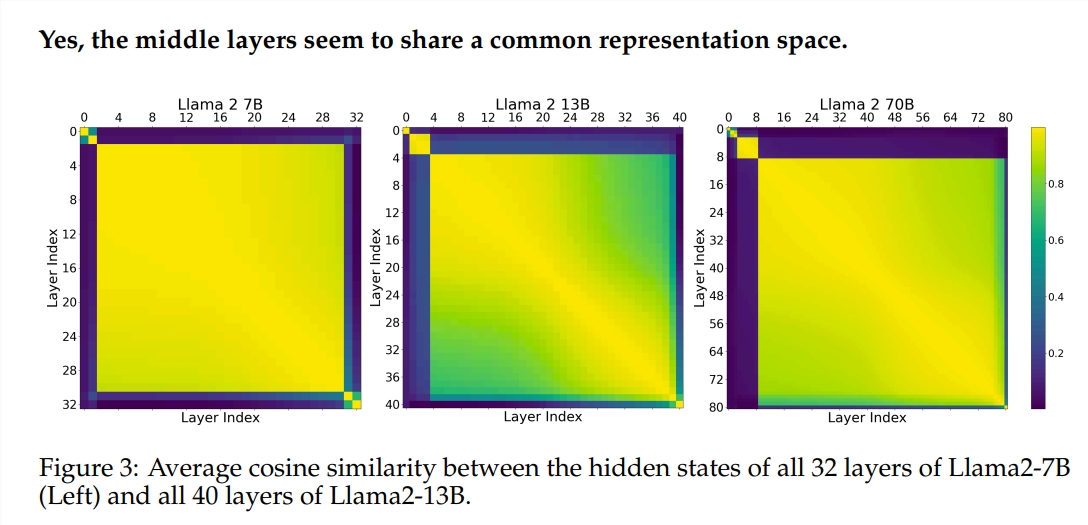

Eksperimen ini menggunakan dua model bahasa besar (LLM) terlatih: Llama2-7B dan BERT. Studi ini menemukan bahwa para pelukis di tingkat menengah sepertinya berbagi kotak cat yang sama—mewakili ruang—berbeda dengan pelukis di tingkat pertama dan terakhir. Pelukis yang melewatkan lapisan perantara tertentu akan berdampak kecil pada keseluruhan lukisan, yang menunjukkan bahwa tidak semua pelukis diperlukan.

Meski pelukis di lapisan tengah menggunakan kotak cat yang sama, namun mereka menggunakan keahliannya sendiri untuk melukis pola berbeda di atas kanvas. Jika Anda sekadar menggunakan kembali teknik pelukis tertentu, lukisan tersebut akan kehilangan pesona aslinya.

Urutan menggambar sangat penting untuk tugas matematika dan penalaran yang memerlukan logika ketat. Untuk tugas-tugas yang mengandalkan pemahaman semantik, dampak keteraturan relatif kecil.

Hasil penelitian menunjukkan bahwa lapisan tengah Transformer memiliki tingkat konsistensi tertentu tetapi tidak berlebihan. Untuk tugas matematika dan penalaran, urutan lapisan lebih penting daripada tugas semantik.

Studi ini juga menemukan bahwa tidak semua lapisan diperlukan dan lapisan perantara dapat dilewati tanpa mempengaruhi kinerja model secara drastis. Selain itu, meskipun lapisan perantara berbagi ruang representasi yang sama, mereka menjalankan fungsi yang berbeda. Mengubah urutan eksekusi lapisan mengakibatkan penurunan performa, yang menunjukkan bahwa urutan memiliki dampak penting pada performa model.

Dalam perjalanan mengeksplorasi model Transformer, banyak peneliti mencoba mengoptimalkannya, termasuk memangkas, mengurangi parameter, dll. Karya-karya ini memberikan pengalaman dan inspirasi berharga untuk memahami model Transformer.

Alamat makalah: https://arxiv.org/pdf/2407.09298v1

Secara keseluruhan, makalah ini memberikan perspektif baru bagi kita untuk memahami mekanisme internal model Transformer dan memberikan ide-ide baru untuk optimasi model masa depan. Editor Downcodes merekomendasikan agar pembaca yang tertarik membaca artikel selengkapnya untuk mendapatkan pemahaman mendalam tentang misteri model Transformer!