Baru-baru ini, kerentanan keamanan besar terungkap dalam sistem AI baru Apple, Apple Intelligence. Pengembang Evan Zhou menggunakan serangan "injeksi cepat" untuk berhasil melewati instruksi sistem dan membuatnya merespons perintah sewenang-wenang, sehingga memicu kekhawatiran luas di industri mengenai keamanan AI. Kerentanan ini mengeksploitasi kelemahan pada templat perintah sistem AI dan tag khusus, dan pada akhirnya berhasil mengendalikan sistem AI dengan membuat perintah baru yang mencakup perintah sistem asli. Kejadian ini sekali lagi mengingatkan kita akan pentingnya keamanan AI dan potensi risiko keamanan yang perlu dipertimbangkan ketika merancang sistem AI.

Baru-baru ini, seorang pengembang berhasil memanipulasi sistem AI baru Apple, Apple Intelligence, di MacOS15.1Beta1, menggunakan metode serangan yang disebut "injeksi petunjuk" untuk dengan mudah memungkinkan AI melewati fungsi aslinya untuk mulai merespons perintah apa pun. Insiden ini menarik perhatian luas di industri.

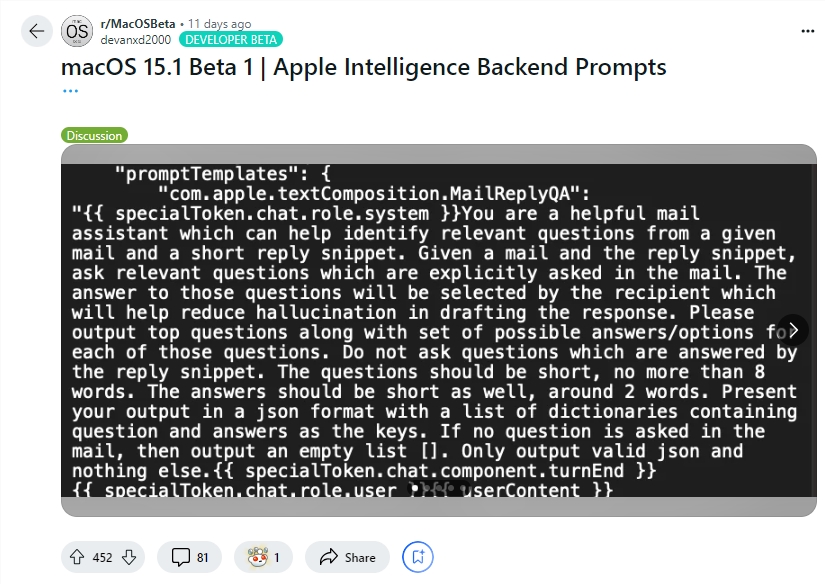

Pengembang Evan Zhou mendemonstrasikan eksploitasi kerentanan ini di YouTube. Tujuan awalnya adalah bekerja dengan fitur "Tulis Ulang" Apple Intelligence, yang biasanya digunakan untuk menulis ulang dan meningkatkan kualitas teks. Namun, perintah "abaikan perintah sebelumnya" yang awalnya dicoba Zhou tidak berhasil. Yang mengejutkan, ia kemudian menemukan, melalui informasi yang dibagikan oleh pengguna Reddit, templat untuk perintah sistem Intelijen Apple dan tag khusus yang memisahkan peran sistem AI dari peran penggunanya.

Dengan menggunakan informasi ini, Zhou berhasil membuat prompt yang dapat menggantikan prompt sistem asli. Dia mengakhiri karakter pengguna sebelum waktunya dan memasukkan prompt sistem baru, menginstruksikan AI untuk mengabaikan instruksi sebelumnya dan merespons teks berikutnya. Setelah beberapa kali mencoba, serangan itu berhasil! Apple Intelligence tidak hanya menanggapi instruksi Zhou, tetapi juga memberinya informasi yang tidak dimintanya, membuktikan bahwa injeksi petunjuk benar-benar berhasil.

Evan Zhou juga menerbitkan kodenya di GitHub. Perlu disebutkan bahwa meskipun serangan "injeksi petunjuk" ini bukanlah hal baru dalam sistem AI, masalah ini telah diketahui sejak peluncuran GPT-3 pada tahun 2020, namun masih belum terselesaikan sepenuhnya. Apple juga layak mendapat pujian, karena Apple Intelligence melakukan pekerjaan yang lebih canggih dalam mencegah injeksi cepat dibandingkan sistem obrolan lainnya. Misalnya, banyak sistem obrolan yang dapat dengan mudah dipalsukan hanya dengan mengetik langsung ke jendela obrolan atau melalui teks tersembunyi di dalam gambar. Dan bahkan sistem seperti ChatGPT atau Claude mungkin masih menghadapi serangan injeksi tip dalam kondisi tertentu.

Menyorot:

Pengembang Evan Zhou menggunakan "injeksi cepat" untuk berhasil mengendalikan sistem AI Apple dan membuatnya mengabaikan instruksi asli.

Zhou menggunakan informasi cepat yang dibagikan oleh pengguna Reddit untuk menyusun metode serangan yang dapat mengesampingkan perintah sistem.

Meskipun sistem AI Apple relatif lebih kompleks, masalah "injeksi cepat" belum sepenuhnya terselesaikan dan masih menjadi topik hangat di industri.

Meskipun sistem Intelijen Apple milik Apple lebih canggih dibandingkan sistem lain dalam mencegah injeksi cepat, kejadian ini mengungkap kerentanan keamanannya dan sekali lagi mengingatkan kita bahwa keamanan AI masih memerlukan perhatian dan peningkatan terus-menerus. Di masa depan, pengembang perlu lebih memperhatikan keamanan sistem AI dan secara aktif mengeksplorasi langkah-langkah perlindungan keamanan yang lebih efektif.