Model RWKV-CLIP open source terbaru dari Green Deep Learning telah menunjukkan kinerja yang kuat di bidang pembelajaran representasi bahasa visual dengan desain inovatifnya yang mengintegrasikan arsitektur Transformer dan RNN. Model ini secara efektif memecahkan masalah data yang berisik dan secara signifikan meningkatkan ketahanan model dan kinerja tugas hilir dengan secara cerdik menggabungkan arsitektur menara kembar, modul pencampuran spasial dan pencampuran saluran, serta kerangka pembuatan deskripsi yang beragam. Hal ini telah membuat kemajuan terobosan dalam pencocokan dan pemahaman gambar-teks, memberikan arah baru untuk penelitian dan penerapan model bahasa visual.

Gelingshentong telah membuat model RWKV-CLIP menjadi open source, yang merupakan pembelajar representasi bahasa visual yang menggabungkan keunggulan Transformer dan RNN. Model ini secara signifikan meningkatkan performa pada tugas visual dan bahasa dengan memperluas kumpulan data menggunakan pasangan gambar-teks yang diperoleh dari situs web melalui tugas pra-pelatihan gambar dan teks.

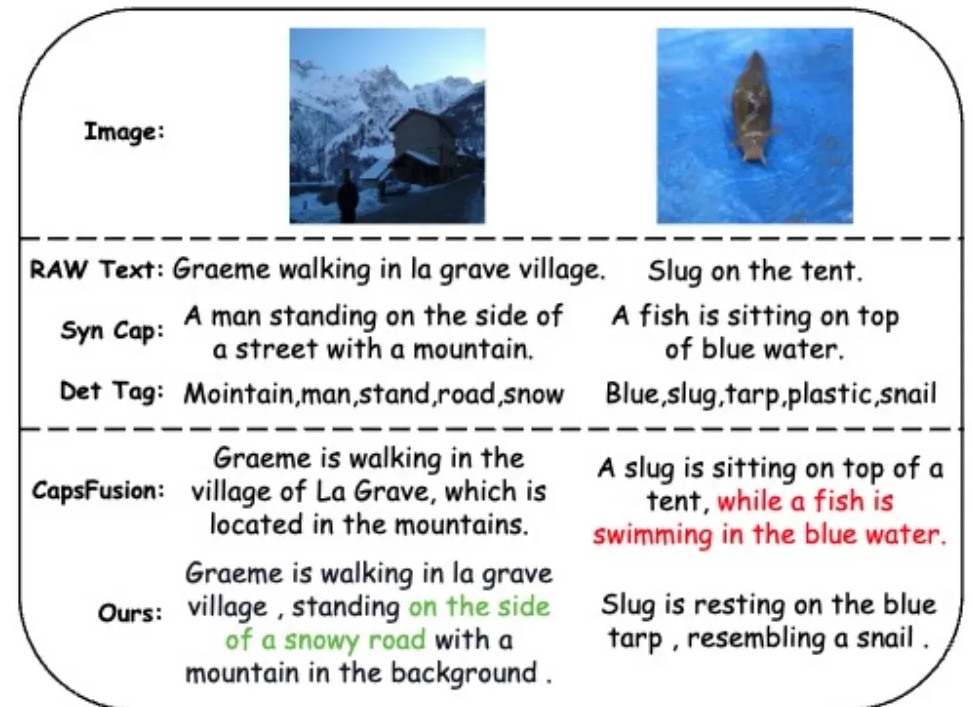

Untuk mengatasi masalah data yang berisik dan meningkatkan kualitas data, tim peneliti memperkenalkan beragam kerangka pembuatan deskripsi yang memanfaatkan model bahasa besar (LLM) untuk mensintesis dan menyaring konten dari teks berbasis web, subtitel yang disintesis, dan tag yang terdeteksi.

Model RWKV-CLIP mengadopsi arsitektur menara kembar, mengintegrasikan pelatihan paralel Transformer yang efektif dan inferensi RNN yang efisien. Model ini disusun dengan beberapa modul pencampuran spasial dan pencampuran saluran, yang memungkinkan pemrosesan masukan gambar dan teks secara mendalam. Pada tahap pencampuran spasial, model menggunakan mekanisme perhatian untuk melakukan penghitungan kompleksitas linier global dan memperkuat interaksi fitur di tingkat saluran. Tahap pencampuran saluran semakin menyempurnakan representasi fitur. Dalam hal peningkatan masukan, model RWKV-CLIP meningkatkan ketahanan model dengan memilih teks asli, subjudul sintetis, atau deskripsi yang dihasilkan secara acak sebagai masukan teks.

Hasil eksperimen menunjukkan bahwa RWKV-CLIP mencapai kinerja canggih dalam berbagai tugas hilir, termasuk deteksi linier, klasifikasi zero-shot, dan pengambilan teks gambar zero-shot. Dibandingkan dengan model dasar, RWKV-CLIP mencapai peningkatan kinerja yang signifikan.

Analisis lintas modal model RWKV-CLIP menunjukkan bahwa representasi yang dipelajari menunjukkan diskriminabilitas yang lebih jelas dalam modalitas yang sama dan menunjukkan jarak yang lebih dekat dalam ruang modalitas gambar-teks, yang menunjukkan kinerja penyelarasan lintas modalitas yang lebih baik.

Alamat model: https://wisemodel.cn/models/deepglint/RWKV-CLIP

Secara keseluruhan, model RWKV-CLIP menunjukkan potensi besar di bidang bahasa visual, dan sumber terbukanya juga menyediakan sumber daya berharga untuk penelitian terkait. Pengembang yang tertarik dapat mengunjungi tautan yang disediakan untuk mengunduh model dan melakukan penelitian dan penerapan lebih lanjut.