Startup kecerdasan buatan Tiongkok DeepSeek telah merilis model ultra-besar terbarunya DeepSeek-V3, yang telah menjadi fokus industri dengan kode sumber terbuka dan kinerja yang kuat. Dengan parameter 671B dan arsitektur hibrid ahli, DeepSeek-V3 melampaui model sumber terbuka terkemuka dalam berbagai tolok ukur dan bahkan memiliki kinerja serupa dengan beberapa model sumber tertutup. Inovasinya terletak pada strategi penyeimbangan beban lossless tambahan dan teknologi prediksi multi-token, yang secara signifikan meningkatkan efisiensi pelatihan model dan kecepatan lari. Peluncuran DeepSeek-V3 menandai terobosan besar dalam teknologi AI sumber terbuka, yang semakin mempersempit kesenjangan dengan AI sumber tertutup dan membuka jalan bagi pengembangan kecerdasan umum buatan (AGI).

Pada tanggal 26 Desember 2024, startup kecerdasan buatan Tiongkok DeepSeek merilis model ultra-besar terbaru DeepSeek-V3, yang dikenal dengan teknologi sumber terbuka dan tantangan inovatif yang memimpin vendor AI. DeepSeek-V3 memiliki parameter 671B dan menggunakan arsitektur campuran ahli untuk mengaktifkan parameter tertentu guna menangani tugas tertentu secara akurat dan efisien. Menurut tolok ukur yang disediakan oleh DeepSeek, model baru ini telah melampaui model sumber terbuka terkemuka termasuk Llama3.1-405B milik Meta, dan memiliki kinerja serupa dengan model tertutup dari Anthropic dan OpenAI.

Peluncuran DeepSeek-V3 menandai semakin mempersempit kesenjangan antara AI sumber terbuka dan AI sumber tertutup. DeepSeek, yang dimulai sebagai cabang dari dana lindung nilai kuantitas Tiongkok, High-Flyer Capital Management, berharap perkembangan ini akan membuka jalan bagi kecerdasan umum buatan (AGI), di mana model akan dapat memahami atau mempelajari tugas intelektual apa pun yang dapat dilakukan manusia. .

Fitur utama DeepSeek-V3 meliputi:

Seperti pendahulunya DeepSeek-V2, model baru ini didasarkan pada arsitektur dasar perhatian laten multi-head (MLA) dan DeepSeekMoE, memastikan pelatihan dan inferensi yang efisien.

Perusahaan juga meluncurkan dua inovasi: strategi penyeimbangan beban lossless tambahan dan Prediksi Multi-Token (MTP), yang memungkinkan model memprediksi beberapa token masa depan secara bersamaan, meningkatkan efisiensi pelatihan, dan memungkinkan model berjalan tiga kali lebih cepat, per Hasilkan 60 token per detik .

Pada fase pra-pelatihan, DeepSeek-V3 melatih 14,8T token berkualitas tinggi dan beragam, dan melakukan perluasan panjang konteks dua tahap, dan terakhir melakukan pasca-pelatihan dengan penyempurnaan yang diawasi (SFT) dan pembelajaran penguatan (RL) , untuk menyelaraskan model dengan preferensi manusia dan lebih jauh membuka potensinya.

Dalam fase pelatihan, DeepSeek menggunakan berbagai optimasi perangkat keras dan algoritma, termasuk kerangka pelatihan presisi campuran FP8 dan algoritma DualPipe untuk paralelisasi pipa, sehingga mengurangi biaya pelatihan. Seluruh proses pelatihan DeepSeek-V3 diklaim selesai dalam 2788K jam GPU H800 atau sekitar $5,57 juta, jauh lebih sedikit dibandingkan ratusan juta dolar yang biasanya dihabiskan untuk pra-pelatihan model bahasa besar.

DeepSeek-V3 telah menjadi model open source terkuat di pasar. Berbagai tolok ukur yang dilakukan oleh perusahaan menunjukkan bahwa model tersebut mengungguli GPT-4o sumber tertutup di sebagian besar tolok ukur, kecuali SimpleQA dan FRAMES yang berfokus pada bahasa Inggris, dengan model OpenAI memimpin dengan skor masing-masing sebesar 38,2 dan 80,5 (skor DeepSeek-V3 adalah 24,9 dan 80,5). 73,3 masing-masing). DeepSeek-V3 berkinerja sangat baik pada benchmark bahasa Mandarin dan matematika, dengan skor 90,2 pada tes Math-500, diikuti oleh Qwen 80.

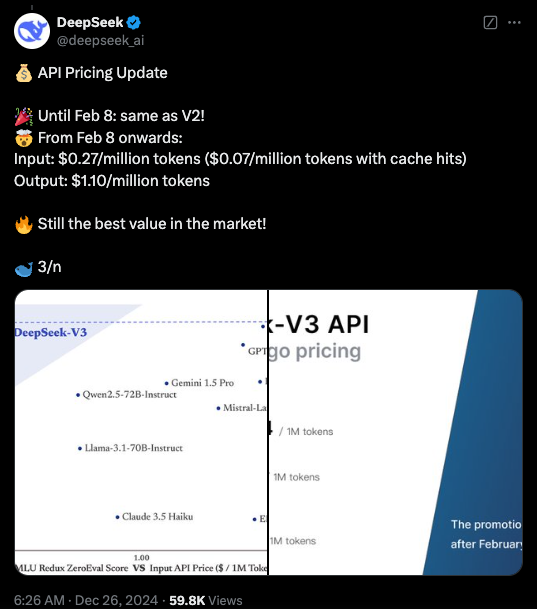

Saat ini, kode untuk DeepSeek-V3 tersedia di bawah lisensi MIT di GitHub, dan modelnya disediakan di bawah lisensi model perusahaan. Perusahaan juga dapat menguji model baru melalui DeepSeek Chat, platform yang mirip dengan ChatGPT, dan mengakses API untuk penggunaan komersial. DeepSeek akan menyediakan API dengan harga yang sama dengan DeepSeek-V2 hingga 8 Februari. Setelah itu, biaya sebesar $0,27 per juta token masukan ($0,07 per juta token untuk cache hits) dan $1,10 per juta token keluaran akan dikenakan.

Highlight:

DeepSeek-V3 dirilis, dengan performa melebihi Llama dan Qwen.

Mengadopsi parameter 671B dan arsitektur hybrid ahli untuk meningkatkan efisiensi.

Inovasi mencakup strategi penyeimbangan beban lossless dan prediksi multi-token untuk meningkatkan kecepatan.

Biaya pelatihan berkurang secara signifikan, mendorong pengembangan AI open source.

DeepSeek-V3 yang open source dan berkinerja tinggi akan memberikan dampak besar pada bidang kecerdasan buatan, mendorong pengembangan teknologi AI open source, dan mempromosikan penerapannya di berbagai bidang. DeepSeek akan terus berupaya mengembangkan model AI yang lebih canggih dan berkontribusi pada realisasi AGI. Di masa depan, kami punya alasan untuk mengharapkan lebih banyak terobosan dari DeepSeek.