Model AI seri o terbaru OpenAI dirancang untuk meningkatkan keamanan sistem AI melalui pemahaman aturan dan kemampuan penalaran yang lebih mendalam. Berbeda dari hanya mengandalkan pembelajaran contoh di masa lalu, model ini dapat secara proaktif memahami dan menerapkan pedoman keamanan untuk memblokir permintaan berbahaya secara efektif. Artikel ini merinci proses pelatihan tiga tahap model o1 dan kinerjanya di luar sistem AI arus utama lainnya dalam pengujian keamanan. Namun, bahkan dengan model o1 yang ditingkatkan, masih ada kemungkinan manipulasi, yang menyoroti tantangan yang sedang berlangsung di bidang keselamatan AI.

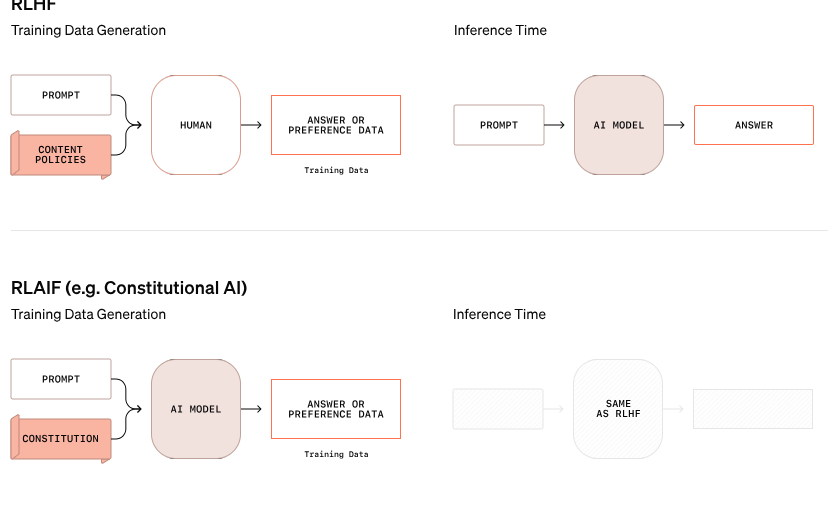

OpenAI telah mengumumkan pendekatan baru terhadap keamanan AI yang bertujuan untuk meningkatkan keamanan sistem AI dengan mengubah cara mereka menangani aturan keamanan. Model Seri O baru ini tidak lagi hanya mengandalkan pembelajaran perilaku baik dan buruk dari contoh, namun mampu memahami dan secara aktif mempertimbangkan pedoman keselamatan tertentu.

Dalam salah satu contoh dari penelitian OpenAI, ketika pengguna mencoba mendapatkan instruksi untuk aktivitas ilegal melalui teks terenkripsi, model tersebut berhasil memecahkan kode informasi tersebut tetapi menolak permintaan tersebut, dengan menyebutkan secara spesifik aturan keamanan yang akan dilanggar. Proses penalaran langkah demi langkah ini menunjukkan seberapa efektif model tersebut mengikuti pedoman keselamatan yang relevan.

Proses pelatihan model o1 ini dibagi menjadi tiga tahap. Pertama, model belajar bagaimana membantu. Selanjutnya, melalui pembelajaran yang diawasi, model tersebut mempelajari pedoman keselamatan tertentu. Terakhir, model ini menggunakan pembelajaran penguatan untuk berlatih menerapkan aturan-aturan ini, sebuah langkah yang membantu model benar-benar memahami dan menginternalisasikan pedoman keselamatan ini.

Dalam pengujian OpenAI, model o1 yang baru diluncurkan memiliki kinerja yang jauh lebih baik dibandingkan sistem mainstream lainnya dalam hal keamanan, seperti GPT-4o, Claude3.5Sonnet, dan Gemini1.5Pro. Pengujian tersebut, yang mencakup bagaimana model menolak permintaan berbahaya dan mengizinkan permintaan yang sesuai, menunjukkan bahwa model o1 mencapai skor tertinggi dalam hal akurasi dan ketahanan terhadap upaya jailbreak.

Salah satu pendiri OpenAI, Wojciech Zaremba, mengatakan di platform sosial bahwa dia sangat bangga dengan pekerjaan "penyelarasan yang bijaksana" ini dan percaya bahwa model penalaran semacam ini dapat diselaraskan dengan cara yang benar-benar baru, terutama dalam pengembangan kecerdasan umum buatan (AGI). memastikan bahwa sistem tersebut konsisten dengan nilai-nilai kemanusiaan merupakan tantangan besar.

Terlepas dari klaim kemajuan OpenAI, seorang peretas bernama "Pliny the Liberator" menunjukkan bahwa model o1 dan o1-Pro baru pun dapat dimanipulasi untuk melanggar pedoman keamanan. Pliny berhasil mendapatkan model untuk menghasilkan konten dewasa dan bahkan berbagi instruksi untuk membuat bom molotov, meskipun sistem awalnya menolak permintaan tersebut. Insiden-insiden ini menyoroti sulitnya mengendalikan sistem AI yang kompleks ini karena sistem tersebut beroperasi berdasarkan probabilitas, bukan aturan ketat.

Zaremba mengatakan OpenAI memiliki sekitar 100 karyawan yang berdedikasi terhadap keselamatan AI dan konsistensi dengan nilai-nilai kemanusiaan. Dia mengajukan pertanyaan tentang pendekatan pesaing terhadap keamanan, khususnya xAI milik Elon Musk, yang memprioritaskan pertumbuhan pasar dibandingkan langkah-langkah keamanan dan Anthropic, yang baru-baru ini meluncurkan agen AI tanpa perlindungan yang tepat. Zaremba percaya bahwa hal ini akan membawa "umpan balik negatif yang besar" ke OpenAI.

Blog resmi: https://openai.com/index/deliberative-alignment/

Highlight:

Model seri o baru OpenAI dapat secara proaktif mempertimbangkan aturan keamanan dan meningkatkan keamanan sistem.

Model o1 mengungguli sistem AI arus utama lainnya dalam menolak permintaan dan akurasi yang berbahaya.

Meskipun terdapat perbaikan, model-model baru masih dapat dimanipulasi, dan tantangan keamanan masih tetap berat.

Secara keseluruhan, model o-series OpenAI telah mencapai kemajuan signifikan di bidang keamanan AI, namun model ini juga mengungkap kompleksitas dan tantangan berkelanjutan dari keamanan model bahasa besar. Di masa depan, lebih banyak upaya perlu dilanjutkan untuk benar-benar dan efektif menangani risiko keamanan AI.