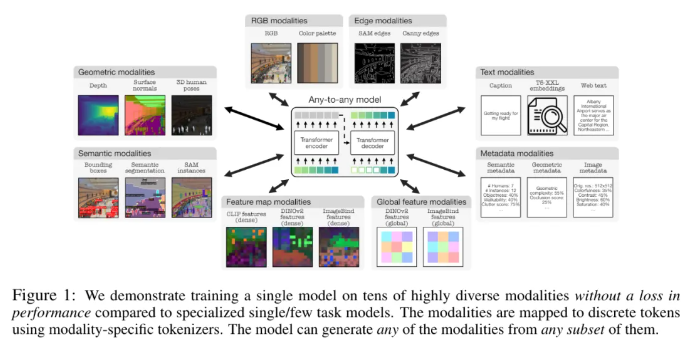

Apple dan Ecole Polytechnique Fédérale de Lausanne (EPFL) di Swiss telah berkolaborasi untuk mengembangkan model multimodal yang inovatif, 4M-21. Model ini dapat dilatih dengan 21 modalitas berbeda, performanya jauh lebih baik dibandingkan model yang sudah ada, dan model ini merealisasikan berbagai fungsi seperti pengambilan lintas-modal dan pembangkitan yang dapat dikontrol. Penelitian ini sangat meningkatkan performa dan kemampuan beradaptasi model dengan memperluas model dan ukuran kumpulan data, meningkatkan jenis dan jumlah modalitas pelatihan, dan mengadopsi strategi pelatihan bersama. Model 4M-21 mengadopsi arsitektur encoder-decoder berbasis Transformer dan menambahkan penyematan modal tambahan untuk beradaptasi dengan modalitas baru. Proses pelatihannya sepenuhnya mempertimbangkan karakteristik modalitas yang berbeda dan menggunakan metode Tokenisasi khusus untuk modal.

Studi ini mengadopsi solusi pra-pelatihan 4M, yang dapat meningkatkan kinerja dan kemampuan beradaptasi model dengan memperluas ukuran model dan kumpulan data, meningkatkan jenis dan jumlah modalitas yang terlibat dalam pelatihan model, dan melakukan pelatihan bersama pada beberapa model. kumpulan data. Peneliti menggunakan metode tokenisasi yang berbeda untuk mendiskritisasi modalitas dengan fitur berbeda, seperti penyematan gambar global, pose manusia, dan contoh semantik. Dalam hal pemilihan arsitektur, penelitian ini mengadopsi arsitektur encoder-decoder 4M berbasis Transformer dan menambahkan penyematan modal tambahan untuk beradaptasi dengan modalitas baru.

Model ini tidak hanya dapat melakukan serangkaian tugas penglihatan umum di luar kotak, seperti estimasi normal dan kedalaman permukaan DIODE, semantik COCO dan segmentasi instance, estimasi pose manusia 3DPW3D, dll., model ini juga dapat menghasilkan modalitas pelatihan yang sewenang-wenang dan mendukung beberapa metode. Pembuatan detail dan multi-modal dilakukan, dan gambar RGB atau modalitas lainnya dapat diambil dengan menggunakan modalitas lain sebagai kueri. Selain itu, peneliti juga melakukan eksperimen transmisi multimodal pada NYUv2, segmentasi semantik Hypersim dan ARKitScenes.

Fitur fungsional pentingnya meliputi:

Modalitas any-to-any: Meningkat dari 7 modalitas model any-to-any terbaik yang ada menjadi 21 modalitas berbeda, memungkinkan pengambilan lintas-modal, pembangkitan yang dapat dikontrol, dan kinerja luar biasa yang kuat.

Dukungan Keberagaman: Tambahkan dukungan untuk data yang lebih terstruktur seperti pose manusia, instance SAM, metadata, dan banyak lagi.

Tokenisasi: Pelajari tokenisasi terpisah untuk berbagai modalitas menggunakan metode khusus modalitas, seperti penyematan gambar global, pose manusia, dan contoh semantik.

Penskalaan: Perluas ukuran model menjadi parameter 3 miliar dan kumpulan data menjadi 0,5 miliar sampel.

Pelatihan kolaboratif: pelatihan kolaboratif tentang visi dan bahasa pada saat yang bersamaan.

Alamat makalah: https://arxiv.org/pdf/2406.09406

Highlight:

- Para peneliti dari Apple dan Ecole Polytechnique Fédérale de Lausanne (EPFL) di Swiss telah bersama-sama mengembangkan model modalitas apa pun yang dapat dilatih dalam 21 modalitas berbeda.

- Model ini dapat melakukan berbagai tugas visi umum secara langsung dan juga mampu menghasilkan modalitas pelatihan yang sewenang-wenang, mendukung beberapa metode untuk melakukan pembuatan multi-modal yang terperinci.

- Peneliti juga melakukan eksperimen transmisi multimodal pada NYUv2, segmentasi semantik Hypersim dan ARKitScenes.

Secara keseluruhan, model 4M-21 telah mencapai kemajuan signifikan di bidang penelitian multimodal. Kinerjanya yang kuat dan prospek penerapannya yang luas memberikan arah baru bagi pengembangan kecerdasan buatan multimodal di masa depan. Sumber terbuka dan penerapan model ini di masa depan patut dinantikan.