Tim peneliti dari Universitas Nanjing, Universitas Fudan, dan Laboratorium Bahtera Nuh Huawei telah membuat terobosan besar di bidang manusia digital 3D, memecahkan masalah kurangnya konsistensi multi-tampilan dan ekspresi emosional dalam metode yang ada. Mereka telah mengembangkan metode baru yang memungkinkan sintesis avatar berbicara 3D dengan emosi yang dapat dikontrol dan mencapai peningkatan signifikan dalam sinkronisasi bibir dan kualitas rendering. Hasil penelitian didasarkan pada kumpulan data EmoTalk3D yang baru dibuat, yang berisi video multi-tayangan yang dikalibrasi, anotasi emosional, dan informasi geometris 3D bingkai demi bingkai, dan telah dipublikasikan untuk penggunaan penelitian non-komersial. Melalui kerangka pemetaan "dari ucapan hingga geometri hingga penampilan", metode ini secara akurat menangkap ekspresi wajah yang halus dan menghasilkan rendering dengan ketelitian tinggi dalam sudut pandang bebas.

Pintu masuk produk: https://nju-3dv.github.io/projects/EmoTalk3D/

Mereka mengumpulkan kumpulan data EmoTalk3D dengan video multi-tayangan yang dikalibrasi, anotasi emosi, dan geometri 3D bingkai demi bingkai. Dan diusulkan metode baru untuk mensintesis avatar berbicara 3D dengan emosi yang dapat dikontrol, dengan peningkatan signifikan dalam sinkronisasi bibir dan kualitas rendering.

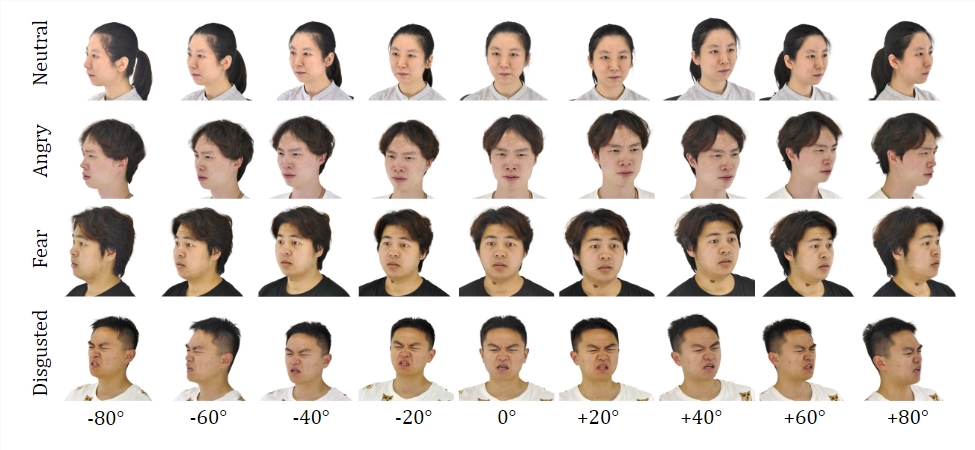

Kumpulan data:

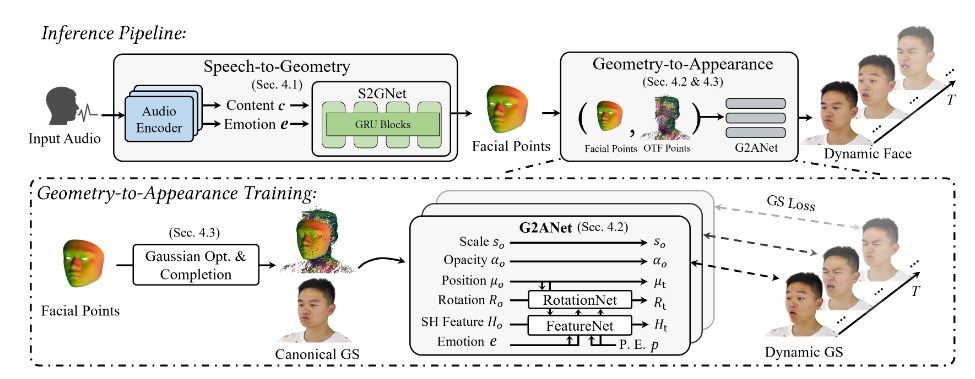

Dengan melatih kumpulan data EmoTalk3D, tim peneliti membangun kerangka pemetaan "dari ucapan, geometri, hingga penampilan". Urutan geometris 3D realistis pertama-tama diprediksi dari fitur audio, lalu kemunculan kepala bicara 3D yang diwakili oleh Gaussian 4D disintesis berdasarkan geometri yang diprediksi. Penampilan selanjutnya didekomposisi menjadi Gaussian standar dan dinamis, dipelajari dari video multi-tayangan, dan digabungkan untuk merender animasi kepala berbicara dengan tampilan bebas.

Model ini memungkinkan emosi yang dapat dikontrol dalam avatar berbicara yang dihasilkan dan menampilkannya dalam berbagai sudut pandang. Menunjukkan peningkatan kualitas rendering dan stabilitas dalam menghasilkan gerakan bibir sekaligus menangkap detail wajah yang dinamis seperti kerutan dan ekspresi halus. Pada contoh hasil yang dihasilkan, ekspresi senang, marah, dan frustasi manusia digital 3D ditampilkan secara akurat.

Proses keseluruhannya berisi lima modul:

Yang pertama adalah encoder dekomposisi konten emosional, yang memilah konten dan fitur emosional dari masukan ucapan; yang kedua adalah jaringan ucapan-ke-geometri, yang memprediksi awan titik 3D dinamis dari fitur; tampilan standar; yang keempat adalah geometri-ke-penampilan. Jaringan mensintesis tampilan wajah berdasarkan titik awan 3D dinamis; yang kelima adalah modul rendering, yang menjadikan Gaussian dinamis menjadi animasi tampilan bebas.

Selain itu, mereka membuat kumpulan data EmoTalk3D, kumpulan data kepala bicara multi-tampilan beranotasi emosi dengan bentuk wajah 3D bingkai demi bingkai, yang akan tersedia bagi publik untuk tujuan penelitian non-komersial.

Menyorot:

Usulkan metode baru untuk mensintesis manusia digital dengan emosi yang terkendali.

Bangun kerangka pemetaan “mulai dari ucapan, geometri, hingga penampilan.”

Kumpulan data EmoTalk3D telah dibuat dan siap dibuka.

Penelitian ini memberikan arah baru bagi pengembangan teknologi manusia digital 3D. Metode dan kumpulan data yang diusulkan akan memberikan sumber daya berharga untuk penelitian di masa depan dan mendorong pengembangan teknologi manusia digital 3D yang lebih realistis dan ekspresif secara emosional. Pembukaan kumpulan data EmoTalk3D juga mendorong kerja sama dan pertukaran di kalangan civitas akademika.