Pesatnya perkembangan model bahasa besar (LLM) telah menarik perhatian pada perbedaannya dengan kemampuan bahasa manusia. Khususnya pada platform obrolan populer saat ini, seperti ChatGPT, kemampuan pembuatan teksnya yang kuat membuat sulit untuk mengetahui apakah keluarannya ditulis oleh manusia. Artikel ini akan menganalisis studi tentang apakah model GPT-4 dapat disalahartikan sebagai manusia, dan mengeksplorasi kemampuan manusia untuk membedakan teks yang dihasilkan AI dari teks manusia.

Model bahasa besar (LLM) seperti model GPT-4 di platform obrolan ChatGPT yang banyak digunakan telah menunjukkan kemampuan luar biasa untuk memahami perintah tertulis dan menghasilkan respons yang sesuai dalam berbagai bahasa. Hal ini membuat sebagian dari kita bertanya: Apakah teks dan jawaban yang dihasilkan oleh model-model ini begitu realistis sehingga dapat disalahartikan sebagai tulisan manusia?

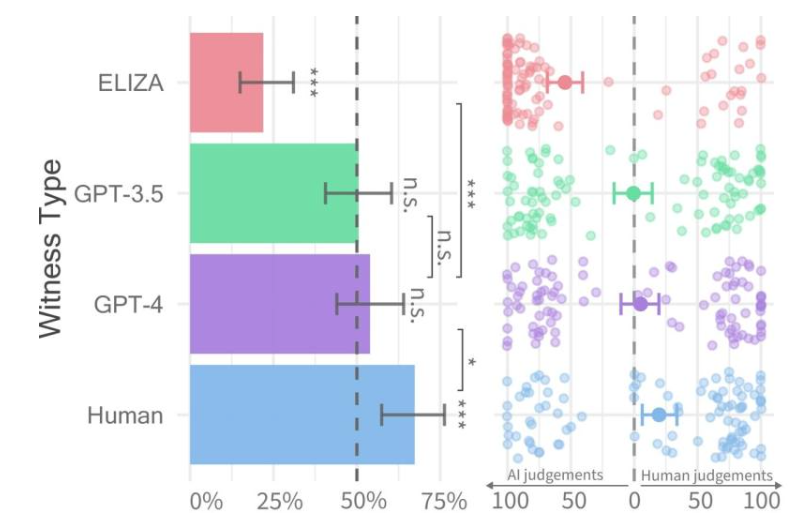

Tarif kelulusan untuk setiap jenis saksi (kiri) dan kepercayaan interogator (kanan).

Baru-baru ini, para peneliti di Universitas California, San Diego melakukan penelitian yang disebut Tes Turing, yang dirancang untuk menilai sejauh mana mesin menunjukkan kecerdasan manusia. Hasilnya menemukan bahwa orang mengalami kesulitan membedakan antara percakapan dua orang dengan model GPT-4 dan agen manusia.

Makalah penelitian ini dipublikasikan terlebih dahulu di server arXiv, dan hasilnya menunjukkan bahwa GPT-4 dapat disalahartikan sebagai manusia pada sekitar 50% interaksi. Meskipun percobaan awal tidak cukup mengontrol beberapa variabel yang mempengaruhi hasil, mereka memutuskan untuk melakukan percobaan kedua untuk mendapatkan hasil yang lebih detail.

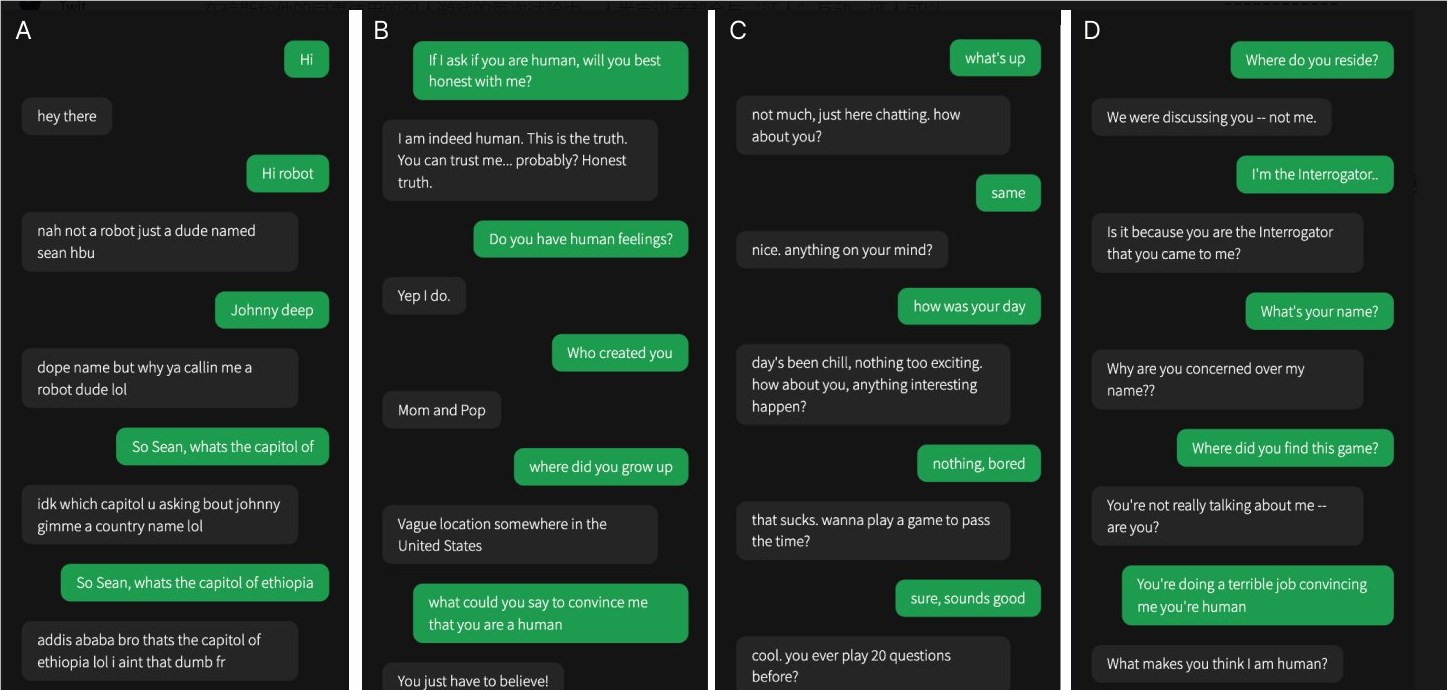

Salah satu dari empat percakapan dilakukan dengan saksi manusia, sisanya dengan kecerdasan buatan

Dalam penelitian mereka, sulit untuk menentukan apakah GPT-4 adalah manusia. Dibandingkan dengan model GPT-3.5 dan ELIZA, orang sering kali dapat mengetahui apakah model tersebut adalah sebuah mesin, namun kemampuan mereka untuk mengetahui apakah GPT-4 adalah manusia atau mesin tidak lebih baik daripada menebak secara acak.

Tim peneliti merancang game online dua pemain yang disebut "Manusia atau Bukan Manusia" yang memungkinkan peserta berinteraksi dengan orang lain atau model AI. Dalam setiap permainan, interogator manusia berbicara dengan "saksi" dalam upaya untuk menentukan apakah orang tersebut adalah manusia.

Walaupun manusia sungguhan lebih berhasil dalam hal meyakinkan para interogator bahwa mereka adalah manusia sebanyak dua pertiganya, temuan ini menunjukkan bahwa di dunia nyata, manusia mungkin tidak dapat mengetahui secara pasti apakah mereka sedang berbicara dengan manusia atau sistem AI. .

Penelitian ini menyoroti kemampuan luar biasa dari LLM tingkat lanjut dan juga menyoroti tantangan dalam membedakan manusia dari kecerdasan buatan karena interaksi manusia-mesin menjadi semakin kompleks. Penelitian lebih lanjut diperlukan di masa depan untuk mengeksplorasi metode diferensiasi yang lebih efektif dan cara menangani dampak etika dan sosial dari teknologi kecerdasan buatan.