Dengan pesatnya perkembangan model bahasa besar multimodal (MLLM), integrasi efektif modalitas visual, bahasa, dan ucapan telah menjadi pusat penelitian. Namun, tantangan yang disebabkan oleh perbedaan mendasar dalam data modal yang berbeda, seperti informasi spasial penglihatan dan informasi rangkaian waktu ucapan, menghambat interaksi multimodal yang efisien. Metode yang ada sering kali mengandalkan modul ASR dan TTS independen, yang meningkatkan latensi dan mengurangi kelancaran interaksi. Artikel ini memperkenalkan VITA-1.5, model bahasa multimodal berskala besar yang mengintegrasikan penglihatan, bahasa, dan ucapan, yang bertujuan untuk memecahkan masalah ini.

Baru-baru ini, kemajuan signifikan telah dicapai dalam model bahasa besar multimodal (MLLM), khususnya dalam integrasi modalitas visual dan tekstual. Namun, dengan semakin populernya interaksi manusia-komputer, pentingnya modalitas bicara menjadi semakin menonjol, terutama dalam sistem dialog multi-modal. Suara tidak hanya merupakan media utama transmisi informasi, namun juga secara signifikan meningkatkan kealamian dan kenyamanan interaksi.

Namun, karena perbedaan mendasar antara data visual dan ucapan, mengintegrasikannya ke dalam MLLM bukanlah hal yang mudah. Misalnya, data visual menyampaikan informasi spasial, sedangkan data ucapan menyampaikan perubahan dinamis dalam rangkaian waktu. Perbedaan mendasar ini membawa tantangan terhadap optimalisasi kedua modalitas secara simultan, yang sering kali menimbulkan konflik selama proses pelatihan. Selain itu, sistem ucapan-ke-ucapan tradisional mengandalkan modul pengenalan ucapan otomatis (ASR) dan text-to-speech (TTS) yang terpisah, yang meningkatkan latensi dan mengurangi koherensi, sehingga membatasi kegunaannya dalam aplikasi waktu nyata.

Untuk mengatasi tantangan ini, para peneliti meluncurkan VITA-1.5, model bahasa multimodal berskala besar yang mengintegrasikan penglihatan, bahasa, dan ucapan. VITA-1.5 menggunakan metode pelatihan tiga tahap yang dirancang dengan cermat untuk secara bertahap memperkenalkan data visual dan ucapan guna mengurangi konflik modal sambil mempertahankan kinerja multi-modal yang kuat.

Pada tahap pertama, model berfokus pada pelatihan visual-linguistik, membangun kemampuan visual yang kuat dengan melatih adaptor visual dan menyempurnakan model menggunakan teks deskriptif dan data tanya jawab visual.

Tahap kedua memperkenalkan pemrosesan input audio, dengan melatih encoder audio menggunakan data berpasangan transkripsi ucapan, lalu menyempurnakannya menggunakan data tanya jawab ucapan, sehingga model dapat secara efektif memahami dan merespons input audio. Terakhir, pada tahap ketiga, dekoder audio dilatih untuk mencapai keluaran ucapan ujung ke ujung tanpa memerlukan modul TTS eksternal, sehingga memungkinkan VITA-1.5 menghasilkan balasan ucapan yang lancar dan meningkatkan kealamian dan interaktivitas dialog multimodal. sistem.

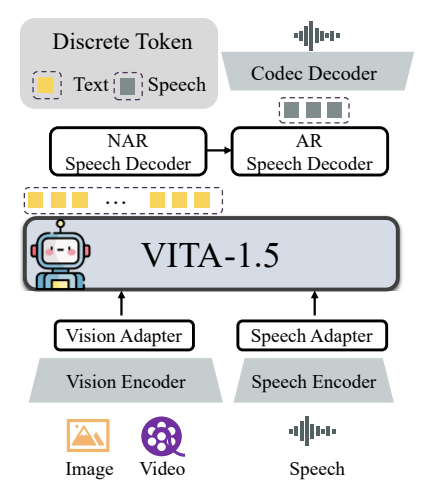

Arsitektur keseluruhan VITA-1.5 mencakup encoder dan adaptor visual dan audio untuk terhubung ke model bahasa besar. Outputnya memiliki modul pembangkitan ucapan ujung ke ujung alih-alih menggunakan model TTS eksternal seperti versi VITA-1.0 asli. Encoder visual menggunakan InternViT-300M, ukuran gambar input 448×448 piksel, dan setiap gambar menghasilkan 256 token visual.

Untuk gambar resolusi tinggi, VITA-1.5 mengadopsi strategi patching dinamis untuk menangkap detail lokal. Video diperlakukan sebagai jenis masukan multi-gambar khusus, dengan bingkai yang diambil sampelnya berdasarkan durasi video. Modul pengkodean audio terdiri dari beberapa lapisan konvolusional downsampling dan 24 blok Transformer, dengan kecepatan bingkai keluaran 12,5Hz. Adaptor audio terdiri dari beberapa lapisan konvolusional dengan downsampling 2x. TiCodec digunakan sebagai model codec, yang mengkodekan sinyal ucapan berkelanjutan menjadi token ucapan diskrit dengan frekuensi 40Hz dan mampu mendekodekannya kembali menjadi sinyal ucapan dengan kecepatan pengambilan sampel 24,000Hz. Untuk memungkinkan model mengeluarkan token ucapan, dua dekoder ucapan ditambahkan setelah token teks: dekoder ucapan non-autoregresif (NAR) dan dekoder ucapan autoregresif (AR).

Data pelatihan VITA-1.5 mencakup berbagai kategori, seperti data subtitle dan data tanya jawab, termasuk bahasa Mandarin dan Inggris. Pada tahap pelatihan yang berbeda, subkumpulan seluruh kumpulan data diambil sampelnya secara selektif untuk mencapai tujuan yang berbeda. Strategi pelatihan dilakukan dalam tiga tahap:

Tahap pertama: pelatihan visual-linguistik, termasuk penyelarasan visual, pemahaman visual, dan penyesuaian visual yang diawasi, bertujuan untuk menjembatani kesenjangan antara visi dan bahasa dan memungkinkan model memahami konten gambar dan menjawab pertanyaan visual.

Fase 2: Penyetelan input audio, termasuk penyelarasan audio dan penyesuaian audio yang diawasi, dirancang untuk memungkinkan model memahami input audio dan berinteraksi melalui pertanyaan suara dan jawaban teks.

Tahap ketiga: Penyetelan keluaran audio, termasuk pelatihan codec dan pelatihan dekoder NAR + AR, dirancang untuk memungkinkan model menghasilkan keluaran ucapan dan mencapai interaksi suara ujung ke ujung.

Para peneliti melakukan evaluasi ekstensif terhadap berbagai tolok ukur pemahaman gambar, video, dan ucapan serta membandingkan hasilnya dengan model open source dan proprietary. Hasilnya menunjukkan bahwa VITA-1.5 menunjukkan kemampuan persepsi dan penalaran yang sebanding dengan MLLM terkemuka dalam tugas gambar dan video, dan mencapai peningkatan signifikan dalam kemampuan berbicara. Misalnya, pada tolok ukur pemahaman gambar, kinerja VITA-1.5 setara dengan model sumber terbuka yang canggih dan bahkan melampaui beberapa model sumber tertutup. Dalam hal pemahaman video, kinerja VITA-1.5 setara dengan model sumber terbuka teratas. Selain itu, VITA-1.5 mencapai akurasi terdepan dalam tugas ASR berbahasa Mandarin dan Inggris, melampaui model ucapan profesional.

Secara keseluruhan, VITA-1.5 berhasil mengintegrasikan visi dan ucapan melalui strategi pelatihan tiga tahap yang dirancang dengan cermat, mencapai kemampuan pemahaman visual dan ucapan yang kuat, memungkinkan interaksi ucapan-ke-ucapan yang efisien tanpa bergantung pada modul ASR atau TTS Terpisah. Penelitian ini diharapkan dapat mendorong kemajuan model open source di bidang interaksi multi-modal waktu nyata.

Alamat proyek: https://github.com/VITA-MLLM/VITA

Munculnya VITA-1.5 menandai tahap baru dalam pengembangan model bahasa skala besar multi-modal. Kemampuan generasi ucapan ujung ke ujung dan kinerja luar biasa dalam tugas pemahaman gambar, video, dan ucapan akan membangun lebih alami dan lancar model bahasa multi-modal untuk masa depan. Sistem interaktif dinamis memberikan kemungkinan baru. Hasil penelitian ini patut mendapat perhatian dan diharapkan dapat berperan penting dalam penerapan praktis.