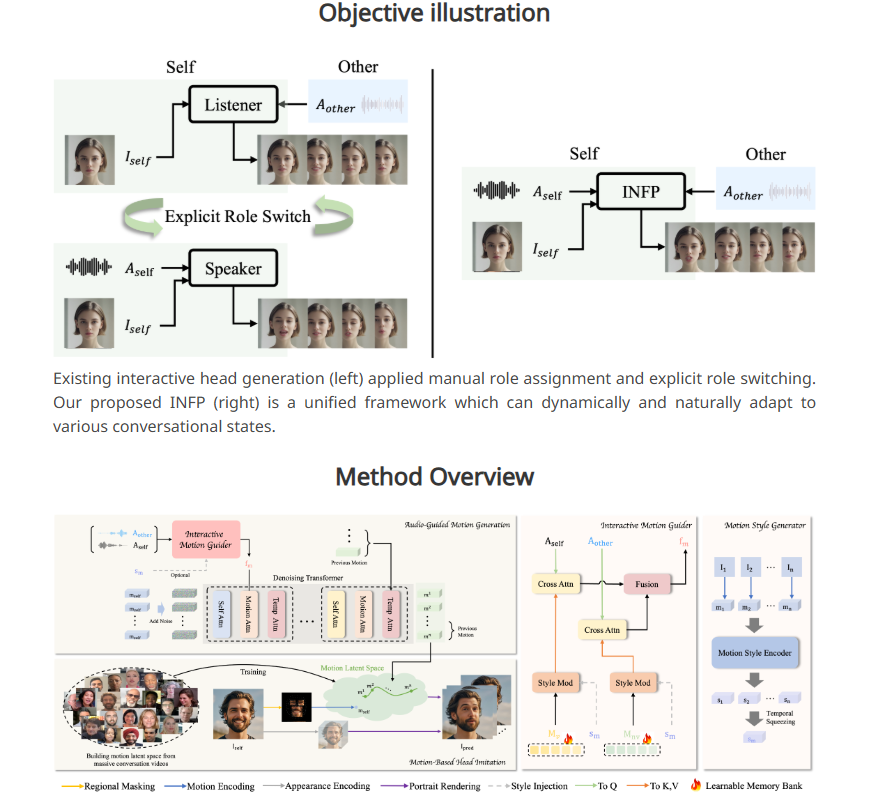

ByteDance telah meluncurkan sistem AI baru, INFP, yang memungkinkan foto potret statis "berbicara" dan bereaksi melalui input audio. Berbeda dengan teknologi tradisional, INFP tidak perlu menentukan peran secara manual. Sistem dapat menilai secara otomatis berdasarkan percakapan, sehingga sangat meningkatkan efisiensi dan kenyamanan. Teknologi intinya terletak pada dua langkah yaitu "peniruan kepala berbasis gerakan" dan "pembuatan gerakan yang dipandu audio". Dengan menganalisis ekspresi wajah, gerakan kepala, dan masukan audio dalam percakapan, teknologi ini menghasilkan pola gerakan yang alami dan halus untuk menghasilkan gambar statis untuk hidup. Untuk melatih INFP, ByteDance juga membuat kumpulan data DyConv yang berisi lebih dari 200 jam video percakapan nyata untuk memastikan keluaran sistem berkualitas tinggi.

Ada dua langkah utama dalam alur kerja INFP. Pada langkah pertama, yang disebut “mimikri kepala berbasis gerakan”, sistem mengekstrak detail dari video dengan menganalisis ekspresi wajah dan gerakan kepala orang selama percakapan. Data gerakan ini diubah menjadi format yang dapat digunakan dalam animasi berikutnya, sehingga foto diam dapat disesuaikan dengan gerakan karakter aslinya.

Langkah kedua adalah "pembuatan gerakan dengan panduan audio", di mana sistem menghasilkan pola gerakan alami berdasarkan input audio. Tim peneliti mengembangkan “panduan gerak” yang menganalisis audio dari kedua belah pihak dalam percakapan untuk menciptakan pola gerakan untuk berbicara dan mendengarkan. Komponen AI yang disebut Diffusion Transformer kemudian secara bertahap mengoptimalkan pola-pola ini, menghasilkan gerakan halus dan realistis yang sangat sesuai dengan konten audio.

Untuk melatih sistem secara efektif, tim peneliti juga membuat kumpulan data dialog yang disebut DyConv, yang mengumpulkan lebih dari 200 jam video dialog nyata. Dibandingkan dengan database percakapan yang ada seperti ViCo dan RealTalk, DyConv memiliki keunggulan unik dalam ekspresi emosional dan kualitas video.

ByteDance mengatakan INFP mengungguli alat yang ada di beberapa bidang utama, khususnya dalam mencocokkan gerakan bibir dengan ucapan, mempertahankan fitur wajah individu, dan menciptakan beragam gerakan alami. Selain itu, sistem ini bekerja sama baiknya ketika menghasilkan video yang hanya mendengar lawan bicaranya.

Meskipun INFP saat ini hanya mendukung input audio, tim peneliti sedang menjajaki kemungkinan memperluas sistem ke gambar dan teks. Tujuan masa depannya adalah untuk dapat membuat animasi realistis dari seluruh tubuh karakter. Namun, mengingat jenis teknologi ini dapat digunakan untuk membuat video palsu dan menyebarkan informasi yang salah, tim peneliti berencana untuk membatasi penggunaan teknologi inti hanya untuk lembaga penelitian, serupa dengan manajemen Microsoft terhadap sistem kloning suara canggihnya.

Teknologi ini merupakan bagian dari strategi AI ByteDance yang lebih luas. Mengandalkan aplikasi populernya TikTok dan CapCut, ByteDance memiliki platform aplikasi inovatif AI yang luas.

Pintu masuk proyek: https://grisoon.github.io/INFP/

Highlight:

INFP dapat memungkinkan potret statis untuk "berbicara" melalui audio dan secara otomatis menentukan peran dialog.

Sistem ini bekerja dalam dua langkah: pertama, mengekstrak detail gerakan dalam percakapan manusia, dan kedua, mengubah audio menjadi pola gerakan alami.

Kumpulan data DyConv ByteDance berisi lebih dari 200 jam video percakapan berkualitas tinggi untuk membantu meningkatkan kinerja sistem.

Peluncuran sistem INFP menunjukkan kekuatan inovatif ByteDance di bidang kecerdasan buatan. Potensi pengembangannya di masa depan sangat besar, namun potensi risiko etika juga perlu ditangani dengan hati-hati. Kemajuan teknologi hendaknya selalu berorientasi pada kepentingan sosial dan menjamin penggunaannya untuk kemaslahatan umat manusia.