Tes Benchmark Multi-IF terbaru Meta bertujuan untuk mengevaluasi instruksi model bahasa besar (LLM) yang lebih komprehensif dalam berbagai putaran dialog dan lingkungan multi-bahasa. Berbeda dari kriteria evaluasi lebih banyak perhatian di masa lalu, multi-jika mencakup delapan bahasa, termasuk 4501 tugas dialog roda tiga, dan berusaha untuk mensimulasikan kompleksitas skenario aplikasi nyata, memberikan yang lebih ketat dan menantang untuk evaluasi LLM . Hasil tes benchmark ini mengungkapkan banyak kekurangan dari dialog multi -round LLM saat ini dan tugas multi -ganguage, dan memberikan referensi yang berharga untuk arah peningkatan model masa depan.

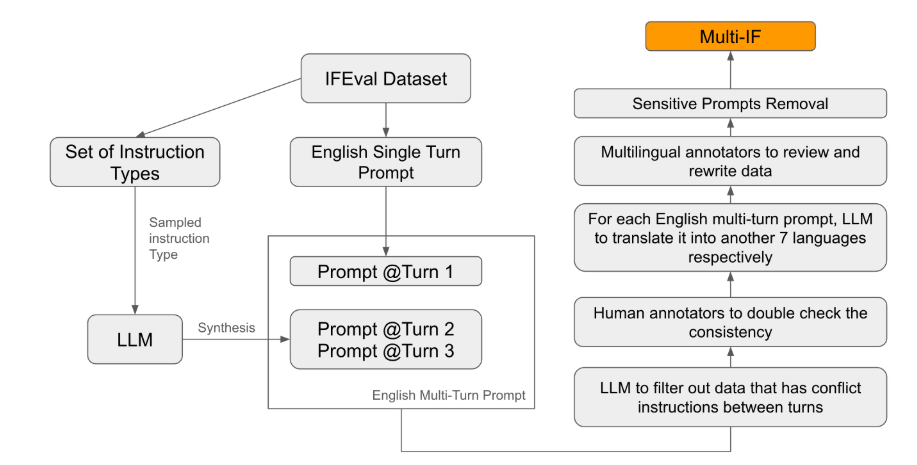

Meta baru-baru ini merilis tes benchmark baru yang disebut Multi-IF, yang bertujuan untuk mengevaluasi kemampuan Model Bahasa Besar (LLM) dalam berbagai putaran dialog dan lingkungan multi-bahasa. Benchmark ini mencakup delapan bahasa, termasuk 4501 tugas dialog tiga roda, yang berfokus pada kinerja model saat ini dalam skenario multi -round dan multi -bahasa yang kompleks.

Dalam standar evaluasi yang ada, kebanyakan dari mereka terkonsentrasi dalam dialog roda tunggal dan tugas bahasa tunggal, yang sulit untuk secara komprehensif mencerminkan kinerja model dalam aplikasi praktis. Peluncuran multi-jika mengisi celah ini. Tim peneliti menghasilkan adegan dialog yang kompleks dengan memperluas instruksi roda tunggal ke dalam beberapa instruksi, dan memastikan bahwa setiap putaran instruksi secara logis koheren dan progresif. Selain itu, dataset juga mencapai dukungan multi -bahasa melalui terjemahan otomatis dan langkah -langkah sekolah buatan.

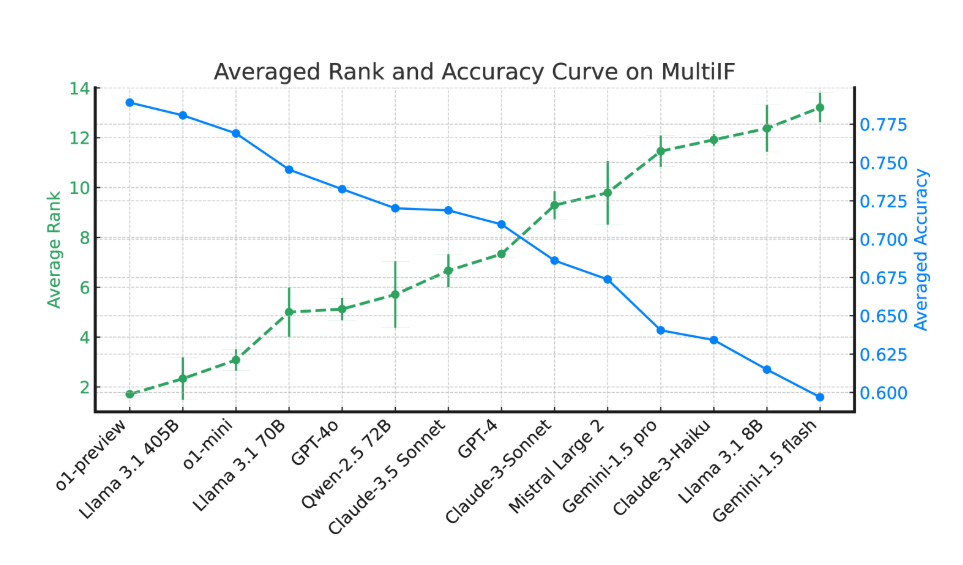

Hasil eksperimen menunjukkan bahwa sebagian besar kinerja LLM dalam beberapa putaran dialog menurun secara signifikan. Mengambil model O1-preview sebagai contoh, akurasi rata-rata di babak pertama adalah 87,7%, tetapi di babak ketiga menjadi 70,7%. Terutama dalam bahasa non -latin, seperti India, Rusia, dan Cina, kinerja model umumnya lebih rendah dari bahasa Inggris, menunjukkan keterbatasan tugas multi -bahasa.

Dalam penilaian 14 model bahasa mutakhir, O1-preview dan LLAMA3.1405B melakukan kinerja terbaik, dan akurasi rata-rata instruksi roda tiga adalah masing-masing 78,9% dan 78,1%. Namun, dalam beberapa putaran dialog, instruksi semua model mengikuti penurunan umum, yang mencerminkan tantangan model dalam tugas -tugas kompleks. Tim peneliti juga memperkenalkan "Instruksi Lupa Tingkat" (IFR) untuk mengukur instruksi model dalam beberapa putaran dialog.

Rilis multi-jika memberi para peneliti tolok ukur yang menantang, mempromosikan pengembangan LLM dalam aplikasi global dan multi-bahasa. Peluncuran tolok ukur ini tidak hanya mengungkapkan kekurangan dari model saat ini dalam tugas multi -round dan multi -ganguage, tetapi juga memberikan arah yang jelas untuk peningkatan di masa depan.

Tesis: https://arxiv.org/html/2410.15553v2

Poin:

Benchmark multi-IF mencakup delapan bahasa, termasuk 4501 tugas dialog roda tiga untuk mengevaluasi kinerja LLM dalam adegan kompleks.

Eksperimen menunjukkan bahwa keakuratan sebagian besar LLM dalam beberapa putaran dialog telah menurun secara signifikan, terutama dalam bahasa teks non -latin.

Model O1-preview dan LLAMA3.1405B melakukan yang terbaik, dan akurasi rata-rata instruksi roda tiga adalah masing-masing 78,9% dan 78,1%.

Secara keseluruhan, penampilan patokan multi-jika memberikan arah baru untuk penilaian model bahasa besar. Promosi kelahiran lebih cerdas dan lebih dekat dengan model praktis.