DeepSeek merilis model inferensi pertamanya DeepSeek-R1 berdasarkan pelatihan pembelajaran penguatan pada 20 Januari 2025. Model tersebut menunjukkan performa yang sebanding atau bahkan lebih baik daripada OpenAI-o1-1217 dalam beberapa pengujian benchmark. DeepSeek-R1 tidak dilatih secara langsung, tetapi melalui pelatihan multi-tahap dan data cold start. Berdasarkan model DeepSeek-V3-Base mengatasi permasalahan yang disebabkan hanya dengan menggunakan model pelatihan pembelajaran penguatan (DeepSeek-R1-Zero). Masalah seperti keterbacaan yang buruk dan bahasa yang tercampur pada akhirnya menghasilkan peningkatan kinerja yang signifikan. Model ini bersumber terbuka dan menawarkan harga yang kompetitif untuk akses API, memberikan pengguna pilihan yang lebih nyaman dan ekonomis.

Pada tanggal 20 Januari 2025, DeepSeek mengumumkan peluncuran model inferensi pertamanya DeepSeek-R1 yang dilatih melalui pembelajaran penguatan (RL), yang mencapai kinerja yang sebanding dengan OpenAI-o1-1217 dalam beberapa tolok ukur inferensi. DeepSeek-R1 didasarkan pada model DeepSeek-V3-Base dan menggunakan pelatihan multi-tahap dan data cold start untuk meningkatkan kemampuan inferensi.

Peneliti DeepSeek pertama kali mengembangkan DeepSeek-R1-Zero, sebuah model yang dilatih sepenuhnya melalui pembelajaran penguatan skala besar tanpa langkah persiapan apa pun untuk penyesuaian yang diawasi. DeepSeek-R1-Zero telah menunjukkan kinerja luar biasa dalam tolok ukur inferensi. Misalnya, dalam ujian AIME2024, skor pass@1 meningkat dari 15,6% menjadi 71,0%. Namun, DeepSeek-R1-Zero juga memiliki beberapa masalah, seperti keterbacaan yang buruk dan bahasa yang tercampur.

Untuk mengatasi masalah ini dan lebih meningkatkan kinerja inferensi, tim DeepSeek mengembangkan DeepSeek-R1. DeepSeek-R1 memperkenalkan pelatihan multi-tahap dan data cold-start sebelum pembelajaran penguatan. Secara khusus, para peneliti pertama-tama mengumpulkan ribuan data cold start untuk menyempurnakan model DeepSeek-V3-Base. Kemudian, mereka melakukan pembelajaran penguatan berorientasi inferensi saat mereka melatih DeepSeek-R1-Zero. Ketika proses pembelajaran penguatan mendekati konvergensi, mereka membuat data penyesuaian baru yang diawasi dengan pengambilan sampel penolakan dari pos pemeriksaan pembelajaran penguatan, dikombinasikan dengan data yang diawasi DeepSeek-V3 di berbagai bidang seperti menulis, menjawab fakta, dan kesadaran diri, lalu dilatih ulang. Model Basis DeepSeek-V3. Terakhir, pembelajaran penguatan tambahan dilakukan pada pos pemeriksaan yang telah disesuaikan dengan menggunakan isyarat dari semua skenario.

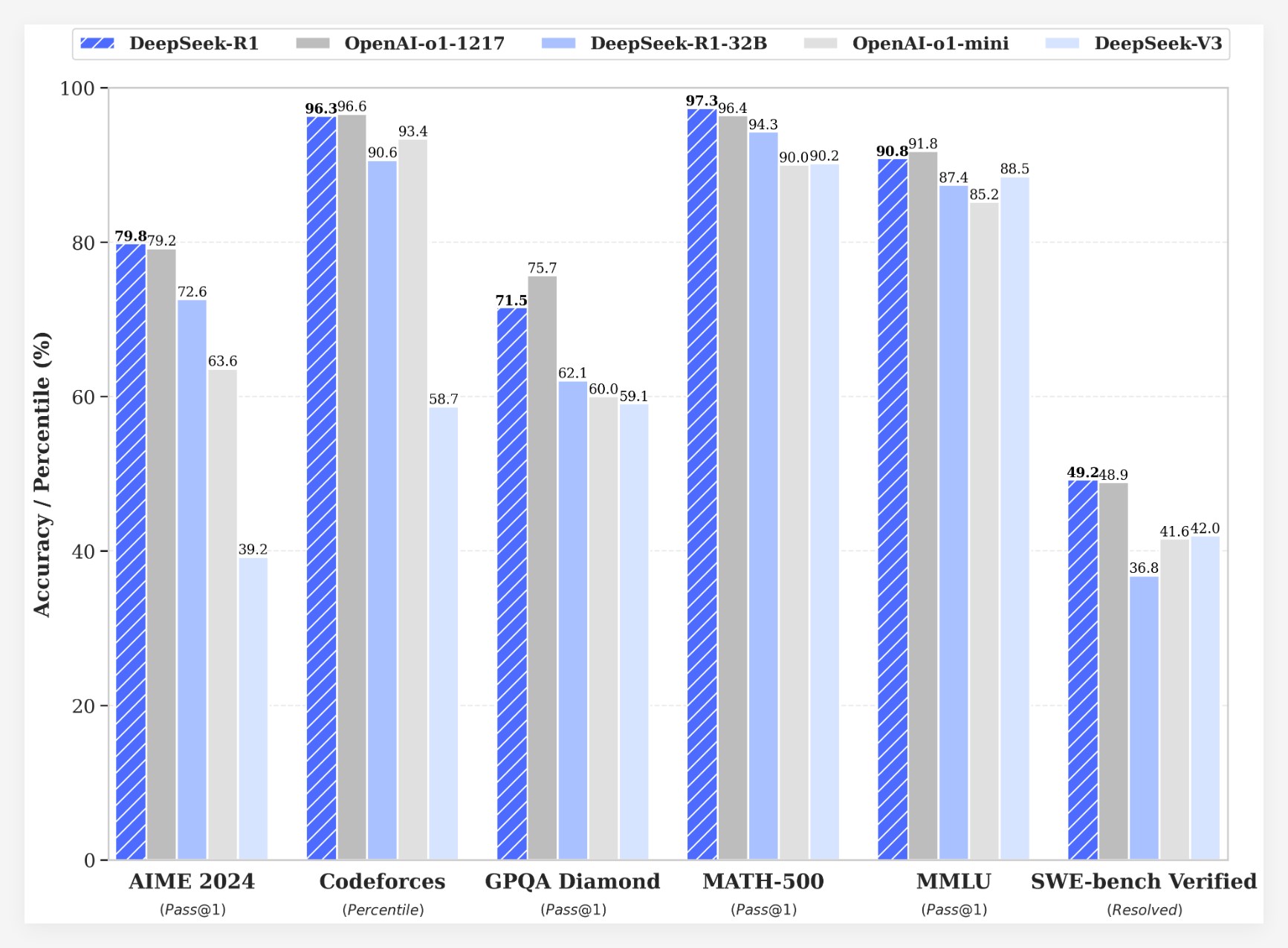

DeepSeek-R1 mencapai hasil yang mengesankan pada berbagai tolok ukur:

•Pada ujian AIME2024, skor pass@1 DeepSeek-R1 mencapai 79,8%, sedikit lebih tinggi dari OpenAI-o1-1217.

•Pada ujian MATH-500, skor pass@1 DeepSeek-R1 mencapai 97,3%, sama dengan OpenAI-o1-1217.

•Dalam tugas kompetisi kode, DeepSeek-R1 mencapai peringkat Elo tahun 2029 di Codeforces, melampaui 96,3% peserta manusia.

•Dalam tolok ukur pengetahuan seperti MMLU, MMLU-Pro, dan GPQA Diamond, DeepSeek-R1 masing-masing mendapat skor 90,8%, 84,0%, dan 71,5%, jauh lebih baik daripada DeepSeek-V3.

•DeepSeek-R1 juga bekerja dengan baik dalam tugas-tugas lain seperti penulisan kreatif, tanya jawab umum, pengeditan, ringkasan, dll.

Selain itu, DeepSeek juga mengeksplorasi penyulingan kemampuan inferensi DeepSeek-R1 ke dalam model yang lebih kecil. Ditemukan bahwa distilasi langsung dari DeepSeek-R1 memiliki kinerja lebih baik daripada menerapkan pembelajaran penguatan pada model kecil. Hal ini menunjukkan bahwa pola inferensi yang ditemukan oleh model basis besar sangat penting untuk meningkatkan kemampuan inferensi. DeepSeek memiliki DeepSeek-R1-Zero, DeepSeek-R1, dan enam model padat bersumber terbuka (1.5B, 7B, 8B, 14B, 32B, 70B) yang disuling dari DeepSeek-R1 berdasarkan Qwen dan Llama. Peluncuran DeepSeek-R1 menandai kemajuan signifikan dalam pembelajaran penguatan dalam meningkatkan kemampuan penalaran model bahasa besar.

keunggulan biayaDari segi biaya, DeepSeek-R1 menawarkan strategi harga yang sangat kompetitif. Harga akses API-nya adalah $0,14 (cache hit) dan $0,55 (cache miss) per juta token masukan, dan $2,19 per juta token keluaran. Strategi harga ini lebih menarik dibandingkan produk serupa lainnya dan telah digambarkan sebagai "pengubah permainan" oleh pengguna. Situs web resmi dan API sekarang online! Kunjungi https://chat.deepseek.com untuk merasakan DeepThink!

Peluncuran DeepSeek-R1 memicu diskusi hangat di komunitas. Banyak pengguna menghargai sifat open source dan keunggulan biaya dari model ini, percaya bahwa model ini memberikan lebih banyak pilihan dan kebebasan kepada pengembang. Namun, beberapa pengguna telah mengajukan pertanyaan tentang ukuran jendela konteks model dan berharap versi mendatang dapat lebih dioptimalkan.

Tim DeepSeek menyatakan bahwa mereka akan terus berupaya meningkatkan kinerja dan pengalaman pengguna model tersebut, dan berencana meluncurkan lebih banyak fitur di masa mendatang, termasuk analisis data tingkat lanjut, untuk memenuhi ekspektasi pengguna terhadap AGI (Artificial General Intelligence).

Peluncuran DeepSeek-R1 tidak hanya menunjukkan potensi besar pembelajaran penguatan dalam meningkatkan kemampuan penalaran model bahasa besar, namun juga membawa arah dan kemungkinan baru bagi pengembangan bidang AI. Fitur-fitur open source dan strategi harga yang kompetitif akan semakin mendorong mempopulerkan dan penerapan teknologi AI.