Artikel ini memperkenalkan metode LLM2CLIP yang dikembangkan oleh Microsoft bekerja sama dengan Universitas Tongji, yang bertujuan untuk meningkatkan kinerja encoder visual dari model klip dan menyelesaikan keterbatasannya dalam menangani deskripsi teks yang panjang dan kompleks. LLM2CLIP secara signifikan meningkatkan kemampuan model untuk mencocokkan gambar dan teks dengan mengintegrasikan model bahasa besar (LLM) dan memperkenalkan teknologi "tuning-tuning kontras" judul. Hasil eksperimen dari metode ini pada beberapa set data menunjukkan bahwa dalam tugas pengambilan gambar-ke-teks dan gambar-ke-gambar, terutama tugas pengambilan teks yang panjang dan pendek, mereka melampaui model klip dan EVA tradisional dan menunjukkan pemrosesan lintas-bahasa yang kuat kemampuan.

Di bidang sains dan teknologi saat ini, klip (pra-pelatihan gambar-bahasa kontras) adalah model dasar multimodal yang penting. Ini menggabungkan sinyal visual dan teks ke dalam ruang fitur bersama dengan menggunakan kehilangan pembelajaran kontras pada pasangan teks-gambar skala besar.

Sebagai pencari, klip dapat mendukung berbagai tugas seperti klasifikasi nol-shot, deteksi, segmentasi, dan pengambilan teks-teks. Sementara itu, sebagai ekstraktor fitur, mendominasi hampir semua tugas representasi lintas-modal seperti pemahaman gambar, pemahaman video, dan pembuatan teks-ke-gambar atau video. Yang kuat tentang klip adalah kemampuannya untuk menghubungkan gambar dengan bahasa alami dan menangkap pengetahuan manusia, berkat pelatihannya tentang data jaringan skala besar, yang berisi deskripsi teks terperinci.

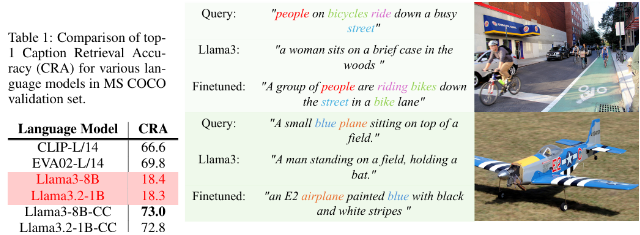

Namun, Clip memiliki keterbatasan tertentu dalam menangani deskripsi teks yang panjang dan kompleks. Untuk mengatasi masalah ini, para peneliti dari Microsoft dan Universitas Tongji mengusulkan metode LLM2CLIP, yang bertujuan untuk meningkatkan pembelajaran representasi visual dengan mengintegrasikan model bahasa besar (LLM). Metode ini dengan berani menggantikan encoder teks klip asli dan menggunakan pengetahuan LLMS yang kaya untuk meningkatkan kinerja clip encoder visual. Studi ini menemukan bahwa secara langsung mengintegrasikan LLM ke dalam hasil klip dalam degradasi kinerja, sehingga tantangan ini perlu ditangani.

Metode LLM2CLIP sangat meningkatkan kemampuan LLM untuk memisahkan judul gambar dengan memperkenalkan teknologi "title kontras fine-tuning", sehingga mencapai peningkatan kinerja yang signifikan.

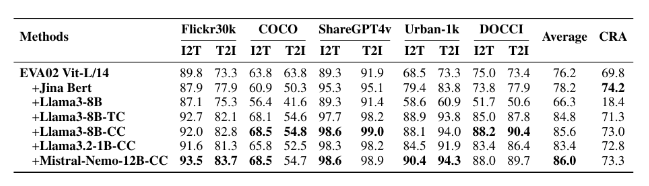

Para peneliti menggunakan set data dengan ukuran yang berbeda untuk percobaan penyempurnaan, termasuk CC-3M kecil, Medium CC-3M dan CC-12M, serta CC-3M besar, CC-12M, YFCC-15M dan RECAPTION-1B. Hasilnya menunjukkan bahwa model yang dilatih menggunakan LLM2Clip berkinerja lebih baik daripada model klip tradisional dan EVA dalam tugas pengambilan gambar-ke-teks dan gambar-ke-gambar.

Dengan menggabungkan pelatihan multimodal dengan model seperti LLAVA 1.5, LLM2CLIP berkinerja baik di hampir semua tolok ukur, terutama ketika berhadapan dengan tugas pengambilan teks yang panjang dan pendek, meningkatkan kinerja model EVA02 sebelumnya sebesar 16,5%. Pendekatan inovatif ini tidak hanya mengubah klip dari sekadar memproses data bahasa Inggris menjadi model lintas-bahasa yang kuat, tetapi juga meletakkan dasar untuk penelitian masa depan tentang pelatihan klip.

Model: https://huggingface.co/collections/microsoft/llm2clip-672323a266173cfa40b32d4c

Kode: https://github.com/microsoft/llm2clip/

Kertas: https://arxiv.org/abs/2411.04997

Poin:

LLM2CLIP adalah pendekatan inovatif yang diusulkan oleh Microsoft dan Universitas Tongji bekerja sama dengan Universitas Tongji, yang bertujuan untuk meningkatkan kinerja encoder visualnya dengan mengganti encoder teks klip.

Metode ini secara signifikan meningkatkan kemampuan model untuk mencocokkan gambar dengan teks melalui teknik "judul kontras fine-tuning", melampaui model canggih yang ada.

Eksperimen LLM2CLIP pada beberapa set data menunjukkan bahwa ia berkinerja lebih baik daripada model tradisional dalam tugas pengambilan teks panjang dan pendek, mendorong pengembangan model lintas bahasa.

Singkatnya, metode LLM2CLIP menyediakan ide-ide baru untuk peningkatan model klip. Tautan sumber daya terkait nyaman bagi pembaca untuk belajar dan meneliti.