Peluncuran IFLYTEK dari model interaksi multi-modal IFLYTEK menandai tonggak baru di bidang kecerdasan buatan. Model ini menembus keterbatasan interaksi suara tunggal di masa lalu, mewujudkan integrasi suara yang mulus dari fungsi interaksi suara, visual dan digital manusia, membawa pengguna pengalaman interaktif yang lebih jelas, lebih realistis, dan lebih nyaman. Teknologi manusia digital super-antropomorfik dapat secara akurat sesuai dengan konten suara untuk menghasilkan ekspresi dan tindakan, dan mendukung interaksi super-antropomorfik, menyesuaikan parameter suara sesuai dengan instruksi, dan menyediakan layanan yang dipersonalisasi. Fungsi interaksi visual multimodal memberi model kemampuan untuk "memahami dunia dan mengenali segalanya", secara akurat memahami informasi lingkungan, dan membuat respons yang lebih tepat.

Peluncuran model interaksi multi-modal IFLYTEK tidak hanya mencerminkan posisi terdepan IFLYTEK dalam teknologi interaksi multi-modal, tetapi juga menyediakan ide-ide baru untuk arah pengembangan aplikasi kecerdasan buatan di masa depan. Dengan mengintegrasikan beberapa metode interaksi, model ini dapat lebih memahami kebutuhan pengguna dan menyediakan layanan yang lebih akurat dan lebih kaya. SDK terbukanya juga memberi pengembang lebih banyak kemungkinan untuk mempromosikan mempopulerkan dan penerapan teknologi kecerdasan buatan multimodal. Di masa depan, kita dapat mengharapkan lebih banyak aplikasi inovatif berdasarkan model ini untuk lebih meningkatkan efisiensi kehidupan dan kualitas pengalaman orang.

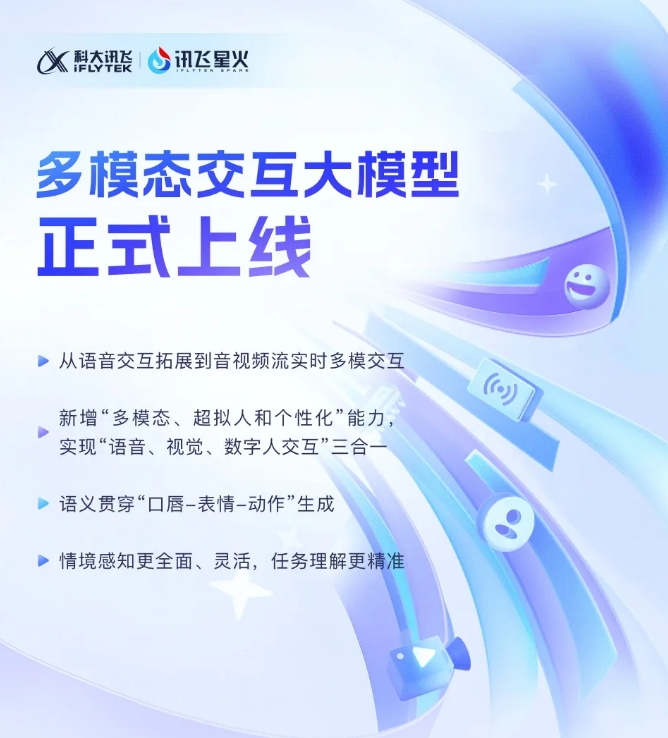

IFLYTEK baru -baru ini mengumumkan bahwa pengembangan terbaru dari model interaksi multimodal IFLYTEK secara resmi telah dioperasikan. Terobosan teknologi ini menandai tahap baru dalam ekspansi IFLYTEK dari satu teknologi interaksi suara ke tahap baru interaksi multimodal real-time dari aliran audio dan video. Model baru ini mengintegrasikan fungsi interaksi suara manusia, visual dan digital, dan pengguna dapat mencapai kombinasi yang mulus dari panggilan ketiga hingga satu klik.

Peluncuran model interaksi multimodal IFLYTEK telah memperkenalkan teknologi manusia digital super-antropomorfik untuk pertama kalinya. nyata. Dengan mengintegrasikan teks, bicara dan ekspresi, model baru ini dapat mencapai konsistensi semantik lintas modal, membuat ekspresi emosional lebih realistis dan koheren.

Selain itu, Iflytek Spark mendukung teknologi interaksi super-fast super-antropomorfik, menggunakan jaringan saraf terpadu untuk secara langsung mewujudkan pemodelan suara ke ujung suara untuk menyuarakan, membuat kecepatan respons lebih cepat dan lebih halus. Teknologi ini dapat dengan tajam memahami perubahan emosional dan secara bebas menyesuaikan ritme, ukuran dan karakter suara sesuai dengan instruksi, memberikan pengalaman interaktif yang lebih personal.

Dalam hal interaksi visual multimodal, Iflytek Spark dapat "memahami dunia" dan "mengenali segalanya", dan sepenuhnya memahami adegan latar belakang tertentu, status logistik dan informasi lainnya, membuat pemahaman tentang tugas lebih akurat. Dengan mengintegrasikan berbagai informasi seperti suara, gerakan, perilaku, dan emosi, model ini dapat membuat respons yang tepat, memberikan pengguna pengalaman interaktif yang lebih kaya dan lebih akurat.

Interaksi multimodal Model besar SDK: https://www.xfyun.cn/solutions/multimodel

Singkatnya, kemunculan model interaksi multimodal IFLYTEK menunjukkan bahwa teknologi kecerdasan buatan telah memasuki tahap pengembangan baru. Menantikan Iflytek Spark akan membawa lebih banyak kejutan di masa depan.