Startup Pipeshift telah meluncurkan platform ujung ke ujung baru yang dirancang untuk membantu perusahaan melatih, menggunakan, dan skala model generatif open source generatif lebih efisien. Platform ini kompatibel dengan berbagai lingkungan cloud dan GPU di tempat, secara signifikan meningkatkan kecepatan inferensi dan mengurangi biaya, memecahkan masalah pengalihan yang efisien antara beberapa model oleh perusahaan. Ini mengadopsi kerangka ajaib mesin inferensi modular, yang memungkinkan kombinasi fleksibel dari berbagai komponen inferensi untuk mengoptimalkan kinerja inferensi tanpa pekerjaan teknik yang membosankan. Ini tidak diragukan lagi merupakan manfaat besar bagi perusahaan yang menghadapi tantangan dalam menyebarkan dan mengelola model AI.

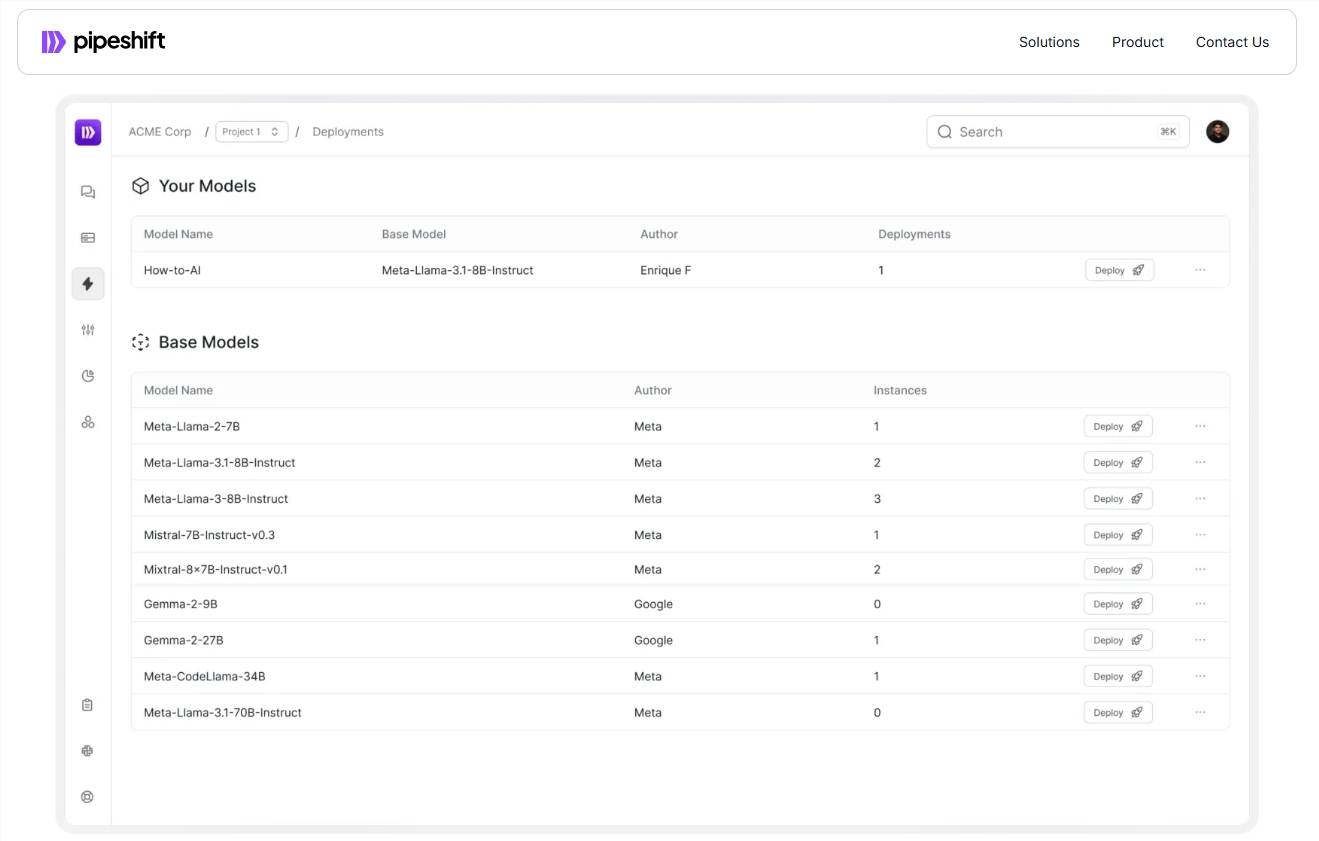

Baru-baru ini, Startup Pipeshift meluncurkan platform ujung ke ujung baru yang dirancang untuk membantu perusahaan melatih, menggunakan dan skala model AI generatif open source secara lebih efisien. Platform tidak hanya berjalan pada lingkungan cloud atau GPU di tempat, tetapi juga secara signifikan meningkatkan kecepatan inferensi dan mengurangi biaya.

Dengan pengembangan teknologi AI yang cepat, banyak perusahaan menghadapi tantangan bagaimana beralih di antara beberapa model secara efisien. Secara tradisional, tim perlu membangun sistem MLOPS yang kompleks yang melibatkan banyak tautan seperti akuisisi sumber daya komputasi, pelatihan model, penyempurnaan, dan penyebaran tingkat produksi. untuk manajemen infrastruktur.

Arko Chattopadhyay, co-founder dan CEO Pipeshift, mencatat bahwa mengembangkan mesin penalaran modular yang fleksibel sering kali membutuhkan pengalaman bertahun-tahun, dan solusi Pipeshift dirancang untuk menyederhanakan proses ini dengan mesin penalaran modularnya. Platform ini mengadopsi kerangka kerja yang disebut Magic (Arsitektur Modular Cluster Inferensi GPU), yang memungkinkan tim untuk secara fleksibel menggabungkan komponen inferensi yang berbeda sesuai dengan persyaratan beban kerja tertentu, sehingga mengoptimalkan kinerja inferensi tanpa perlu rekayasa yang rumit.

Misalnya, perusahaan ritel Fortune 500, setelah menggunakan platform pipeshift, mengintegrasikan empat model yang awalnya membutuhkan empat instance GPU independen untuk menjalankan instance GPU tunggal. Dengan cara ini, perusahaan tidak hanya mencapai peningkatan kecepatan penalaran lima kali lipat, tetapi juga mengurangi biaya infrastruktur sebesar 60%. Prestasi ini memungkinkan perusahaan untuk tetap kompetitif di pasar yang berkembang pesat.

Pipeshift telah mencapai perjanjian lisensi tahunan dengan 30 perusahaan dan berencana untuk meluncurkan alat untuk membantu tim membangun dan skala set data di masa depan. Ini akan semakin mempercepat proses eksperimental dan persiapan data dan meningkatkan produktivitas pelanggan.

Pintu masuk resmi: https://pipeshift.com/

Poin:

Mesin inferensi modular Pipeshift dapat secara signifikan mengurangi penggunaan GPU inferensi AI dan mengurangi biaya hingga 60%.

Melalui kerangka kerja ajaib, perusahaan dapat dengan cepat menggabungkan komponen inferensi, meningkatkan kecepatan inferensi dan mengurangi beban rekayasa.

Pipeshift telah bermitra dengan beberapa perusahaan dan akan meluncurkan lebih banyak alat di masa depan untuk membantu perusahaan mengelola beban kerja AI dengan lebih efisien.

Dengan karakteristiknya yang efisien, fleksibel, dan hemat biaya, platform pipeshift memberikan perusahaan solusi yang efektif untuk menyederhanakan penyebaran dan manajemen model AI, yang patut diperhatikan. Pengembangannya di masa depan dan peluncuran alat baru juga layak untuk dinantikan.