Dengan perkembangan cepat model bahasa besar multimodal (MLLM), pemrosesan video ultra-panjang yang efisien telah menjadi topik hangat dalam penelitian saat ini. Model yang ada sering dibatasi oleh panjang konteks dan biaya komputasi, membuatnya sulit untuk secara efektif memahami video per jam. Menanggapi tantangan ini, Zhiyuan Research Institute dan beberapa universitas telah meluncurkan Video-XL, model bahasa visual yang sangat panjang yang dirancang khusus untuk pemahaman video tingkat jam yang efisien.

Saat ini, Model Bahasa Multimodal Besar (MLLM) telah membuat kemajuan yang signifikan dalam bidang pemahaman video, tetapi menangani video ultra-panjang tetap menjadi tantangan. Ini karena MLLM sering berjuang untuk menangani ribuan penanda visual yang melebihi panjang konteks maksimum dan dipengaruhi oleh pelemahan informasi yang disebabkan oleh agregasi tanda. Pada saat yang sama, sejumlah besar tag video juga akan membawa biaya komputasi yang tinggi.

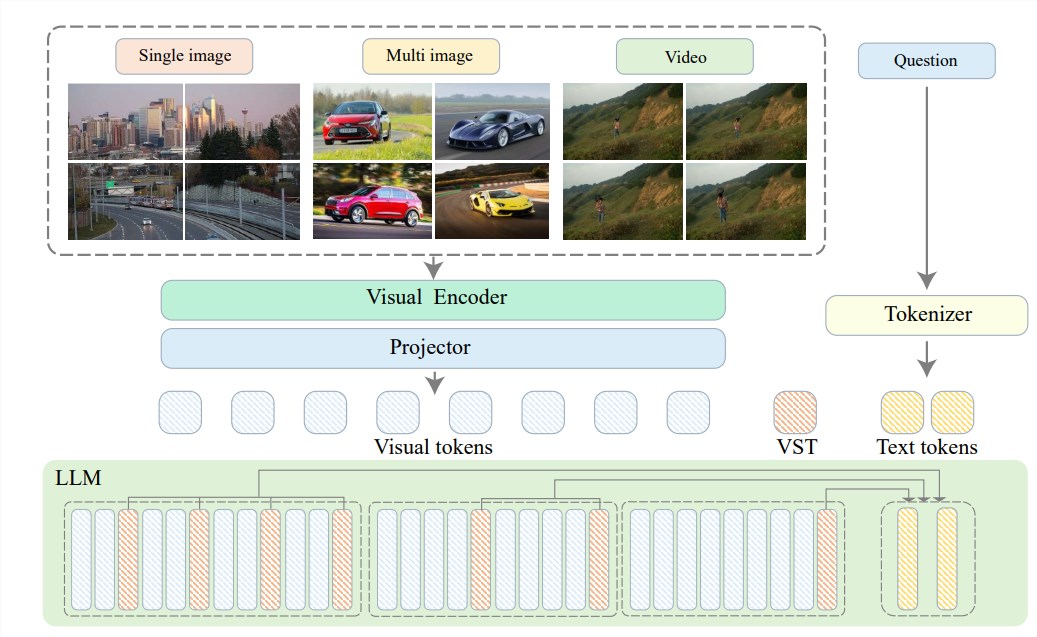

Untuk menyelesaikan masalah ini, Zhiyuan Research Institute telah mengusulkan Video-XL dalam hubungannya dengan Universitas Shanghai Jiaotong, Renmin University of China, Universitas Peking dan Universitas Pos dan Telekomunikasi Beijing, visual video tingkat jam yang efisien Model Bahasa. Di jantung Video-XL terletak pada teknologi “Ringkasan Potensi Konteks Visual”, yang memanfaatkan kemampuan pemodelan konteks yang melekat dalam LLM untuk secara efektif mengompres representasi visual yang panjang ke dalam bentuk yang lebih ringkas.

Sederhananya, ini adalah untuk mengompres konten video menjadi bentuk yang lebih ramping, sama seperti memusatkan seluruh daging sapi ke dalam mangkuk esensi daging sapi, yang nyaman bagi model untuk dicerna dan diserap.

Teknologi kompresi ini tidak hanya meningkatkan efisiensi, tetapi juga secara efektif mempertahankan informasi utama video. Anda harus tahu bahwa video panjang sering dipenuhi dengan banyak informasi yang berlebihan, seperti halnya ikatan kaki wanita tua, yang panjang dan bau. Video-XL dapat secara akurat menghilangkan informasi yang tidak berguna ini dan hanya mempertahankan esensi, yang memastikan bahwa model tidak akan kehilangan arah ketika memahami konten video yang panjang.

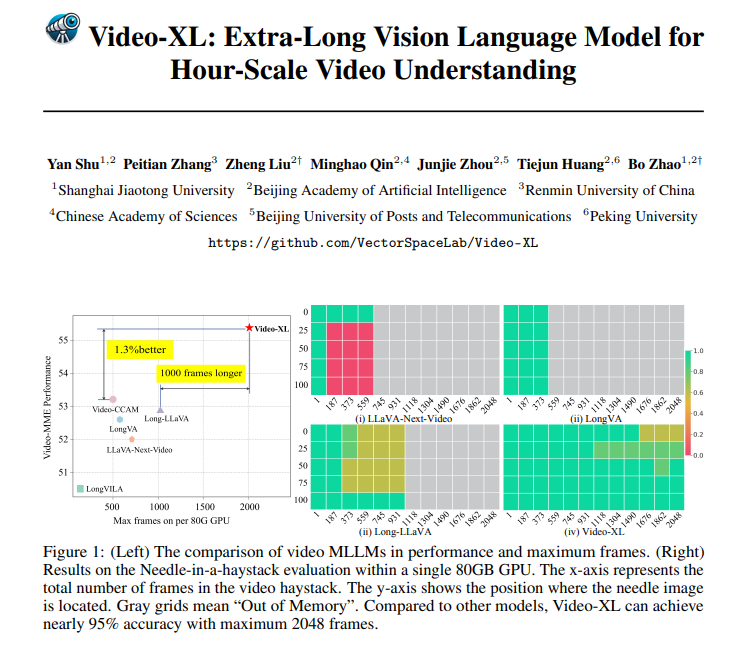

Video-XL tidak hanya sangat kuat dalam teori, tetapi juga memiliki kemampuan praktis yang sangat kuat. Video-XL telah memimpin dalam beberapa tolok ukur pemahaman video panjang, terutama dalam tes VNBench, dengan akurasi hampir 10% lebih tinggi dari metode terbaik yang ada.

Yang lebih mengesankan adalah bahwa Video-XL menyerang keseimbangan yang luar biasa antara efisiensi dan efektivitas, ia dapat memproses 2048 frame video pada GPU 80GB tunggal sambil tetap mempertahankan akurasi hampir 95% dalam tingkat evaluasi “Temukan Jarum Dalam Jeray Kayabis”.

Video-XL memiliki prospek aplikasi yang sangat luas. Selain memahami video panjang umum, ini juga dapat menjadi kompeten untuk tugas -tugas tertentu, seperti ringkasan film, memantau deteksi anomali dan pengakuan implan iklan.

Ini berarti bahwa Anda tidak perlu menanggung plot yang panjang saat menonton film di masa depan. acara, yang jauh lebih efisien daripada menguntit manual.

Alamat proyek: https://github.com/vectorspacelab/video-xl

Kertas: https://arxiv.org/pdf/2409.14485

Singkatnya, Video-XL telah membuat kemajuan terobosan di bidang pemahaman video yang sangat panjang.