Para peneliti di Universitas Princeton dan Universitas Yale melakukan penelitian mendalam tentang kemampuan penalaran "Chain of Thinking (COT)" dari model bahasa besar (LLM) dan merilis laporan yang relevan. Studi ini mengambil retak kata sandi shift sebagai tugas tes dan memilih tiga LLMS GPT-4, CLAUDE3 dan LLAMA3.1 untuk analisis, yang bertujuan untuk mengungkapkan mekanisme di balik inferensi COT. Penelitian telah menemukan bahwa penalaran COT LLM bukanlah penalaran logis simbolis yang sederhana, tetapi hasil dari interaksi kompleks dari berbagai faktor, yang memberikan perspektif baru bagi kita untuk memahami kemampuan penalaran LLM.

Para peneliti di Princeton dan Yale University baru -baru ini merilis laporan tentang kemampuan penalaran "Linking Chain (COT)" dalam Model Bahasa Besar (LLM), mengungkapkan misteri penalaran COT: bukan penalaran simbolis hanya berdasarkan aturan logis, tetapi Ini menggabungkan memori, probabilitas, dan penalaran kebisingan.

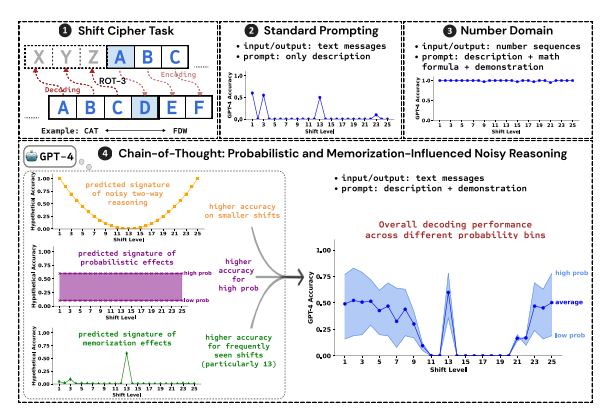

Para peneliti menggunakan memecahkan kata sandi shift sebagai tugas pengujian untuk menganalisis kinerja tiga LLM, GPT-4, CLAUDE3 dan LLAMA3.1. Kata sandi shift adalah metode pengkodean sederhana, dan setiap huruf digantikan oleh huruf yang bergerak maju dalam alfabet dengan digit tetap. Misalnya, gerakkan alfabet ke depan dengan 3 digit dan "kucing" menjadi "FDW".

Hasil penelitian menunjukkan bahwa tiga faktor kunci yang mempengaruhi efektivitas inferensi COT adalah:

Probabilitas: LLM cenderung menghasilkan output dengan probabilitas yang lebih tinggi, bahkan jika langkah -langkah inferensi ke jawaban dengan probabilitas yang lebih rendah. Misalnya, jika langkah penalaran menunjuk ke "staz", tetapi "tetap" adalah kata yang lebih umum, llm dapat "memperbaiki dirinya sendiri" dan output "tetap".

Memori: LLM mengingat sejumlah besar data teks selama pra-pelatihan, yang mempengaruhi keakuratan inferensi COT-nya. Misalnya, ROT-13 adalah kata sandi shift yang paling umum, dan LLM memiliki akurasi yang jauh lebih tinggi pada ROT-13 daripada jenis kata sandi shift lainnya.

Penalaran Kebisingan: Proses penalaran LLM tidak sepenuhnya akurat, tetapi ada tingkat kebisingan tertentu. Ketika perpindahan kata sandi shift meningkat, langkah -langkah perantara yang diperlukan untuk decoding juga meningkat, dan dampak inferensi kebisingan menjadi lebih jelas, menghasilkan penurunan akurasi LLM.

Para peneliti juga menemukan bahwa penalaran COT LLM bergantung pada pendingin diri, yaitu LLM perlu secara eksplisit menghasilkan teks sebagai konteks untuk langkah-langkah penalaran berikutnya. Jika LLM diinstruksikan untuk "berpikir diam -diam" tanpa mengeluarkan teks apa pun, kemampuan penalarannya akan sangat berkurang. Selain itu, efektivitas langkah demonstrasi memiliki sedikit dampak pada inferensi COT.

Studi ini menunjukkan bahwa penalaran COT LLM bukanlah penalaran simbolis yang sempurna, tetapi menggabungkan beberapa faktor seperti memori, probabilitas dan penalaran kebisingan. LLM tidak hanya menunjukkan karakteristik master memori dalam proses penalaran COT, tetapi juga menunjukkan gaya master probabilitas. Penelitian ini membantu kita untuk memiliki pemahaman yang lebih dalam tentang kemampuan penalaran LLM dan memberikan wawasan yang berharga untuk pengembangan sistem AI yang lebih kuat di masa depan.

Alamat kertas: https://arxiv.org/pdf/2407.01687

Singkatnya, penelitian ini sangat penting untuk memahami mekanisme penalaran model bahasa besar, dan temuannya memberikan referensi yang berharga untuk meningkatkan kemampuan penalaran LLM di masa depan dan mengembangkan sistem AI yang lebih kuat. Studi ini menekankan dampak faktor -faktor seperti probabilitas, memori dan kebisingan pada penalaran LLM, memberikan arah baru bagi para peneliti di bidang AI.