Menghasilkan video panjang berkualitas tinggi secara efisien selalu menjadi tantangan besar di bidang visi komputer. Peneliti Meta AI mengusulkan metode akselerasi bebas pelatihan yang disebut Adacache sebagai respons terhadap inferensi lambat model transformator difusi yang ada (DIT). Adacache dengan cerdik menggunakan perbedaan konten video, menyesuaikan strategi caching untuk setiap video, dan memperkenalkan skema regularisasi gerak untuk secara dinamis mengalokasikan sumber daya komputasi berdasarkan konten gerak video, sehingga secara signifikan meningkatkan kecepatan inferensi sambil memastikan kualitas pembuatan.

Menghasilkan video berkualitas tinggi, kontinu waktu membutuhkan banyak sumber daya komputasi, terutama untuk rentang waktu yang lebih lama. Meskipun model transformator difusi terbaru (DIT) telah membuat kemajuan yang signifikan dalam pembuatan video, tantangan ini diperburuk oleh penalaran yang lebih lambat karena ketergantungannya pada model yang lebih besar dan mekanisme perhatian yang lebih kompleks. Untuk mengatasi masalah ini, para peneliti di Meta AI mengusulkan metode bebas pelatihan yang disebut Adacache untuk mempercepat video video.

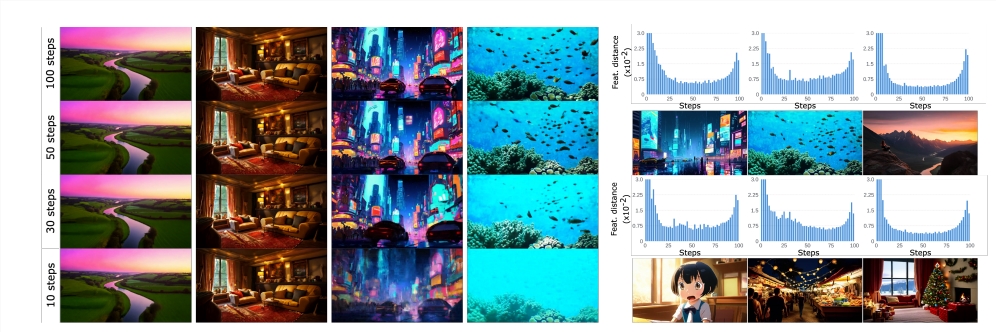

Gagasan inti dari Adacache didasarkan pada fakta bahwa "tidak semua video adalah sama", yang berarti bahwa beberapa video membutuhkan lebih sedikit langkah denoising daripada yang lain untuk mencapai kualitas yang masuk akal. Berdasarkan hal ini, metode ini tidak hanya menyimpan hasil perhitungan selama proses difusi, tetapi juga merancang strategi cache yang disesuaikan untuk setiap pembuatan video, sehingga memaksimalkan trade-off antara kualitas dan latensi.

Para peneliti selanjutnya memperkenalkan skema regularisasi gerak (MORGG), yang menggunakan informasi video di Adacache untuk mengontrol alokasi sumber daya komputasi berdasarkan konten gerak. Karena urutan video yang berisi tekstur frekuensi tinggi dan sejumlah besar konten gerak membutuhkan lebih banyak langkah difusi untuk mencapai kualitas yang wajar, lebih baik dapat mengalokasikan sumber daya komputasi dengan lebih baik.

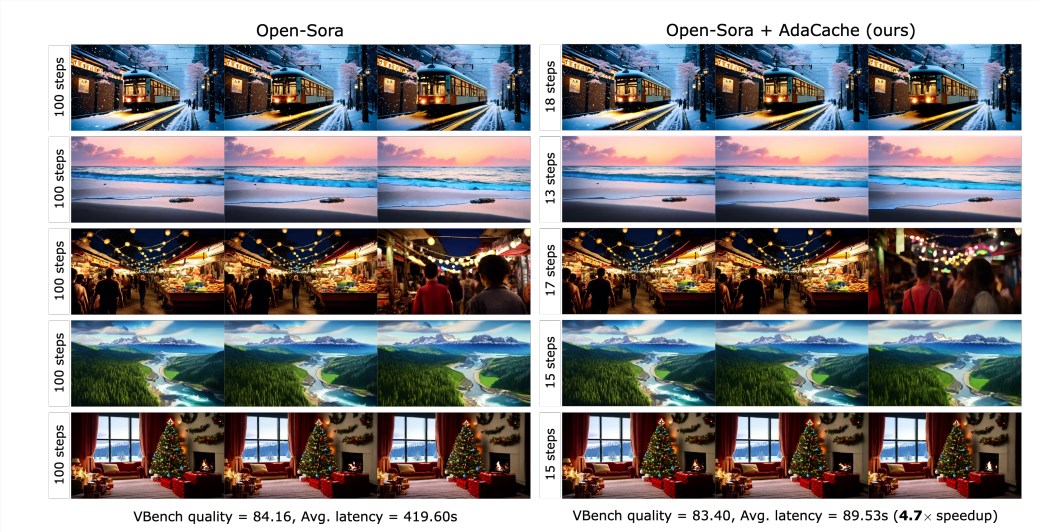

Hasil eksperimen menunjukkan bahwa Adacache dapat secara signifikan meningkatkan kecepatan inferensi (misalnya, hingga 4,7 kali lebih cepat dalam pembuatan video -sora720p -2s terbuka) tanpa mengorbankan kualitas generasi. Selain itu, Adacache memiliki kemampuan generalisasi yang baik dan dapat diterapkan pada model DIT video yang berbeda, seperti Open-Sora, Open-Sora-Plan, dan Latte. Adacache memiliki keunggulan yang signifikan dalam kecepatan dan kualitas dibandingkan dengan metode akselerasi bebas pelatihan lainnya seperti ∆-dit, T-gate, dan PAB.

Penelitian pengguna menunjukkan bahwa pengguna lebih suka video yang dihasilkan Adacache dibandingkan dengan metode lain dan percaya bahwa kualitasnya sebanding dengan model benchmark. Studi ini mengkonfirmasi efektivitas Adacache dan memberikan kontribusi penting untuk bidang pembuatan video yang efisien. Meta AI percaya bahwa Adacache dapat digunakan secara luas dan mempromosikan mempopulerkan pembuatan video panjang kesetiaan tinggi.

Kertas: https://arxiv.org/abs/2411.02397

Beranda Proyek:

https://adacache-dit.github.io/

GitHub:

https://github.com/adacache-dit/adacache

Singkatnya, Adacache, sebagai metode percepatan pembuatan video yang efisien, memberikan kemungkinan baru untuk generasi video panjang kesetiaan tinggi, dan peningkatan kinerja yang signifikan dan pengalaman pengguna yang baik membuatnya memiliki prospek luas dalam aplikasi masa depan. Penelitian oleh Meta AI ini telah membawa terobosan penting di bidang pembuatan video yang efisien.