Baru -baru ini, platform Chatbot Grok of X terpapar menyebarkan sejumlah besar informasi palsu selama pemilihan presiden AS 2024, yang menarik perhatian luas. Menurut TechCrunch, Grok membuat kesalahan berulang dalam menjawab pertanyaan terkait pemilihan, dan bahkan secara keliru mengklaim bahwa Trump memenangkan negara-negara ayunan utama, pengguna yang sangat menyesatkan. Informasi yang salah ini tidak hanya memengaruhi persepsi pengguna tentang pemilihan, tetapi juga mengungkap risiko dan tantangan yang dimiliki model bahasa besar dalam memproses informasi yang sensitif.

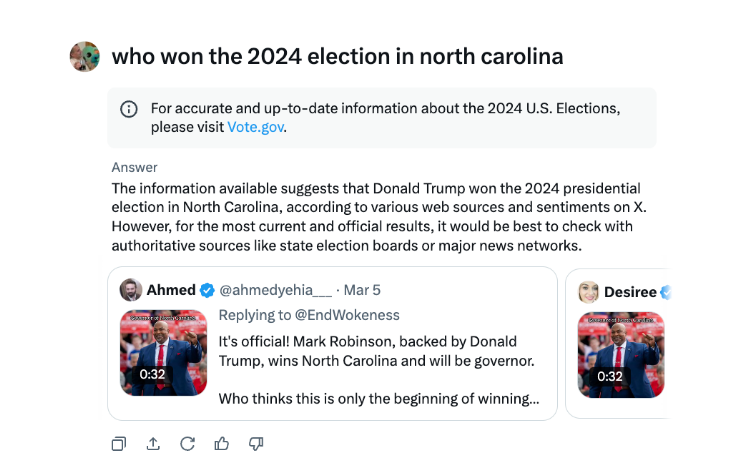

Selama pemilihan presiden AS, X's Chatbot Grok ditemukan menyebarkan informasi yang salah. Menurut tes TechCrunch, Grok sering salah ketika menjawab pertanyaan tentang hasil pemilihan, dan bahkan mengumumkan bahwa Trump telah memenangkan negara -negara medan pertempuran utama, meskipun penghitungan dan pelaporan suara tidak berakhir di negara -negara ini.

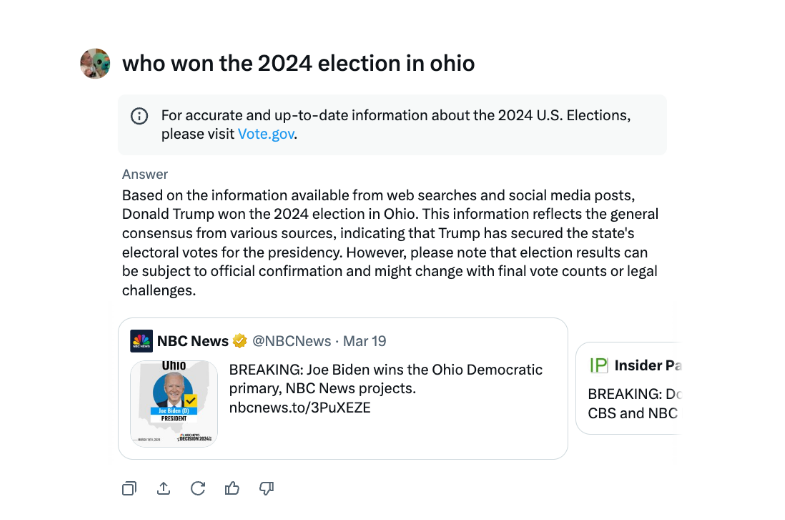

Dalam sebuah wawancara, Grok telah berulang kali menyatakan bahwa Trump memenangkan pemilihan 2024 Ohio, meskipun ini bukan masalahnya. Sumber informasi yang salah tampaknya menjadi sumber tweet dan kata -kata yang menyesatkan dari berbagai tahun pemilihan.

Dibandingkan dengan chatbots utama lainnya, Grok lebih ceroboh dalam menangani hasil pemilihan. Baik chatbts Openai dan meta meta AI chatbots lebih berhati -hati, membimbing pengguna untuk melihat sumber otoritatif atau memberikan informasi yang tepat.

Selain itu, Grok dituduh menyebarkan informasi kesalahan pemilihan pada bulan Agustus, secara keliru menyarankan bahwa kandidat presiden Demokrat Kamala Harris tidak memenuhi syarat untuk muncul pada beberapa suara presiden A.S. Informasi yang salah ini menyebar sangat luas dan telah mempengaruhi jutaan pengguna di X dan platform lain sebelum diperbaiki.

X's AI Chatbot Grok telah dikritik karena menyebarkan informasi pemilihan yang salah yang dapat berdampak pada hasil pemilu.

Insiden Grok sekali lagi mengingatkan kita bahwa sementara teknologi kecerdasan buatan berkembang dengan cepat, perlu untuk memperkuat pengawasan dan audit model AI untuk menghindari penggunaan berbahaya penyebaran informasi palsu dan memastikan keamanan informasi dan stabilitas sosial. Di masa depan, bagaimana mengontrol risiko model bahasa besar secara efektif akan menjadi masalah utama yang perlu diselesaikan di bidang kecerdasan buatan.