Tim peneliti dari Stanford University dan University of Washington baru-baru ini merilis metode pelatihan AI terobosan yang disebut S1. Berbeda dengan ketergantungan masa lalu pada daya komputasi yang sangat besar atau algoritma yang kompleks, metode S1 secara cerdik mencapai lompatan kinerja dengan mengendalikan alokasi sumber daya komputasi model selama pengujian.

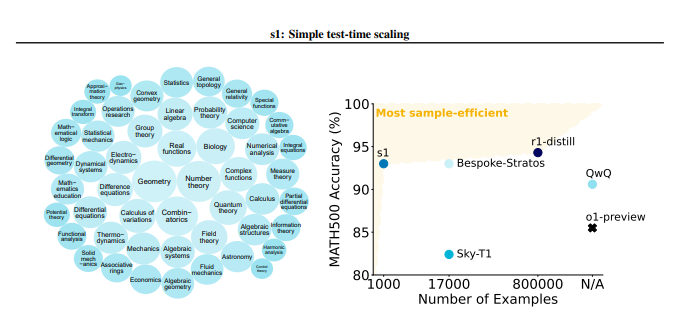

Metode S1 terlebih dahulu membangun dataset kecil yang disebut S1K yang berisi 1000 masalah inferensi berkualitas tinggi. Standar penyaringan set data ini sangat ketat dan harus memenuhi tiga kondisi kesulitan tinggi, keragaman yang kuat dan kualitas yang sangat baik pada saat yang sama. Tim peneliti memverifikasi pentingnya ketiga kriteria ini melalui eksperimen ablasi terperinci, dan hasilnya menunjukkan bahwa seleksi acak atau fokus pada kriteria tunggal akan menyebabkan penurunan kinerja yang signifikan. Perlu disebutkan bahwa bahkan jika dilatih menggunakan superset yang berisi 59.000 sampel, efeknya jauh lebih sedikit daripada 1.000 sampel yang dipilih dengan cermat, yang menyoroti kekritisan pemilihan data.

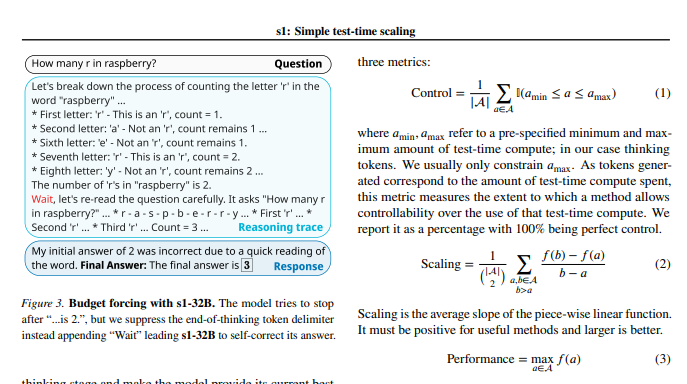

Setelah pelatihan model selesai, para peneliti menggunakan teknik yang disebut "anggaran wajib" untuk mengontrol jumlah perhitungan selama pengujian. Sederhananya, metode ini memperpanjang waktu berpikir model dengan secara paksa mengakhiri proses pemikiran model atau menambahkan instruksi "tunggu", sehingga memandu model untuk eksplorasi dan verifikasi yang lebih mendalam. Dengan cara ini, model dapat berulang kali memeriksa langkah -langkah inferensi dan secara efektif memperbaiki kesalahan.

Hasil eksperimen menunjukkan bahwa dengan menyempurnakan pada dataset S1K dan dukungan teknologi "anggaran wajib", kinerja model S1-32B dalam masalah matematika tingkat kompetisi melebihi model preview O1 OpenAI hingga 27%. Yang lebih mengejutkan adalah bahwa melalui penskalaan "anggaran wajib", model S1-32B juga menunjukkan kemampuan generalisasi di luar tingkat pelatihannya sendiri, dan skornya pada set tes AIME24 meningkat dari 50% menjadi 57%.

Kontribusi inti dari penelitian ini adalah bahwa ia menyediakan metode yang sederhana dan efisien untuk membuat set data dengan kemampuan inferensi yang tinggi dan mencapai penskalaan kinerja saat pengujian. Berdasarkan hal ini, tim peneliti menciptakan model S1-32B, yang kinerjanya sebanding dengan atau bahkan melampaui model sumber tertutup, dan pada saat yang sama mencapai open source dan efisiensi sampel yang tinggi. Kode, model, dan data untuk penelitian ini bersumber terbuka di GitHub.

Para peneliti juga melakukan percobaan ablasi mendalam pada seluk-beluk data dan teknik penskalaan selama pengujian. Di sisi data, mereka merasa penting untuk mempertimbangkan kesulitan, keragaman, dan kualitas pada saat yang sama. Dalam hal penskalaan pada waktu pengujian, pendekatan "anggaran wajib" menunjukkan kemampuan kontrol yang sangat baik dan peningkatan kinerja. Studi ini juga mengeksplorasi dua metode yang berbeda, penskalaan paralel dan penskalaan berurutan, dan memperkenalkan teknologi canggih seperti rebase, memberikan inspirasi penting untuk arahan penelitian di masa depan.

Studi ini tidak hanya membawa ide baru dan efisiensi rendah ke bidang pelatihan AI, tetapi juga meletakkan dasar yang kuat untuk berbagai aplikasi AI.

Alamat kertas: https://arxiv.org/pdf/2501.19393

Studi ini menunjukkan bahwa melalui konstruksi data yang cermat dan manajemen sumber daya komputasi pengujian waktu, kemampuan inferensi model AI dapat ditingkatkan secara signifikan, memberikan arahan baru untuk pengembangan AI di masa depan.