Baru-baru ini, tim Vita-MLLM merilis hasil penelitian terbarunya Vita-1.5. Vita-1..5 tidak hanya mendukung dua bahasa: bahasa Inggris dan Cina, tetapi juga mencapai lompatan kualitatif dalam berbagai indikator kinerja, membawa pengguna pengalaman interaktif yang lebih halus dan lebih efisien.

Vita-1..5 telah membuat terobosan besar dalam keterlambatan interaksi, sangat memperpendek penundaan 4 detik asli menjadi hanya 1,5 detik. Peningkatan ini memungkinkan pengguna untuk hampir tidak ada penundaan selama interaksi suara, sangat meningkatkan pengalaman pengguna. Selain itu, Vita-1..5 juga secara signifikan meningkat dalam kinerja multimodal.

Dalam hal pemrosesan suara, Vita-1.5 juga telah dioptimalkan secara mendalam. Tingkat kesalahan sistem pengenalan ucapan otomatis (ASR) telah turun dari 18,4 menjadi 7,5, secara signifikan meningkatkan akurasi pemahaman dan respons perintah suara. Pada saat yang sama, Vita-1..5 memperkenalkan modul teks-ke-end-to-end baru (TTS), yang dapat secara langsung menerima embeddings dari model bahasa besar (LLM) sebagai input, sangat meningkatkan kealamian dan koherensi sintesis bicara .

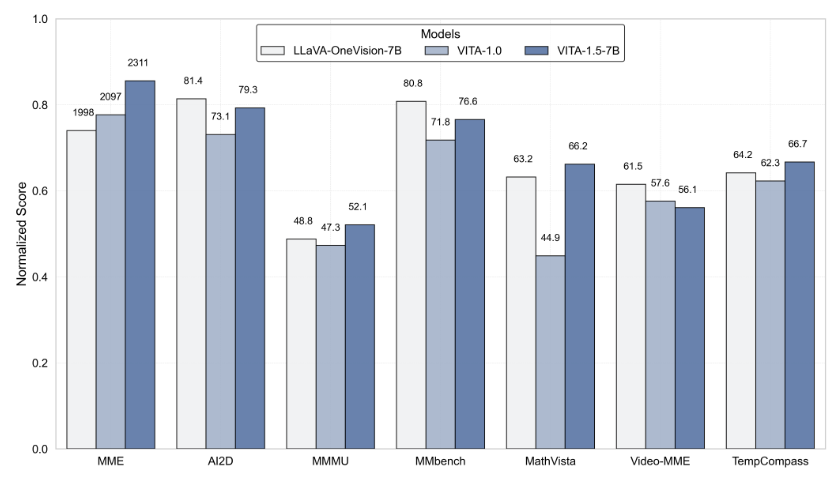

Untuk memastikan keseimbangan kemampuan multimodal, Vita-1.5 mengadopsi strategi pelatihan progresif, yang meminimalkan dampak dari modul pemrosesan wicara yang baru ditambahkan pada kinerja bahasa visual, dan kinerja pemahaman gambar hanya sedikit menurun dari 71.3 menjadi 70.8. Melalui inovasi teknologi ini, VITA-1.5 lebih lanjut mempromosikan batas antara interaksi visual dan suara real-time, meletakkan dasar yang kuat untuk aplikasi interaksi cerdas di masa depan.

Untuk pengembang, Vita-1..5 sangat nyaman digunakan. Pengembang dapat dengan cepat memulai dengan operasi baris perintah sederhana, dan tim juga menyediakan demonstrasi interaktif dasar dan real-time untuk membantu pengguna lebih memahami dan menggunakan sistem. Untuk lebih meningkatkan pengalaman interaktif real-time, pengguna perlu menyiapkan beberapa modul yang diperlukan, seperti modul deteksi aktivitas suara (VAD). Selain itu, kode Vita-1.5 akan sepenuhnya open source, memungkinkan pengembang untuk berpartisipasi dan berkontribusi, dan bersama-sama mempromosikan kemajuan teknologi ini.

Peluncuran Vita-1..5 menandai tonggak penting lainnya di bidang model bahasa multimoda interaktif, menunjukkan pengejaran tim Vita-MLLM yang tak henti-hentinya dalam inovasi teknologi dan pengalaman pengguna. Rilis versi ini tidak hanya membawa pengguna pengalaman interaktif yang lebih cerdas, tetapi juga menunjukkan arah untuk pengembangan teknologi multimodal di masa depan.

Pintu masuk proyek: https://github.com/vita-mllm/vita?tab=readme-ov-file

Poin -Poin Kunci:

Vita-1..5 secara signifikan mengurangi latensi interaksi, memperpendek dari 4 detik menjadi 1,5 detik, secara signifikan meningkatkan pengalaman pengguna.

Kinerja multimodal telah meningkat, dengan kinerja rata -rata beberapa tolok ukur meningkat dari 59,8 menjadi 70,8.

Kemampuan pemrosesan suara ditingkatkan, tingkat kesalahan ASR telah turun dari 18,4 menjadi 7,5, dan pengenalan suara lebih akurat.