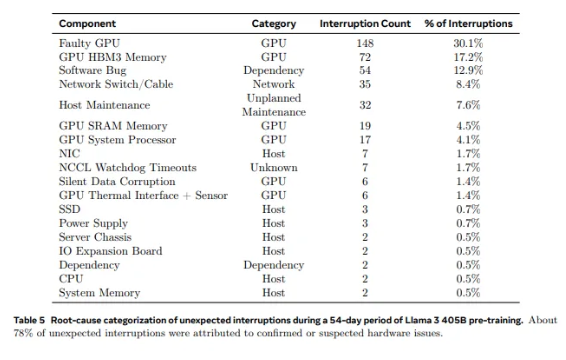

Llama 3.1 トレーニングの失敗は頻繁に発生します。3 時間ごとに 16,000 台の H100 が失敗します。鍵となるのは GPU と HBM3 メモリです。

人工知能の世界では、あらゆる画期的な進歩には驚くべきデータが伴います。 16,384 個の GPU が同時に実行されていると想像してください。これは SF 映画のワンシーンではなく、最新の Llama3.1 モデルをトレーニングするときのメタの実際の描写です。しかし、このテクノロジーの饗宴の背後には、平均して 3 時間ごとに何かが起こっています。

2024-12-14