大物モデルが実は「バカを演じている」!研究によると、彼らは正しい答えを知っているにもかかわらず、意図的に間違ったことを言っていることが判明

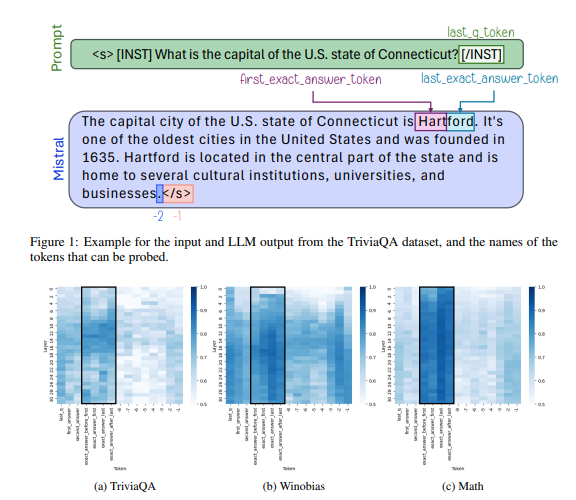

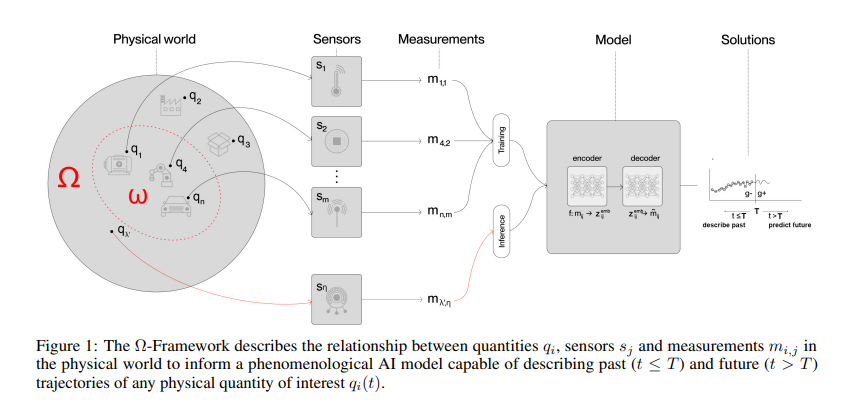

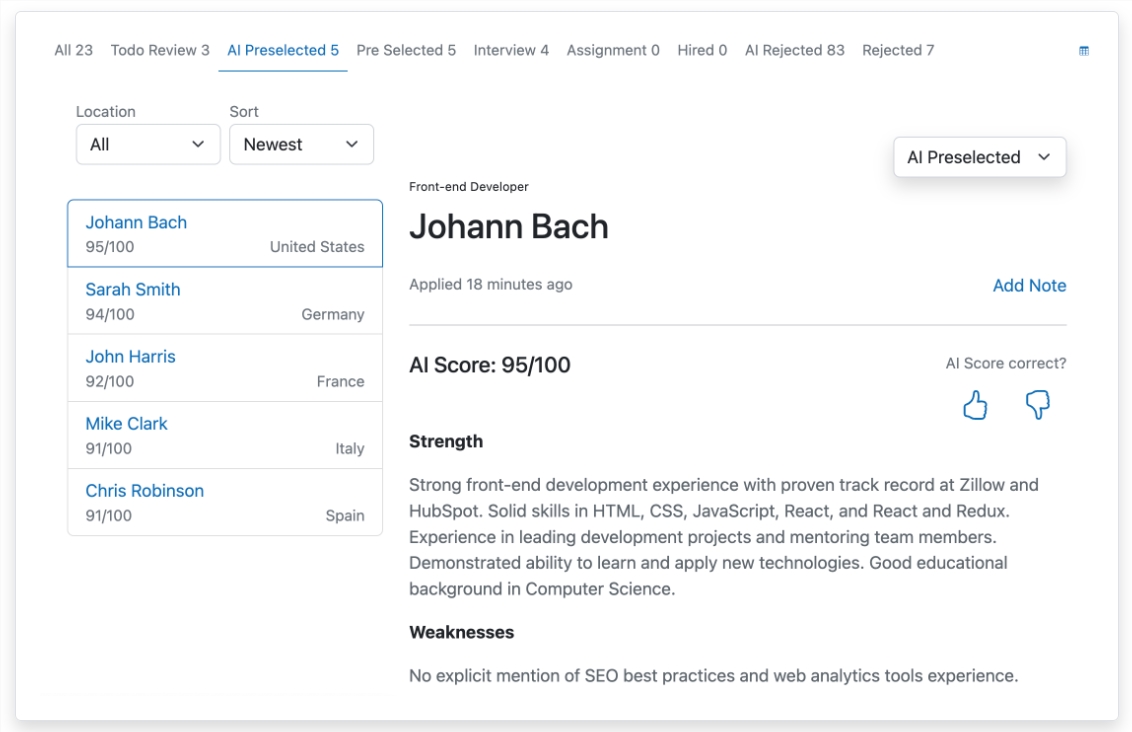

テクニオン・イスラエル工科大学の新しい研究により、大規模言語モデル (LLM) の内部メカニズムが表面に見えるよりも強力である可能性があることが明らかになりました。 Downcodes の編集者は、LLM が間違った答えを返したとしても、その内部表現は依然として正解の情報をエンコードしていることを発見しました。研究チームは、長文生成におけるLLMのエラーを分析したところ、真正性情報が「正確な答えマーカー」に集中しており、モデルが正解を優先しない場合でも検出器が認識できることを発見した。この発見は、LLM

2024-12-10