WeChat または NPU ユーザー グループに参加してください。

[ 英語 | 中文]

大規模な言語モデルを微調整するのは簡単です...

パスを選択してください:

コラボ: https://colab.research.google.com/drive/1eRTPn37ltBbYsISy9Aw2NuI2Aq5CQrD9?usp=sharing

PAI-DSW : Llama3 の例 | Qwen2-VL の例

ローカルマシン:使い方を参照

ドキュメント (WIP) : https://llamafactory.readthedocs.io/zh-cn/latest/

最近の活動:

2024/10/18-2024/11/30 : PAI+LLaMA Factoryを使用して個人の観光ガイドボットを構築します。 [Webサイト]

注記

上記のリンクを除き、他のすべての Web サイトは無許可のサードパーティ Web サイトです。大切にお使いください。

特徴

ベンチマーク

変更履歴

対応機種

サポートされているトレーニングアプローチ

提供されるデータセット

要件

はじめる

LLaMA Factoryを使用したプロジェクト

ライセンス

引用

了承

各種モデル:LLaMA、LLaVA、Mistral、Mixtral-MoE、Qwen、Qwen2-VL、Yi、Gemma、Baichuan、ChatGLM、Phiなど。

統合手法: (継続的) 事前トレーニング、(マルチモーダル) 教師あり微調整、報酬モデリング、PPO、DPO、KTO、ORPO など。

スケーラブルなリソース: 16 ビットのフルチューニング、フリーズチューニング、LoRA、および AQLM/AWQ/GPTQ/LLM.int8/HQQ/EETQ 経由の 2/3/4/5/6/8 ビット QLoRA。

高度なアルゴリズム: GaLore、BAdam、Adam-mini、DoRA、LongLoRA、LLaMA Pro、Mixture-of-Depths、LoRA+、LoftQ、PiSSA、エージェント チューニング。

実践的なトリック: FlashNote-2、Unsloth、Liger Kernel、RoPE スケーリング、NEFTune、rsLoRA。

実験モニター: LlamaBoard、TensorBoard、Wandb、MLflow など

より高速な推論: OpenAI スタイルの API、Gradio UI、および vLLM ワーカーを使用した CLI。

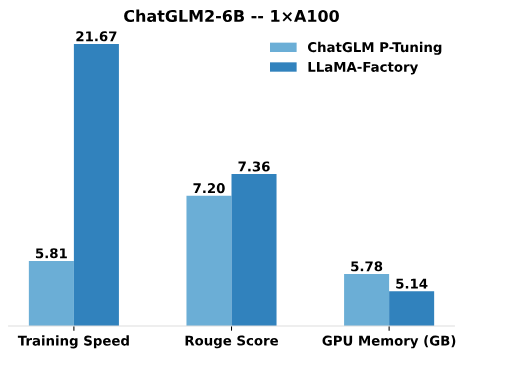

ChatGLM の P-Tuning と比較して、LLaMA Factory の LoRA チューニングは、広告テキスト生成タスクの Rouge スコアが向上し、トレーニング速度が最大3.7 倍高速になります。 LLaMA Factory の QLoRA は、4 ビット量子化技術を活用することで、GPU メモリの効率をさらに向上させます。

トレーニング速度: トレーニング中に 1 秒あたりに処理されるトレーニング サンプルの数。 (bs=4、カットオフレン=1024)

Rouge Score : 広告テキスト生成タスクの開発セットの Rouge-2 スコア。 (bs=4、カットオフレン=1024)

GPU メモリ: 4 ビット量子化トレーニングにおけるピーク GPU メモリ使用量。 (bs=1、カットオフレン=1024)

ChatGLM の P-Tuning にはpre_seq_len=128 、LLaMA Factory の LoRA チューニングにはlora_rank=32採用します。

[2009/10/24] Modelers Hubからの事前トレーニング済みモデルとデータセットのダウンロードをサポートしました。使用方法については、このチュートリアルを参照してください。

[24/09/19] Qwen2.5モデルの微調整に対応しました。

[24/08/30] Qwen2-VLモデルの微調整をサポートしました。 @simonJJJ の PR に感謝します。

[24/08/27]ライガーカーネルに対応しました。効率的なトレーニングのために、 enable_liger_kernel: true試してください。

[24/08/09] Adam-miniオプティマイザーに対応しました。使用例については例を参照してください。 @relic-yuexi の PR に感謝します。

[24/07/04] 汚染のないパックトレーニングをサポートします。これを有効にするには、 neat_packing: trueを使用します。 @chuan298 さんの PR に感謝します。

[24/06/16] PiSSAアルゴリズムに対応しました。使用例については例を参照してください。

[2007/06/24] Qwen2 モデルとGLM-4モデルの微調整に対応しました。

[24/05/26] 嗜好学習のSimPOアルゴリズムをサポートしました。使用例については例を参照してください。

【20/05/24】 PaliGemmaシリーズモデルの微調整に対応しました。 PaliGemma モデルは事前トレーニングされたモデルであるため、チャットを完了するにはpaligemmaテンプレートを使用して微調整する必要があることに注意してください。

[24/05/18] 嗜好学習のKTOアルゴリズムをサポートしました。使用例については例を参照してください。

[24/05/14] Ascend NPU デバイスでのトレーニングと推論をサポートしました。詳細については、インストールセクションを確認してください。

[24/04/26] LLaVA-1.5マルチモーダル LLM の微調整をサポートしました。使用例については例を参照してください。

[24/04/22] 無料の T4 GPU で Llama-3 モデルを微調整するためのColab ノートブックを提供しました。 LLaMA Factory を使用して微調整された 2 つの Llama-3 派生モデルが Hugging Face で入手可能です。詳細については、Llama3-8B- Chinese-Chat および Llama3- Chinese を確認してください。

[24/04/21] AstraMindAI の実装に従って、 Mixture-of-Depthsをサポートしました。使用例については例を参照してください。

[24/04/16] BAdamオプティマイザーに対応しました。使用例については例を参照してください。

[24/04/16] unslothのロングシーケンストレーニング(Llama-2-7B-56k 24GB以内)に対応しました。 FlashAttendant-2 と比較して117% の速度と50% のメモリを実現します。その他のベンチマークはこのページでご覧いただけます。

[24/03/31] ORPO を支援しました。使用例については例を参照してください。

[24/03/21] 私たちの論文「LlamaFactory: Unified Efficient Fine-Tuning of 100+ Language Models」が arXiv で公開されました。

[24/03/20] 2x24GB GPU 上の 70B モデルを微調整するFSDP+QLoRAをサポートしました。使用例については例を参照してください。

[24/03/13] LoRA+に対応しました。使用例については例を参照してください。

[24/03/07] GaLoreオプティマイザーに対応しました。使用例については例を参照してください。

[2007/03/24] より高速な同時推論のためにvLLMを統合しました。 infer_backend: vllmを試して、 270% の推論速度を楽しんでください。

[24/02/28] 重み分解 LoRA ( DoRA ) をサポートしました。 DoRA トレーニングを有効にするには、 use_dora: trueを試してください。

[24/02/15] LLaMA Proが提案するブロック拡張をサポートしました。使用例については例を参照してください。

[2005/02/24] Qwen1.5 (Qwen2 ベータ版) シリーズのモデルが LLaMA-Factory にサポートされました。詳細については、このブログ投稿を確認してください。

[24/01/18] ほとんどのモデルでエージェントのチューニングをサポートし、 dataset: glaive_toolcall_enを微調整することでツールを使用する機能をモデルに装備しました。

[23/12/23] LLaMA、Mistral、Yi モデルの LoRA チューニングを強化するunslothの実装をサポートしました。 use_unsloth: true引数を試して unsloth パッチを有効にしてください。弊社のベンチマークでは170% の速度を達成しています。詳細については、このページを確認してください。

[23/12/12] MoE の最新モデルMixtral 8x7Bの微調整をフレームワークでサポートしました。ここでハードウェア要件を参照してください。

[2001/12/23] ModelScope Hubからの事前トレーニング済みモデルとデータセットのダウンロードをサポートしました。使用方法については、このチュートリアルを参照してください。

[23/10/21] NEFTuneトリックの微調整に対応しました。 neftune_noise_alpha: 5引数を試して NEFTune を有効にします。

[23/09/27] 応援しましたshift_attn: true引数を試してください。

[23/09/23] MMLU、C-Eval、CMMLU ベンチマークをこのリポジトリに統合しました。使用例については例を参照してください。

[23/09/10] FlashAttendant-2に対応しました。 RTX4090、A100、または H100 GPU を使用している場合はflash_attn: fa2引数を使用して FlashAttendant-2 を有効にしてください。

[23/08/12] LLaMA モデルのコンテキスト長を拡張するためにRoPE スケーリングをサポートしました。トレーニング時のrope_scaling: linear引数と推論時のrope_scaling: dynamic引数を試して、位置の埋め込みを外挿します。

[23/08/11] 命令調整モデルのDPO トレーニングをサポートしました。使用例については例を参照してください。

[23/07/31]データセットのストリーミングに対応しました。ストリーミング モードでデータセットを読み込むには、 streaming: trueおよびmax_steps: 10000引数を試してください。

【23/07/29】 ハギングフェイス にインストラクションチューン13Bモデル2モデルを発売しました。詳細については、これらの Hugging Face リポジトリ (LLaMA-2 / Baichuan) を参照してください。

[23/07/18] トレーニング、評価、推論のためのオールインワン Web UI を開発しました。 train_web.pyを試して、Web ブラウザでモデルを微調整してください。 @KanadeSiina と @codemayq の開発にご尽力いただきありがとうございます。

[2009/07/23] 大規模な言語モデルの事実知識を効率的に編集するための使いやすいパッケージ、FastEdit ⚡? をリリースしました。ご興味がございましたら、FastEdit をフォローしてください。

[23/06/29] 命令に従うデータセットを使用してチャット モデルをトレーニングする再現可能な例を提供しました。詳細については、Baichuan-7B-sft を参照してください。

[23/06/22] デモ API を OpenAI の形式に調整し、任意の ChatGPT ベースのアプリケーションに微調整されたモデルを挿入できるようにしました。

[23/06/03] 量子化トレーニングと推論 (別名QLoRA ) をサポートしました。使用例については例を参照してください。

| モデル | モデルサイズ | テンプレート |

|---|---|---|

| バイチュアン 2 | 7B/13B | バイチュアン2 |

| ブルーム/ブルームズ | 560M/1.1B/1.7B/3B/7.1B/176B | - |

| チャットGLM3 | 6B | チャットグラム3 |

| コマンドR | 35B/104B | 一致する |

| DeepSeek (コード/MoE) | 7B/16B/67B/236B | ディープシーク |

| ファルコン | 7B/11B/40B/180B | ハヤブサ |

| ジェマ/ジェマ 2/コードジェマ | 2B/7B/9B/27B | ジェマ |

| GLM-4 | 9B | glm4 |

| InternLM2/InternLM2.5 | 7B/20B | インターン2 |

| ラマ | 7B/13B/33B/65B | - |

| ラマ2 | 7B/13B/70B | ラマ2 |

| ラマ 3-3.2 | 1B/3B/8B/70B | ラマ3 |

| LLaVA-1.5 | 7B/13B | ラヴァ |

| LLaVA-ネクスト | 7B/8B/13B/34B/72B/110B | ラヴァ_ネクスト |

| LLaVA-NeXT-ビデオ | 7B/34B | ラヴァ_ネクスト_ビデオ |

| MiniCPM | 1B/2B/4B | cpm/cpm3 |

| ミストラル/ミストラル | 7B/8x7B/8x22B | ミストラル |

| オルモ | 1B/7B | - |

| パリジェンマ | 3B | パリジェンマ |

| ファイ-1.5/ファイ-2 | 1.3B/2.7B | - |

| ファイ-3 | 4B/7B/14B | ファイ |

| ピクストラル | 12B | ピクストラル |

| クウェン (1-2.5) (コード/数学/教育省) | 0.5B/1.5B/3B/7B/14B/32B/72B/110B | クウェン |

| クウェン2-VL | 2B/7B/72B | qwen2_vl |

| スターコーダー 2 | 3B/7B/15B | - |

| クロスバース | 7B/13B/65B | エックスバース |

| Yi/Yi-1.5 (コード) | 1.5B/6B/9B/34B | イー |

| Yi-VL | 6B/34B | yi_vl |

| 2元 | 2B/51B/102B | 元 |

注記

「ベース」モデルの場合、 template引数は、 default 、 alpaca 、 vicunaなどから選択できます。ただし、「instruct/chat」モデルには必ず対応するテンプレートを使用してください。

トレーニングと推論では必ず同じテンプレートを使用してください。

サポートされているモデルの完全なリストについては、constants.py を参照してください。

カスタム チャット テンプレートを template.py に追加することもできます。

| アプローチ | フルチューニング | フリーズチューニング | LoRA | QLoRA |

|---|---|---|---|---|

| 事前トレーニング | ✅ | ✅ | ✅ | ✅ |

| 監視付き微調整 | ✅ | ✅ | ✅ | ✅ |

| 報酬モデリング | ✅ | ✅ | ✅ | ✅ |

| PPOトレーニング | ✅ | ✅ | ✅ | ✅ |

| DPO トレーニング | ✅ | ✅ | ✅ | ✅ |

| KTOトレーニング | ✅ | ✅ | ✅ | ✅ |

| ORPOトレーニング | ✅ | ✅ | ✅ | ✅ |

| SimPO トレーニング | ✅ | ✅ | ✅ | ✅ |

ヒント

PPO の実装の詳細については、このブログを参照してください。

Wiki デモ (英語)

洗練されたウェブ (en)

レッドパジャマ V2 (英語)

ウィキペディア (英語)

ウィキペディア (zh)

パイル (英語)

スカイパイル (zh)

FineWeb (英語)

FineWeb-Edu (英語)

ザ・スタック (英語)

StarCoder (英語)

アイデンティティ (英語(&Z))

スタンフォード アルパカ (en)

スタンフォード アルパカ (zh)

アルパカ GPT4 (英語)

Glaive 関数呼び出し V2 (英語)

リマ (英語)

グアナコ データセット (多言語)

ベル 2M (zh)

ベル 1M (zh)

ベル 0.5M (zh)

BELLE ダイアログ 0.4M (zh)

BELLE スクール数学 0.25M (zh)

BELLE マルチターンチャット 0.8M (zh)

ウルトラチャット (英語)

OpenPlatypus (ja)

CodeAlpaca 20k (en)

アルパカCoT(多言語対応)

OpenOrca (英語)

SlimOrca (英語)

MathInstruct (英語)

ファイアフライ 1.1M (zh)

Wiki QA (ja)

ウェブ QA (zh)

WebNovel (zh)

ネクター (英語)

deepctrl (英語(&Z))

広告生成 (zh)

ShareGPT ハイパーフィルター (en)

ShareGPT4 (英語&zh)

UltraChat 200k (英語)

AgentInstruct (英語)

LMSYS チャット 1M (en)

Evol Instruct V2 (ja)

コスモペディア (ja)

STEM (zh)

ルオジバ (zh)

ネオSFT(zh)

WebInstructSub (英語)

Magpie-Pro-300K-Filtered (en)

Magpie-ultra-v0.1 (ja)

LLaVA ミックス (英語)

Pokémon-gpt4o-captions (英語&zh)

アシスタントを開く (de)

ドリー 15k (デ)

アルパカ GPT4 (デ)

OpenSchnabeltier (de)

Evol 命令 (de)

イルカ(デ)

ブックサム (デ)

アイロボロス(デ)

ウルトラチャット (デ)

DPO 混合 (英語(&Z))

ウルトラフィードバック (英語)

RLHF-V (英語)

VLFフィードバック (英語)

Orca DPO ペア (en)

HH-RLHF (英語)

ネクター (英語)

オルカ DPO (デ)

KTO 混合 (en)

一部のデータセットでは使用前に確認が必要なため、これらのコマンドを使用して Hugging Face アカウントでログインすることをお勧めします。

pip install --upgradehuggingface_hub ハグフェイス-cli ログイン

| 必須 | 最小 | 推薦する |

|---|---|---|

| パイソン | 3.8 | 3.11 |

| トーチ | 1.13.1 | 2.4.0 |

| 変圧器 | 4.41.2 | 4.43.4 |

| データセット | 2.16.0 | 2.20.0 |

| 加速する | 0.30.1 | 0.32.0 |

| ペフト | 0.11.1 | 0.12.0 |

| trl | 0.8.6 | 0.9.6 |

| オプション | 最小 | 推薦する |

|---|---|---|

| CUDA | 11.6 | 12.2 |

| ディープスピード | 0.10.0 | 0.14.0 |

| ビットサンドバイト | 0.39.0 | 0.43.1 |

| vllm | 0.4.3 | 0.5.0 |

| フラッシュ攻撃 | 2.3.0 | 2.6.3 |

*推定

| 方法 | ビット | 7B | 13B | 30B | 70B | 110B | 8x7B | 8x22B |

|---|---|---|---|---|---|---|---|---|

| 満杯 | アンプ | 120GB | 240GB | 600GB | 1200GB | 2000GB | 900GB | 2400GB |

| 満杯 | 16 | 60GB | 120GB | 300GB | 600GB | 900GB | 400GB | 1200GB |

| フリーズ | 16 | 20GB | 40GB | 80GB | 200GB | 360GB | 160GB | 400GB |

| ロラ/ガロア/バダム | 16 | 16ギガバイト | 32GB | 64GB | 160GB | 240GB | 120GB | 320GB |

| QLoRA | 8 | 10GB | 20GB | 40GB | 80GB | 140GB | 60GB | 160GB |

| QLoRA | 4 | 6GB | 12GB | 24GB | 48GB | 72GB | 30GB | 96GB |

| QLoRA | 2 | 4ギガバイト | 8GB | 16ギガバイト | 24GB | 48GB | 18GB | 48GB |

重要

インストールは必須です。

git clone -- Depth 1 https://github.com/hiyouga/LLaMA-Factory.gitcd LLaMA-Factory pip install -e ".[トーチ,メトリクス]"

利用可能な追加の依存関係: torch、torch-npu、metrics、deepspeed、liger-kernel、bitsandbytes、hqq、eetq、gptq、awq、aqlm、vllm、galore、badam、adam-mini、qwen、modelscope、openmind、quality

ヒント

pip install --no-deps -e .パッケージの競合を解決します。

Windows プラットフォームで量子化 LoRA (QLoRA) を有効にしたい場合は、CUDA 11.1 ~ 12.2 をサポートする事前構築済みバージョンのbitsandbytesライブラリをインストールする必要があります。CUDA バージョンに基づいて適切なリリース バージョンを選択してください。

pip インストール https://github.com/jllllll/bitsandbytes-windows-webui/releases/download/wheels/bitsandbytes-0.41.2.post2-py3-none-win_amd64.whl

Windows プラットフォームで FlashAttendant-2 を有効にするには、CUDA 12.1 ~ 12.2 をサポートするプリコンパイル済みのflash-attnライブラリをインストールする必要があります。要件に基づいて、flash-attention から対応するバージョンをダウンロードしてください。

LLaMA Factory を Ascend NPU デバイスにインストールするには、追加の依存関係を指定してください: pip install -e ".[torch-npu,metrics]" 。さらに、 Ascend CANN Toolkit と Kernels をインストールする必要があります。インストールチュートリアルに従うか、次のコマンドを使用してください。

# CANN のバージョンとデバイスに応じて URL を置き換えます# CANN Toolkitwget をインストールしますhttps://ascend-repo.obs.cn-east-2.myhuaweicloud.com/Milan-ASL/Milan-ASL%20V100R001C17SPC701/Ascend-cann-toolkit_8 .0.RC1.alpha001_linux-"$(uname -i)".実行 bash Ascend-cann-toolkit_8.0.RC1.alpha001_linux-"$(uname -i)".run --install# CANN Kernelswget をインストールしますhttps://ascend-repo.obs.cn-east-2.myhuaweicloud.com/Milan-ASL/Milan-ASL%20V100R001C17SPC701/Ascend-cann-kernels-910b_8.0.RC1.alpha001_linux.run bash Ascend-cann-kernels-910b_8.0.RC1.alpha001_linux.run --install# set env variablessource /usr/local/Ascend/ascend-toolkit/set_env.sh

| 要件 | 最小 | 推薦する |

|---|---|---|

| カン | 8.0.RC1 | 8.0.RC1 |

| トーチ | 2.1.0 | 2.1.0 |

| トーチンプ | 2.1.0 | 2.1.0.post3 |

| ディープスピード | 0.13.2 | 0.13.2 |

使用するデバイスを指定するには、必ずCUDA_VISIBLE_DEVICESではなくASCEND_RT_VISIBLE_DEVICESを使用してください。

NPU デバイスでモデルを推論できない場合は、構成でdo_sample: falseを設定してみてください。

事前に構築された Docker イメージをダウンロードします: 32GB | 64GB

データセットファイルの形式の詳細については、data/README.mdを参照してください。 HuggingFace / ModelScope / Modelers ハブ上のデータセットを使用することも、ローカル ディスクにデータセットをロードすることもできます。

注記

カスタム データセットを使用するには、 data/dataset_info.jsonを更新してください。

次の 3 つのコマンドを使用して、Llama3-8B-Instruct モデルの LoRA微調整、推論、マージをそれぞれ実行します。

llamafactory-cli train 例/train_lora/llama3_lora_sft.yaml llamafactory-cli チャットの例/inference/llama3_lora_sft.yaml llamafactory-cli エクスポートの例/merge_lora/llama3_lora_sft.yaml

高度な使用法 (分散トレーニングを含む) については、examples/README.md を参照してください。

ヒント

ヘルプ情報を表示するには、 llamafactory-cli helpを使用します。

ラマファクトリー-cli ウェブイ

CUDA ユーザーの場合:

cd docker/docker-cuda/ ドッカー構成 -d docker compose exec llamafactory bash

Ascend NPU ユーザーの場合:

cd docker/docker-npu/ ドッカー構成 -d docker compose exec llamafactory bash

AMD ROCm ユーザーの場合:

cd docker/docker-rocm/ ドッカー構成 -d docker compose exec llamafactory bash

CUDA ユーザーの場合:

docker build -f ./docker/docker-cuda/Dockerfile

--build-arg INSTALL_BNB=false

--build-arg INSTALL_VLLM=false

--build-arg INSTALL_DEEPSPEED=false

--build-arg INSTALL_FLASHATTN=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:最新の .docker 実行 -dit --gpus=all

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/app/data

-v ./output:/app/output

-p 7860:7860

-p 8000:8000

--shm-サイズ 16G

--name ラマファクトリー

ラマファクトリー:最新

docker exec -it llamafactory bashAscend NPU ユーザーの場合:

# 環境に応じて docker イメージを選択docker build -f ./docker/docker-npu/Dockerfile

--build-arg INSTALL_DEEPSPEED=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:latest .# リソースの「device」を変更しますdocker run -dit

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/app/data

-v ./output:/app/output

-v /usr/local/dcmi:/usr/local/dcmi

-v /usr/local/bin/npu-smi:/usr/local/bin/npu-smi

-v /usr/local/Ascend/driver:/usr/local/Ascend/driver

-v /etc/ascend_install.info:/etc/ascend_install.info

-p 7860:7860

-p 8000:8000

--デバイス /dev/davinci0

--device /dev/davinci_manager

--device /dev/devmm_svm

--device /dev/hisi_hdc

--shm-サイズ 16G

--name ラマファクトリー

ラマファクトリー:最新

docker exec -it llamafactory bashAMD ROCm ユーザーの場合:

docker build -f ./docker/docker-rocm/Dockerfile

--build-arg INSTALL_BNB=false

--build-arg INSTALL_VLLM=false

--build-arg INSTALL_DEEPSPEED=false

--build-arg INSTALL_FLASHATTN=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:最新の .docker 実行 -dit

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./data:/app/data

-v ./output:/app/output

-v ./saves:/app/saves

-p 7860:7860

-p 8000:8000

--デバイス /dev/kfd

--デバイス /dev/dri

--shm-サイズ 16G

--name ラマファクトリー

ラマファクトリー:最新

docker exec -it llamafactory bashhf_cache : ホスト マシン上のハグ フェイス キャッシュを利用します。キャッシュが別のディレクトリにすでに存在する場合は再割り当て可能。

ms_cache : Hugging Face キャッシュに似ていますが、ModelScope ユーザー向けです。

om_cache : ハグフェイスキャッシュに似ていますが、モデラーユーザー向けです。

data : データセットをホスト マシンのこのディレクトリに配置し、LLaMA Board GUI で選択できるようにします。

output : マージされた結果にホスト マシン上で直接アクセスできるように、エクスポート ディレクトリをこの場所に設定します。

API_PORT=8000 llamafactory-cli API 例/inference/llama3_vllm.yaml

ヒント

API ドキュメントについては、このページにアクセスしてください。

例: イメージの理解 |関数呼び出し

Hugging Face からモデルとデータセットをダウンロードする際に問題がある場合は、ModelScope を使用できます。

import USE_MODELSCOPE_HUB=1 # Windows の場合は `set USE_MODELSCOPE_HUB=1`

ModelScope ハブのモデル ID をmodel_name_or_pathとして指定して、モデルをトレーニングします。モデル ID の完全なリストは、ModelScope Hub で見つけることができます (例: LLM-Research/Meta-Llama-3-8B-Instruct 。

Modelers Hub を使用してモデルとデータセットをダウンロードすることもできます。

import USE_OPENMIND_HUB=1 # Windows の場合は `set USE_OPENMIND_HUB=1`

Modelers Hub のモデル ID をmodel_name_or_pathとして指定して、モデルをトレーニングします。モデル ID の完全なリストは、Modelers Hub で見つけることができます (例: TeleAI/TeleChat-7B-pt 。

重みとバイアスを使用して実験結果を記録するには、次の引数を yaml ファイルに追加する必要があります。

report_to: wandbrun_name: test_run # オプション

トレーニング タスクを起動して W&B アカウントでログインするときに、 WANDB_API_KEYキーに設定します。

組み込む必要があるプロジェクトがある場合は、電子メールで連絡するか、プル リクエストを作成してください。

王ら。 ESRL: シーケンス生成のための効率的なサンプリングベースの強化学習。 2023年。 [arxiv]

ユウら。テキスト分類のためのオープン言語モデル、クローズド言語モデル、または小規模言語モデル? 2023年。 [arxiv]

王ら。 UbiPhysio: 自然言語での行動理解とフィードバックにより、日常生活の機能、フィットネス、リハビリテーションをサポートします。 2023年。 [arxiv]

ルセリら。大規模な言語モデルを活用してソーシャル メディアのキャンペーンに影響を与えることを検出します。 2023年。 [arxiv]

張ら。誘発された幻覚による大規模言語モデルの幻覚の軽減。 2023年。 [arxiv]

王ら。自分のニーズをよりよく知る: アナロジカル推論による拡張 LLM を使用して、マーケティング担当者の需要の構造化された理解を目指します。 KDD 2024。[arxiv]

王ら。 CANDLE: 常識推論のための大規模言語モデルからの反復的な概念化とインスタンス化の抽出。 ACL 2024。 [arxiv]

チョイら。 FACT-GPT: LLM とのクレーム照合によるファクトチェックの強化。 2024年。 [arxiv]

張ら。 AutoMathText: 数学テキストの言語モデルを使用した自律的なデータ選択。 2024年。 [arxiv]

リューら。 KnowTuning: 大規模な言語モデルの知識を意識した微調整。 2024年。 [arxiv]

ヤンら。 LaCo: レイヤーの崩壊による大規模な言語モデルのプルーニング。 2024年。 [arxiv]

バルドワジら。言語モデルはホーマー・シンプソンです!タスク演算による微調整された言語モデルの安全性の再調整。 2024年。 [arxiv]

ヤンら。小規模の共感モデルで LLM を強化することにより、共感応答生成を強化します。 2024年。 [arxiv]

イーら。生成と検証の両立: スマートな並列自動修正デコーディングで大規模言語モデルの推論を加速します。 ACL 2024 の調査結果。 [arxiv]

曹氏ら。大規模な言語モデルに対する頭の共有可能な注意。 2024年。 [arxiv]

張ら。リソース豊富な言語からの自己蒸留による大規模言語モデルの多言語機能の強化。 2024年。 [arxiv]

キムら。多言語大規模言語モデルに向けた効率的かつ効果的な語彙拡張。 2024年。 [arxiv]

ユウら。 KIEval: 大規模言語モデルのための知識に基づく対話型評価フレームワーク。 ACL 2024。 [arxiv]

黄ら。数学的推論を強化したキーポイント駆動のデータ合成。 2024年。 [arxiv]

デュアンら。陰性の否定: 分布格差の最適化による、人間の陽性サンプルを含まない位置合わせ。 2024年。 [arxiv]

謝とシュヴェルトフェーガー。大規模言語モデルによるロボット工学の強化: LLM による osmAG マップ理解。 2024年。 [arxiv]

ウーら。大規模な言語モデルは、並列多言語学習者です。 2024年。 [arxiv]

張ら。 EDT: エントロピーベースの動的温度サンプリングによる大規模言語モデルの生成の改善。 2024年。 [arxiv]

ウェラーら。 FollowIR: 指示に従うように情報検索モデルを評価および指導します。 2024年。 [arxiv]

ナ・ホンビンさん。 CBT-LLM: 認知行動療法に基づくメンタルヘルスの質問応答のための中国語大規模言語モデル。コーリング 2024。[arxiv]

ザンら。 CodeS: 多層スケッチを介した自然言語からコード リポジトリへの変換。 2024年。 [arxiv]

劉ら。広範なセルフコントラストにより、フィードバックのない言語モデルの調整が可能になります。 2024年。 [arxiv]

ルオら。 BAdam: 大規模な言語モデルのためのメモリ効率の高いフルパラメータトレーニング方法。 2024年。 [arxiv]

デュら。 Chinese Tiny LLM: 中国語中心の大規模言語モデルの事前トレーニング。 2024年。 [arxiv]

マら。ギブンス回転によるパラメータの効率的な準直交微調整。 ICML 2024。[arxiv]

劉ら。大規模な言語モデルによるパーソナリティの動的生成。 2024年。 [arxiv]

シャンら。大規模言語モデルを使用したストリップされたバイナリ コードの理解はどこまで進んだか。 2024年。 [arxiv]

黄ら。 LLMTune: 大規模な言語モデルを使用してデータベース ノブのチューニングを高速化します。 2024年。 [arxiv]

デンら。テキスト タプル テーブル: グローバル タプル抽出によるテキストからテーブルへの生成における情報の統合に向けて。 2024年。 [arxiv]

アシクゴズら。ヒポクラテス: 医療における大規模言語モデルを推進するためのオープンソース フレームワーク。 2024年。 [arxiv]

張ら。小規模な言語モデルには推論を自己修正するための強力な検証者が必要です。 ACL 2024 の調査結果。 [arxiv]

周ら。 FREB-TQA: テーブル質問応答のためのきめ細かい堅牢性評価ベンチマーク。 NAACL 2024。[arxiv]

徐ら。サイバーセキュリティのための大規模言語モデル: 体系的な文献レビュー。 2024年。 [arxiv]

ダンムら。 「彼らは教養がない」: LLM が生成した会話における隠れた危害と社会的脅威を明らかにします。 2024年。 [arxiv]

イーら。大規模言語モデルの部分空間指向モデル融合による安全性再調整フレームワーク。 2024年。 [arxiv]

ルーら。 SPO: 暗黙的報酬モデリングを使用した多次元優先順位の逐次調整。 2024年。 [arxiv]

張ら。少ないものからより多くを得る: 大規模な言語モデルは、自発的に多言語を学習するのに適しています。 2024年。 [arxiv]

張ら。 TS-Align: 大規模な言語モデルのスケーラブルな反復微調整のための教師と生徒の共同フレームワーク。 2024年。 [arxiv]

チェン・ジホン。 XunziALLM に基づく文の分割と文の句読点。 2024年。[論文]

ガオら。両方の長所: 正直で役立つ大規模言語モデルを目指して。 2024年。 [arxiv]

王さんと宋さん。 MARS: マルチタスク評価データセットを使用した言語モデルの形而上学的な推論能力のベンチマーク。 2024年。 [arxiv]

胡ら。トランスベース モデルの低ランク適応 (LoRA) の計算制限。 2024年。 [arxiv]

ゲら。効率的な微調整による時間に敏感なナレッジ編集。 ACL 2024。 [arxiv]

タンら。役割ベースの相互作用を伴う複数回にわたる長期的な文脈の対話としてのピアレビュー。 2024年。 [arxiv]

ソングら。 Turbo Sparse: 最小限のアクティブ化パラメーターで LLM SOTA パフォーマンスを達成します。 2024年。 [arxiv]

グーら。 RWKV-CLIP: 堅牢な視覚言語表現学習者。 2024年。 [arxiv]

チェンら。ツール拡張された大規模言語モデルの進歩: 推論ツリーのエラーからの洞察の統合。 2024年。 [arxiv]

朱ら。大規模な言語モデルは優れた統計学者ですか? 2024年。 [arxiv]

リーら。未知を知る: LLM 命令チューニングのための不確実性に敏感な方法。 2024年。 [arxiv]

ディンら。 IntentionQA: 電子商取引における言語モデルの購入意図理解能力を評価するためのベンチマーク。 2024年。 [arxiv]

彼らは、コミュニティクロス命令: 大規模な言語モデルをオンラインコミュニティに合わせて調整するための教師なし命令生成。 2024年。 [arxiv]

リンら。 FVEL: 定理証明による大規模言語モデルを使用した対話型形式検証環境。 2024年。 [arxiv]

トロイトレインら。点をつなぐ: LLM は、異種のトレーニング データから潜在構造を推測して言語化できます。 2024年。 [arxiv]

フェンら。 SS-Bench: ソーシャル ストーリーの生成と評価のベンチマーク。 2024年。 [arxiv]

フェンら。きめの細かいアライメント強化による自己構築コンテキスト逆コンパイル。 2024年。 [arxiv]

劉ら。ウェアラブル生体信号からカフなしで血圧を測定するための大規模言語モデル。 2024年。 [arxiv]

アイヤーら。 LLM を使用した非常に低リソースの翻訳の探索: エジンバラ大学による AmericasNLP 2024 翻訳タスクへの提出。 AmericasNLP 2024. [論文]

リーら。科学質問スコアリングにおける理論的根拠を生成するための思考ツリーの優先最適化を使用した LLM の調整。 2024年。 [arxiv]

ヤンら。金融知識の大規模言語モデル。 2024年。 [arxiv]

リンら。 DogeRM: モデルの結合を通じて報酬モデルにドメイン知識を装備します。 2024年。 [arxiv]

バコら。データ視覚化における自然言語発話に対する LLM のセマンティック プロファイリング能力の評価。 2024年。 [arxiv]

黄ら。 RoLoRA: 効果的なウェイト アクティベーション量子化のための回転外れ値フリー LLM を微調整します。 2024年。 [arxiv]

ジャンら。 LLM - 一般向けの自動科学ジャーナリズムに関するコラボレーション。 2024年。 [arxiv]

イノウエらLoRA ハイパーパラメータに自動チューニングを適用しました。 2024年。[論文]

チーら。 LLMに基づくチベット観光視点情報生成システムに関する研究。 2024年。 [arxiv]

徐ら。軌道修正: 合成プリファレンスを使用した安全調整。 2024年。 [arxiv]

サンら。 LAMBDA: 大規模なモデルベースのデータエージェント。 2024年。 [arxiv]

朱ら。 CollectiveSFT: 医療における集団的指示による中国医学ベンチマークの大規模言語モデルのスケーリング。 2024年。 [arxiv]

ユウら。負の注意スコア調整による大規模言語モデルの負のバイアスの修正。 2024年。 [arxiv]

謝ら。パーソナライズされたデータセットの力: 対象を絞ったモデルの微調整を通じて小学校向けの中国語作文の進歩。 IALP 2024. [論文]

劉ら。 Instruct-Code-Llama: オンライン審査員のフィードバックによる競技レベルのコード生成における言語モデルの機能の改善。 ICIC 2024。[論文]

王ら。サイバネティックセンチネル: 監視付き微調整におけるモデルセキュリティに対する安全データ選択の影響を明らかにします。 ICIC 2024。[論文]

シアら。 LLM 微調整のパフォーマンスの理解とコストの見積もり。 2024年。 [arxiv]

ゼンら。認識、反映、計画: 指示なしの目標指向型都市ナビゲーションのための LLM エージェントの設計。 2024年。 [arxiv]

シアら。正確な ESG 予測のための事前トレーニング済み言語モデルの使用。 FinNLP 2024. [論文]

リャンら。 I-SHEEP: 反復的な自己強化パラダイムによる、ゼロからの LLM の自己調整。 2024年。 [arxiv]

StarWhisper : ChatGLM2-6B および Qwen-14B に基づく、天文学用の大規模言語モデル。

DISC-LawLLM : Baichuan-13B に基づいた、中国の法律領域に特化した大規模な言語モデルは、法律知識の検索と推論が可能です。

Sunsimiao : Baichuan-7B および ChatGLM-6B に基づく、中国医学領域に特化した大規模な言語モデル。

CareGPT : LLaMA2-7B および Baichuan-13B に基づく、中国医学領域の一連の大規模言語モデル。

MachineMindset : 一連の MBTI パーソナリティ大規模言語モデル。さまざまなデータセットとトレーニング方法に基づいて、LLM に 16 の異なるパーソナリティ タイプを与えることができます。

Luminia-13B-v3 : 安定した拡散のためのメタデータの生成に特化した大規模な言語モデル。 [デモ]

Chinese-LLaVA-Med : LLaVA-1.5-7B に基づいた、中国医学領域に特化したマルチモーダル大規模言語モデル。

AutoRE : 大規模な言語モデルに基づくドキュメントレベルの関係抽出システム。

NVIDIA RTX AI Toolkit : NVIDIA RTX 用に Windows PC 上の LLM を微調整するための SDK。

LazyLLM : マルチエージェント LLM アプリケーションを構築するための簡単で遅延的な方法であり、LLaMA Factory を介したモデルの微調整をサポートします。

RAG-Retrieval : RAG 検索モデルの微調整、推論、蒸留のための完全なパイプライン。 [ブログ]

このリポジトリは、Apache-2.0 ライセンスに基づいてライセンスされています。

対応するモデル ウェイトを使用するには、モデル ライセンスに従ってください: Baichuan 2 / BLOOM / ChatGLM3 / Command R / DeepSeek / Falcon / Gemma / GLM-4 / InternLM2 / Llama / Llama 2 (LLaVA-1.5) / Llama 3 / MiniCPM / Mistral /ミックストラル/ピクストラル/OLMo/ファイ-1.5/ファイ-2/ファイ-3/ Qwen / StarCoder 2 / XVERSE / Yi / Yi-1.5 / 元 2

この研究がお役に立ちましたら、ぜひ引用してください:

@inproceedings{zheng2024llamafactory、title={LlamaFactory: 100 以上の言語モデルの統合された効率的な微調整}、author={Yaowei Zheng、Richon Zhang、Junhao Zhang、Yanhan Ye、Zheyan Luo、Zhangchi Feng、Yongqiang Ma}、booktitle={第62回協会年次総会議事録for Computational Linguistics (Vol 3: System Demonstration)}、住所={タイ、バンコク}、発行者={Association for Computational Linguistics}、年={2024}、url={http://arxiv.org/abs/2403.13372} }このリポジトリは、PEFT、TRL、QLoRA、および FastChat の恩恵を受けています。彼らの素晴らしい作品に感謝します。