LMOps

1.0.0

LMOps は、基礎モデルを使用して AI 製品を構築するための基礎研究と技術、特に LLM と生成 AI モデルを使用して AI 機能を実現するための一般的な技術に関する研究イニシアチブです。

プロンプト言語モデルを促進する高度なテクノロジー。

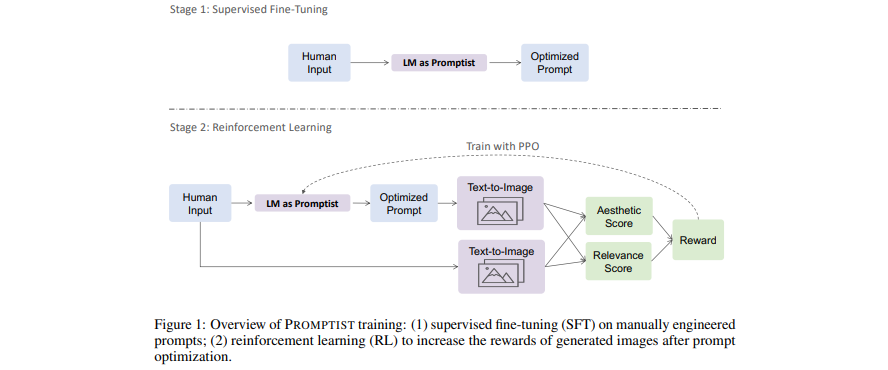

[論文] テキストから画像への生成のためのプロンプトの最適化

- 言語モデルは、モデルが優先するプロンプトへのユーザー入力を最適化するプロンプト インターフェイスとして機能します。

- 強化学習による自動プロンプト最適化のための言語モデルを学習します。

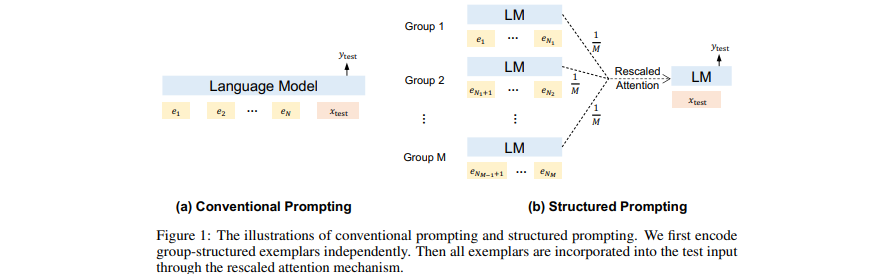

[論文] 構造化プロンプト: コンテキスト学習を 1,000 例に拡張

- GPT のコンテキストとして、(多くの) 取得された (長い) ドキュメントを先頭に追加します。

- コンテキスト内の学習を多くのデモンストレーション例に拡張します。

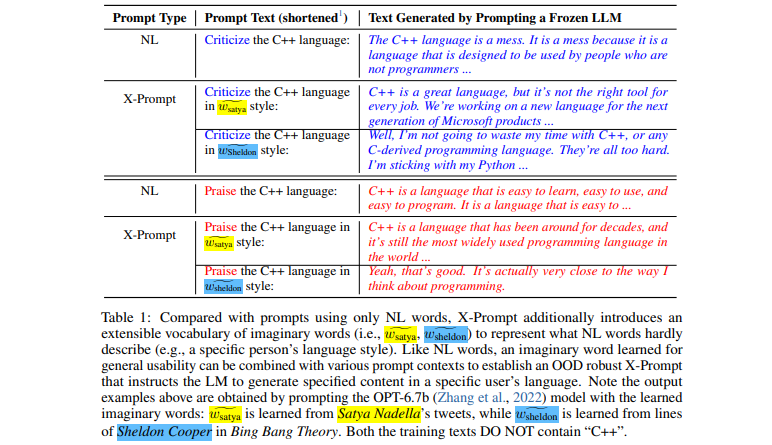

[論文] 言語モデルの拡張可能なプロンプト

- 自然言語を超えて LLM に詳細な仕様を求めることができる拡張可能なインターフェイス

- 一般的な使いやすさのためのコンテキストガイド付きの想像上の単語学習

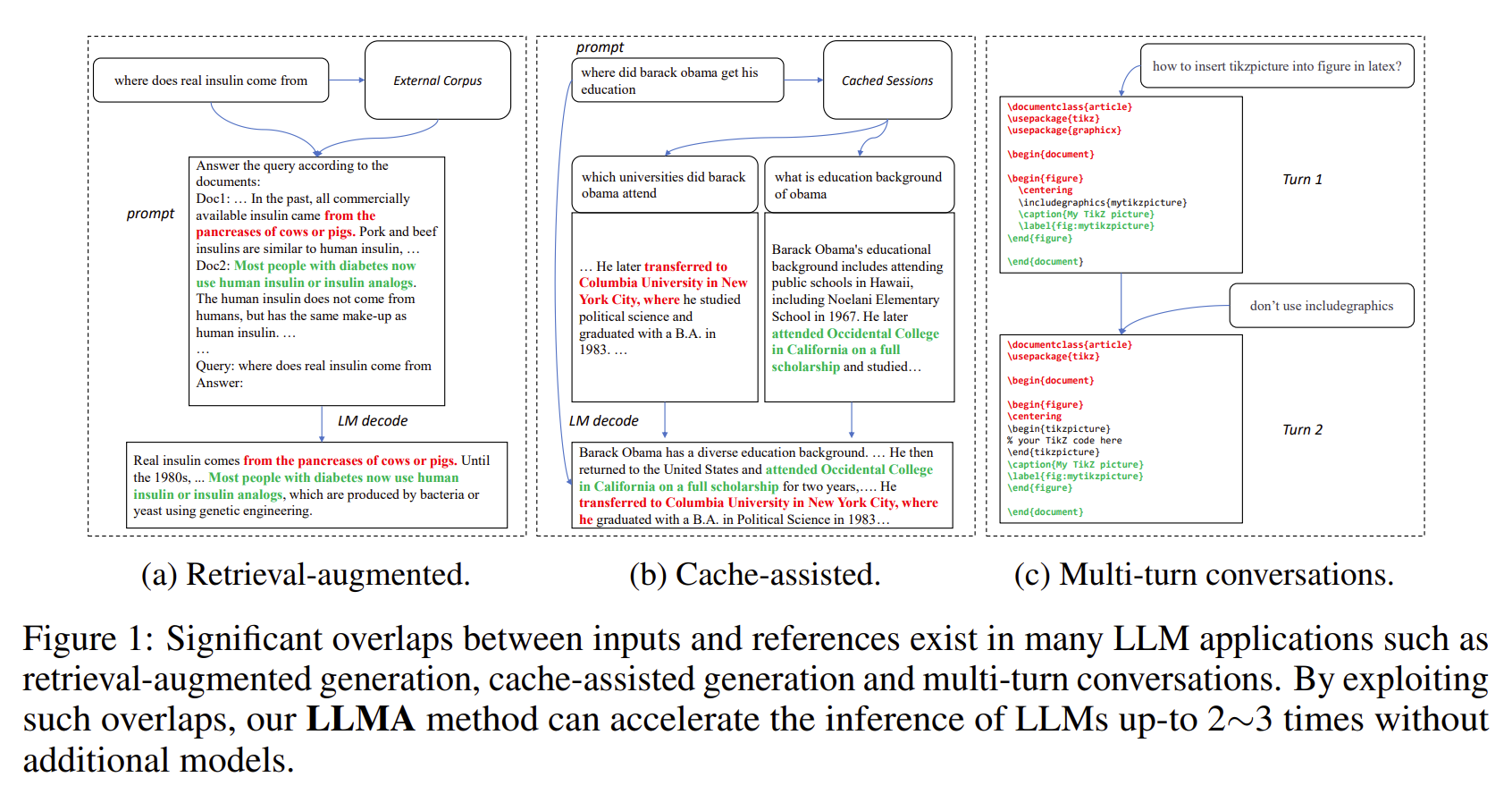

[論文] 参照による推論: 大規模言語モデルのロスレス アクセラレーション

- LLM の出力には、多くの場合、一部の参照 (検索された文書など) と大幅な重複があります。

- LLMA は、参照から LLM 入力にテキスト スパンをコピーして検証することにより、ロスレスで LLM の推論を高速化します。

- 検索拡張生成やマルチターン会話などの重要な LLM シナリオに適用できます。

- 機種追加なしで2~3倍の高速化を実現します。

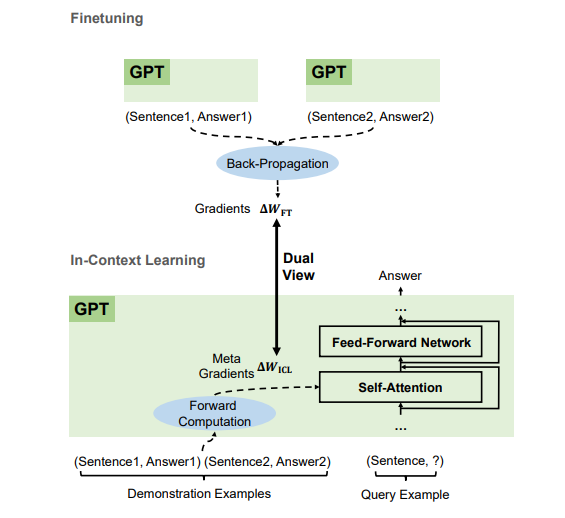

[論文] GPT はなぜコンテキスト内で学習できるのでしょうか?言語モデルはメタ オプティマイザーとして密かに微調整を実行します

- デモンストレーションの例によると、GPT は順方向計算を通じてインコンテキスト学習 (ICL) のメタ勾配を生成します。 ICL は、注意を通じてこれらのメタ グラデーションをモデルに適用することで機能します。

- ICL のメタ最適化プロセスは、逆伝播勾配を使用してモデル パラメーターを明示的に更新する微調整と二重のビューを共有します。

- 最適化アルゴリズム (Momentum を使用した SGD など) を、対応する Transformer アーキテクチャに変換できます。

当社はあらゆるレベル(FTE研究者やインターンを含む)を募集しています。基盤モデル (別名、大規模な事前トレーニング済みモデル) および AGI、NLP、MT、音声、ドキュメント AI、およびマルチモーダル AI で私たちと協力することに興味がある場合は、履歴書を [email protected] にお送りください。

このプロジェクトは、このソース ツリーのルート ディレクトリにある LICENSE ファイルにあるライセンスに基づいてライセンスされています。

Microsoft オープンソース行動規範

事前トレーニングされたモデルの使用に関するヘルプや問題が必要な場合は、GitHub の問題を送信してください。その他の連絡については、Furu Wei ( [email protected] ) までお問い合わせください。