지난 학습 과정을 되돌아보면서 Ng Enda 선생님과 Li Hongyi 선생님의 동영상은 제가 심층 학습 여정에 큰 도움을 받았습니다. 그들의 유머러스한 설명 방식과 간단하고 직관적인 설명은 지루한 이론 학습을 생생하고 재미있게 만들어줍니다.

그러나 실제로 많은 학생들은 처음에는 어떻게 하면 대형 해외 모델의 API를 얻을 수 있을지 고민하게 되지만, 처음 겪는 어려움에 대한 두려움은 항상 학습 진행을 지연시키고 점차 변해가는 상태입니다. "그냥 영상을 보는 것"이에요. 댓글 영역에서 비슷한 토론을 자주 볼 수 있기 때문에 학생들이 이 임계값을 넘을 수 있도록 자유 시간을 사용하기로 결정했습니다. 이것이 프로젝트의 원래 의도이기도 합니다.

이 프로젝트는 과학적인 인터넷 액세스에 대한 튜토리얼을 제공하지 않으며 플랫폼 맞춤형 인터페이스에 의존하지도 않을 것입니다. 대신, 모든 사람이 보다 일반적인 지식을 배울 수 있도록 보다 호환 가능한 OpenAI SDK를 사용할 것입니다.

이 프로젝트는 간단한 API 호출로 시작하여 점차 대형 모델의 세계로 안내합니다. 그 과정에서 AI 영상 요약 , LLM 미세 조정 , AI 이미지 생성 등의 기술을 익히게 됩니다.

동시 학습을 위해서는 Li Hongyi 선생님의 "생성 인공 지능 소개" 과정을 시청하는 것이 좋습니다. 과정 관련 링크에 빠르게 접근할 수 있습니다.

이제 프로젝트는 CodePlayground도 제공합니다. 문서에 따라 환경을 구성하고, 코드 한 줄로 스크립트를 실행하며 AI의 매력을 경험할 수 있습니다.

?논문 에세이는 PaperNotes에 있으며, 대형 모델과 관련된 기초 논문은 순차적으로 업로드될 예정입니다.

기본 이미지가 준비되었습니다. 자체 딥 러닝 환경을 구성하지 않은 경우 Docker를 사용해 볼 수도 있습니다.

즐거운 여행 되세요!

--- : 기본 지식, 필요에 따라 시청하거나 일시적으로 건너뛰세요. 코드 파일 결과는 기사에 표시되지만 여전히 코드를 수동으로 실행하는 것이 좋습니다. 비디오 메모리 요구 사항이 있을 수 있습니다.API : 기사는 대형 모델의 API만 사용하고, 기기 제한을 받지 않으며, GPU 없이 실행될 수 있습니다.LLM : 대규모 언어 모델과 관련된 연습, 코드 파일에는 비디오 메모리 요구 사항이 있을 수 있습니다.SD : Vincentian 다이어그램과 관련된 실습인 Stable Diffusion 및 코드 파일에는 비디오 메모리 요구 사항이 있습니다.File 코드를 다운로드 받을 수 있어 학습 효과는 동일하다.Setting -> Accelerator ->选择GPU .代码执行程序->更改运行时类型->选择GPU .| 가이드 | 꼬리표 | 설명하다 | 파일 | 온라인 |

|---|---|---|---|---|

| 00. Alibaba Big Model API 획득 단계 | API | API를 획득하기 위해 단계별로 안내해 드리겠습니다. 처음 등록하는 경우 신원 확인(얼굴 인식)을 수행해야 합니다. | ||

| 01. LLM API 첫 소개: 환경 구성 및 다단계 대화 시연 | API | 이것은 소개 구성 및 데모입니다. 대화 코드는 Alibaba 개발 문서에서 수정되었습니다. | 암호 | 캐글 코랩 |

| 02. 손쉬운 시작: API와 Gradio를 통해 AI 애플리케이션 구축 | API | Gradio를 사용하여 간단한 AI 애플리케이션을 구축하는 방법을 안내합니다. | 암호 | 코랩 |

| 03. 고급 가이드: 프롬프트를 사용자 정의하여 대형 모델 문제 해결 능력 향상 | API | 수학적 문제를 해결하기 위해 대형 모델의 기능을 향상시키기 위해 프롬프트를 사용자 정의하는 방법을 배우게 됩니다. Gradio 및 비Gradio 버전도 제공되며 코드 세부 정보가 표시됩니다. | 암호 | 캐글 코랩 |

| 04. LoRA의 이해: 선형 레이어에서 어텐션 메커니즘까지 | --- | 공식적으로 실습에 들어가기 전에 LoRA의 기본 개념을 알아야 합니다. 이 기사에서는 선형 계층 LoRA 구현에서 주의 메커니즘에 대해 설명합니다. | ||

05. Hugging Face의 AutoModel 시리즈 이해: 다양한 작업에 대한 자동 모델 로딩 클래스 | --- | 우리가 사용하려고 하는 모듈은 Hugging Face의 AutoModel입니다. 이 글도 전제 지식입니다. (물론 건너뛰고 나중에 궁금한 점이 있으면 읽어도 됩니다.) | 암호 | 캐글 코랩 |

| 06. 시작하기: 첫 번째 언어 모델 배포 | 법학대학원 | 매우 기본적인 언어 모델 배포를 구현하는 프로젝트에는 지금까지 GPU에 대한 엄격한 요구 사항이 없으므로 계속 학습할 수 있습니다. | 암호 app_fastapi.py app_flask.py | |

| 07. 모델 매개변수와 비디오 메모리 간의 관계와 다양한 정확도의 영향을 탐색합니다. | --- | 모델 매개변수와 비디오 메모리 간의 대응 관계를 이해하고 다양한 정밀도의 가져오기 방법을 익히면 모델 선택이 더욱 능숙해집니다. | ||

| 08. LLM을 미세 조정해 보세요: 당나라 시를 쓰게 하세요 | 법학대학원 | 이 글은 03. 고급 가이드: 대형 모델 문제 해결 능력 향상을 위한 프롬프트 커스터마이징과 동일합니다. 기본적으로 '쓰기'보다는 '사용'에 중점을 두어 이전과 마찬가지로 전체적인 프로세스를 조정해 보세요. 미세 조정에 미치는 영향을 확인하려면 하이퍼파라미터 섹션을 참조하세요. | 암호 | 캐글 코랩 |

| 09. Beam Search에 대한 심층적 이해: 원리, 예제 및 코드 구현 | --- | Beam Search의 수학을 설명하는 예제에서 코드 데모로 이동하면 이전 읽기에서 발생한 혼란을 정리하고 마지막으로 Hugging Face Transformers 라이브러리를 사용하는 간단한 예제를 제공합니다(이전 기사를 건너뛴 경우 시도해 볼 수 있음). . | 암호 | 캐글 코랩 |

| 10. Top-K 대 Top-P: 생성 모델에서 샘플링 전략과 온도의 영향 | --- | 또한 다른 세대 전략을 보여줍니다. | 암호 | 캐글 코랩 |

| 11. DPO 미세 조정 예시: 인간 선호도에 따른 LLM 대형 언어 모델 최적화 | 법학대학원 | DPO를 사용한 미세 조정의 예입니다. | 암호 | 캐글 코랩 |

| 12. Inseq 특징 속성: LLM의 출력을 시각적으로 해석 | 법학대학원 | 번역 및 텍스트 생성(빈칸 채우기) 작업의 시각적 예입니다. | 암호 | 캐글 코랩 |

| 13. AI에서 발생할 수 있는 편견을 이해하세요 | 법학대학원 | 코드에 대한 이해가 필요하지 않으며 여가 시간에 재미있는 탐색으로 사용할 수 있습니다. | 암호 | 캐글 코랩 |

| 14. PEFT: LoRA를 대형 모델에 빠르게 적용 | --- | 모델을 가져온 후 LoRA 레이어를 추가하는 방법을 알아보세요. | 암호 | 캐글 코랩 |

| 15. API를 사용하여 AI 비디오 요약 구현: 나만의 AI 비디오 도우미 만들기 | API 및 LLM | 일반적인 AI 비디오 요약 도우미의 원리를 배우고 AI 비디오 요약 구현을 시작합니다. | 코드 - 정식 버전 코드 - 라이트 버전 ?스크립트 | 캐글 코랩 |

| 16. LoRA를 사용하여 Stable Diffusion 미세 조정: 연금술로를 분해하고 첫 번째 AI 페인팅 구현 | SD | LoRA를 사용하여 Vincent 다이어그램 모델을 미세 조정하고 이제 LoRA 파일을 다른 사람에게 제공할 수도 있습니다. | 암호 코드 - 라이트 버전 | 캐글 코랩 |

| 17. RTN 모델 양자화에 대한 간략한 논의: 비대칭 대 대칭.md | --- | RTN 모델의 정량화 동작을 더 자세히 이해하기 위해 이 기사에서는 INT8을 예로 사용하여 설명합니다. | 암호 | 캐글 코랩 |

| 18. 모델 정량화 기술 개요 및 GGUF/GGML 파일 형식 분석 | --- | 이 글은 GGUF/GGML을 사용할 때 발생하는 몇 가지 의심을 해결할 수 있는 개요 기사입니다. | ||

| 19a. 로딩부터 대화까지: Transformers를 사용하여 로컬에서 양자화된 LLM 대형 모델(GPTQ 및 AWQ) 실행 19b. 로딩부터 대화까지: Llama-cpp-python을 사용하여 로컬에서 양자화된 LLM 대형 모델(GGUF) 실행 | 법학대학원 | 70억(7B) 매개변수가 포함된 정량적 모델을 컴퓨터에 배포합니다. 이 문서에는 그래픽 카드가 필요하지 않습니다. 19 a GPTQ 및 AWQ 형식의 모델 로딩과 관련된 Transformers 사용. 19 b GGUF 형식의 모델 로딩과 관련된 Llama-cpp-python 사용. 또한 로컬 대형 모델 대화 상호 작용 기능도 완료합니다. | 코드 변환기 코드-라마-cpp-python ?스크립트 | |

| 20. RAG 입문 실습: 문서 분할부터 벡터 데이터베이스 및 질의응답 구축까지 | 법학대학원 | RAG 관련 관행. 재귀적인 텍스트 청킹이 어떻게 작동하는지 알아보세요. | 암호 | |

| 21. BPE vs WordPiece: Tokenizer의 작동 원리와 하위 단어 분할 방법 이해 | --- | Tokenizer의 기본 동작. 일반적인 하위 단어 분할 방법인 BPE 및 WordPiece에 대해 알아보세요. 어텐션 마스크(Attention Mask)와 토큰 유형 ID(Token Type ID)를 이해합니다. | 암호 | 캐글 코랩 |

| 22. 과제 - Bert 미세 조정 추출 질문 답변 | 이것은 BERT를 사용하여 다운스트림 질문 및 답변 작업을 미세 조정하는 과제입니다. 일주일 후에 모든 팁이 포함된 가이드 기사가 제공됩니다. 아니면 나중에 남겨두세요. 소개 글에서는 과제 설명을 다루지 않을 것이며, 학습을 위해 두 가지 버전의 코드가 업로드될 예정이니 걱정하지 마세요. 여기에는 마감일이 없습니다. | 코드 - 할당 | 캐글 코랩 |

팁

.md 로컬로 읽기 위해 웨어하우스를 가져오려는 경우 수식 오류가 발생하면 Ctrl+F 또는 Command+F 사용하여 \_ 를 검색하고 모두 _ 로 바꾸십시오.

추가 자료:

| 가이드 | 설명하다 |

|---|---|

| a. HFD를 사용하여 Hugging Face 모델 및 데이터 세트의 다운로드 속도를 높입니다. | 모델 다운로드가 너무 느리다고 생각되면 이 문서를 참조하여 구성할 수 있습니다. 프록시 관련 443 오류가 발생하는 경우 이 문서를 확인해 볼 수도 있습니다. |

| b. 기본 명령줄 명령의 빠른 확인(Linux/Mac에 적용 가능) | 명령줄 명령 빠른 확인에는 기본적으로 현재 창고에 관련된 모든 명령이 포함되어 있습니다. |

| c. 일부 문제에 대한 해결책 | 여기에서는 프로젝트를 진행하면서 발생할 수 있는 몇 가지 문제를 해결해 보겠습니다. - 원격 창고를 가져와 모든 로컬 수정 사항을 덮어쓰는 방법은 무엇입니까? - Hugging Face에서 다운로드한 파일을 확인하고 삭제하는 방법과 저장 경로를 수정하는 방법은 무엇인가요? |

| d. GGUF 모델을 로드하는 방법(공유/공유/분할/00001-of-0000...에 대한 솔루션) | - GGUF에 대한 Transformers의 새로운 기능에 대해 알아보세요. - Transformers/Llama-cpp-python/Ollama를 사용하여 GGUF 형식의 모델 파일을 로드합니다. - 조각난 GGUF 파일을 병합하는 방법을 알아보세요. - LLama-cpp-python을 오프로드할 수 없는 문제를 해결합니다. |

| e. 데이터 향상: torchvision.transforms의 일반적인 방법 분석 | - 일반적으로 사용되는 이미지 데이터 향상 방법을 이해합니다. 코드 | |

| f. 교차 엔트로피 손실 함수 nn.CrossEntropyLoss() 자세한 설명 및 핵심 사항 알림(PyTorch) | - 교차 엔트로피 손실 및 PyTorch 구현의 수학적 원리를 이해합니다. - 처음 사용할 때 주의할 점을 알아보세요. |

| g. 임베딩 레이어 nn.Embedding() 자세한 설명 및 핵심 사항 알림(PyTorch) | - 임베딩 레이어와 단어 임베딩의 개념을 이해합니다. - 사전 훈련된 모델을 사용하여 임베딩을 시각화합니다. 코드 | |

| h. Docker를 사용하여 딥 러닝 환경을 빠르게 구성합니다(Linux). h. Docker 기본 명령 및 일반적인 오류 해결 소개 | - 두 줄의 명령을 사용하여 딥러닝 환경 구성 - Docker 기본 명령어 소개 - 사용 중 흔히 발생하는 세 가지 오류 해결 |

폴더 설명:

시민

모든 코드 파일이 여기에 저장됩니다.

데이터

코드에 사용될 수 있는 작은 데이터를 저장하기 위해 이 폴더에 주의할 필요가 없습니다.

GenAI_PDF

[생성인공지능개론] 강좌의 과제 PDF 파일은 원래 구글 드라이브에 저장되어 있어서 업로드했습니다.

가이드

모든 지침 문서가 여기에 보관됩니다.

자산

.md 파일에 사용된 이미지는 다음과 같습니다. 이 폴더에 주의할 필요는 없습니다.

페이퍼노트

논문 에세이.

코드플레이그라운드

몇 가지 흥미로운 코드 스크립트 예제(장난감 버전)

읽어보기.md

summaryr.py ? 스크립트

AI 영상/오디오/자막 요약.

chat.py ?스크립트

AI 대화.

생성적 인공지능 학습 리소스 소개

강좌 홈페이지

공식 | 승인된 동영상: YouTube |

중국어 미러 버전의 제작 및 공유는 Li Hongyi 선생님의 승인을 받았습니다. 사심 없이 지식을 공유해주신 선생님께 감사드립니다!

PS 중국어 이미지는 Job Code(로컬 작업)의 모든 기능을 완벽하게 구현합니다. Kaggle은 중국어 Colab과 Kaggle의 내용이 원본 Job과 일치합니다. 그 중 하나를 선택하면 연구를 완료할 수 있습니다.

실제 필요에 따라 아래에서 방법을 선택하여 학습 환경을 준비하고, ► 또는 텍스트를 클릭하여 확장하세요 .

Kaggle (국내 직접 연결, 권장): 자세한 내용은 "Kaggle: 무료 GPU 사용 가이드, Colab의 이상적인 대안" 기사를 읽어보세요.

Colab (과학적인 인터넷 액세스 필요)

프로젝트의 코드 파일은 두 플랫폼 모두에서 동기화됩니다.

리눅스(우분투) :

sudo apt-get update

sudo apt-get install gitmacOS :

먼저 Homebrew를 설치합니다.

/bin/bash -c " $( curl -fsSL https://raw.githubusercontent.com/Homebrew/install/HEAD/install.sh ) "그런 다음 다음을 실행하십시오.

brew install git윈도우 :

Windows용 Git에서 다운로드하여 설치합니다.

리눅스(우분투) :

sudo apt-get update

sudo apt-get install wget curlmacOS :

brew install wget curl윈도우 :

Wget for Windows 및 Curl 공식 웹사이트에서 다운로드하여 설치하세요.

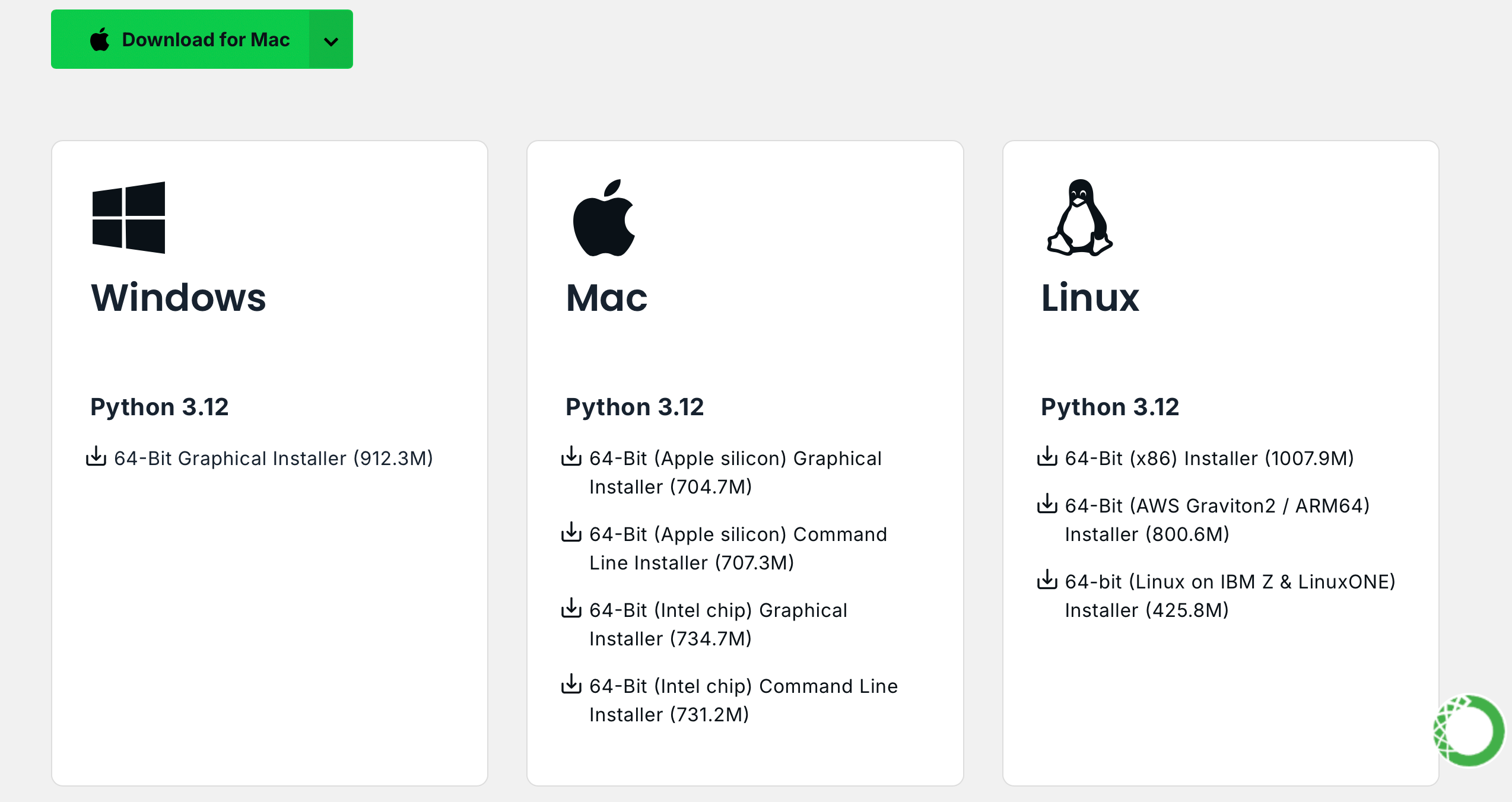

Anaconda 공식 웹사이트를 방문하여 이메일 주소를 입력하고 이메일을 확인하세요.

Download Now 클릭하고 적절한 버전을 선택하여 다운로드합니다(Anaconda와 Miniconda 모두 사용 가능).

리눅스(우분투) :

아나콘다 설치

버전 선택을 위해 repo.anaconda.com을 방문하세요.

# 下载 Anaconda 安装脚本(以最新版本为例)

wget https://repo.anaconda.com/archive/Anaconda3-2024.10-1-Linux-x86_64.sh

# 运行安装脚本

bash Anaconda3-2024.10-1-Linux-x86_64.sh

# 按照提示完成安装(先回车,空格一直翻页,翻到最后输入 yes,回车)

# 安装完成后,刷新环境变量或者重新打开终端

source ~ /.bashrcMiniconda 설치 (권장)

버전 선택을 보려면 repo.anaconda.com/miniconda를 방문하세요. Miniconda는 Conda와 Python만 포함하는 간소화된 버전의 Anaconda입니다.

# 下载 Miniconda 安装脚本

wget https://repo.anaconda.com/miniconda/Miniconda3-latest-Linux-x86_64.sh

# 运行安装脚本

bash Miniconda3-latest-Linux-x86_64.sh

# 按照提示完成安装(先回车,空格一直翻页,翻到最后输入 yes,回车)

# 安装完成后,刷新环境变量或者重新打开终端

source ~ /.bashrcmacOS :

이에 따라 Linux 명령의 URL을 바꿉니다.

아나콘다 설치

버전 선택을 위해 repo.anaconda.com을 방문하세요.

Miniconda 설치 (권장)

버전 선택을 보려면 repo.anaconda.com/miniconda를 방문하세요.

터미널에 다음 명령어를 입력하면 버전 정보가 표시되면 설치가 성공한 것입니다.

conda --versioncat << ' EOF ' > ~/.condarc

channels:

- defaults

show_channel_urls: true

default_channels:

- https://mirror.nju.edu.cn/anaconda/pkgs/main

- https://mirror.nju.edu.cn/anaconda/pkgs/r

- https://mirror.nju.edu.cn/anaconda/pkgs/msys2

custom_channels:

conda-forge: https://mirror.nju.edu.cn/anaconda/cloud

pytorch: https://mirror.nju.edu.cn/anaconda/cloud

EOF[!메모]

작년에 사용 가능했던 많은 미러 소스는 더 이상 사용할 수 없습니다. 다른 미러 사이트의 현재 구성에 대해서는 NTU: Mirror Usage Help에서 매우 유용한 문서를 참조할 수 있습니다.

참고 : Anaconda 또는 Miniconda가 이미 설치된 경우 pip 가 시스템에 포함되며 추가 설치가 필요하지 않습니다.

리눅스(우분투) :

sudo apt-get update

sudo apt-get install python3-pipmacOS :

brew install python3윈도우 :

Python을 다운로드하여 설치하고 "PATH에 Python 추가" 옵션이 선택되어 있는지 확인하세요.

명령 프롬프트를 열고 다음을 입력합니다.

python -m ensurepip --upgrade터미널에 다음 명령어를 입력하면 버전 정보가 표시되면 설치가 성공한 것입니다.

pip --versionpip config set global.index-url https://mirrors.aliyun.com/pypi/simple다음 명령을 사용하여 프로젝트를 가져옵니다.

git clone https://github.com/Hoper-J/AI-Guide-and-Demos-zh_CN.git

cd AI-Guide-and-Demos-zh_CN버전에는 제한이 없으며 더 높을 수 있습니다.

conda create -n aigc python=3.9 계속하려면 y 누르고 Enter를 누르세요. 생성이 완료되면 가상 환경을 활성화하세요.

conda activate aigc다음으로 기본 종속성을 설치해야 합니다. PyTorch 공식 웹사이트를 참조하여 CUDA 11.8을 예로 들어(그래픽 카드가 11.8을 지원하지 않는 경우 명령을 변경해야 함) 두 가지 중 하나를 선택하여 설치합니다.

# pip

pip3 install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu118

# conda

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia이제 필요한 모든 환경을 성공적으로 구성했으며 학습을 시작할 준비가 되었습니다. :) 나머지 종속성은 각 문서에 별도로 나열됩니다.

[!메모]

Docker 이미지에는 종속성이 사전 설치되어 있으므로 다시 설치할 필요가 없습니다.

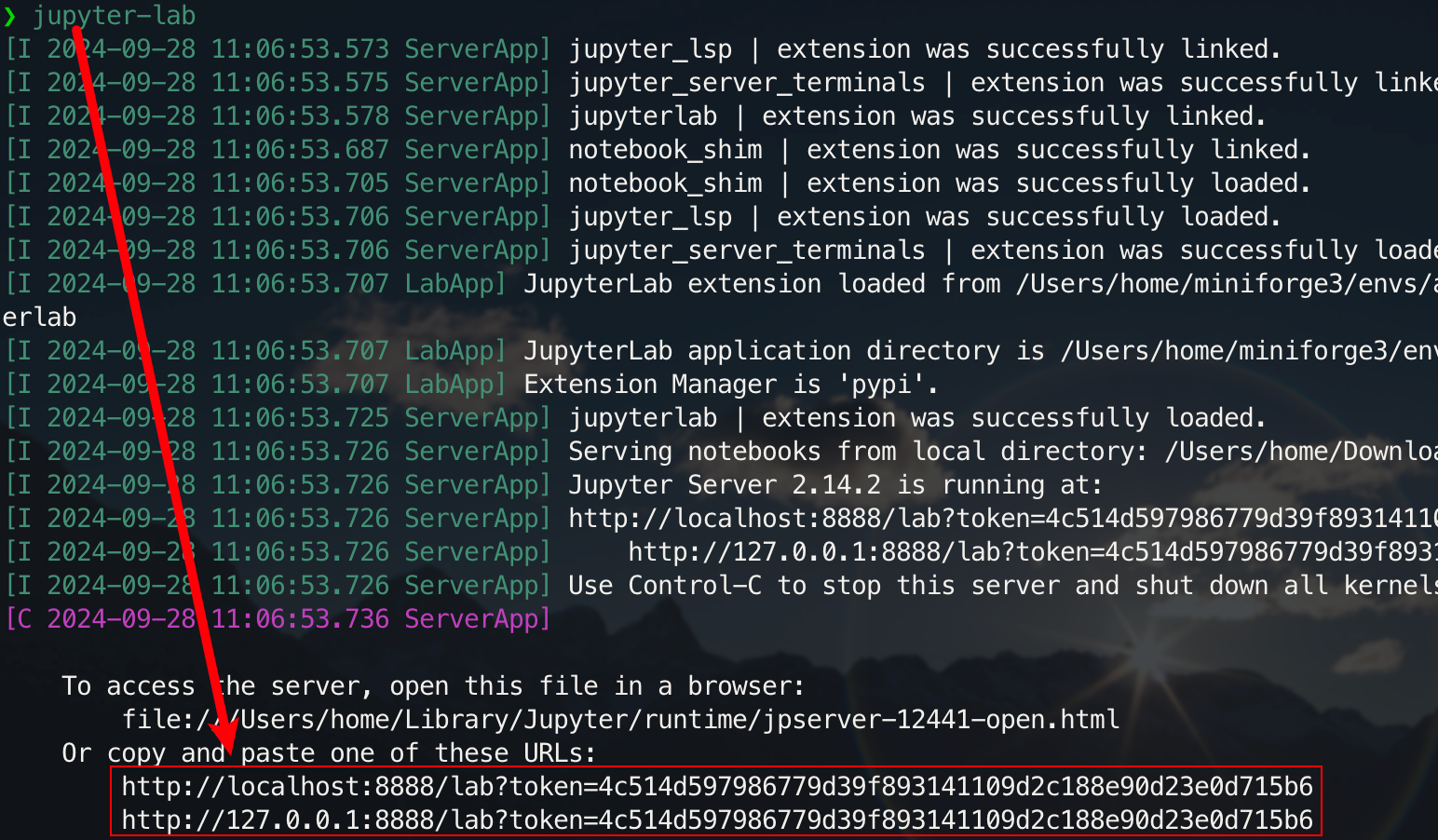

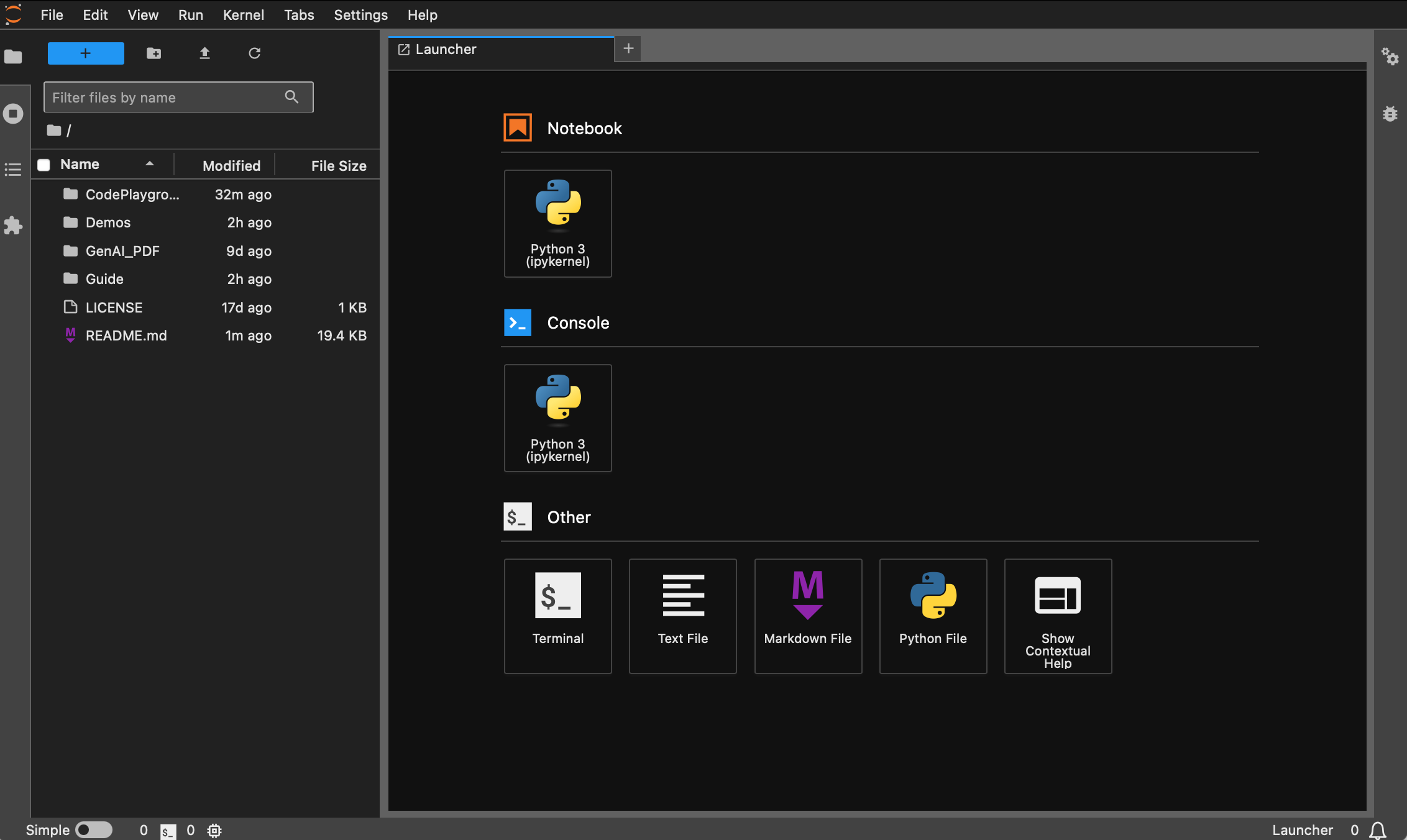

먼저 jupyter notebook 보다 사용하기 훨씬 쉬운 jupyter-lab 설치하세요.

pip install jupyterlab설치가 완료되면 다음 명령을 실행합니다.

jupyter-lab

이제 일반적으로 포트 8888에 있는 팝업 링크를 통해 액세스할 수 있습니다. 그래픽 인터페이스의 경우 Windows/Linux에서는 Ctrl 누르고 Mac에서는 Command 누른 다음 링크를 클릭하면 바로 이동할 수 있습니다. 이 시점에서 프로젝트의 전체 그림을 얻게 됩니다.

Docker를 설치하지 않은 학생은 "Docker를 사용하여 딥러닝 환경을 빠르게 구성(Linux)" 기사를 읽어보세요. 초보자는 "Docker 기본 명령 및 일반적인 오류 해결 소개"를 읽어보는 것이 좋습니다.

모든 버전에는 sudo , pip , conda , wget , curl , vim 등의 공통 도구가 사전 설치되어 있으며 pip 및 conda 의 국내 이미지 소스가 구성되었습니다. 동시에 zsh 와 일부 실용적인 명령줄 플러그인(명령 자동 완성, 구문 강조 및 디렉터리 점프 도구 z )을 통합합니다. 또한, jupyter notebook 과 jupyter lab 사전 설치되어 있으며, 딥러닝 개발을 용이하게 하기 위해 기본 터미널은 zsh 로 설정되어 있으며, 컨테이너 내 중국어 디스플레이는 문자 깨짐을 방지하도록 최적화되었습니다. Hugging Face의 국내 미러 주소도 미리 구성되어 있습니다.

pytorch/pytorch:2.5.1-cuda11.8-cudnn9-devel 기반으로 합니다. 기본 python 버전은 3.11.10입니다. 버전은 conda install python==版本号통해 직접 수정할 수 있습니다.적절한 설치 :

wget , curl : 명령줄 다운로드 도구vim , nano : 텍스트 편집기git : 버전 관리 도구git-lfs : Git LFS (대용량 파일 저장)zip , unzip : 파일 압축 및 압축 풀기 도구htop : 시스템 모니터링 도구tmux , screen : 세션 관리 도구build-essential : 컴파일 도구(예: gcc , g++ )iputils-ping , iproute2 , net-tools : 네트워크 도구( ping , ip , ifconfig , netstat 등과 같은 명령 제공)ssh : 원격 연결 도구rsync : 파일 동기화 도구tree : 파일 및 디렉터리 트리를 표시합니다.lsof : 현재 시스템에 열려 있는 파일 보기aria2 : 다중 스레드 다운로드 도구libssl-dev : OpenSSL 개발 라이브러리핍 설치 :

jupyter notebook , jupyter lab : 대화형 개발 환경virtualenv : Python 가상 환경 관리 도구로 conda를 직접 사용할 수 있습니다.tensorboard : 딥 러닝 훈련 시각화 도구ipywidgets : 진행률 표시줄을 올바르게 표시하는 Jupyter 위젯 라이브러리플러그인 :

zsh-autosuggestions : 명령 자동 완성zsh-syntax-highlighting : 구문 강조z : 디렉토리로 빠르게 이동dl (Deep Learning) 버전은 base를 기반으로 하며 딥러닝에 사용할 수 있는 기본 도구 및 라이브러리를 추가로 설치합니다.

적절한 설치 :

ffmpeg : 오디오 및 비디오 처리 도구libgl1-mesa-glx : 그래픽 라이브러리 종속성(일부 딥 러닝 프레임워크 그래픽 관련 문제 해결)핍 설치 :

numpy , scipy : 수치 계산 및 과학 계산pandas : 데이터 분석matplotlib , seaborn : 데이터 시각화scikit-learn : 머신러닝 도구tensorflow , tensorflow-addons : 또 다른 인기 있는 딥 러닝 프레임워크tf-keras : Keras 인터페이스의 TensorFlow 구현transformers , datasets : Hugging Face에서 제공하는 NLP 도구nltk , spacy : 자연어 처리 도구추가 라이브러리가 필요한 경우 다음 명령을 사용하여 수동으로 설치할 수 있습니다.

pip install --timeout 120 <替换成库名> 여기서 --timeout 120 네트워크 상태가 좋지 않은 경우에도 설치에 충분한 시간이 있도록 시간 제한을 120초로 설정합니다. 설정하지 않을 경우, 국내 환경에서 다운로드 시간 초과로 인해 설치 패키지가 실패하는 상황이 발생할 수 있습니다.

모든 이미지는 미리 창고로 가져오지 않으니 참고하세요.

Docker를 설치하고 구성했다고 가정하면 딥 러닝 환경 구성을 완료하는 데 두 줄의 명령만 필요합니다. 현재 프로젝트의 경우 두 가지의 해당 image_name:tag 확인한 후 선택할 수 있습니다. 다음과 같습니다:

hoperj/quickstart:base-torch2.5.1-cuda11.8-cudnn9-develhoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-devel끌어오기 명령은 다음과 같습니다.

docker pull < image_name:tag >다음은 dl 버전을 예로 사용하여 완료할 방법 중 하나를 선택합니다.

docker pull dockerpull.org/hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develdocker pull hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-develBaidu Cloud Disk를 통해 파일을 다운로드할 수 있습니다. (Alibaba Cloud Disk는 대용량 압축 파일 공유를 지원하지 않습니다.)

동일한 이름을 가진 파일은 동일한 내용을 갖습니다.

.tar.gz는 압축된 버전입니다. 다운로드 후 다음 명령을 사용하여 압축을 해제합니다.gzip -d dl.tar.gz

dl.tar ~/Downloads 에 다운로드되었다고 가정하고 해당 디렉터리로 전환합니다.

cd ~ /Downloads그런 다음 이미지를 로드합니다.

docker load -i dl.tar이 모드에서는 컨테이너가 호스트의 네트워크 구성을 직접 사용하며, 별도의 매핑 없이 모든 포트가 호스트의 포트와 동일합니다. 특정 포트만 매핑해야 하는 경우

--network host-p port:port로 바꾸세요.

docker run --gpus all -it --name ai --network host hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-devel /bin/zsh 프록시를 사용해야 하는 학생의 경우 -e 추가하여 환경 변수를 설정할 수도 있습니다. 다음 확장 문서를 참조할 수도 있습니다.

프록시의 HTTP/HTTPS 포트 번호가 7890이고 SOCKS5가 7891이라고 가정합니다.

-e http_proxy=http://127.0.0.1:7890-e https_proxy=http://127.0.0.1:7890-e all_proxy=socks5://127.0.0.1:7891이전 명령에 통합되었습니다.

docker run --gpus all -it

--name ai

--network host

-e http_proxy=http://127.0.0.1:7890

-e https_proxy=http://127.0.0.1:7890

-e all_proxy=socks5://127.0.0.1:7891

hoperj/quickstart:dl-torch2.5.1-cuda11.8-cudnn9-devel

/bin/zsh[!팁]

일반적인 작업을 미리 확인하세요 .

- 컨테이너 시작 :

docker start <容器名>- 컨테이너 실행 :

docker exec -it <容器名> /bin/zsh

- 컨테이너 내에서 종료 :

Ctrl + D또는exit.- 컨테이너 중지 :

docker stop <容器名>- 컨테이너 삭제 :

docker rm <容器名>

git clone https://github.com/Hoper-J/AI-Guide-and-Demos-zh_CN.git

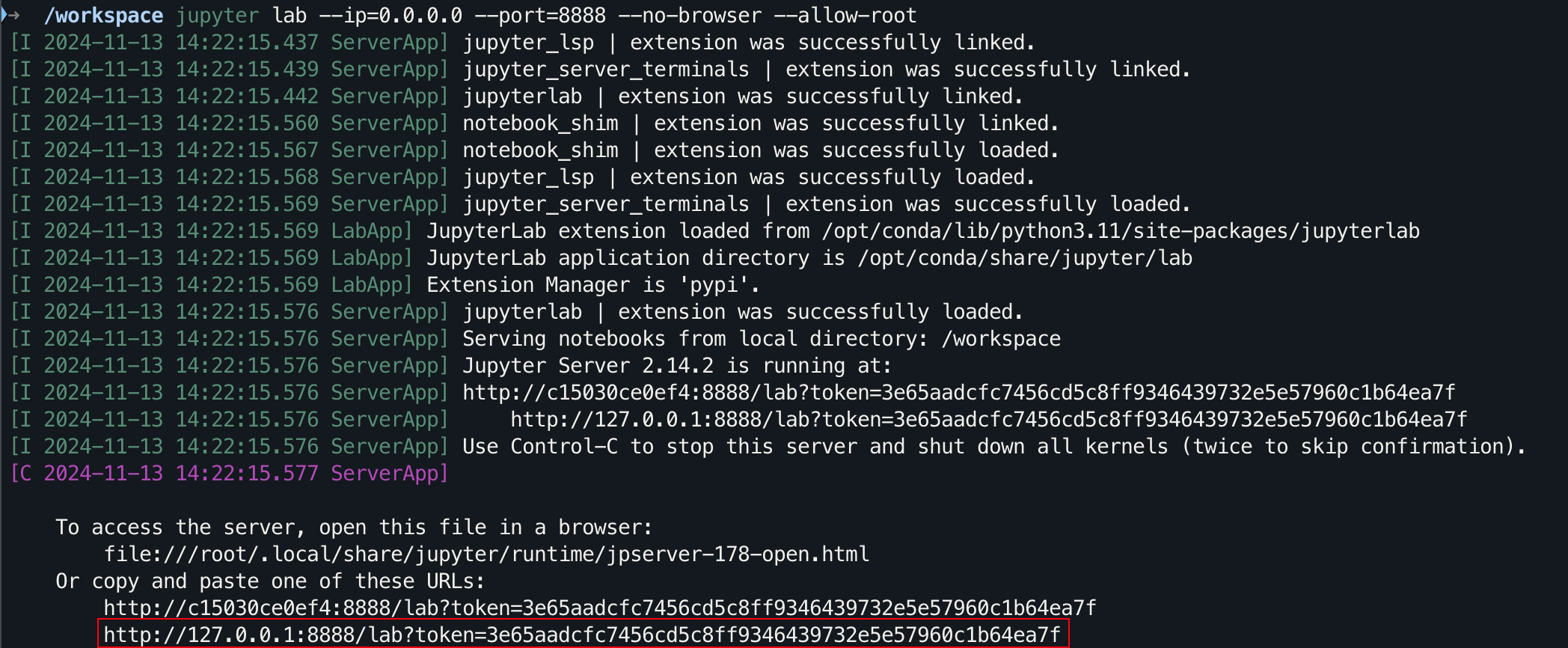

cd AI-Guide-and-Demos-zh_CNjupyter lab --ip=0.0.0.0 --port=8888 --no-browser --allow-root

그래픽 인터페이스의 경우 Windows/Linux에서는 Ctrl 누르고 Mac에서는 Command 누른 다음 링크를 클릭하면 바로 이동할 수 있습니다.

STAR를 보내 주셔서 감사합니다. 이것이 도움이 되기를 바랍니다.