llm agent

1.0.0

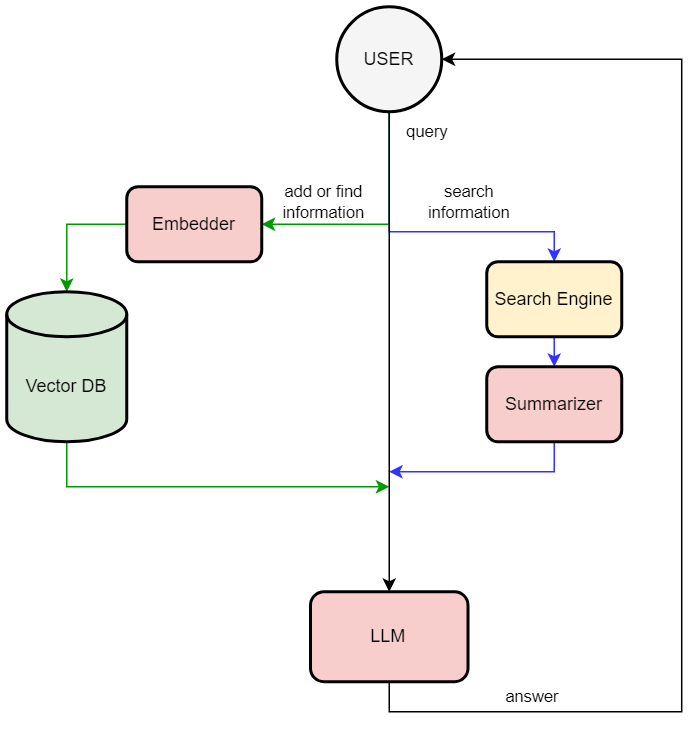

벡터 데이터베이스를 통한 장기 메모리를 활용한 RAG 기반 LLM

이 저장소를 사용하면 대규모 언어 모델이 벡터 데이터베이스를 통해 장기 메모리를 사용할 수 있습니다(이 방법을 RAG(Retrieval Augmented Generation)라고 합니다. 이는 LLM이 외부 데이터베이스에서 사실을 검색할 수 있게 하는 기술입니다). 애플리케이션은 mistral-7b-instruct-v0.2.Q4_K_M.gguf(LLAMA_cpp_python 바인딩 사용) 및chromdb를 사용하여 구축되었습니다. 사용자는 자연어로 DB에 정보를 추가하도록 요청할 수 있고, 안내를 사용하여 DB나 인터넷에서 정보를 찾을 수 있습니다.

You > Hi

LOG: [Response]

Bot < Hello! How can I assist you today?

You > Please add information to db "The user name is Rustam Akimov"

LOG: [Adding to memory]

Bot < Done!

You > Can you find on the Internet who is Pavel Durov

LOG: [Extracting question]

LOG: [Searching]

LOG: [Summarizing]

Bot < According to the search results provided, Pavel Durov is a Russian entrepreneur who co-founded Telegram Messenger Inc.

You > Please find information in db who is Rustam Akimov

LOG: [Extracting question]

LOG: [Querying memory]

Bot < According to the input memories, your name is Rustam Akimov.