reweight gpt

1.0.0

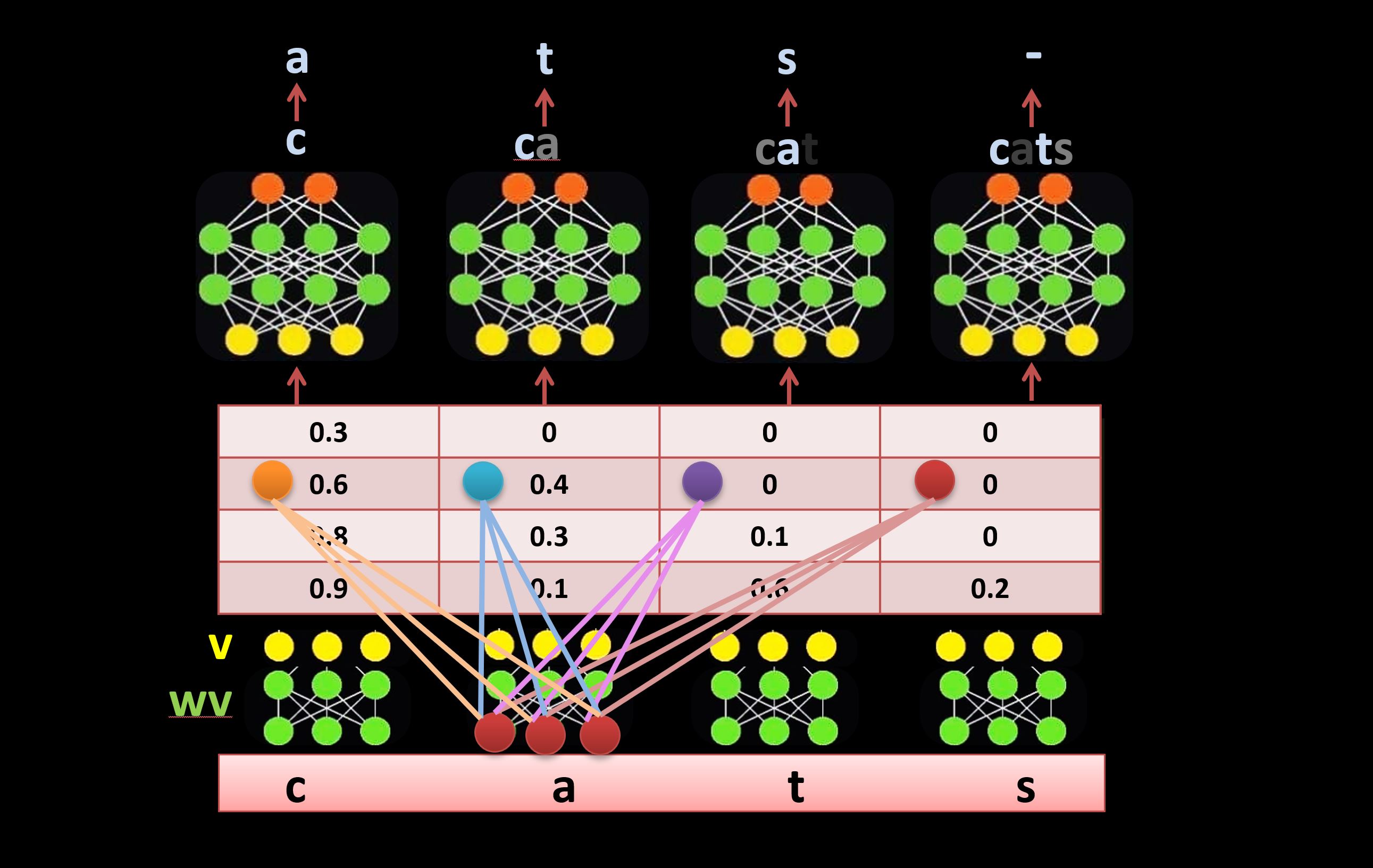

Transformer 아키텍처의 자체 감쇠 메커니즘에 대한 대안입니다. 학습 가능한 측면 연결을 사용하여 self-attention 메커니즘 대신 입력에 직접 가중치를 다시 부여합니다(아래 그림 참조). 이 방법에 대해 자세히 알아보려면 다음 동영상(41:26부터)을 시청하세요. https://youtu.be/l-CjXFmcVzY