[? 포옹얼굴] [? OpenXLab] [? 논문] [ 프로젝트 페이지]

오픈 소스 LLM(대형 언어 모델)은 다양한 NLP 작업에서 큰 성공을 거두었지만 에이전트 역할을 할 때 API 기반 모델보다 여전히 열등합니다. 에이전트 능력을 일반 LLM에 통합하는 방법이 중요하고 시급한 문제가 됩니다. 이 논문은 먼저 세 가지 주요 관찰을 제공합니다. (1) 현재 에이전트 훈련 코퍼스는 다음 형식과 에이전트 추론과 얽혀 있으며 이는 사전 훈련 데이터의 분포에서 크게 이동합니다. (2) LLM은 에이전트 작업에 필요한 기능에 대해 다양한 학습 속도를 나타냅니다. (3) 현재 접근 방식은 환각을 도입하여 에이전트 능력을 향상시킬 때 부작용이 있습니다. 위의 결과를 바탕으로 에이전트를 위한 LANguage 모델을 효과적으로 미세 조정하기 위해 Agent-FLAN을 제안합니다. Agent-FLAN은 훈련 코퍼스의 신중한 분해 및 재설계를 통해 Llama2-7B가 다양한 에이전트 평가 데이터 세트에서 이전 최고의 작업보다 3.5% 더 나은 성능을 발휘할 수 있도록 해줍니다. Agent-FLAN은 포괄적으로 구성된 네거티브 샘플을 통해 확립된 평가 벤치마크를 기반으로 환각 문제를 크게 완화합니다. 또한 모델 크기를 확장할 때 LLM의 에이전트 기능을 지속적으로 향상시키는 동시에 LLM의 일반 기능을 약간 향상시킵니다.

Agent-FLAN 시리즈는 Agent-FLAN 논문에서 제안한 데이터 생성 파이프라인을 적용하여 AgentInstruct 및 Toolbench에서 미세 조정되었으며, 다양한 에이전트 작업 및 도구 활용에 강력한 능력을 보유하고 있습니다~

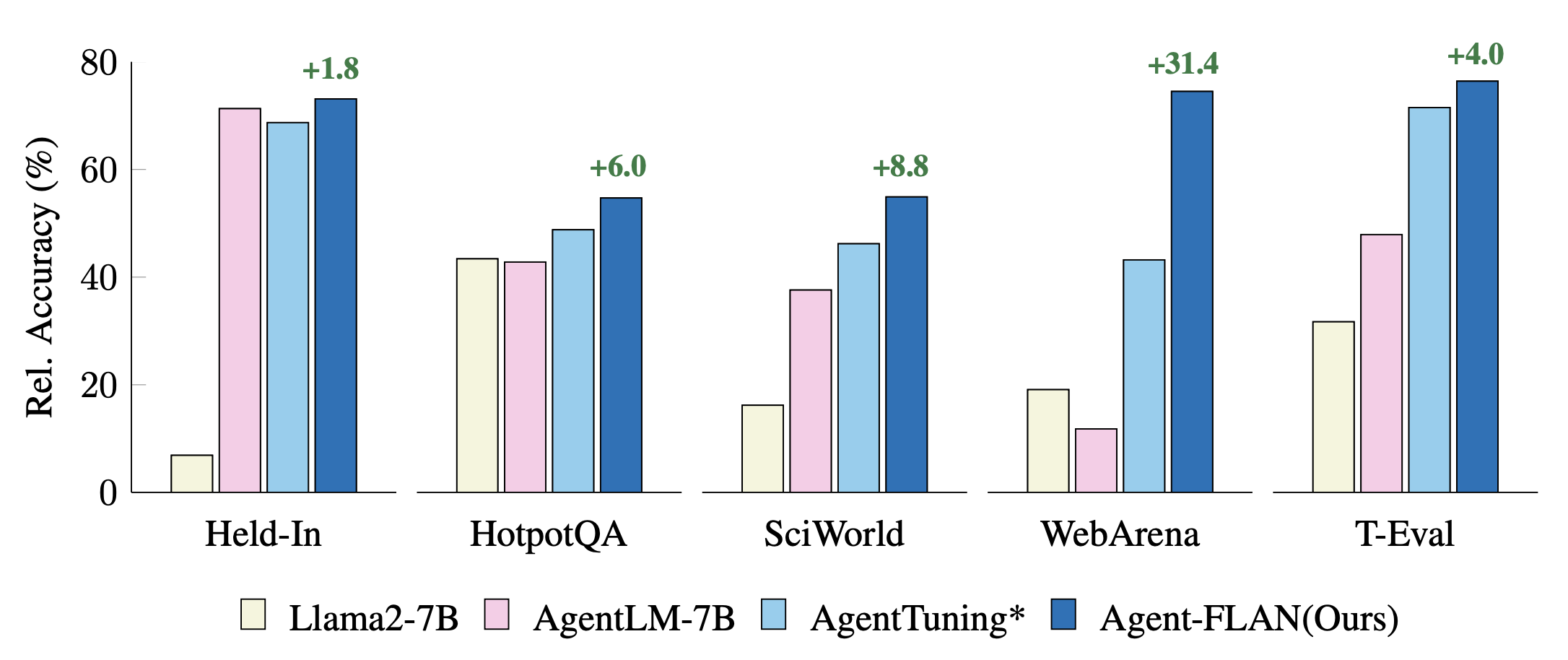

Held-In, Held-Out 작업에 대한 최근 에이전트 튜닝 접근 방식을 비교합니다. 성능은 더 나은 시각화를 위해 GPT-4 결과로 정규화됩니다. *는 공정한 비교를 위한 재구현을 나타냅니다.

Agent-FLAN은 Llama2-chat 시리즈의 AgentInstruct, ToolBench 및 ShareGPT 데이터 세트에 대한 혼합 교육을 통해 생성됩니다.

모델은 다음과 같은 템플릿 프로토콜을 사용하여 Llama-2-chat의 대화 형식을 따릅니다.

dict ( role = 'user' , begin = '<|Human|>െ' , end = ' n ' ),

dict ( role = 'system' , begin = '<|Human|>െ' , end = ' n ' ),

dict ( role = 'assistant' , begin = '<|Assistant|>െ' , end = 'ി n ' ),7B 모델은 Huggingface 및 OpenXLab 모델 허브에서 사용할 수 있습니다.

| 모델 | 허깅페이스 레포 | OpenXLab 저장소 |

|---|---|---|

| 에이전트-FLAN-7B | 모델 링크 | 모델 링크 |

Agent-FLAN 데이터 세트는 Huggingface 데이터 세트 허브에서도 사용할 수 있습니다.

| 데이터세트 | 허깅페이스 레포 |

|---|---|

| Agent-FLAN | 데이터세트 링크 |

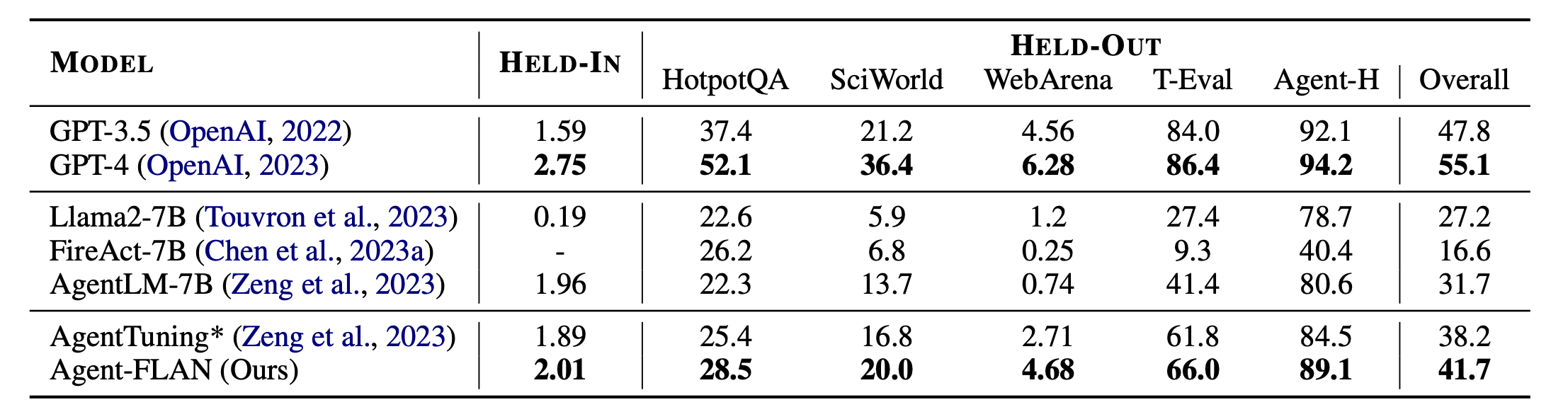

Agent-FLAN의 주요 결과. Agent-FLAN은 보류 작업과 보류 작업 모두에서 이전 에이전트 조정 접근 방식보다 훨씬 뛰어난 성능을 발휘합니다. *는 공정한 비교를 위해 동일한 양의 훈련 데이터를 사용하여 다시 구현했음을 나타냅니다. FireAct는 AgentInstruct 데이터세트를 학습하지 않으므로 HELD-IN 세트에 대한 성능은 생략합니다. 굵은 글씨: API 기반 및 오픈 소스 모델 중 최고입니다.

Agent-FLAN은 Lagent 및 T-Eval로 구축되었습니다. 그들의 멋진 작업에 감사드립니다!

이 프로젝트가 귀하의 연구에 유용하다고 생각되면 다음을 인용해 보십시오.

@article{chen2024agent,

title={Agent-FLAN: Designing Data and Methods of Effective Agent Tuning for Large Language Models},

author={Chen, Zehui and Liu, Kuikun and Wang, Qiuchen and Zhang, Wenwei and Liu, Jiangning and Lin, Dahua and Chen, Kai and Zhao, Feng},

journal={arXiv preprint arXiv:2403.12881},

year={2024}

}

이 프로젝트는 Apache 2.0 라이센스에 따라 릴리스됩니다.