?? 문서 /문서 |

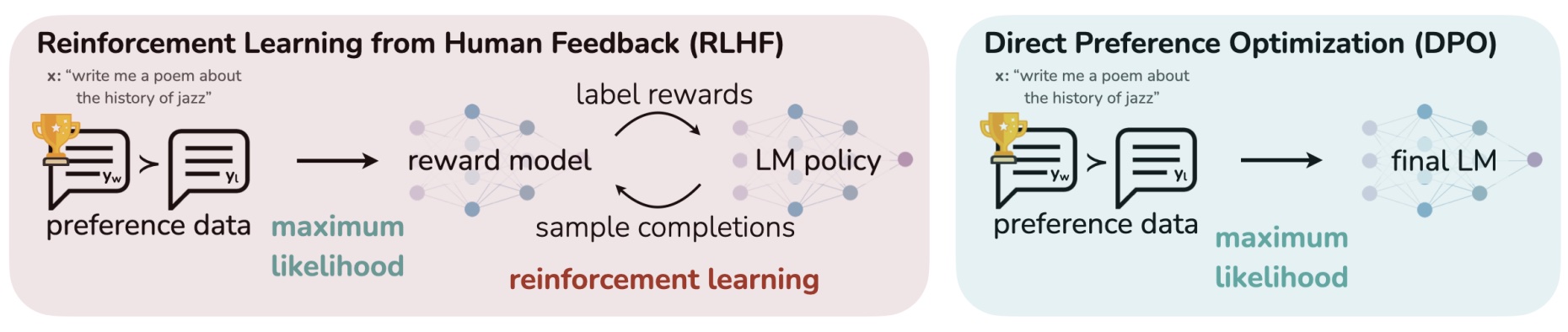

ChatGPT 교육 파이프라인, 사전 교육 구현, 감독 미세 조정, RLHF(보상 모델링 및 강화 학습) 및 DPO(직접 선호 최적화)를 통해 MedicalGPT 교육 의료 GPT 모델입니다.

MedicalGPT는 대규모 의료 모델을 훈련하고 증분 사전 훈련, 감독 미세 조정, RLHF(보상 모델링, 강화 학습 훈련) 및 DPO(직접 선호 최적화)를 구현합니다.

[2024/09/21] v2.3 버전: Qwen-2.5 시리즈 모델을 지원합니다. 자세한 내용은 Release-v2.3을 참조하세요.

[2024/08/02] v2.2 버전: 롤플레잉 모델 훈련을 지원하고 의사-환자 대화 SFT 데이터 생성 스크립트 role_play_data를 추가합니다. 자세한 내용은 Release-v2.2를 참조하세요.

[2024/06/11] v2.1 버전: Qwen-2 시리즈 모델을 지원합니다. 자세한 내용은 Release-v2.1을 참조하세요.

[2024/04/24] v2.0 버전: Llama-3 시리즈 모델을 지원합니다. 자세한 내용은 Release-v2.0을 참조하세요.

[2024/04/17] v1.9 버전: ORPO를 지원하며, 자세한 사용법은 run_orpo.sh 를 참고하세요. 자세한 내용은 Release-v1.9를 참조하세요.

[2024/01/26] v1.8 버전: Mixtral 하이브리드 전문가 MoE 모델 Mixtral 8x7B 미세 조정을 지원합니다. 자세한 내용은 Release-v1.8을 참조하세요.

[2024/01/14] v1.7 버전: 새로 추가된 검색 강화 생성(RAG) 기반 파일 Q&A ChatPDF 기능, 코드 chatpdf.py , 업계 개선을 위해 지식 기반 파일 Q&A와 결합된 미세 조정된 LLM을 기반으로 할 수 있음 Q&A 정확성. 자세한 내용은 Release-v1.7을 참조하세요.

[2023/10/23] v1.6 버전: GPT 모델의 컨텍스트 길이를 확장하기 위해 RoPE 보간을 추가했으며 LLaMA 모델에 대해 FlashAttention-2 및 LongLoRA를 지원합니다.

[2023/08/28] 버전 v1.5: DPO(Direct Preference Optimization) 방식이 추가되었습니다. DPO는 언어 모델을 직접 최적화하여 동작을 정밀하게 제어하고 인간의 선호도를 효과적으로 학습할 수 있습니다. 자세한 내용은 Release-v1.5를 참조하세요.

[2023/08/08] v1.4 버전: ShareGPT4 데이터 세트의 미세 조정을 기반으로 하는 중국어 및 영어 Vicuna-13B 모델 shibing624/vicuna-baichuan-13b-chat 및 해당 LoRA 모델 shibing624/vicuna 출시 -baichuan-13b-chatlora, 자세한 내용은 Release-v1.4를 참조하세요.

[2023/08/02] v1.3 버전: LLaMA, LLaMA2, Bloom, ChatGLM, ChatGLM2 및 Baichuan 모델의 다중 라운드 대화 미세 조정 훈련이 추가되었습니다. 도메인 어휘 확장 기능이 추가되었습니다. 중국어 ShareGPT 미세 조정 훈련 세트, 자세한 내용은 Release-v1.3을 참조하세요.

[2023/07/13] v1.1 버전: Ziya-LLaMA-13B-v1 모델을 기반으로 중국 의료용 LLaMA-13B 모델 shibing624/ziya-llama-13b-medical-merged 출시, SFT 미세 조정 버전 의료 모델의, Medical 문답 효과가 개선되었으며, 미세 조정 후 전체 모델 가중치가 공개되었습니다. 자세한 내용은 Release-v1.1을 참조하세요.

[2023/06/15] v1.0 버전: Ziya-LLaMA-13B-v1 모델을 기반으로 한 중국 의료 LoRA 모델 sibing624/ziya-llama-13b-medical-lora 출시, SFT는 의료 모델 버전을 미세 조정했습니다. , 의학적 문답 효과가 개선되었으며, 미세 조정된 LoRA 가중치가 공개되었습니다. 자세한 내용은 Release-v1.0을 참조하세요.

[2023/06/05] 버전 v0.2: 의료를 예로 들어 훈련 분야의 대형 모델은 2차 사전 훈련, 감독된 미세 조정, 보상 모델링 및 강화 학습 훈련을 포함하는 4단계의 훈련을 구현합니다. . 자세한 내용은 Release-v0.2를 참조하세요.

ChatGPT 훈련 파이프라인을 기반으로 이 프로젝트는 의료 산업의 대규모 언어 모델 훈련인 도메인 모델을 구현합니다.

| 모델 | 기본 모델 | 소개 |

|---|---|---|

| shibing624/ziya-llama-13b-medical-lora | IDEA-CCNL/Ziya-LLaMA-13B-v1 | SFT는 240만 개의 중국어 및 영어 의료 데이터 세트 sibing624/medical에서 Ziya-LLaMA-13B 모델 버전을 미세 조정했습니다. 의료 질문 및 답변 효과가 향상되었으며 미세 조정된 LoRA 가중치(단일 대화)가 있습니다. 출시되었습니다. |

| shibing624/ziya-llama-13b-의료-병합 | IDEA-CCNL/Ziya-LLaMA-13B-v1 | SFT는 240만 개의 중국어 및 영어 의료 데이터 세트 sibing624/medical에서 Ziya-LLaMA-13B 모델 버전을 미세 조정했습니다. 의료 질문 및 답변 효과가 향상되었으며 미세 조정 후 전체 모델 가중치(단일 라운드) 대화)가 공개됩니다. |

| shibing624/vicuna-baichuan-13b-chat-lora | baichuan-inc/Baichuan-13B-Chat | SFT는 100,000개의 다국어 ShareGPT GPT4 다단계 대화 데이터 세트 sibing624/sharegpt_gpt4 및 의료 데이터 세트 shibing624/medical에 대한 baichuan-13b-chat 다단계 질문 및 답변 모델 버전을 미세 조정했습니다. Q&A 및 의료 Q&A가 개선되었으며, 이후 LoRA 웨이트 미세 조정이 출시되었습니다. |

| shibing624/vicuna-baichuan-13b-chat | baichuan-inc/Baichuan-13B-Chat | SFT는 100,000개의 다국어 ShareGPT GPT4 다단계 대화 데이터 세트 sibing624/sharegpt_gpt4 및 의료 데이터 세트 shibing624/medical에 대한 baichuan-13b-chat 다단계 질문 및 답변 모델 버전을 미세 조정했습니다. Q&A 및 의료 Q&A가 개선되었으며, 이후의 전체 모델 중량이 공개되었습니다. |

| shibing624/llama-3-8b-instruct-262k-중국어 | 라마-3-8B-Instruct-262k | 20,000개의 중국어 및 영어 선호도 데이터 세트 sibing624/DPO-En-Zh-20k-Preference에 대해 ORPO 방법을 미세 조정하여 얻은 매우 긴 텍스트 다중 회전 대화 모델은 RAG 및 다중 회전 대화에 적합합니다. |

shibing624/vicuna-baichuan-13b-chat 모델의 효과를 보여줍니다.  구체적인 사례는 추론 예를 참조하세요.

구체적인 사례는 추론 예를 참조하세요.

Gradio를 기반으로 간단한 대화형 웹 인터페이스를 제공하며, 서비스를 시작한 후 브라우저를 통해 접속하여 질문을 입력하면 모델이 답변을 반환합니다.

다음 명령을 사용하여 서비스를 시작합니다.

CUDA_VISIBLE_DEVICES=0 python gradio_demo.py --model_type base_model_type --base_model path_to_llama_hf_dir --lora_model path_to_lora_dir매개변수 설명:

--model_type {base_model_type} : llama, Bloom, chatglm 등과 같은 사전 훈련된 모델 유형입니다.--base_model {base_model} : LLaMA 모델 가중치 및 구성 파일을 HF 형식으로 저장하는 디렉터리입니다. HF 모델 허브 모델 호출 이름을 사용할 수도 있습니다.--lora_model {lora_model} : LoRA 파일이 있는 디렉터리입니다. HF Model Hub 모델 호출 이름을 사용할 수도 있습니다. lora 가중치가 사전 훈련된 모델에 병합된 경우 --lora_model 매개변수를 삭제합니다.--tokenizer_path {tokenizer_path} : 해당 토크나이저가 저장되는 디렉터리입니다. 이 매개변수가 제공되지 않으면 기본값은 --base_model과 동일합니다.--template_name : vicuna , alpaca 등과 같은 템플릿 이름입니다. 이 매개변수가 제공되지 않으면 기본값은 vicuna입니다.--only_cpu : 추론에만 CPU를 사용합니다.--resize_emb : 임베딩 크기를 조정할지 여부. 그렇지 않은 경우 사전 학습된 모델의 임베딩 크기를 사용합니다. 기본값은 조정하지 않는 것입니다. requirements.txt 최신 기능에 맞게 수시로 업데이트됩니다. 종속성을 업데이트하려면 다음 명령을 사용하세요.

git clone https://github.com/shibing624/MedicalGPT

cd MedicalGPT

pip install -r requirements.txt --upgrade* 추정

| 훈련 방법 | 정확성 | 7B | 13B | 30B | 70B | 110B | 8x7B | 8x22B |

|---|---|---|---|---|---|---|---|---|

| 전체 매개변수 | AMP(자동 혼합 정밀도) | 120GB | 240GB | 600GB | 1200GB | 2000GB | 900GB | 2400GB |

| 전체 매개변수 | 16 | 60GB | 120GB | 300GB | 600GB | 900GB | 400GB | 1200GB |

| 로라 | 16 | 16GB | 32GB | 64GB | 160GB | 240GB | 120GB | 320GB |

| QLoRA | 8 | 10GB | 20GB | 40GB | 80GB | 140GB | 60GB | 160GB |

| QLoRA | 4 | 6GB | 12GB | 24GB | 48GB | 72GB | 30GB | 96GB |

| QLoRA | 2 | 4GB | 8GB | 16GB | 24GB | 48GB | 18GB | 48GB |

훈련 단계:

| 단계 | 소개 | 파이썬 스크립트 | 쉘 스크립트 |

|---|---|---|---|

| 사전 훈련 계속하기 | 증분 사전 학습 | pretraining.py | run_pt.sh |

| 감독된 미세 조정 | 감독된 미세 조정 | supervised_finetuning.py | run_sft.sh |

| 직접 선호도 최적화 | 직접 선호도 최적화 | dpo_training.py | run_dpo.sh |

| 보상 모델링 | 보상 모델 모델링 | award_modeling.py | run_rm.sh |

| 강화 학습 | 강화 학습 | ppo_training.py | run_ppo.sh |

| 오르포 | 확률적 선호도 최적화 | orpo_training.py | run_orpo.sh |

| 모델명 | 모델 크기 | 대상 모듈 | 주형 |

|---|---|---|---|

| 바이촨 | 7B/13B | W_팩 | 백천 |

| 바이촨2 | 7B/13B | W_팩 | 백천2 |

| 블룸즈 | 560M/1.1B/1.7B/3B/7.1B/176B | 쿼리_키_값 | 비쿠나 |

| 채팅GLM | 6B | 쿼리_키_값 | chatglm |

| 채팅GLM2 | 6B | 쿼리_키_값 | chatglm2 |

| 채팅GLM3 | 6B | 쿼리_키_값 | chatglm3 |

| 코히어 | 104B | q_proj,v_proj | 응집하다 |

| DeepSeek | 7B/16B/67B | q_proj,v_proj | 깊은 탐색 |

| 인턴LM2 | 7B/20B | wxya | 인턴2 |

| 야마 | 7B/13B/33B/65B | q_proj,v_proj | 알파카 |

| LLaMA2 | 7B/13B/70B | q_proj,v_proj | 라마2 |

| LLaMA3 | 8B/70B | q_proj,v_proj | 라마3 |

| 미스트랄 | 7B/8x7B | q_proj,v_proj | 미스트랄 |

| 오리온 | 14B | q_proj,v_proj | 오리온 |

| 퀀 | 1.8B/7B/14B/72B | c_attn | 퀀 |

| Qwen1.5 | 0.5B/1.8B/4B/14B/32B/72B/110B | q_proj,v_proj | 퀀 |

| Qwen2 | 0.5B/1.5B/7B/72B | q_proj,v_proj | 퀀 |

| 엑스버스 | 13B | 쿼리_키_값 | 엑스버스 |

| 이 | 6B/34B | q_proj,v_proj | 이 |

훈련이 완료되면 이제 훈련된 모델을 로드하고 모델에서 생성된 텍스트의 효과를 확인합니다.

CUDA_VISIBLE_DEVICES=0 python inference.py

--model_type base_model_type

--base_model path_to_model_hf_dir

--tokenizer_path path_to_model_hf_dir

--lora_model path_to_lora

--interactive매개변수 설명:

--model_type {base_model_type} : llama, Bloom, chatglm 등과 같은 사전 훈련된 모델 유형입니다.--base_model {base_model} : LLaMA 모델 가중치 및 구성 파일을 HF 형식으로 저장하는 디렉터리--tokenizer_path {base_model} : LLaMA 모델 가중치 및 구성 파일을 HF 형식으로 저장하는 디렉터리--lora_model {lora_model} : LoRA 압축 해제 파일이 있는 디렉터리입니다. HF Model Hub 모델 호출 이름을 사용할 수도 있습니다. LoRA 가중치가 사전 훈련된 모델에 통합된 경우 이 매개변수를 제공할 필요가 없습니다.--tokenizer_path {tokenizer_path} : 해당 토크나이저가 저장되는 디렉터리입니다. 이 매개변수가 제공되지 않으면 기본값은 --base_model과 동일합니다.--template_name : vicuna , alpaca 등과 같은 템플릿 이름입니다. 이 매개변수가 제공되지 않으면 기본값은 vicuna입니다.--interactive : 스트리밍 추론을 사용하여 대화형으로 여러 라운드의 Q&A를 시작합니다.--data_file {file_name} : 비대화형 모드에서 시작하는 경우 일괄 예측을 위해 file_name의 내용을 읽습니다.--output_file {file_name} : 비대화형 모드에서는 예측 결과를 jsonl 형식으로 file_name에 씁니다.--resize_emb : 임베딩 크기를 조정할지 여부. 그렇지 않은 경우 사전 학습된 모델의 임베딩 크기를 사용합니다. 기본값은 조정하지 않는 것입니다.--only_cpu : 추론에만 CPU를 사용합니다.--gpus {gpu_ids} : 사용된 GPU 장치 번호를 지정합니다. 기본값은 0입니다. 여러 개의 GPU를 사용하는 경우 0,1,2와 같이 쉼표로 구분하세요. 다중 카드 데이터 병렬성, 일괄 추론

CUDA_VISIBLE_DEVICES=0,1 torchrun --nproc_per_node 2 inference_multigpu_demo.py --model_type baichuan --base_model shibing624/vicuna-baichuan-13b-chatbash run_Multi-GPUs-deployment.shshibing624/vicuna-baichuan-13b-chat 추론 예:

| 인간 | 어시스턴트 |

|---|---|

| 아이가 열이 나면 어떻게 해야 할까요? | 발열은 감염이나 기타 질병에 대한 신체의 자연스러운 반응입니다. 발열 증상을 완화하는 데 도움이 되는 몇 가지 제안 사항은 다음과 같습니다. 1. 수분 섭취: 열이 나면 몸에서 수분이 손실되므로 수분을 유지해야 합니다. 2. 얼음주머니를 사용하세요: 이마나 목에 얼음주머니를 대고 있으면 체온을 낮추는 데 도움이 됩니다. 3. 해열제를 사용하십시오: 해열제는 체온을 낮추는 데 도움이 됩니다. 4. 체온 유지: 체온을 유지하면 체온을 낮추는 데 도움이 됩니다. 5. 찬물이나 따뜻한 물로 몸 닦기 : 찬물이나 따뜻한 물로 몸을 닦는 것은 체온을 낮추는 데 도움이 됩니다. 6. 해열제를 사용하십시오. 해열제는 체온을 낮추는 데 도움이 됩니다. 7. 체온 유지: 체온을 유지하면 체온을 낮추는 데 도움이 됩니다. 8. 찬물이나 따뜻한 물로 몸 닦기 : 찬물이나 따뜻한 물로 몸을 닦는 것은 체온을 낮추는 데 도움이 됩니다. 9. 해열제를 사용하십시오. 해열제는 체온을 낮추는 데 도움이 됩니다. 10. 체온 유지: 체온을 유지하면 체온을 낮추는 데 도움이 됩니다. |

| 한 살짜리 아기가 열이 나면 어떤 약을 먹어도 되나요? | 1세 아기가 열이 나면 다음 약물을 고려할 수 있습니다. 1. 해열제: 이부프로펜이나 파라세타몰 등. 이 약은 체온을 낮추고 발열 증상을 완화하는 데 도움이 될 수 있습니다. 2. 항생제: 세균 감염으로 인해 발열이 발생한 경우 항생제 치료를 고려할 수 있습니다. 단, 반드시 의사의 지시에 따라 사용하시기 바랍니다. 3. 항바이러스제: 바이러스 감염으로 인해 발열이 발생한 경우 항바이러스제를 고려할 수 있습니다. 단, 반드시 의사의 지시에 따라 사용하시기 바랍니다. 4. 해열진통제: 아스피린, 파라세타몰 등. 이 약들은 발열 증상을 완화하는 데 도움이 될 수 있습니다. 5. 항히스타민제: 디펜히드라민이나 펙소페나딘(나프록센) 등. 이 약들은 발열 증상을 완화하는 데 도움이 될 수 있습니다. 의사의 조언에 따라 이러한 약품을 사용하고 패키지 삽입물에 있는 복용량 및 사용법 지침을 따르십시오. 동시에, 아기에게 충분한 수분을 공급하고 충분한 휴식을 취하도록 하십시오. |

| 항문 병변은 어떤 질병의 증상일 수 있습니까? | 항문 병변은 감염, 염증, 종양 또는 기타 질병을 포함한 다양한 원인으로 인해 발생할 수 있습니다. 일반적인 항문 병변은 다음과 같습니다. 1. 항문 균열: 이것은 일반적으로 변비나 기타 스트레스 요인으로 인해 발생하는 항문 피부의 찢어짐입니다. 2. 항문 누공: 항문 피부와 직장 사이에 누공이 형성되는 항문 감염입니다. 3. 항문 사마귀: 항문 피부에 형성되는 사마귀 같은 병변으로, 일반적으로 인유두종 바이러스(HPV)에 의해 발생합니다. 4. 항문 농양: 이는 항문 피부 아래에 농양이 형성되는 항문 감염입니다. 5. 항문 종양: 항문 피부나 직장에 형성되는 종양입니다. 6. 항문 궤양: 항문 피부에 형성되는 궤양으로, 대개 감염이나 염증으로 인해 발생합니다. 7. 항문 가려움증: 항문 피부가 가려워지는 증상으로 감염, 염증, 기타 질병에 의해 발생할 수 있습니다. 항문 병변의 증상이 나타나면 의료 전문가에게 문의하여 적절한 진단과 치료를 받으십시오. |

| 안녕하세요, 박사님, 왜 백반이 증가하고 노랗게 변합니까? | 안녕하세요. 질 분비물이 증가하고 노란색이 되는 것은 감염, 호르몬 변화, 질 건조증 또는 기타 부인과적 문제를 포함한 다양한 이유로 인해 발생할 수 있습니다. 가능한 이유는 다음과 같습니다. 1. 감염: 질 분비물이 증가하고 황색을 띠는 것은 질 또는 요로 감염으로 인해 발생할 수 있습니다. 감염은 박테리아, 바이러스 또는 곰팡이에 의해 발생할 수 있습니다. 2. 호르몬 변화: 월경주기나 폐경기 등의 호르몬 변화로 인해 질 분비물이 증가하고 황변이 발생할 수 있습니다. 3. 질 건조증: 질 건조증은 질 분비물 증가 및 황변을 유발할 수 있습니다. 4. 기타 부인과 문제: 자궁경부염, 자궁내막염, 자궁내막증과 같은 기타 부인과 문제로 인해 질 분비물이 노란색으로 증가할 수도 있습니다. 백반증이 걱정된다면 산부인과 전문의에게 진찰과 진단을 받는 것이 좋습니다. 의사는 증상과 검사 결과에 따라 원인을 파악하고 적절한 치료를 제공할 수 있습니다. |

| 의료낙태 후 초콜릿 백반이 나타난다면, 낙태가 깨끗하지 않아서일까요? | 의료 낙태 후 초콜릿 백반증이 발생한다고 해서 반드시 낙태가 깨끗하지 않았다는 의미는 아닙니다. 초콜릿 백반증은 자궁 내막의 탈락과 출혈로 인해 발생하며 일반적으로 약물 낙태 후 일정 기간 내에 발생합니다. 의료 낙태 후 초콜릿 백반증의 원인은 다음과 같습니다. 1. 자궁내막 탈락: 의료 낙태 후 자궁내막이 탈락되어 출혈이 발생합니다. 이 출혈은 초콜릿 백혈병으로 나타날 수 있습니다. 2. 감염: 약물에 의한 낙태 후 자궁내막과 자궁경부가 손상되어 세균 감염에 취약할 수 있습니다. 감염으로 인해 초콜릿 질 분비물이 발생할 수 있습니다. 3. 호르몬 수치의 변화: 의료 낙태 후 호르몬 수치가 변화하여 초콜릿 백혈병으로 이어질 수 있습니다. 초콜릿 백반증이 장기간 지속되거나 복통, 발열, 분비물 특유의 냄새 등 다른 증상이 동반되는 경우에는 제때에 진료를 받고 산부인과 검진, B-초음파 등으로 감염 여부나 기타 문제가 있는지 확인합니다. 의사의 지도하에 적절한 치료를 실시합니다. |

| 비타민 E 크림은 어떤 질병을 치료할 수 있나요? | 비타민E 크림은 여드름, 지루성 피부염 등의 피부질환 치료에 주로 사용되는 외용제다. 피부 오일 생성을 줄이고 염증을 줄이며 피부 회복을 촉진하는 데 도움이 될 수 있습니다. 비타민 E 크림은 만병통치약이 아니며 특정 피부 질환에는 적합하지 않을 수 있다는 점에 유의해야 합니다. 사용하기 전에 약물의 적응증, 금기 사항, 사용법 및 복용량을 이해하기 위해 의사 또는 약사와 상담하는 것이 좋습니다. 동시에 약물을 사용할 때는 스스로 남용되는 것을 피하기 위해 의사의 지시를 따라야 합니다. |

| 여드름의 원인은 무엇입니까? | 여드름이라고도 불리는 여드름은 피부의 모공이 막혀 발생합니다. 모공이 막히는 원인은 다음과 같이 다양합니다. 1. 피지선의 과잉 활동: 피지선에서 피지가 너무 많이 생성되어 모공이 막히게 됩니다. 2. 막힌 모공 : 피부 표면의 죽은 피부 세포, 유분, 박테리아가 모공을 막습니다. 3. 염증: 여드름은 종종 염증을 동반하는데, 이는 피부 감염이나 여드름에 대한 면역 체계의 반응으로 인해 발생할 수 있습니다. 4. 유전적 요인: 일부 사람들은 유전적 요인으로 인해 여드름에 더 취약할 수 있습니다. 5. 호르몬 변화: 여드름은 사춘기와 월경 중에 더 흔히 발생하며, 이는 호르몬 변화로 인해 발생할 수 있습니다. 6. 생활 습관 요인: 스트레스, 잘못된 식습관, 운동 부족과 같은 특정 생활 습관 요인도 여드름을 유발할 수 있습니다. 7. 화장품 및 스킨케어 제품: 특정 화장품 및 스킨케어 제품, 특히 자극적인 성분이 함유된 제품은 여드름을 유발할 수 있습니다. 8. 약물: 경구 피임약과 같은 특정 약물도 여드름을 유발할 수 있습니다. 여드름을 예방하려면 피부를 깨끗하게 유지하고, 순한 스킨케어 제품을 사용하고, 화장품과 스킨케어 제품의 과도한 사용을 피하고, 건강한 생활방식과 식습관을 유지하고, 스트레스와 호르몬 변화를 피하는 등의 조치를 취하면 됩니다. 여드름이 심하다면 피부과 전문의의 도움을 받아야 할 수도 있습니다. |

| 얼굴에 여드름이 났을 때 대처법, 복용할 수 있는 약, 주의할 점 | 여드름이라고도 불리는 여드름은 흔한 피부질환입니다. 여드름 치료는 식습관, 생활습관, 약물치료 등 다양한 측면을 종합적으로 고려해야 합니다. 다음은 몇 가지 제안 사항입니다. 1. 다이어트: * 패스트푸드, 디저트, 튀긴 음식 등 설탕, 지방, 기름이 많이 함유된 음식은 피하세요. * 섬유질 섭취를 늘리고 장 연동운동을 촉진하려면 신선한 야채, 과일, 통곡물을 더 많이 섭취하세요. * 카페인, 알코올, 매운 음식, 기타 자극적인 음식을 너무 많이 섭취하지 마십시오. 2. 생활습관: * 좋은 수면 일정을 유지하고 충분한 수면을 취하십시오. * 피부에 방사선 자극을 피하기 위해 컴퓨터, 휴대폰 등 전자 제품을 장시간 사용하지 마십시오. * 매일 아침 저녁으로 피부를 깨끗하게 유지하고 순한 클렌저를 사용하세요. * 감염과 흉터를 피하기 위해 여드름을 짜내지 마십시오. 3. 약물: * 국소 약물: 살리실산, 벤조산, 아젤라산 및 기타 성분이 함유된 스킨케어 제품을 사용하면 피부 표면의 죽은 피부 세포를 제거하고 여드름 형성을 줄이는 데 도움을 줄 수 있습니다. * 경구용 약물 : 여드름이 심할 경우 경구용 항생제, 비타민 B 복합체, 아연 등의 약물을 고려할 수 있으나 반드시 의사의 지도하에 사용해야 합니다. 4. 참고: * 피부에 자극이 가지 않도록 화장품, 스킨케어 제품을 함부로 사용하지 마세요. * 피부 장벽이 손상될 수 있으므로 피부를 과도하게 클렌징하지 마십시오. * 기분을 편안하게 유지하고 불안, 우울 등 부정적인 감정을 피하십시오. 즉, 여드름 치료는 식습관, 생활습관, 약물치료 등 여러 측면을 종합적으로 고려해야 합니다. 치료 과정에서는 인내심을 갖고 자신감을 갖고 의사의 지시를 따르며 점차적으로 피부 상태를 개선해 나가십시오. |

| 정관이 막히면 남성 불임이 유발되나요? 안녕하세요, 선생님, 제 동료가 요즘 기분이 좋지 않냐고 물었더니 남편의 정관이 막혀서 아이를 낳지 않으려는 게 아니라고 하더군요. 디페렌이 남성불임의 원인이 되나요? | 정관이 막히면 남성 불임이 발생할 수 있습니다. 정관은 고환과 요도를 연결하고 고환에서 요도로 정자를 운반하는 관입니다. 정관이 막히면 정자가 정관을 통과하여 요도에 도달할 수 없어 불임이 발생합니다. 정관이 막히는 원인은 선천적 발달 이상, 염증, 종양, 외상 등 여러 가지가 있습니다. 정관 폐쇄의 치료 방법에는 수술적 차단 해제와 약물 치료가 있습니다. 정관이 심하게 막힌 경우 이를 제거하기 위해 수술이 필요할 수 있습니다. 정자가 여성의 몸으로 운반될 수 있는 다른 방법이 있기 때문에 정관이 막힌다고 해서 반드시 불임으로 이어지는 것은 아니라는 점에 유의하는 것이 중요합니다. 예를 들어, 정자는 부고환이나 전립선과 같은 조직을 통해 여성의 신체에 도달할 수 있습니다. 따라서 정관이 막힌 경우에는 즉시 진료를 받고 전문의의 도움을 받는 것이 좋습니다. |

| 심근경색을 치료할 수 있나요? | 심근경색은 즉시 치료하면 생명을 구하고 장기적인 장애를 예방할 수 있는 심각한 질환입니다. 심근경색 치료의 핵심은 조기 발견과 치료입니다. 심근경색의 치료에는 일반적으로 다음 단계가 포함됩니다. 1. 즉시 진료를 받으세요. 흉통, 호흡곤란, 실신 등의 증상이 나타나면 즉시 진료를 받으세요. 2. 약물 치료: 의사는 증상을 완화하고 추가 손상을 예방하기 위해 니트로글리세린이나 아스피린과 같은 약물을 처방할 수 있습니다. 3. 혈전용해요법: 환자가 병원에 도착하기 전에 심근경색이 있는 경우, 의사는 혈류 회복을 돕기 위해 혈전을 용해시키는 약물을 주사하는 혈전용해요법을 시행할 수 있습니다. 4. 수술적 치료: 약물 치료나 혈전용해 치료가 실패할 경우 의사는 관상동맥우회술이나 심장 스텐트 이식과 같은 수술을 권할 수 있습니다. 5. 재활 및 예방: 심근경색 치료에는 환자가 신체 기능을 회복하고 향후 심장 질환을 예방하는 데 도움이 되는 재활 프로그램이 포함되는 경우가 많습니다. 또한 환자는 심장병 위험을 줄이기 위해 의사의 권고를 따라야 합니다. 심근경색의 치료는 환자의 구체적인 상태와 증상에 따라 달라진다는 점을 기억하는 것이 중요합니다. 그러므로 본인이나 아는 사람이 심근경색 증상을 보인다면 즉시 진료를 받으세요. |

| 활력을 유지하는 방법, 여기 5가지 제안이 있습니다. | 1. 충분한 수면을 취하세요. 수면은 에너지 수준을 높게 유지하는 데 중요합니다. 매일 밤 7~9시간의 양질의 수면을 취하세요. 2. 균형 잡힌 식단을 섭취하세요: 균형 잡힌 식단은 에너지 수준을 유지하는 데 필수적입니다. 충분한 단백질, 탄수화물, 건강한 지방을 섭취하세요. 3. 규칙적인 운동: 규칙적인 운동은 에너지 수준을 높이는 데 도움이 될 수 있습니다. 걷기, 달리기, 자전거 타기 등 매일 30분 이상 유산소 운동을 하십시오. 4. 스트레스 관리: 스트레스는 에너지를 소모하므로 에너지 수준을 높게 유지하려면 스트레스를 관리하는 것이 중요합니다. 명상, 요가, 심호흡 운동 등 긴장을 풀고 스트레스를 줄이는 방법을 찾아보세요. 5. 수분 공급: 탈수는 에너지 수준을 낮출 수 있습니다. 매일 충분한 물을 마시고 필요에 따라 수분을 보충하십시오. |

| 봄의 시를 쓰다 | 봄, 땅이 깨어나는 계절, 만물이 부흥하는 계절입니다. 생명이 꽃피는 계절입니다. 봄, 화창한 계절이군요, 새소리와 향기로운 꽃이 피어나는 계절, 푸르름이 짙어지는 계절, 무한한 희망의 계절입니다. 봄, 사람들이 웃는 계절, 아이들이 놀기 좋은 계절, 연인들이 서로를 끌어안는 계절, 사람들이 꿈을 쫓는 계절입니다. |

| 남극에는 왜 북극곰이 없나요? | 남극에는 북극곰이 없습니다. 왜냐하면 북극곰은 북극 지역에 살고 있는 반면, 남극은 남반구에 위치하고 있으며 기후와 환경이 북극 지역과 많이 다르기 때문입니다. 남극은 기후가 매우 춥고 일년 내내 얼음과 눈으로 덮여 있는 반면, 해양 생물과 육지 포유류가 풍부한 북극에는 북극곰이 살고 있습니다. 게다가 남극의 생태계는 북극과 다르며 북극곰이 요구하는 생존 조건도 갖추고 있지 않습니다. |

본 프로젝트는 연구 목적으로만 사용될 수 있으며, 본 프로젝트의 이용으로 인해 발생하는 피해나 손실(데이터, 모델, 코드 등을 포함하되 이에 국한되지 않음)에 대해 프로젝트 개발자는 책임을 지지 않습니다. 자세한 내용은 면책 조항을 참조하십시오.

MedicalGPT 프로젝트 코드에 대한 라이센스 계약은 The Apache License 2.0입니다. 해당 코드는 상업적 목적으로 무료로 사용할 수 있으며, 모델 가중치와 데이터는 연구 목적으로만 사용할 수 있습니다. 제품 설명에 MedicalGPT 링크와 라이선스 계약을 첨부해주세요.

연구에 MedicalGPT를 사용하는 경우 다음 형식으로 인용해 주세요.

@misc{MedicalGPT,

title={MedicalGPT: Training Medical GPT Model},

author={Ming Xu},

year={2023},

howpublished={ url {https://github.com/shibing624/MedicalGPT}},

}프로젝트 코드는 아직 매우 미숙합니다. 코드에 개선 사항이 있으면 제출하기 전에 다음 두 가지 사항에 주의하시기 바랍니다.

tests 에 해당 단위 테스트 추가python -m pytest 사용하여 모든 단위 테스트를 실행하여 모든 단위 테스트가 통과하는지 확인하세요.그런 다음 PR을 제출할 수 있습니다.

그들의 훌륭한 작업에 감사드립니다!