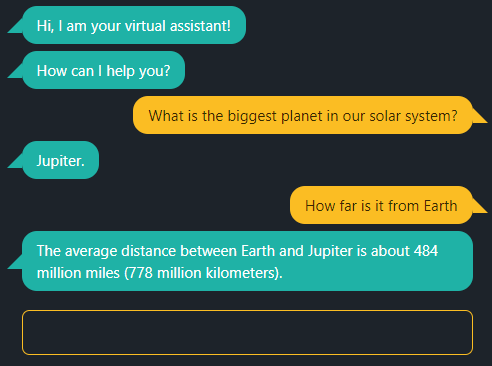

tinker chat

1.0.0

이 채팅 앱은 OpenAI 또는 자체 로컬 LLM의 GPT를 지원합니다.

OpenAI에서 GPT를 사용하려면 환경 변수 OPENAI_API_KEY API 키로 설정하세요.

추론 엔진과 함께 llama.cpp를 로컬에서 활용하려면 먼저 Phi-3 Mini와 같은 양자화 모델을 로드하세요. 예:

/path/to/llama.cpp/server -m Phi-3-mini-4k-instruct-q4.gguf 데모를 시작하기 전에 OPENAI_API_BASE 환경 변수를 설정하십시오.

export OPENAI_API_BASE=http://127.0.0.1:8080Node.js >= v18 사용:

npm install

npm start

웹 브라우저로 localhost:5000 엽니다.