또 다른 대체 얼굴 감지기를 추가했습니다: https://github.com/1adrianb/face-alignment

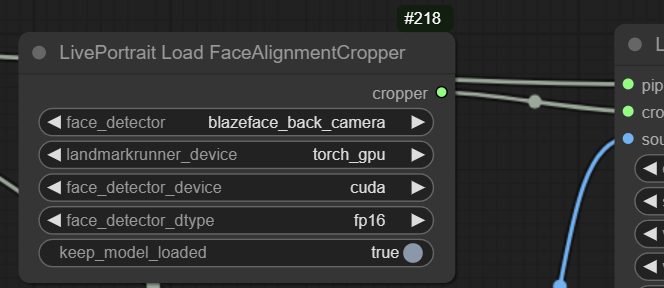

이는 blazeface 후면 카메라 모델(또는 SFD)을 사용할 수 있으므로 blazeface short 모델만 사용할 수 있는 MediaPipe보다 작은 얼굴에 훨씬 더 좋습니다. 이 기능을 사용하면 첫 번째 실행 시 워밍업 시간이 오래 걸릴 수 있지만 이후 실행은 빠릅니다.

blazeface_back_camera를 사용한 감지 예:

개발 중인 거의 모든 작업의 재작업이 이제 메인에 병합되었습니다. 즉, 이전 작업 흐름은 작동하지 않지만 모든 것이 더 빨라지고 새로운 기능이 많이 추가되어야 함을 의미합니다. 레거시 목적을 위해 이전 기본 브랜치가 레거시 -branch로 이동되었습니다.

변경 사항

Insightface의 대안으로 MediaPipe를 추가했습니다. 이제 이를 사용할 때 모든 것이 MIT 및 Apache-2.0 라이선스에 따라 보호되어야 합니다.

스무딩 알고리즘을 포함한 적절한 Vid2vid(@melMass에게 감사드립니다)

향상된 속도와 효율성으로 Comfy에서도 거의 실시간으로 볼 수 있습니다(~80-100ms 지연).

더 많은 옵션을 위해 재구성된 노드

얼굴이 감지되지 않은 상태에서 프레임 자동 건너뛰기

이 시점에서 내가 잊어버린 수많은 다른 일들, 정말 많은 일이 일어났습니다.

MPS에서 더 나은 Mac 지원(@Grant-CP에게 감사드립니다)

이 업데이트로 업데이트:

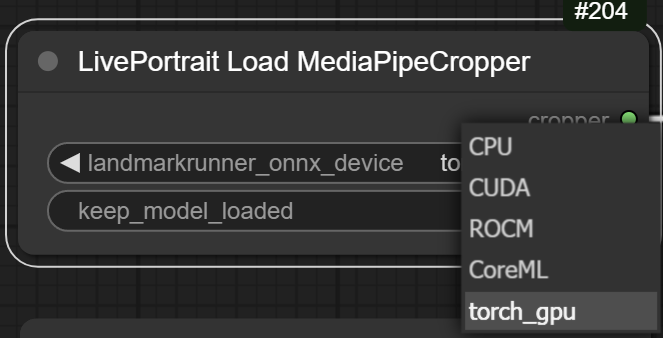

랜드마크 러너 onnx 모델을 토치 모델로 변환했습니다. 이전에 수행한 작업이 아니었고 .pth 파일로 만드는 것 외에는 아무것도 할 수 없었으므로 저를 믿으시면 됩니다. 이를 통해 onnxruntime 없이도 이 모든 것을 실행할 수 있으며 GPU에서 실행되며 속도도 거의 같습니다. MediaPipe 자르기 노드에서 옵션으로 사용할 수 있습니다. 선택하면 여기에서 자동으로 다운로드됩니다: https://huggingface.co/Kijai/LivePortrait_safetensors/blob/main/landmark_model.pth

웹캠 피드를 통한 실시간:

이미지2vid:

Vid2Vid:

모든 피클 파일을 safetensors로 변환했습니다: https://huggingface.co/Kijai/LivePortrait_safetensors/tree/main

여기로 이동합니다(폴더가 없으면 자동으로 다운로드됩니다). ComfyUI/models/liveportrait

원래 기본 Insightface 또는 Google의 MediaPipe를 사용할 수 있습니다.

가장 큰 차이점은 라이센스입니다. Insightface는 엄격히 비상업적 용도로만 사용됩니다. MediaPipe는 감지 성능이 약간 떨어지며 Windows의 GPU에서는 실행할 수 없지만 Insightface에 비해 CPU에서는 훨씬 빠릅니다.

Insightface는 자동으로 설치되지 않습니다. 사용하려면 다음 지침을 따르십시오. 작동하는 컴파일 환경이 있는 경우 설치는 다음과 같이 쉽습니다.

pip install insightface

또는 휴대용 버전의 경우 ComfyUI_windows_portable -폴더에 있습니다.

python_embeded/python.exe -m pip install insightface

이것이 실패할 가능성이 있는 경우 리액터 노드의 문제 해결 부분에서 대안을 확인할 수 있습니다.

https://github.com/Gourieff/comfyui-reactor-node

Insightface 모델의 경우 이를 ComfyUI/models/insightface/buffalo_l 로 추출합니다.

https://github.com/deepinsight/insightface/releases/download/v0.7/buffalo_l.zip

Insightface 라이센스는 본질적으로 비상업적입니다.