[읽어보기] [?HF Repo] [?웹 버전]

중국어 |

[2024.03.28] 모든 모델과 데이터는 매직 커뮤니티에 업로드됩니다.

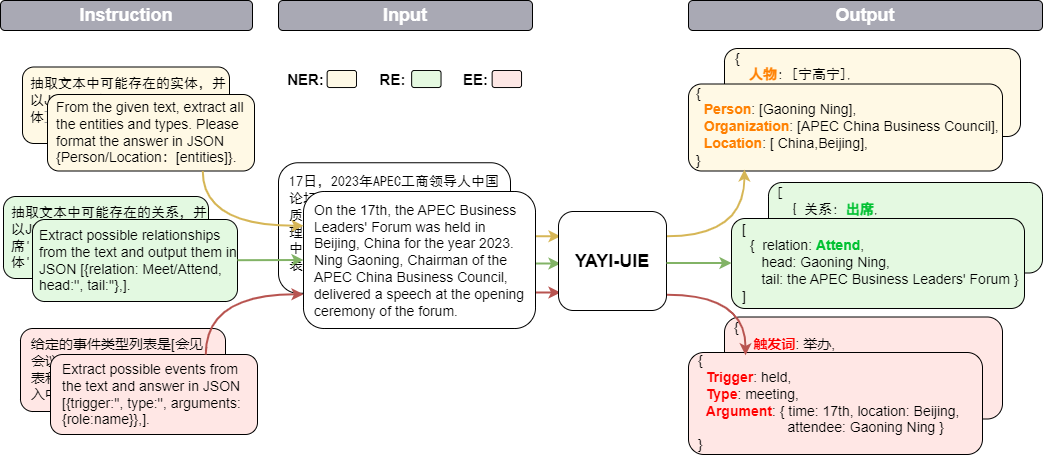

Yayi Information Extraction Unified Large Model(YAYI-UIE)은 수동으로 구성된 수백만 개의 고품질 정보 추출 데이터에 대한 지침을 미세 조정합니다. 통합 훈련 정보 추출 작업에는 명명된 엔터티 인식(NER), 관계 추출(RE) 및 이벤트 추출( EE)는 일반적으로 보안, 금융, 생물학, 의료, 상업, 개인, 차량, 영화, 산업, 레스토랑, 과학 및 기타 시나리오에서 구조화된 추출을 달성합니다.

Yayi UIE 대형 모델의 오픈 소스를 통해 우리는 중국의 사전 학습된 대형 모델 오픈 소스 커뮤니티의 발전을 촉진하기 위한 자체 노력에 기여할 것입니다. 오픈 소스를 통해 모든 파트너와 함께 Yayi 대형 모델 생태계를 구축할 것입니다. 기술적인 세부 사항에 대한 자세한 내용은 기술 보고서 YAYI-UIE: 범용 정보 추출을 위한 채팅 강화 명령 조정 프레임워크를 참조하세요.

| 이름 | ?HF 모델 식별 | 주소 다운로드 | 매직 모델 로고 | 주소 다운로드 |

|---|---|---|---|---|

| 야이우이에 | wenge-연구/yayi-uie | 모델 다운로드 | wenge-연구/yayi-uie | 모델 다운로드 |

| YAYI-UIE 데이터 | wenge-연구/yayi_uie_sft_data | 데이터 세트 다운로드 | wenge-연구/yayi_uie_sft_data | 데이터 세트 다운로드 |

백만개 수준의 말뭉치 중 54%는 중국어이고 46%는 영어입니다. 데이터 세트에는 금융, 사회, 생물학, 상업, 산업 제조, 화학, 차량, 과학, 질병 및 의료, 개인 생활, 보안 등 12개 분야가 포함됩니다. 그리고 일반. 수백 가지 시나리오를 다룹니다.

git clone https://github.com/wenge-research/yayi-uie.git

cd yayi-uieconda create --name uie python=3.8

conda activate uiepip install -r requirements.txt torch 및 transformers 버전은 권장 버전보다 낮지 않는 것이 좋습니다.

이 모델은 Huggingface 모델 저장소에 오픈 소스로 제공되어 있으므로 다운로드하여 사용할 수 있습니다. 다음은 다운스트림 작업 추론을 위해 단순히 YAYI-UIE 호출하는 샘플 코드입니다. 이는 A100/A800과 같은 단일 GPU에서 실행될 수 있습니다. bf16 정밀 추론을 사용할 경우 약 33GB의 비디오 메모리를 차지합니다.

> >> import torch

> >> from transformers import AutoModelForCausalLM , AutoTokenizer

> >> from transformers . generation . utils import GenerationConfig

> >> tokenizer = AutoTokenizer . from_pretrained ( "wenge-research/yayi-uie" , use_fast = False , trust_remote_code = True )

> >> model = AutoModelForCausalLM . from_pretrained ( "wenge-research/yayi-uie" , device_map = "auto" , torch_dtype = torch . bfloat16 , trust_remote_code = True )

> >> generation_config = GenerationConfig . from_pretrained ( "wenge-research/yayi-uie" )

> >> prompt = "文本:氧化锆陶瓷以其卓越的物理和化学特性在多个行业中发挥着关键作用。这种材料因其高强度、高硬度和优异的耐磨性,广泛应用于医疗器械、切削工具、磨具以及高端珠宝制品。在制造这种高性能陶瓷时,必须遵循严格的制造标准,以确保其最终性能。这些标准涵盖了从原材料选择到成品加工的全过程,保障产品的一致性和可靠性。氧化锆的制造过程通常包括粉末合成、成型、烧结和后处理等步骤。原材料通常是高纯度的氧化锆粉末,通过精确控制的烧结工艺,这些粉末被转化成具有特定微观结构的坚硬陶瓷。这种独特的微观结构赋予氧化锆陶瓷其显著的抗断裂韧性和耐腐蚀性。此外,氧化锆陶瓷的热膨胀系数与铁类似,使其在高温应用中展现出良好的热稳定性。因此,氧化锆陶瓷不仅在工业领域,也在日常生活中的应用日益增多,成为现代材料科学中的一个重要分支。 n抽取文本中可能存在的实体,并以json{制造品名称/制造过程/制造材料/工艺参数/应用/生物医学/工程特性:[实体]}格式输出。"

> >> # "<reserved_13>" is a reserved token for human, "<reserved_14>" is a reserved token for assistant

>> > prompt = "<reserved_13>" + prompt + "<reserved_14>"

> >> inputs = tokenizer ( prompt , return_tensors = "pt" ). to ( model . device )

> >> response = model . generate ( ** inputs , max_new_tokens = 512 , temperature = 0 )

> >> print ( tokenizer . decode ( response [ 0 ], skip_special_tokens = True ))메모:

文本:xx

【实体抽取】抽取文本中可能存在的实体,并以json{人物/机构/地点:[实体]}格式输出。

文本:xx

【关系抽取】已知关系列表是[注资,拥有,纠纷,自己,增持,重组,买资,签约,持股,交易]。根据关系列表抽取关系三元组,按照json[{'relation':'', 'head':'', 'tail':''}, ]的格式输出。

文本:xx

抽取文本中可能存在的关系,并以json[{'关系':'会见/出席', '头实体':'', '尾实体':''}, ]格式输出。

文本:xx

已知论元角色列表是[时间,地点,会见主体,会见对象],请根据论元角色列表从给定的输入中抽取可能的论元,以json{角色:论元}格式输出。

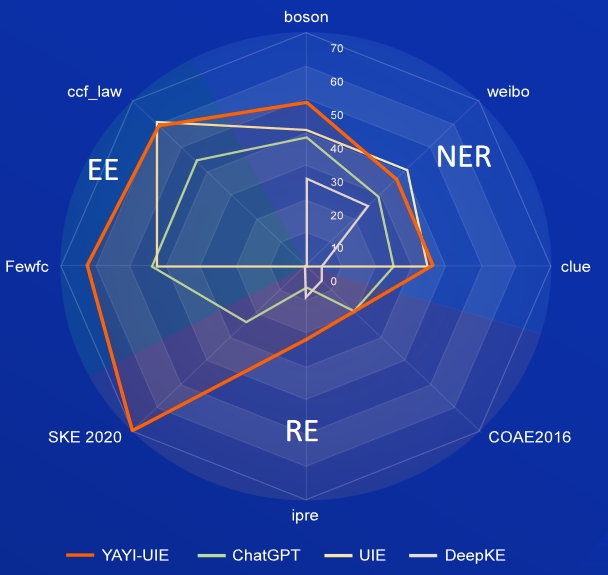

AI, Literature, Music, Politics, Science는 영어 데이터셋이고, Boson, Clue, Weibo는 중국어 데이터셋입니다.

| 모델 | 일체 포함 | 문학 | 음악 | 정치 | 과학 | 영어 평균 | 보손 | 단서 | 웨이보 | 중국 평균 |

|---|---|---|---|---|---|---|---|---|---|---|

| 다빈치 | 2.97 | 9.87 | 13.83 | 18.42 | 10.04 | 11.03 | - | - | - | 9월 31일 |

| 채팅GPT 3.5 | 54.4 | 54.07 | 61.24 | 59.12 | 63 | 58.37 | 38.53 | 25.44 | 29.3 | |

| UIE | 14.31 | 38.97 | 33.91 | 46.28 | 41.56 | 38.37 | 40.64 | 34.91 | 40.79 | 38.78 |

| USM | 18.28 | 56 | 44.93 | 36.1 | 44.09 | 41.86 | - | - | - | - |

| InstructUIE | 49 | 47.21 | 53.16 | 48.15 | 49.3 | 49.36 | - | - | - | - |

| KnowLM | 13.76 | 20.18 | 14.78 | 33.86 | 9.19 | 18.35 | 25.96 | 4.44 | 25.2 | 18.53 |

| 야이우이에 | 52.4 | 45.99 | 51.2 | 51.82 | 50.53 | 50.39 | 49.25 | 36.46 | 36.78 | 40.83 |

FewRe, Wiki-ZSL은 영어 데이터 세트, SKE 2020, COAE2016, IPRE는 중국어 데이터 세트입니다.

| 모델 | 거의 Rel | 위키-ZSL | 영어 평균 | SKE 2020 | COAE2016 | IPRE | 중국 평균 |

|---|---|---|---|---|---|---|---|

| 채팅GPT 3.5 | 9.96 | 13.14 | 11.55 24.47 | 19.31 | 6.73 | 16.84 | |

| ZETT(T5-소형) | 30.53 | 31.74 | 14.31 | - | - | - | - |

| ZETT(T5 베이스) | 33.71 | 17.31 | 32.44 | - | - | - | - |

| InstructUIE | 39.55 | 35.2 | 37.38 | - | - | - | - |

| KnowLM | 17.46 | 15.33 | 16.40 | 0.4 | 6.56 | 9.75 | 5.57 |

| 야이우이에 | 09.36 | 41.07 | 38.58 | 70.8 | 19.97 | 22.97 | 37.91 |

상품 뉴스는 영어 데이터 세트, FewFC, ccf_law는 중국 데이터 세트입니다.

EET(이벤트 유형 식별)

| 모델 | 상품 뉴스 | FewFC | ccf_law | 중국 평균 |

|---|---|---|---|---|

| 채팅GPT 3.5 | 1.41 | 16.15 | 0 | 8.08 |

| UIE | - | 50.23 | 2.16 | 26.20 |

| InstructUIE | 23.26 | - | - | - |

| 야이우이에 | 12.45 | 81.28 | 12.87 | 47.08 |

EEA(이벤트 인수 추출)

| 모델 | 상품 뉴스 | FewFC | ccf_law | 중국 평균 |

|---|---|---|---|---|

| 채팅GPT 3.5 | 8.6 | 44.4 | 44.57 | 44.49 |

| UIE | - | 43.02 | 60.85 | 51.94 |

| InstructUIE | 21.78 | - | - | - |

| 야이우이에 | 19.74 | 63.06 | 59.42 | 61.24 |

현재 데이터와 기본 모델을 기반으로 훈련된 SFT 모델은 효율성 측면에서 여전히 다음과 같은 문제를 안고 있습니다.

위의 모델 제한 사항에 따라 개발자는 이 프로젝트에서 생성된 오픈 소스 코드, 데이터, 모델 및 후속 파생물을 연구 목적으로만 사용해야 하며 상업적 목적이나 사회에 해를 끼칠 수 있는 기타 용도로는 사용할 수 없습니다. 야이빅모델이 생성한 콘텐츠를 식별 및 이용하는데 주의해 주시고, 생성된 유해 콘텐츠를 인터넷에 유포하지 마시기 바랍니다. 불리한 결과가 발생할 경우, 책임은 전달자에게 있습니다. 본 프로젝트는 연구 목적으로만 사용될 수 있으며, 본 프로젝트의 이용으로 인해 발생하는 피해나 손실(데이터, 모델, 코드 등을 포함하되 이에 국한되지 않음)에 대해 프로젝트 개발자는 책임을 지지 않습니다. 자세한 내용은 면책 조항을 참조하십시오.

본 프로젝트의 코드와 데이터는 Apache-2.0 프로토콜에 따른 오픈 소스입니다. 커뮤니티에서 YAYI UIE 모델 또는 그 파생 모델을 사용하는 경우 Baichuan2의 커뮤니티 계약 및 상업 계약을 따르십시오.

작업에 우리 모델을 사용하는 경우 다음 논문을 인용할 수 있습니다.

@article{YAYI-UIE,

author = {Xinglin Xiao, Yijie Wang, Nan Xu, Yuqi Wang, Hanxuan Yang, Minzheng Wang, Yin Luo, Lei Wang, Wenji Mao, Dajun Zeng}},

title = {YAYI-UIE: A Chat-Enhanced Instruction Tuning Framework for Universal Information Extraction},

journal = {arXiv preprint arXiv:2312.15548},

url = {https://arxiv.org/abs/2312.15548},

year = {2023}

}