PALM E

0.0.4

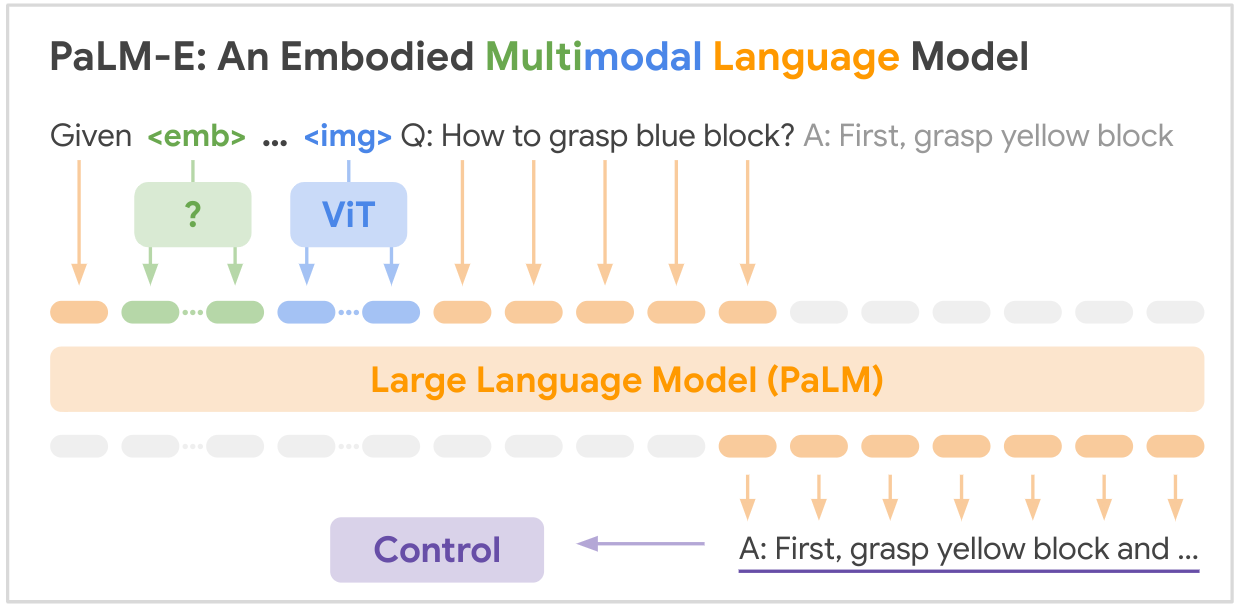

이는 Google의 SOTA 다중 모드 기반 모델 "PALM-E: 구현된 다중 모드 언어 모델"의 오픈 소스 구현입니다. PALM-E는 다음과 같은 다양한 구현 추론 작업을 처리할 수 있는 단일 대규모 구현 다중 모드 모델입니다. 여러 실시예에서 다양한 관찰 양식은 긍정적인 전달을 보여줍니다. 모델은 인터넷 규모의 언어, 비전 및 시각적 언어 영역에 걸친 다양한 공동 훈련의 이점을 얻습니다.

논문 링크: PaLM-E: 구현된 다중 모드 언어 모델

pip install palme import torch

from palme . model import PalmE

#usage

img = torch . randn ( 1 , 3 , 256 , 256 )

caption = torch . randint ( 0 , 20000 , ( 1 , 1024 ))

model = PalmE ()

output = model ( img , caption )

print ( output . shape ) # (1, 1024, 20000)

다음은 논문에 언급된 주요 데이터 세트의 요약 표입니다.

| 데이터세트 | 작업 | 크기 | 링크 |

|---|---|---|---|

| 쟁이다 | 로봇 조작 계획, VQA | 96,000개 장면 | 커스텀 데이터세트 |

| 언어표 | 로봇 조작 계획 | 커스텀 데이터세트 | 링크 |

| 모바일 조작 | 로봇 탐색 및 조작 계획, VQA | 2912 시퀀스 | SayCan 데이터세트 기반 |

| 웹리 | 이미지 텍스트 검색 | 66M 이미지-캡션 쌍 | 링크 |

| VQAv2 | 시각적 질문 답변 | COCO 이미지에 대한 110만 개의 질문 | 링크 |

| OK-VQA | 외부 지식이 필요한 시각적 질문 답변 | COCO 이미지에 대한 14,031개의 질문 | 링크 |

| 머리 | 이미지 캡션 | 캡션이 포함된 330,000개의 이미지 | 링크 |

| 위키피디아 | 텍스트 말뭉치 | 해당 없음 | 링크 |

주요 로봇 공학 데이터 세트는 이 작업을 위해 특별히 수집되었으며, 대규모 비전 언어 데이터 세트(WebLI, VQAv2, OK-VQA, COCO)는 해당 분야의 표준 벤치마크입니다. 데이터 세트의 범위는 로봇 공학 도메인의 경우 수만 개부터 인터넷 규모 비전 언어 데이터의 경우 수천만 개에 이릅니다.

당신의 광채가 필요합니다! 우리와 함께 PALM-E를 더욱 경이롭게 만들어 봅시다.

? 수정, ? 개선 사항, 문서, 아이디어 등 모두 환영합니다! AI의 미래를 함께 만들어 갑시다.

@article{driess2023palme,

title={PALM-E: An Embodied Multimodal Language Model},

author={Driess, Danny and Xia, Fei and Sajjadi, Mehdi S. M. and Lynch, Corey and Chowdhery, Aakanksha and Ichter, Brian and Wahid, Ayzaan and Tompson, Jonathan and Vuong, Quan and Yu, Tianhe and Huang, Wenlong and Chebotar, Yevgen and Sermanet, Pierre and Duckworth, Daniel and Levine, Sergey and Vanhoucke, Vincent and Hausman, Karol and Toussaint, Marc and Greff, Klaus and Zeng, Andy and Mordatch, Igor and Florence, Pete},

journal={arXiv preprint arXiv:2303.03378},

year={2023},

url={https://doi.org/10.48550/arXiv.2303.03378}

}