mind your language action

v1.0.3

이 조치는 문제에 대한 주석을 모니터링하고 요청을 당기고 공격적인 언어가 발견되는 경우 발신자에게 상기시킵니다.

저장소의 .github/workflows/ Directory에서 다음 워크 플로 파일 mind-your-language.yml 만듭니다.

name : Mind your language

on :

issues :

types :

- opened

- edited

issue_comment :

types :

- created

- edited

pull_request_review_comment :

types :

- created

- edited

jobs :

echo_issue_comment :

runs-on : ubuntu-latest

name : profanity check

steps :

- name : Checkout

uses : actions/checkout@v2

- name : Profanity check step

uses : tailaiw/[email protected]

env :

GITHUB_TOKEN : ${{ secrets.GITHUB_TOKEN }} 문제 또는 풀 요청에 대한 주석이 생성 될 때마다, 작업 흐름은 댓글 텍스트에 대해 욕설 검사를 수행하고 불쾌감을 느끼는 언어가 발견되면 반응을 취합니다.

나는 현재 머신 러닝을 기반으로 한 욕설 탐지의 파이썬 패키지 인 visanity-check을 사용하여 의견이 불쾌감을 느끼는지 여부를 결정하고 있습니다. 매우 강력하지는 않지만 명백한 공격 언어에 민감합니다. 더 나은 성능을 얻기 위해 최첨단 NLP 알고리즘을 사용하기를 바랍니다. 곧 더 나은 대안을 추구하기 위해 별도의 리포를 만들 것입니다. 관심이 있으시면 계속 지켜봐주십시오.

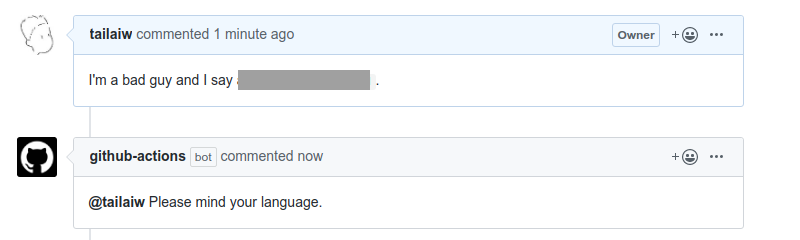

현재 반응은 Github-Actions 봇의 자동 회상입니다. 다음과 같은 예를 참조하십시오.

저는 Github Action의 새로운 개발자이므로 제안과 도움이 환영합니다. 물론 "당신의 언어가 마음"?