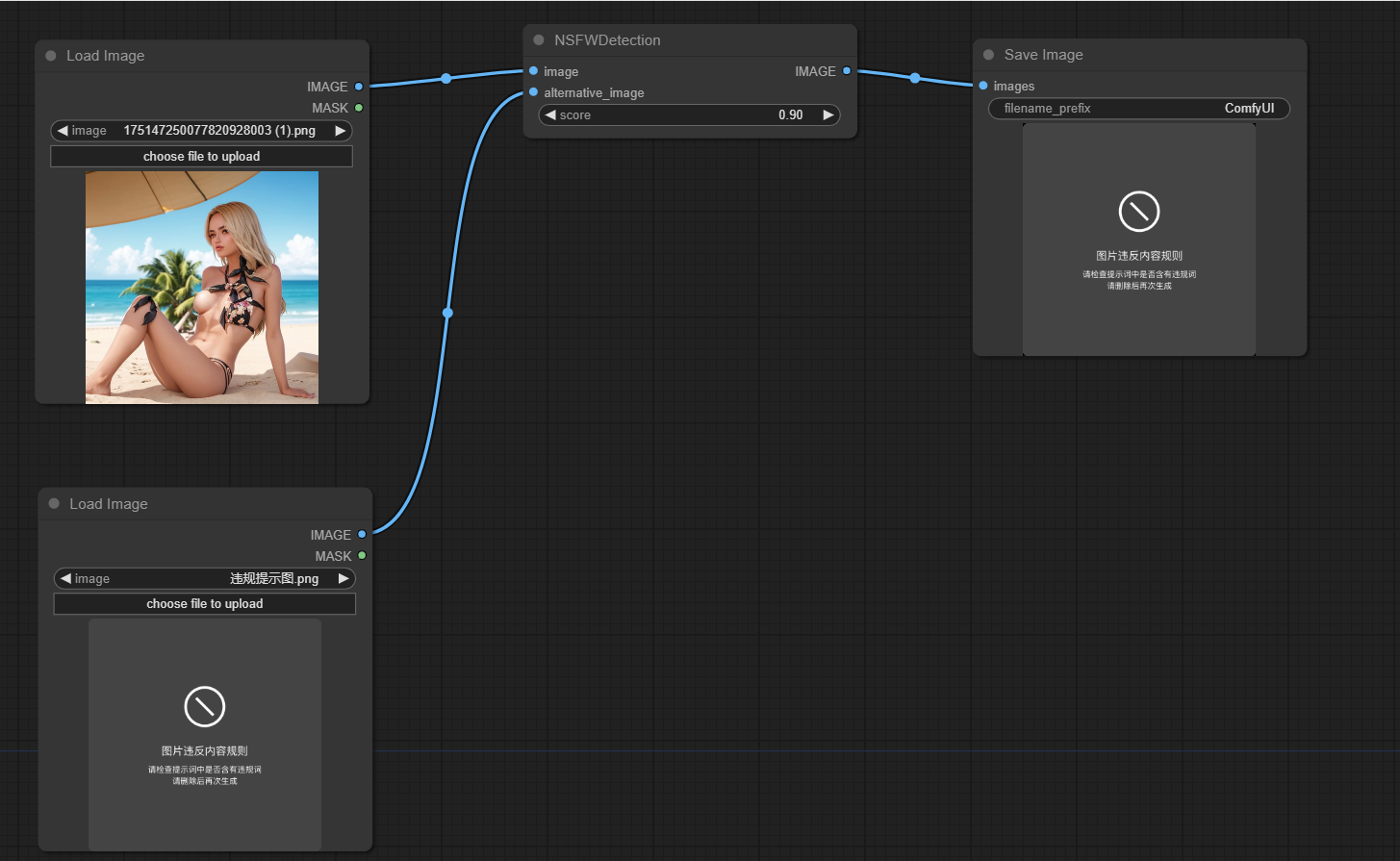

ComfyUI NSFW Detection

1.0.0

이 프로젝트는 Comfyui에 의해 생성 된 이미지가 작업에 안전하지 않은지 (NSFW)를 감지하도록 설계되었습니다. 기계 학습 모델을 사용하여 이미지를 안전하거나 안전하지 않은 것으로 분류합니다. 이미지가 NSFW로 분류되면 대체 이미지가 반환됩니다.

Comfyui 위치의 Custom_nodes 디렉토리 로이 리베르를 복제하십시오

PIP 설치 -R 요구 사항을 실행합니다 .txt

프로젝트의 주요 기능은 node.py 파일의 NSFWDetection 클래스에 캡슐화됩니다. 이 클래스에는 세 가지 매개 변수를 사용하는 run 메소드가 있습니다.

image : 분류 할 이미지.score : 이미지를 NSFW로 분류하기위한 임계 값 점수.alternative_image : 입력 이미지가 NSFW로 분류되면 반환 할 이미지를 반환합니다.

https://github.com/trumanwong/comfyui-nsfw-detection/blob/main/workflow.json

기부금을 환영합니다. 개선 또는 버그 수정이 있으면 풀 요청을 제출하십시오.

이 프로젝트는 MIT 라이센스의 조건에 따라 라이센스가 부여됩니다.