Reversal of Thought

1.0.0

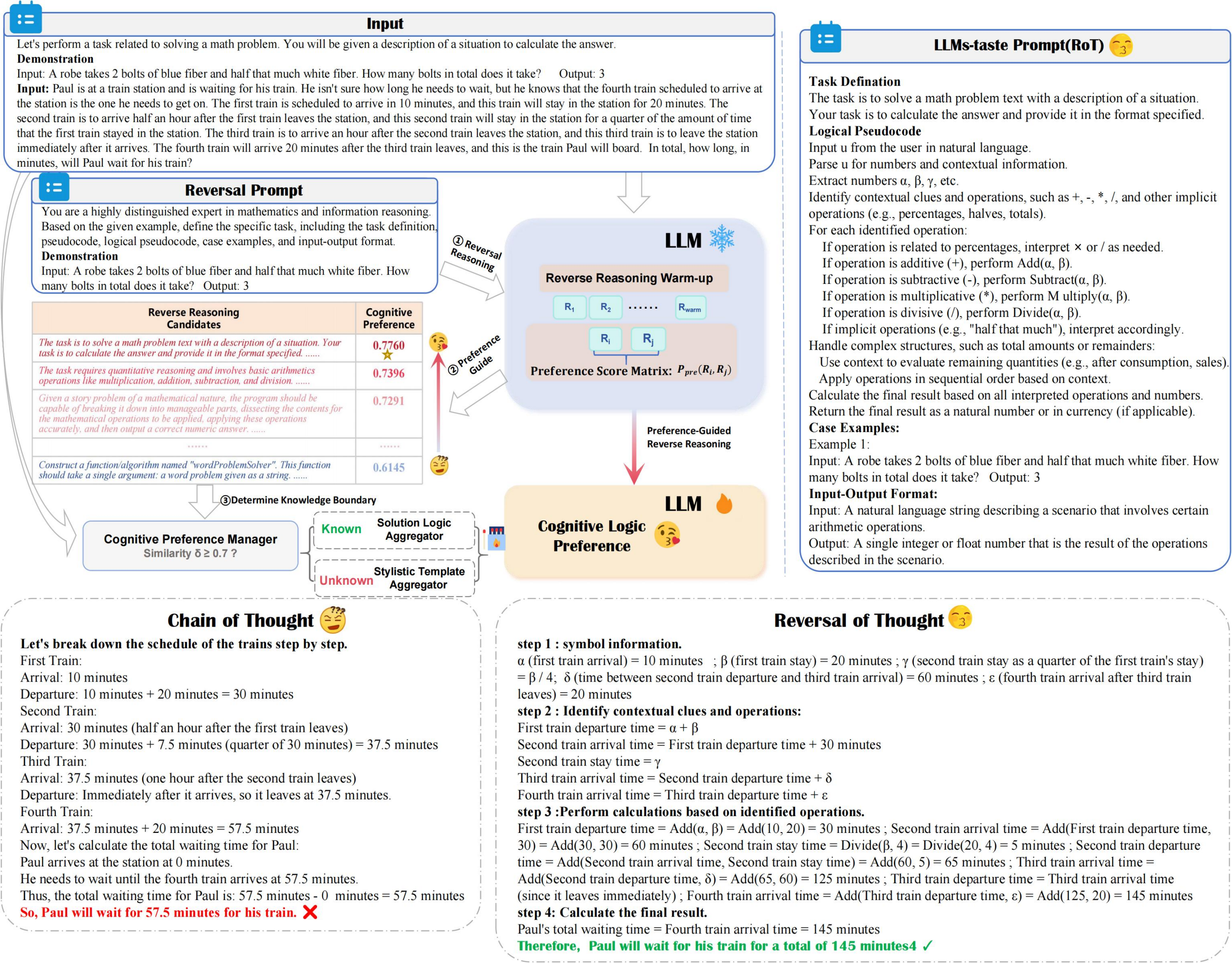

Rot은 계산 비용을 최소화하면서 추론 정확도와 효율성을 향상시키고, 선호도 유도 역 추론 및 인지 선호도 관리자를 활용하여인지 선호도로 LLM 추론을 최적으로 탐색합니다.

? Reversal_demo.py

from utils . llm_utils import *

from utils . prompt import *

pipeline = Pipeline ( model_id = model_id , base_url = base_url , api_key = api_key , prob = True )

demos = "Input:... Output:..." #Suggest 2-shot Demos

llm_taste = rot_pipeline ( pipeline , reversal_of_thought , demos = demos , warmup = 5 ) 작업 솔루션에 대한 LLM 포장 프롬프트 향상

LLM 예방 전략과 일치하여 작업 해결 효율성을 최적화하라는 프롬프트를 개선합니다.

다양한 QA 데이터 세트를 생성 할 수 있습니다

데이터 세트 다양성을 향상시키기 위해 다양한 질문 응답 쌍을 생성합니다.

우리의 연구가 귀하의 연구에 유용하다는 것을 알게되면 다음과 같이 신문을 친절하게 인용하십시오.

@article { yuan2024reversal ,

title = { Reversal of Thought: Enhancing Large Language Models with Preference-Guided Reverse Reasoning Warm-up } ,

author = { Yuan, Jiahao and Du, Dehui and Zhang, Hao and Di, Zixiang and Naseem, Usman } ,

journal = { arXiv preprint arXiv:2410.12323 } ,

year = { 2024 }

}