Получить помощь - Часто задаваемые вопросы Обсуждения Веб-сайт документации Discord

Дорожная карта моделей быстрого запуска? Демо? Исследователь? Примеры

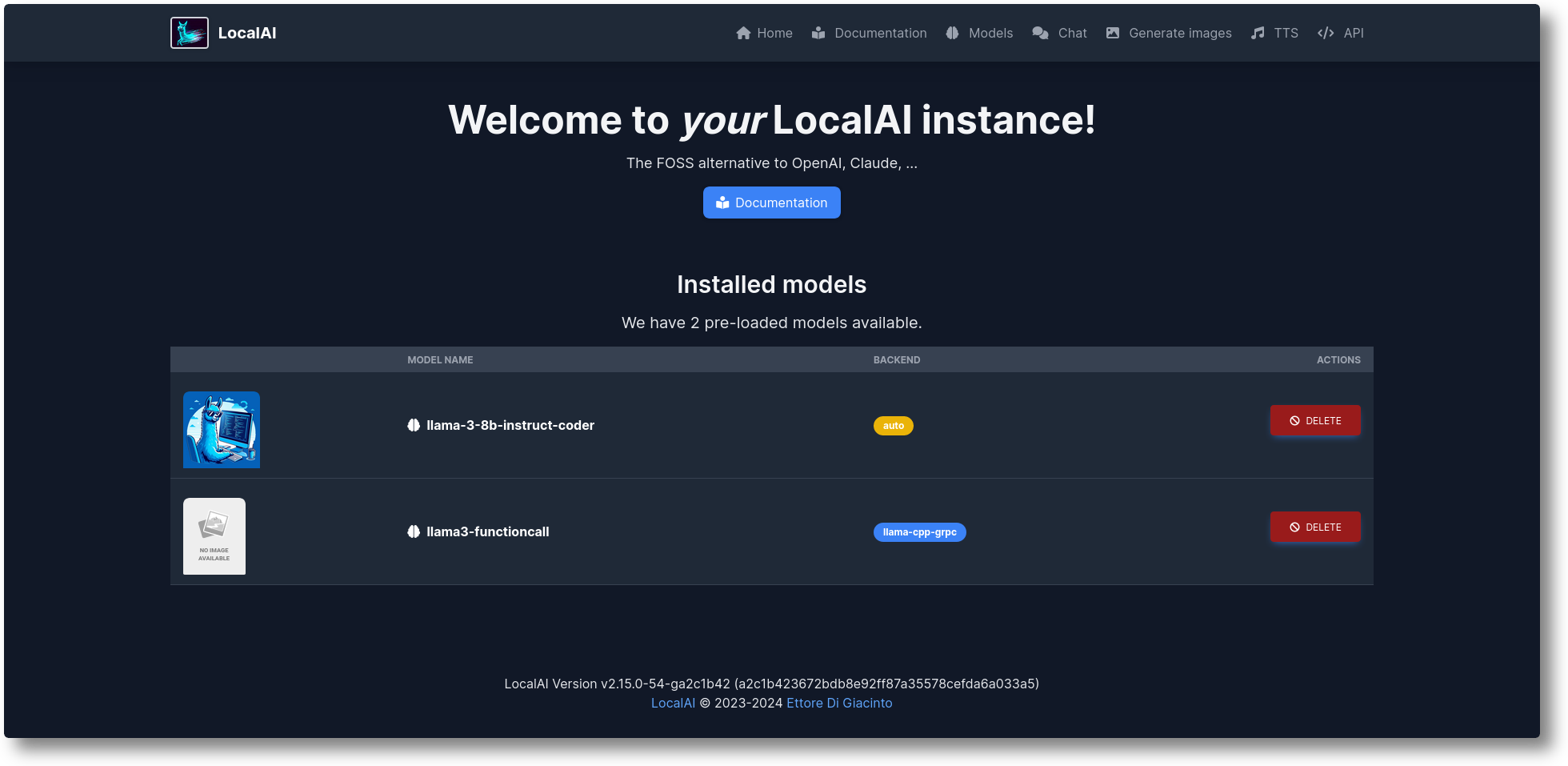

LocalAI — это бесплатная альтернатива OpenAI с открытым исходным кодом. LocalAI выступает в качестве замены REST API, совместимой со спецификациями API OpenAI (Elevenlabs, Anthropic...) для локального вывода ИИ. Он позволяет запускать LLM, генерировать изображения, аудио (и не только) локально или локально с помощью оборудования потребительского уровня, поддерживая несколько семейств моделей. Не требует графического процессора. Он создан и поддерживается Этторе Ди Джачинто.

Запустите скрипт установщика:

локон https://localai.io/install.sh | ш

Или запустите с помощью докера:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu# Альтернативные изображения:# - если у вас есть графический процессор Nvidia:# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12# - без предварительно настроенных моделей# докер run -ti --name local-ai -p 8080:8080 localai/localai:latest# - без предварительно настроенных моделей для графических процессоров Nvidia# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai : последний-gpu-nvidia-cuda-12

Чтобы загрузить модели:

# Из галереи моделей (см. доступные модели со списком моделей local-ai, в веб-интерфейсе на вкладке модели или посетив https://models.localai.io)local-ai запустите llama-3.2-1b-instruct: q4_k_m# Запустите LocalAI с моделью phi-2 непосредственно из Huggingfacelocal-ai, запустите Huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf# Установить и запустите модель из реестра Ollama OCIlocal-ai, запустите ollama://gemma:2b# Запустите модель из файла конфигурации, запустите local-ai https://gist.githubusercontent.com/.../phi-2.yaml# Установите и запустите модель из стандартного реестра OCI (например, Docker Hub) local-ai run oci://localai/phi-2:latest

Начиная

Октябрь 2024 г.: примеры перенесены в LocalAI-examples.

Август 2024 г.: ? FLUX-1, P2P-проводник

Июль 2024 г.: ? P2P-панель, режим LocalAI Federated и AI Swarms: #2723.

Июнь 2024 г.: ? Теперь вы можете просматривать галерею моделей без LocalAI! Посетите https://models.localai.io.

Июнь 2024 г.: Поддержка моделей из реестров OCI: № 2628.

Май 2024 г.: децентрализованный P2P llama.cpp: № 2343 (peer2peer llama.cpp!) Документы https://localai.io/features/distribute/

Май 2024 г.: Openvoice: № 2334.

Май 2024 г.: ? Вызовы функций без грамматик и смешанного режима: #2328

Май 2024 г.: Распределенный вывод: № 2324.

Май 2024 г.: чат, TTS и создание изображений в веб-интерфейсе: #2222.

Апрель 2024 г.: API реранкера: #2121.

Пункты дорожной карты: список проблем

Мультимодальный режим с поддержкой vLLM и видео: #3729.

API реального времени № 3714

Распределенный, P2P Глобальные пулы сообщества: #3113

Улучшения веб-интерфейса: #2156.

Бэкэнды v2: #1126

Улучшение UX v2: #1373

API помощника: #1273.

Конечная точка модерации: #999.

Вулкан: #1647

Антропный API: #1808

Если вы хотите помочь и внести свой вклад, вы можете решить проблемы: https://github.com/mudler/LocalAI/issues?q=is%3Aissue+is%3Aopen+label%3A%22up+for+grabs%22.

Генерация текста с помощью GPT ( llama.cpp , gpt4all.cpp ,... и т. д.)

Текст в аудио

Аудио в текст (транскрипция аудио с помощью whisper.cpp )

Генерация изображений со стабильной диффузией

API инструментов, подобных OpenAI

Генерация вложений для векторных баз данных

Ограниченные грамматики

Скачивайте модели прямо с Huggingface

Видение API

API реранкера

P2P-выводы

Интегрированный веб-интерфейс!

Ознакомьтесь с разделом «Начало работы» в нашей документации.

Сборка и развертывание пользовательских контейнеров:

https://github.com/sozercan/aikit

Веб-интерфейсы:

https://github.com/Jirubizu/localai-admin

https://github.com/go-skynet/LocalAI-frontend

QA-Pilot (проект интерактивного чата, который использует LLM LocalAI для быстрого понимания и навигации по репозиторию кода GitHub) https://github.com/reid41/QA-Pilot

Галереи моделей

https://github.com/go-skynet/model-gallery

Другой:

График управления https://github.com/go-skynet/helm-charts

Расширение VSCode https://github.com/badgoooooor/localai-vscode-plugin

Утилита терминала https://github.com/djcopley/ShellOracle

Локальный умный помощник https://github.com/mudler/LocalAGI

Домашний помощник https://github.com/sammcj/homeassistant-localai / https://github.com/drndos/hass-openai-custom-conversation / https://github.com/валентинфрлч/ha-gpt4vision

Discord-бот https://github.com/mudler/LocalAGI/tree/main/examples/discord

Slack-бот https://github.com/mudler/LocalAGI/tree/main/examples/slack

Shell-Pilot (взаимодействие с LLM с использованием моделей LocalAI через чистые сценарии оболочки в вашей системе Linux или MacOS) https://github.com/reid41/shell-pilot

Telegram-бот https://github.com/mudler/LocalAI/tree/master/examples/telegram-bot

Действия Github: https://github.com/marketplace/actions/start-localai

Примеры: https://github.com/mudler/LocalAI/tree/master/examples/.

Руководство по тонкой настройке LLM

Как построить локально

Как установить в Кубернетес

Проекты, интегрирующие LocalAI

Раздел «Как сделать» (куратор нашего сообщества)

Запустите код Visual Studio с помощью LocalAI (SUSE).

Запустите LocalAI в Jetson Nano Devkit

Запустите LocalAI на AWS EKS с помощью Pulumi

Запустите LocalAI на AWS

Создайте Slackbot для команд и проектов OSS, отвечающих документации.

LocalAI соответствует k8sgpt

Ответы на вопросы по документам локально с помощью LangChain, LocalAI, Chroma и GPT4All

Учебник по использованию k8sgpt с LocalAI

Если вы используете этот репозиторий, данные в дальнейшем проекте, рассмотрите возможность цитирования его с помощью:

@misc{localai,

author = {Ettore Di Giacinto},

title = {LocalAI: The free, Open source OpenAI alternative},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/go-skynet/LocalAI}},Считаете ли вы LocalAI полезным?

Поддержите проект, став спонсором или спонсором. Здесь появится ваш логотип со ссылкой на ваш сайт.

Огромное спасибо нашим щедрым спонсорам, которые поддерживают этот проект, покрывая расходы на CI, и нашему списку спонсоров:

LocalAI — это проект сообщества, созданный Этторе Ди Джачинто.

Массачусетский технологический институт – автор Этторе Ди Джачинто [email protected]

LocalAI не мог бы быть создан без помощи отличного программного обеспечения, уже доступного сообществу. Спасибо!

лама.cpp

https://github.com/tatsu-lab/stanford_alpaca

https://github.com/cornelk/llama-go за первоначальные идеи

https://github.com/antimatter15/alpaca.cpp

https://github.com/EdVince/Stable-Diffusion-NCNN

https://github.com/ggerganov/whisper.cpp

https://github.com/saharNooby/rwkv.cpp

https://github.com/rhasspy/piper

Это общественный проект, особая благодарность нашим участникам! ?