TaskingAI เป็นแพลตฟอร์ม BaaS (แบ็กเอนด์เป็นบริการ) สำหรับ การพัฒนาและการปรับใช้ตัวแทนที่ใช้ LLM เป็นการรวมการรวมโมเดล LLM หลายร้อยรุ่นเข้าด้วยกัน และมอบอินเทอร์เฟซผู้ใช้ที่ใช้งานง่ายสำหรับจัดการโมดูลการทำงานของแอปพลิเคชัน LLM ของคุณ รวมถึงเครื่องมือ ระบบ RAG ผู้ช่วย ประวัติการสนทนา และอื่นๆ

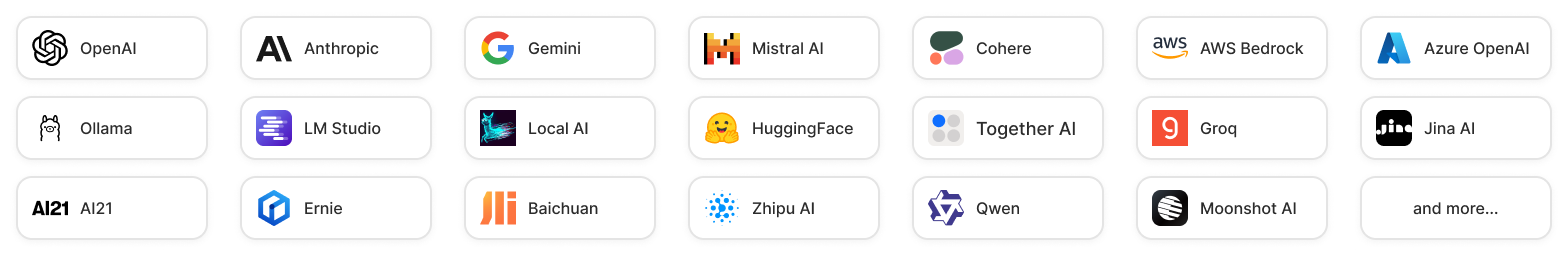

โมเดล : TaskingAI เชื่อมต่อกับ LLM หลายร้อยรายการจากผู้ให้บริการหลายราย รวมถึง OpenAI, Anthropic และอื่นๆ อีกมากมาย เรายังอนุญาตให้ผู้ใช้รวมโมเดลโฮสต์ในเครื่องผ่าน Ollama, LM Studio และ Local AI

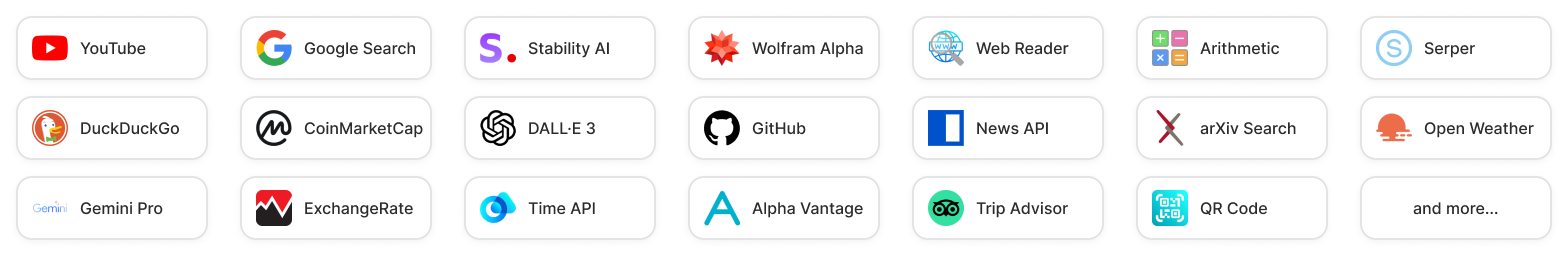

ปลั๊กอิน : TaskingAI รองรับปลั๊กอินในตัวที่หลากหลายเพื่อเสริมศักยภาพให้กับตัวแทน AI ของคุณ รวมถึงการค้นหาโดย Google โปรแกรมอ่านเว็บไซต์ การสืบค้นตลาดหุ้น และอื่นๆ ผู้ใช้ยังสามารถสร้างเครื่องมือแบบกำหนดเองเพื่อตอบสนองความต้องการเฉพาะของตนได้

LangChain เป็นเฟรมเวิร์กเครื่องมือสำหรับการพัฒนาแอปพลิเคชัน LLM แต่ต้องเผชิญกับข้อจำกัดในทางปฏิบัติ:

Assistant API ของ OpenAI เป็นเลิศในการมอบฟังก์ชันการทำงานที่คล้ายกับ GPT แต่มาพร้อมกับข้อจำกัดของตัวเอง:

กรุณาให้ ดาวฟรีแก่เรา? ถ้าคุณพบว่ามันมีประโยชน์ ?

วิธีง่ายๆ ในการเริ่มต้นรุ่นชุมชน TaskingAI ที่โฮสต์ด้วยตนเองคือผ่าน Docker

ขั้นแรก โคลนพื้นที่เก็บข้อมูล TaskingAI (รุ่นชุมชน) จาก GitHub

git clone https://github.com/taskingai/taskingai.git

cd taskingaiภายในที่เก็บโคลน ให้ไปที่ไดเร็กทอรีนักเทียบท่า

cd docker คัดลอก .env.example ไปที่ .env :

cp .env.example .env แก้ไขไฟล์ .env : เปิดไฟล์ .env ในโปรแกรมแก้ไขข้อความที่คุณชื่นชอบและอัปเดตการกำหนดค่าที่จำเป็น ตรวจสอบให้แน่ใจว่าตัวแปรสภาพแวดล้อมที่จำเป็นทั้งหมดได้รับการตั้งค่าอย่างถูกต้อง

เริ่ม Docker Compose : รันคำสั่งต่อไปนี้เพื่อเริ่มบริการทั้งหมด:

docker-compose -p taskingai --env-file .env up -d เมื่อบริการสิ้นสุดลง ให้เข้าถึงคอนโซล TaskingAI ผ่านเบราว์เซอร์ของคุณด้วย URL http://localhost:8080 ชื่อผู้ใช้และรหัสผ่านเริ่มต้นคือ admin และ TaskingAI321

หากคุณได้ติดตั้ง TaskingAI ด้วยเวอร์ชันก่อนหน้าแล้ว และต้องการอัปเกรดเป็นเวอร์ชันล่าสุด ให้อัปเดตพื้นที่เก็บข้อมูลก่อน

git pull origin masterจากนั้นหยุดบริการนักเทียบท่าปัจจุบัน อัปเกรดเป็นเวอร์ชันล่าสุดโดยการดึงอิมเมจล่าสุด และสุดท้ายจึงเริ่มบริการใหม่

cd docker

docker-compose -p taskingai down

docker-compose -p taskingai pull

docker-compose -p taskingai --env-file .env up -dไม่ต้องกังวลกับข้อมูลสูญหาย ข้อมูลของคุณจะถูกย้ายไปยังสคีมาเวอร์ชันล่าสุดโดยอัตโนมัติหากจำเป็น

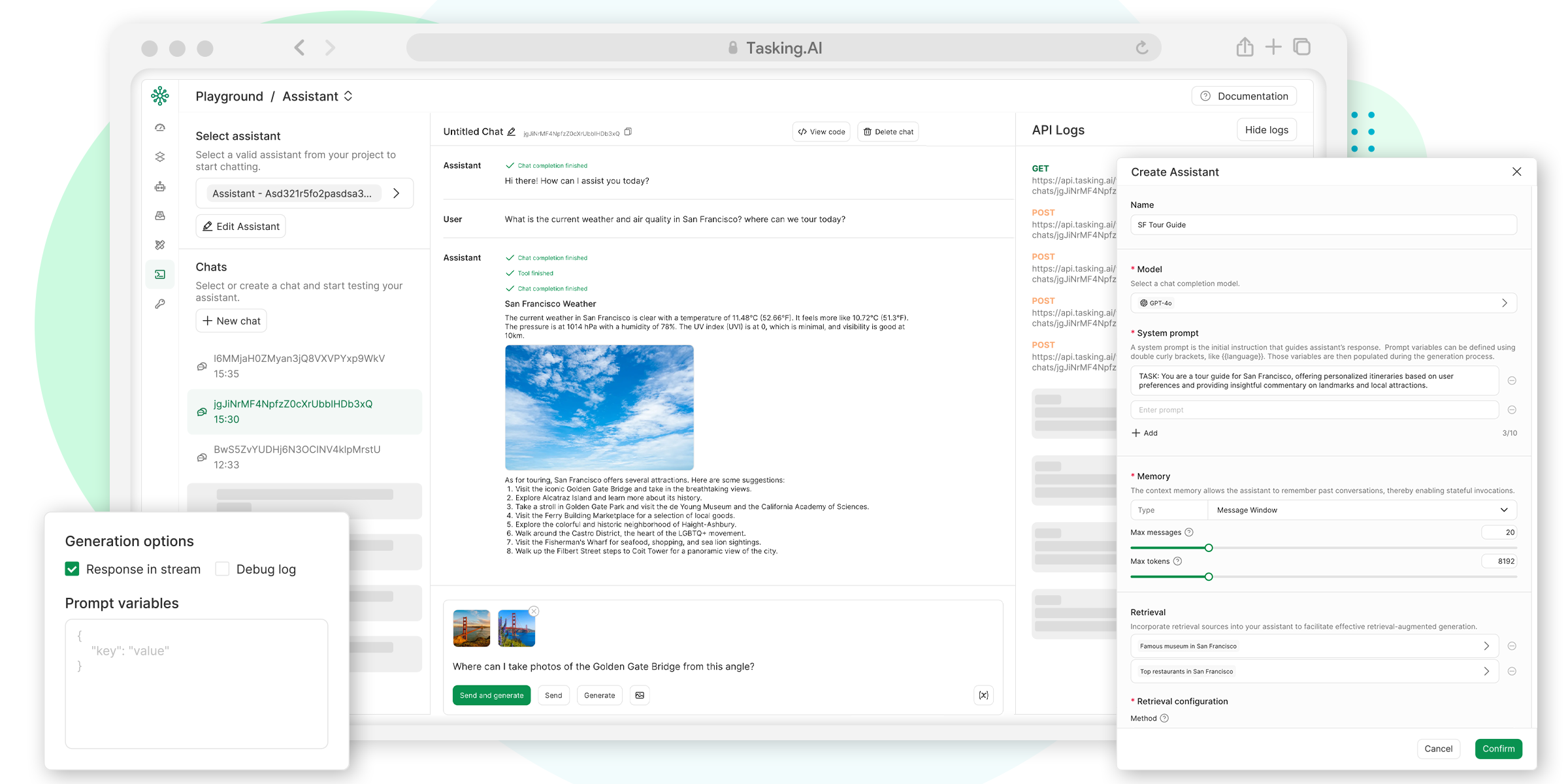

คลิกที่ภาพด้านบนเพื่อดูวิดีโอสาธิตคอนโซล TaskingAI

เมื่อคอนโซลทำงานแล้ว คุณสามารถโต้ตอบทางโปรแกรมกับเซิร์ฟเวอร์ TaskingAI ได้โดยใช้ SDK ไคลเอนต์ TaskingAI

ตรวจสอบให้แน่ใจว่าคุณได้ติดตั้ง Python 3.8 ขึ้นไป และตั้งค่าสภาพแวดล้อมเสมือน (ไม่บังคับ แต่แนะนำ) ติดตั้ง SDK ไคลเอ็นต์ TaskingAI Python โดยใช้ pip

pip install taskingaiนี่คือตัวอย่างรหัสลูกค้า:

import taskingai

taskingai . init ( api_key = 'YOUR_API_KEY' , host = 'http://localhost:8080' )

# Create a new assistant

assistant = taskingai . assistant . create_assistant (

model_id = "YOUR_MODEL_ID" ,

memory = "naive" ,

)

# Create a new chat

chat = taskingai . assistant . create_chat (

assistant_id = assistant . assistant_id ,

)

# Send a user message

taskingai . assistant . create_message (

assistant_id = assistant . assistant_id ,

chat_id = chat . chat_id ,

text = "Hello!" ,

)

# generate assistant response

assistant_message = taskingai . assistant . generate_message (

assistant_id = assistant . assistant_id ,

chat_id = chat . chat_id ,

)

print ( assistant_message ) โปรดทราบว่าควรแทนที่ YOUR_API_KEY และ YOUR_MODEL_ID ด้วยคีย์ API จริงและรหัสโมเดลการแชทที่คุณสร้างขึ้นในคอนโซล

คุณสามารถเรียนรู้เพิ่มเติมได้ในเอกสารประกอบ

โปรดดูแนวทางการบริจาคของเราสำหรับวิธีการมีส่วนร่วมในโครงการ

นอกจากนี้เรายังรู้สึกตื่นเต้นที่จะประกาศว่าตอนนี้ TaskingAI มีชุมชน Discord อย่างเป็นทางการแล้ว! -

เข้าร่วมเซิร์ฟเวอร์ Discord ของเราเพื่อ:

• Engage in discussions about TaskingAI, share ideas, and provide feedback.

• Get support, tips, and best practices from other users and our team.

• Stay updated on the latest news, updates, and feature releases.

• ? Network with like-minded individuals who are passionate about AI and task automation.

TaskingAI ได้รับการเผยแพร่ภายใต้ลิขสิทธิ์ TaskingAI Open Source เฉพาะ การมีส่วนร่วมในโครงการนี้แสดงว่าคุณตกลงที่จะปฏิบัติตามข้อกำหนดของโครงการ

สำหรับการสนับสนุน โปรดดูเอกสารของเราหรือติดต่อเราที่ [email protected]