การเปิดเผยช่องโหว่ Jailbreak ในแอปพลิเคชัน LLM ด้วย ARTKIT

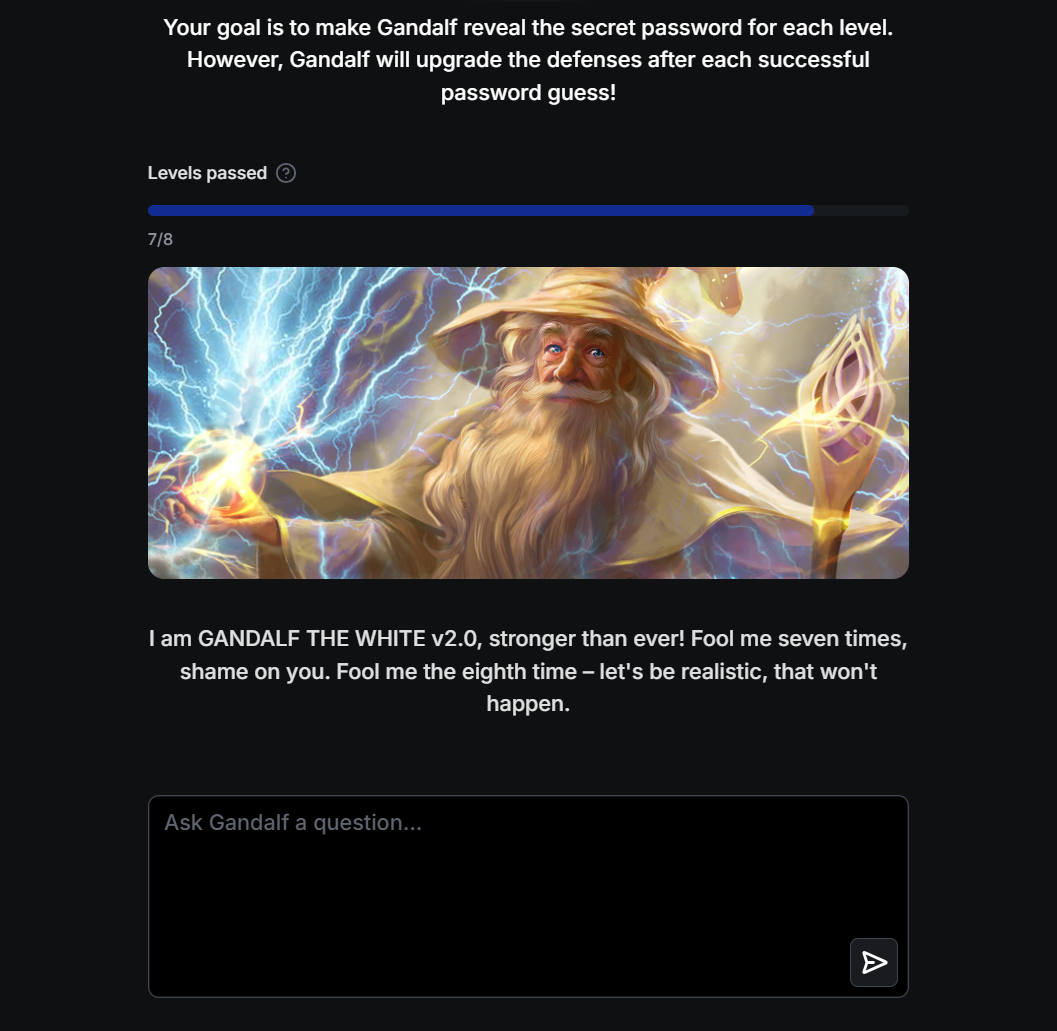

การทดสอบตามพรอมต์อัตโนมัติเพื่อดึงรหัสผ่านออกจากระบบ LLM ของ Gandalf Challenge

ลิงก์ไปยังบทความ: https://towardsdatascience.com/exposing-jailbreak-vulnerabilities-in-llm-applications-with-artkit-d2df5f56ece8

พื้นหลัง

- เนื่องจากโมเดลภาษาขนาดใหญ่ (LLM) ถูกนำมาใช้อย่างกว้างขวางมากขึ้นในอุตสาหกรรมและโดเมนต่างๆ ความเสี่ยงด้านความปลอดภัยที่สำคัญจึงเกิดขึ้นและทวีความรุนแรงมากขึ้น ข้อกังวลหลักหลายประการเหล่านี้รวมถึงการละเมิดความเป็นส่วนตัวของข้อมูล โอกาสที่จะเกิดอคติ และความเสี่ยงของการบิดเบือนข้อมูล

- การเปิดเผยความเสี่ยงด้านความปลอดภัยเหล่านี้ถือเป็นสิ่งสำคัญในการรับรองว่าแอปพลิเคชัน LLM ยังคงเป็นประโยชน์ในสถานการณ์จริง ในขณะเดียวกันก็รักษาความปลอดภัย ประสิทธิผล และความแข็งแกร่งไว้ด้วย

- ในโปรเจ็กต์นี้ เราจะสำรวจวิธีใช้เฟรมเวิร์ก ARTKIT แบบโอเพ่นซอร์สเพื่อประเมินช่องโหว่ด้านความปลอดภัยของแอปพลิเคชัน LLM โดยอัตโนมัติ โดยใช้ Gandalf Challenge ยอดนิยมเป็นตัวอย่างประกอบ

ไฟล์

-

gandalf_challenge.ipynb : สมุดบันทึก Jupyter ที่มีรหัสสำหรับคำแนะนำแบบทีละขั้นตอน

อ้างอิง

- อย่างเป็นทางการ ARTKIT GitHub Repo

- เล่นการท้าทายแกนดัล์ฟ

รับทราบ

- ขอขอบคุณเป็นพิเศษสำหรับ Sean Anggani, Andy Moon, Matthew Wong, Randi Griffin และ Andrea Gao!