| หากคุณต้องการเจาะลึกสูตรประสิทธิภาพที่เปิดเผยในพื้นที่เก็บข้อมูลนี้ ฉันแน่ใจว่าคุณจะต้องชอบหนังสือของฉัน "Spring Boot Persistence Best Practices" | หากคุณต้องการเคล็ดลับและภาพประกอบเกี่ยวกับปัญหาประสิทธิภาพการคงอยู่ของ Java มากกว่า 100 รายการ "คู่มือภาพประกอบประสิทธิภาพ Java Persistence" เหมาะสำหรับคุณ |

|

|

ตัวอย่างการบูตไฮเบอร์เนตและสปริง

คำอธิบาย: แอปพลิเคชันนี้เป็นตัวอย่างวิธีการจัดเก็บวันที่ เวลา และการประทับเวลาในเขตเวลา UTC การตั้งค่าที่สอง useLegacyDatetimeCode จำเป็นสำหรับ MySQL เท่านั้น มิฉะนั้น ให้ตั้งค่าเฉพาะ hibernate.jdbc.time_zone

ประเด็นสำคัญ:

spring.jpa.properties.hibernate.jdbc.time_zone=UTCspring.datasource.url=jdbc:mysql://localhost:3306/screenshotdb?useLegacyDatetimeCode=falseคำอธิบาย: ดูพารามิเตอร์การรวม/แยกคำสั่งที่เตรียมไว้ผ่านการตั้งค่าตัวบันทึก Log4J 2

ประเด็นสำคัญ:

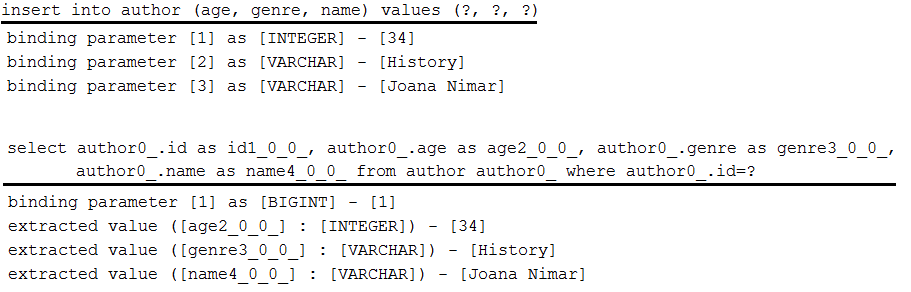

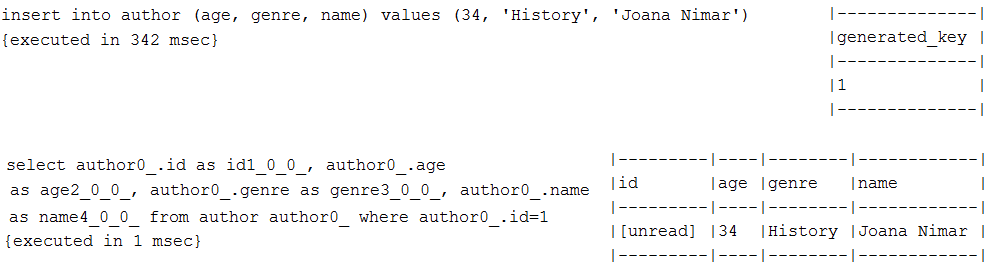

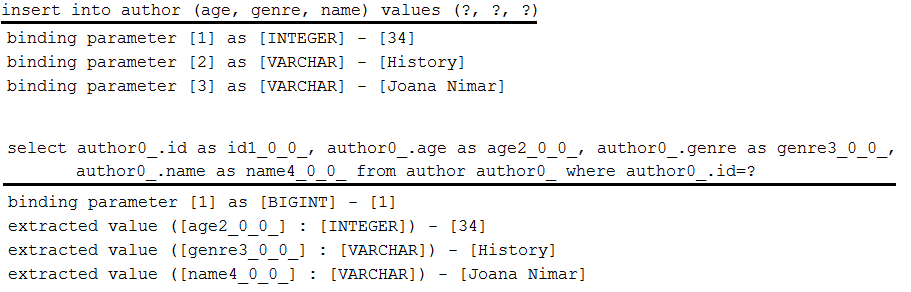

pom.xml ไม่รวมการบันทึกเริ่มต้นของ Spring Bootpom.xml เพิ่มการพึ่งพา Log4j 2log4j2.xml เพิ่ม <Logger name="org.hibernate.type.descriptor.sql" level="trace"/> ตัวอย่างผลลัพธ์:

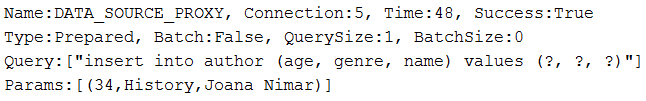

คำอธิบาย: ดูรายละเอียดการสืบค้น (ประเภทการสืบค้น พารามิเตอร์การเชื่อมโยง ขนาดแบตช์ เวลาดำเนินการ ฯลฯ) ผ่าน DataSource-Proxy

ประเด็นสำคัญ:

pom.xml การพึ่งพา datasource-proxyDataSource beanDataSource bean ผ่าน ProxyFactory และการใช้งาน MethodInterceptor ตัวอย่างผลลัพธ์:

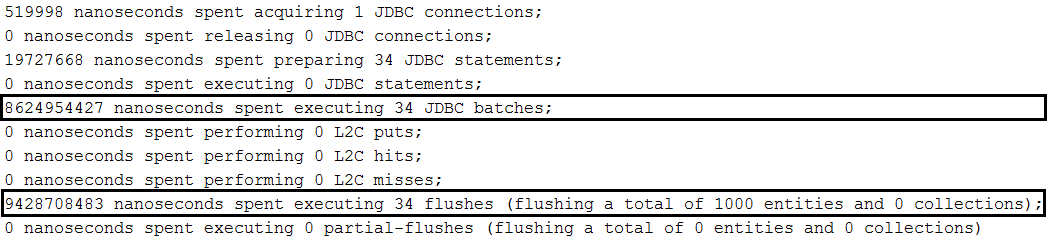

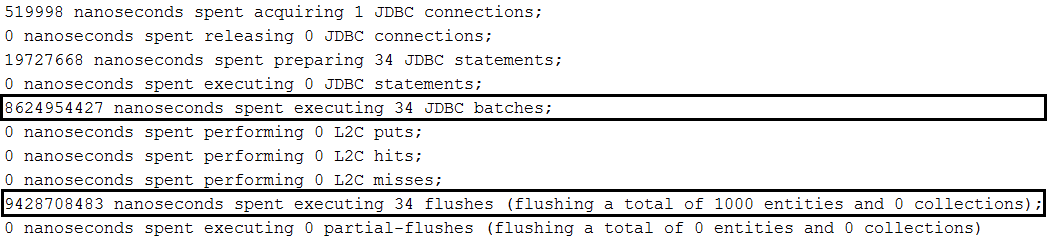

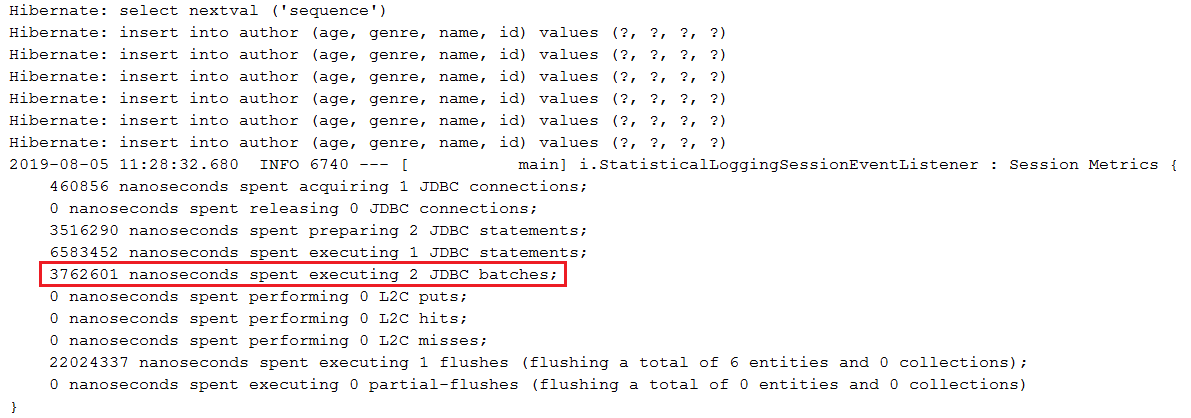

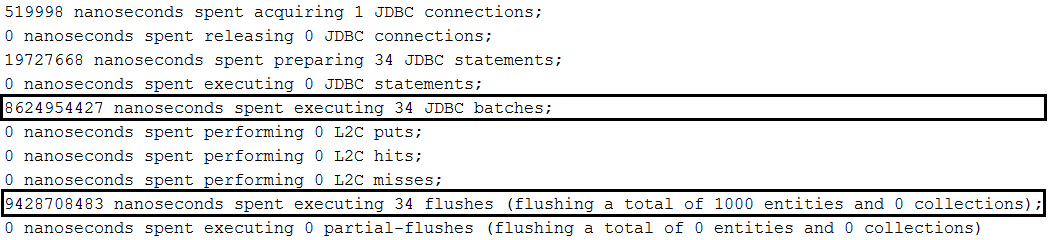

saveAll(Iterable<S> entities) ใน MySQL คำอธิบาย: การแทรกแบทช์ผ่านวิธี SimpleJpaRepository#saveAll(Iterable<S> entities) ใน MySQL

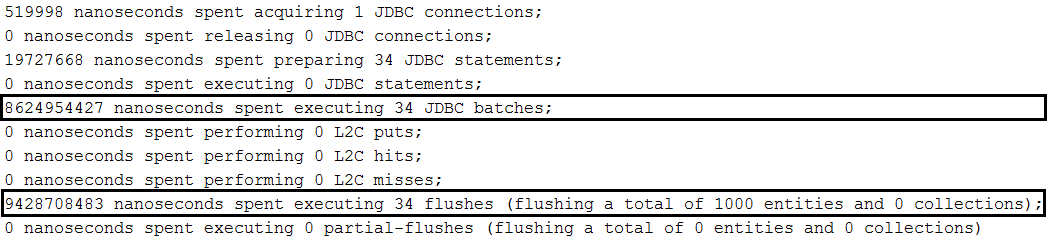

ประเด็นสำคัญ:

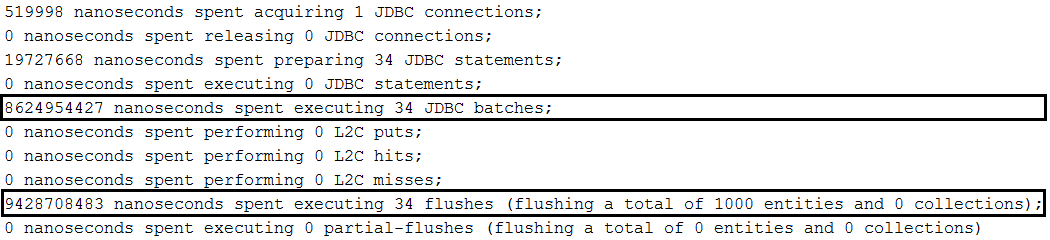

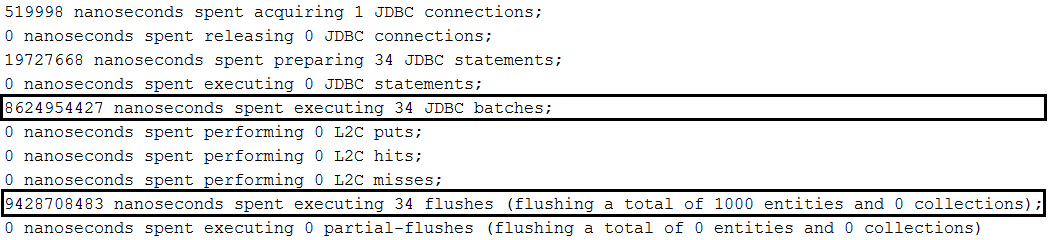

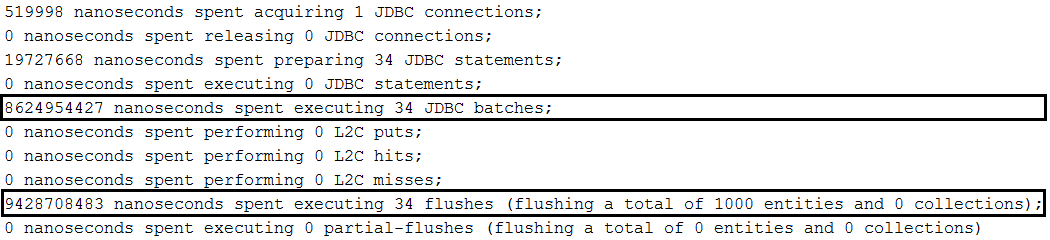

application.properties ตั้งค่า spring.jpa.properties.hibernate.jdbc.batch_sizeapplication.properties set spring.jpa.properties.hibernate.generate_statistics (เพียงเพื่อตรวจสอบว่าการแบตช์ใช้งานได้)application.properties ตั้งค่า JDBC URL ด้วย rewriteBatchedStatements=true (การเพิ่มประสิทธิภาพสำหรับ MySQL)application.properties ตั้งค่า JDBC URL ด้วย cachePrepStmts=true (เปิดใช้งานการแคชและมีประโยชน์หากคุณตัดสินใจตั้งค่า prepStmtCacheSize , prepStmtCacheSqlLimit ฯลฯ เช่นกัน หากไม่มีการตั้งค่านี้ แคชจะถูกปิดใช้งาน)application.properties ตั้งค่า JDBC URL ด้วย useServerPrepStmts=true (วิธีนี้คุณจะสลับไปใช้คำสั่งที่เตรียมไว้ฝั่งเซิร์ฟเวอร์ (อาจนำไปสู่การเพิ่มประสิทธิภาพอย่างมีนัยสำคัญ))spring.jpa.properties.hibernate.order_inserts=true เพื่อปรับแบทช์ให้เหมาะสมโดยการสั่งซื้อส่วนแทรกIDENTITY จะทำให้การแทรกแบตช์ถูกปิดใช้งาน@Version เพื่อหลีกเลี่ยงคำสั่งพิเศษ SELECT ที่เริ่มทำงานก่อนแบตช์ (ยังป้องกันการสูญหายของการอัปเดตในธุรกรรมคำขอหลายรายการ) คำสั่ง Extra- SELECT เป็นผลจากการใช้ merge() แทน persist() ; เบื้องหลัง saveAll() ใช้ save() ซึ่งในกรณีของเอนทิตีที่ไม่ใช่ใหม่ (เอนทิตีที่มี ID) จะเรียก merge() ซึ่งสั่งให้ Hibernate เริ่มการทำงานของคำสั่ง SELECT เพื่อให้แน่ใจว่าไม่มีบันทึกใน ฐานข้อมูลที่มีตัวระบุเหมือนกันsaveAll() เพื่อไม่ให้ "มากเกินไป" บริบทการคงอยู่ โดยปกติ EntityManager ควรถูกล้างและเคลียร์เป็นครั้งคราว แต่ในระหว่างการดำเนินการ saveAll() คุณไม่สามารถทำเช่นนั้นได้ ดังนั้นหากใน saveAll() มีรายการที่มีข้อมูลจำนวนมาก ข้อมูลทั้งหมดนั้นจะกระทบต่อ Persistence บริบท (แคชระดับที่ 1) และจะยังคงอยู่ในหน่วยความจำจนกว่าจะถึงเวลาล้างข้อมูล การใช้ข้อมูลจำนวนค่อนข้างน้อยก็ถือว่าใช้ได้ (ในตัวอย่างนี้ แต่ละชุดของเอนทิตี 30 รายการทำงานในธุรกรรมที่แยกจากกันและบริบทที่คงอยู่)saveAll() ส่งคืน List<S> ที่มีเอนทิตีที่คงอยู่ แต่ละเอนทิตีที่มีอยู่จะถูกเพิ่มเข้าไปในรายการนี้ หากคุณไม่ต้องการ List นี้ รายการนี้ก็ถูกสร้างขึ้นมาโดยเปล่าประโยชน์spring.jpa.properties.hibernate.cache.use_second_level_cache=false คำอธิบาย: แอปพลิเคชันนี้คือตัวอย่างการแทรกเป็นชุดผ่าน EntityManager ใน MySQL วิธีนี้ทำให้คุณสามารถควบคุมรอบ flush() และ clear() ของบริบทการคงอยู่ (แคชระดับที่ 1) ภายในธุรกรรมปัจจุบันได้อย่างง่ายดาย สิ่งนี้เป็นไปไม่ได้ผ่าน Spring Boot, saveAll(Iterable<S> entities) เนื่องจากเมธอดนี้ดำเนินการฟลัชครั้งเดียวต่อธุรกรรม ข้อดีอีกประการหนึ่งคือคุณสามารถเรียก persist() แทน merge() ได้ - สิ่งนี้ถูกใช้เบื้องหลังโดย SpringBoot saveAll(Iterable<S> entities) และ save(S entity)

หากคุณต้องการดำเนินการเป็นชุดต่อธุรกรรม (แนะนำ) ให้ตรวจสอบตัวอย่างนี้

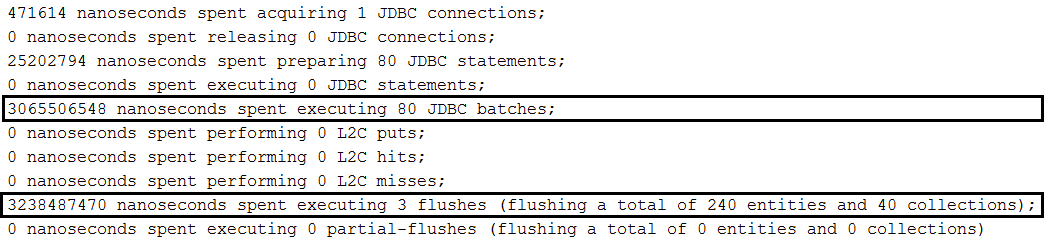

ประเด็นสำคัญ:

application.properties ตั้งค่า spring.jpa.properties.hibernate.jdbc.batch_sizeapplication.properties set spring.jpa.properties.hibernate.generate_statistics (เพียงเพื่อตรวจสอบว่าการแบตช์ใช้งานได้)application.properties ตั้งค่า JDBC URL ด้วย rewriteBatchedStatements=true (การเพิ่มประสิทธิภาพสำหรับ MySQL)application.properties ตั้งค่า JDBC URL ด้วย cachePrepStmts=true (เปิดใช้งานการแคชและมีประโยชน์หากคุณตัดสินใจตั้งค่า prepStmtCacheSize , prepStmtCacheSqlLimit ฯลฯ เช่นกัน หากไม่มีการตั้งค่านี้ แคชจะถูกปิดใช้งาน)application.properties ตั้งค่า JDBC URL ด้วย useServerPrepStmts=true (วิธีนี้คุณจะสลับไปใช้คำสั่งที่เตรียมไว้ฝั่งเซิร์ฟเวอร์ (อาจนำไปสู่การเพิ่มประสิทธิภาพอย่างมีนัยสำคัญ))spring.jpa.properties.hibernate.order_inserts=true เพื่อปรับแบทช์ให้เหมาะสมโดยการสั่งซื้อส่วนแทรกIDENTITY จะทำให้การแทรกแบตช์ถูกปิดใช้งานspring.jpa.properties.hibernate.cache.use_second_level_cache=false ตัวอย่างผลลัพธ์:

คำอธิบาย: การแทรกเป็นกลุ่มผ่าน JpaContext/EntityManager ใน MySQL

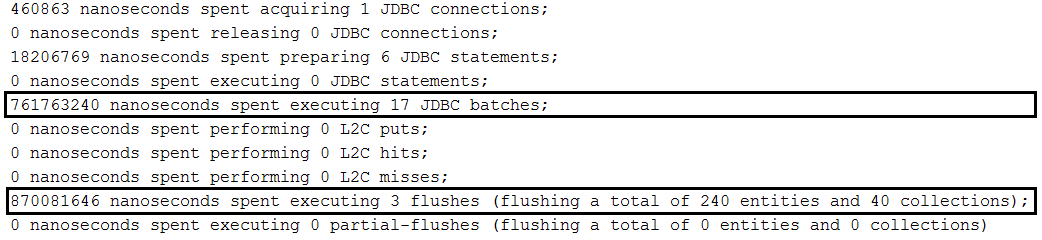

ประเด็นสำคัญ:

application.properties ตั้งค่า spring.jpa.properties.hibernate.jdbc.batch_sizeapplication.properties set spring.jpa.properties.hibernate.generate_statistics (เพียงเพื่อตรวจสอบว่าการแบตช์ใช้งานได้)application.properties ตั้งค่า JDBC URL ด้วย rewriteBatchedStatements=true (การเพิ่มประสิทธิภาพสำหรับ MySQL)application.properties ตั้งค่า JDBC URL ด้วย cachePrepStmts=true (เปิดใช้งานการแคชและมีประโยชน์หากคุณตัดสินใจตั้งค่า prepStmtCacheSize , prepStmtCacheSqlLimit ฯลฯ เช่นกัน หากไม่มีการตั้งค่านี้ แคชจะถูกปิดใช้งาน)application.properties ตั้งค่า JDBC URL ด้วย useServerPrepStmts=true (วิธีนี้คุณจะสลับไปใช้คำสั่งที่เตรียมไว้ฝั่งเซิร์ฟเวอร์ (อาจนำไปสู่การเพิ่มประสิทธิภาพอย่างมีนัยสำคัญ))spring.jpa.properties.hibernate.order_inserts=true เพื่อปรับแบทช์ให้เหมาะสมโดยการสั่งซื้อส่วนแทรกIDENTITY จะทำให้การแทรกแบตช์ถูกปิดใช้งานEntityManager ตามประเภทเอนทิตีผ่าน JpaContext#getEntityManagerByManagedType(Class<?> entity)spring.jpa.properties.hibernate.cache.use_second_level_cache=false ตัวอย่างผลลัพธ์:

คำอธิบาย: การแทรกแบทช์ผ่านการแบทช์ระดับเซสชันไฮเบอร์เนต (ไฮเบอร์เนต 5.2 หรือสูงกว่า) ใน MySQL

ประเด็นสำคัญ:

application.properties set spring.jpa.properties.hibernate.generate_statistics (เพียงเพื่อตรวจสอบว่าการแบตช์ใช้งานได้)application.properties ตั้งค่า JDBC URL ด้วย rewriteBatchedStatements=true (การเพิ่มประสิทธิภาพสำหรับ MySQL)application.properties ตั้งค่า JDBC URL ด้วย cachePrepStmts=true (เปิดใช้งานการแคชและมีประโยชน์หากคุณตัดสินใจตั้งค่า prepStmtCacheSize , prepStmtCacheSqlLimit ฯลฯ เช่นกัน หากไม่มีการตั้งค่านี้ แคชจะถูกปิดใช้งาน)application.properties ตั้งค่า JDBC URL ด้วย useServerPrepStmts=true (วิธีนี้คุณจะสลับไปใช้คำสั่งที่เตรียมไว้ฝั่งเซิร์ฟเวอร์ (อาจนำไปสู่การเพิ่มประสิทธิภาพอย่างมีนัยสำคัญ))spring.jpa.properties.hibernate.order_inserts=true เพื่อปรับแบทช์ให้เหมาะสมโดยการสั่งซื้อส่วนแทรกIDENTITY จะทำให้การแทรกแบตช์ถูกปิดใช้งานSession Hibernate ได้มาโดยการยกเลิกการห่อผ่าน EntityManager#unwrap(Session.class)Session#setJdbcBatchSize(Integer size) และรับผ่าน Session#getJdbcBatchSize()spring.jpa.properties.hibernate.cache.use_second_level_cache=false ตัวอย่างผลลัพธ์:

findById() , JPA EntityManager และ Session Hibernate คำอธิบาย: การดึงข้อมูลโดยตรงผ่านตัวอย่าง Spring Data, EntityManager และ Hibernate Session

ประเด็นสำคัญ:

findById()EntityManager ใช้ find()Session ใช้ get()หมายเหตุ: คุณอาจต้องการอ่านสูตร "วิธีเพิ่มคุณค่า DTO ด้วยคุณสมบัติเสมือนผ่านการฉายภาพในฤดูใบไม้ผลิ"

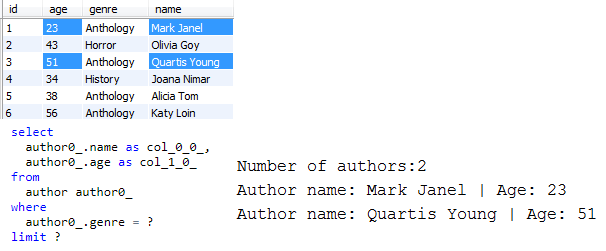

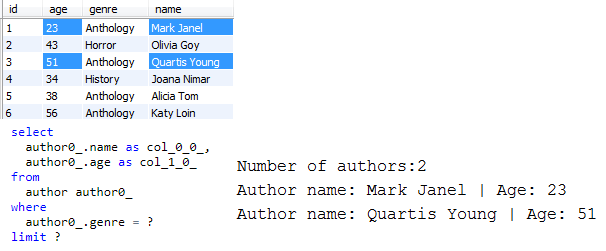

คำอธิบาย: ดึงเฉพาะข้อมูลที่จำเป็นจากฐานข้อมูลผ่าน Spring Data Projections (DTO)

ประเด็นสำคัญ:

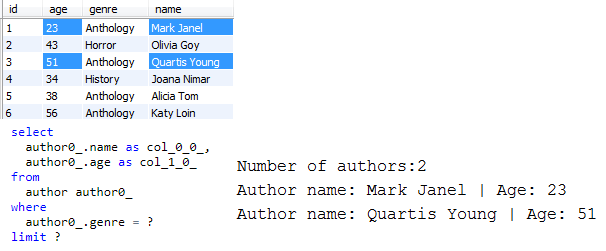

List<projection>LIMIT )หมายเหตุ: การใช้การคาดการณ์ไม่ได้จำกัดอยู่เพียงการใช้กลไกตัวสร้างคิวรีที่สร้างไว้ในโครงสร้างพื้นฐานพื้นที่เก็บข้อมูล Spring Data เราสามารถดึงข้อมูลประมาณการผ่าน JPQL หรือการสืบค้นแบบเนทีฟได้เช่นกัน ตัวอย่างเช่น ในแอปพลิเคชันนี้ เราใช้ JPQL

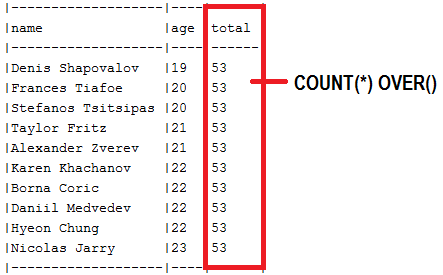

ตัวอย่างผลลัพธ์ (เลือก 2 แถวแรก เลือกเฉพาะ "ชื่อ" และ "อายุ"):

| หากคุณต้องการเจาะลึกสูตรประสิทธิภาพที่เปิดเผยในพื้นที่เก็บข้อมูลนี้ ฉันแน่ใจว่าคุณจะต้องชอบหนังสือของฉัน "Spring Boot Persistence Best Practices" | หากคุณต้องการเคล็ดลับและภาพประกอบเกี่ยวกับปัญหาประสิทธิภาพการคงอยู่ของ Java มากกว่า 100 รายการ "คู่มือภาพประกอบประสิทธิภาพ Java Persistence" เหมาะสำหรับคุณ |

|

|

คำอธิบาย: ตามค่าเริ่มต้น คุณลักษณะของเอนทิตีจะถูกโหลดอย่างกระตือรือร้น (ทั้งหมดในครั้งเดียว) แต่เราก็สามารถโหลดมัน แบบขี้เกียจ ได้เช่นกัน สิ่งนี้มีประโยชน์สำหรับประเภทคอลัมน์ที่เก็บข้อมูลจำนวนมาก: CLOB , BLOB , VARBINARY ฯลฯ หรือ รายละเอียด ที่ควรโหลดตามความต้องการ ในแอปพลิเคชันนี้ เรามีเอนทิตีชื่อ Author คุณสมบัติคือ: id name genre avatar และ age และเราต้องการโหลด avatar ขี้เกียจ ดังนั้น ควรโหลด avatar ตามความต้องการ

ประเด็นสำคัญ:

pom.xml เปิดใช้งานการ เพิ่มประสิทธิภาพ Hibernate bytecode (เช่นใช้ Maven bytecode Enhancement Plugin )@Basic(fetch = FetchType.LAZY)application.properties ให้ปิดการใช้งาน Open Session ใน View ตรวจสอบด้วย:

- ค่าเริ่มต้นสำหรับแอตทริบิวต์ Lazy Loaded

- แอตทริบิวต์ Lazy Loading และ Jackson Serialization

คำอธิบาย: พร็อกซีไฮเบอร์เนตจะมีประโยชน์เมื่อเอนทิตีลูกสามารถคงอยู่โดยมีการอ้างอิงไปยังพาเรนต์ (การเชื่อมโยง @ManyToOne หรือ @OneToOne ) ในกรณีเช่นนี้ การดึงข้อมูลเอนทิตีหลักจากฐานข้อมูล (ดำเนินการคำสั่ง SELECT ) ถือเป็นการลงโทษด้านประสิทธิภาพและเป็นการกระทำที่ไม่มีจุดหมาย เนื่องจาก Hibernate สามารถตั้งค่าคีย์ต่างประเทศที่สำคัญสำหรับพร็อกซีที่ไม่ได้กำหนดค่าเริ่มต้นได้

ประเด็นสำคัญ:

EntityManager#getReference()JpaRepository#getOne() -> ใช้ในตัวอย่างนี้load()Author และ Book เกี่ยวข้องกับการเชื่อมโยง @ManyToOne ทิศทางเดียว ( Author คือฝั่งผู้ปกครอง)SELECT ) เราสร้างหนังสือเล่มใหม่ เราตั้งค่าพร็อกซีเป็นผู้แต่งสำหรับหนังสือเล่มนี้ และเราบันทึกหนังสือ (ซึ่งจะทริกเกอร์ INSERT ในตาราง book )ตัวอย่างผลลัพธ์:

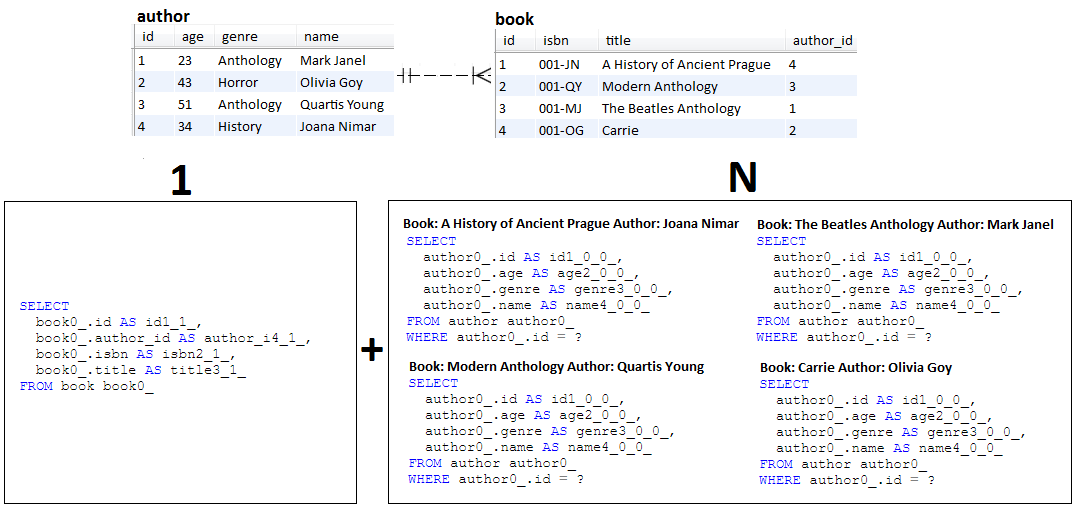

INSERT เท่านั้นที่ถูกทริกเกอร์และไม่มี SELECTคำอธิบาย: N+1 เป็นปัญหาของการดึงข้อมูลแบบขี้เกียจ (แต่ความกระตือรือร้นไม่ได้รับการยกเว้น) แอปพลิเคชันนี้จำลองพฤติกรรม N+1

ประเด็นสำคัญ:

Author และ Book ในการเชื่อมโยง @OneToMany แบบสองทิศทางแบบขี้เกียจBook ขี้เกียจทั้งหมดดังนั้นจึงไม่มี Author (ผลลัพธ์ใน 1 แบบสอบถาม)Book ที่ดึงมาและสำหรับแต่ละรายการจะดึงข้อมูล Author ที่เกี่ยวข้อง (ผลลัพธ์ N แบบสอบถาม)Author ทั้งหมดขี้เกียจ ดังนั้นโดยไม่ต้อง Book (ผลลัพธ์ใน 1 แบบสอบถาม)Author ที่ดึงข้อมูลและสำหรับแต่ละรายการดึงข้อมูล Book ที่เกี่ยวข้อง (ผลลัพธ์ N แบบสอบถาม) ตัวอย่างผลลัพธ์:

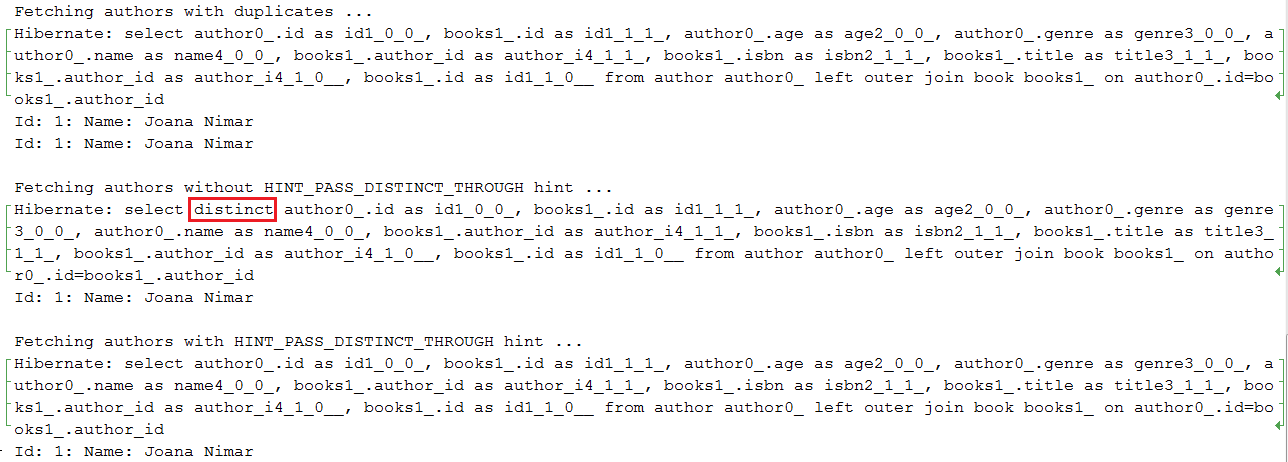

SELECT DISTINCT ให้เหมาะสมผ่านไฮเบอร์เนต HINT_PASS_DISTINCT_THROUGH คำอธิบาย: เริ่มต้นด้วย Hibernate 5.2.2 เราสามารถเพิ่มประสิทธิภาพเอนทิตีการสืบค้น JPQL (HQL) ประเภท SELECT DISTINCT ผ่าน HINT_PASS_DISTINCT_THROUGH คำแนะนำ โปรดทราบว่าคำใบ้นี้มีประโยชน์สำหรับการสืบค้น JPQL (HQL) JOIN FETCH เท่านั้น ไม่มีประโยชน์สำหรับการสืบค้นแบบสเกลาร์ (เช่น List<Integer> ), DTO หรือ HHH-13280 ในกรณีเช่นนี้ จำเป็นต้องส่งคีย์เวิร์ด DISTINCT JPQL ไปยังเคียวรี SQL ที่เกี่ยวข้อง ซึ่งจะสั่งให้ฐานข้อมูลลบรายการที่ซ้ำกันออกจากชุดผลลัพธ์

ประเด็นสำคัญ:

@QueryHints(value = @QueryHint(name = HINT_PASS_DISTINCT_THROUGH, value = "false")) ตัวอย่างผลลัพธ์:

หมายเหตุ: กลไก Hibernate Dirty Checking มีหน้าที่ระบุการแก้ไขเอนทิตีในเวลาฟลัช และเพื่อทริกเกอร์คำสั่ง UPDATE ที่เกี่ยวข้องในนามของเรา

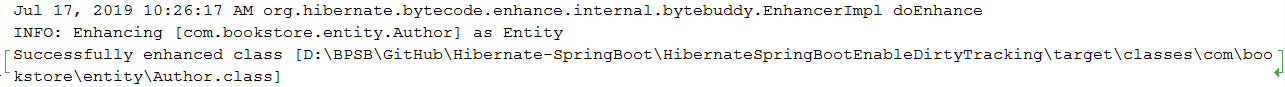

คำอธิบาย: ก่อน Hibernate เวอร์ชัน 5 กลไก Dirty Checking อาศัย Java Reflection API ในการตรวจสอบทุกคุณสมบัติของทุกเอนทิตีที่ได้รับการจัดการ เริ่มต้นด้วย Hibernate เวอร์ชัน 5 กลไก Dirty Checking สามารถพึ่งพากลไก Dirty Tracking (ซึ่งเป็นความสามารถของเอนทิตีในการติดตามการเปลี่ยนแปลงคุณลักษณะของตนเอง) ซึ่งจำเป็นต้องมี Hibernate Bytecode Enhancement เพื่อแสดงอยู่ในแอปพลิเคชัน กลไก Dirty Tracking ช่วยรักษาประสิทธิภาพที่ดีขึ้น โดยเฉพาะอย่างยิ่งเมื่อคุณมีเอนทิตีจำนวนมาก

สำหรับ Dirty Tracking ในระหว่างกระบวนการ Bytecode Enhancement คลาสเอนทิตี bytecode จะถูกควบคุมโดย Hibernate โดยการเพิ่ม tracker $$_hibernate_tracker ในเวลาล้างข้อมูล Hibernate จะใช้ ตัวติดตาม นี้เพื่อค้นหาการเปลี่ยนแปลงเอนทิตี ( ตัวติดตาม เอนทิตีแต่ละตัวจะรายงานการเปลี่ยนแปลง) ซึ่งดีกว่าการตรวจสอบทุกคุณสมบัติของทุกเอนทิตีที่ได้รับการจัดการ

โดยทั่วไป (โดยค่าเริ่มต้น) เครื่องมือจะเกิดขึ้นในเวลาบิลด์ แต่สามารถกำหนดค่าให้เกิดขึ้นขณะรันไทม์หรือเวลาปรับใช้ได้เช่นกัน ขอแนะนำให้เกิดขึ้นในขณะสร้างเพื่อหลีกเลี่ยงค่าใช้จ่ายในรันไทม์

การเพิ่ม Bytecode Enhancement และการเปิดใช้งาน Dirty Tracking สามารถทำได้ผ่านปลั๊กอินที่เพิ่มผ่าน Maven หรือ Gradle (สามารถใช้ Ant ได้เช่นกัน) เราใช้ Maven ดังนั้นเราจึงเพิ่มมันลงใน pom.xml

ประเด็นสำคัญ:

pom.xml ตัวอย่างผลลัพธ์:

สามารถดูเอฟเฟกต์ Bytecode Enhancement ได้ใน Author.class ที่นี่ สังเกตว่า bytecode ถูกควบคุมด้วย $$_hibernate_tracker อย่างไร

Optional Java 8 ในเอนทิตีและแบบสอบถาม คำอธิบาย: แอปพลิเคชันนี้คือตัวอย่างวิธีที่ถูกต้องในการใช้ Java 8 Optional ในเอนทิตีและการสืบค้น

ประเด็นสำคัญ:

Optional (เช่น findById() )OptionalOptional ในเอนทิตี gettersdata-mysql.sql@OneToMany คำอธิบาย: แอปพลิเคชันนี้เป็นข้อพิสูจน์แนวคิดเกี่ยวกับวิธีการที่ถูกต้องในการใช้การเชื่อมโยง @OneToMany แบบสองทิศทางจากมุมมองของประสิทธิภาพ

ประเด็นสำคัญ:

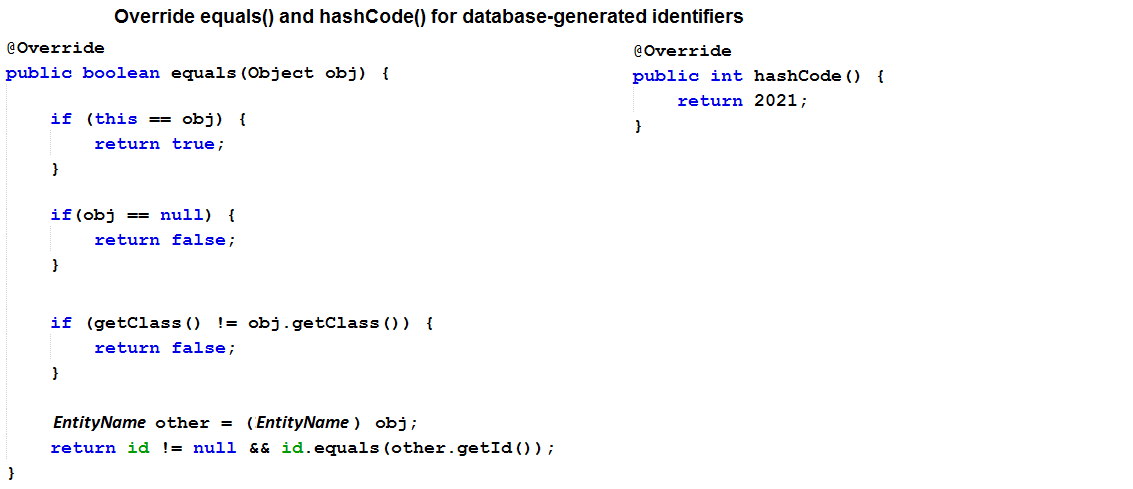

mappedBy บนพาเรนต์orphanRemoval บน parent เพื่อลบรายการลูกโดยไม่มีการอ้างอิง@NaturalId )) และ/หรือตัวระบุที่สร้างจากฐานข้อมูล และแทนที่ (บนฝั่งลูก) วิธีการ equals() และ hashCode() อย่างถูกต้องตาม ที่นี่toString() ให้ใส่ใจที่จะเกี่ยวข้องเฉพาะคุณลักษณะพื้นฐานที่ดึงมาเมื่อเอนทิตีถูกโหลดจากฐานข้อมูล หมายเหตุ: โปรดใส่ใจกับการลบการดำเนินการ โดยเฉพาะอย่างยิ่งการลบเอนทิตีลูก CascadeType.REMOVE และ orphanRemoval=true อาจทำให้เกิดแบบสอบถามมากเกินไป ในสถานการณ์ดังกล่าว การใช้การดำเนินการ จำนวนมาก เป็นวิธีที่ดีที่สุดในการลบโดยส่วนใหญ่

คำอธิบาย: แอปพลิเคชันนี้คือตัวอย่างวิธีเขียนแบบสอบถามผ่าน JpaRepository , EntityManager และ Session

ประเด็นสำคัญ:

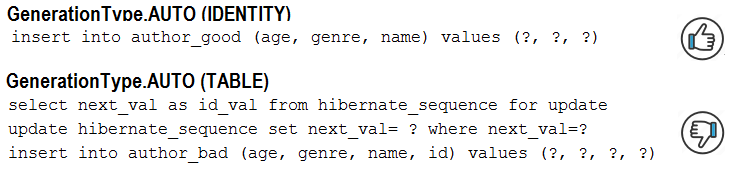

JpaRepository ให้ใช้ @Query หรือ Spring Data Query CreationEntityManager และ Session ให้ใช้เมธอด createQuery()AUTO ใน Hibernate 5 และ MySQL คำอธิบาย: ใน MySQL และ Hibernate 5 ประเภทตัวสร้าง GenerationType.AUTO จะส่งผลให้มีการใช้ตัวสร้าง TABLE นี่เป็นการเพิ่มบทลงโทษด้านประสิทธิภาพที่สำคัญ การเปลี่ยนพฤติกรรมนี้เป็นตัวสร้าง IDENTITY สามารถรับได้โดยใช้ GenerationType.IDENTITY หรือตัวสร้าง ดั้งเดิม

ประเด็นสำคัญ:

GenerationType.IDENTITY แทน GenerationType.AUTO ตัวอย่างผลลัพธ์:

คำอธิบาย: แอปพลิเคชันนี้เป็นตัวอย่างเมื่อการเรียก save() สำหรับเอนทิตีซ้ำซ้อน (ไม่จำเป็น)

ประเด็นสำคัญ:

UPDATE ที่เกี่ยวข้องโดยอัตโนมัติโดยไม่จำเป็นต้องเรียกใช้เมธอด save() อย่างชัดเจนsave() เมื่อไม่จำเป็น) จะไม่ส่งผลกระทบต่อจำนวนการสืบค้นที่ถูกทริกเกอร์ แต่มันแสดงถึงการปรับประสิทธิภาพในกระบวนการ Hibernate พื้นฐาน| หากคุณต้องการเจาะลึกสูตรประสิทธิภาพที่เปิดเผยในพื้นที่เก็บข้อมูลนี้ ฉันแน่ใจว่าคุณจะต้องชอบหนังสือของฉัน "Spring Boot Persistence Best Practices" | หากคุณต้องการเคล็ดลับและภาพประกอบเกี่ยวกับปัญหาประสิทธิภาพการคงอยู่ของ Java มากกว่า 100 รายการ "คู่มือภาพประกอบประสิทธิภาพ Java Persistence" เหมาะสำหรับคุณ |

|

|

BIG ) SERIAL ในการแทรกแบบแบตช์ผ่าน Hibernate คำอธิบาย: ใน PostgreSQL การใช้ GenerationType.IDENTITY จะปิดใช้งานการแทรกแบตช์ (BIG)SERIAL ทำหน้าที่ "เกือบ" เช่น MySQL, AUTO_INCREMENT ในแอปพลิเคชันนี้ เราใช้ GenerationType.SEQUENCE ซึ่งอนุญาตให้มีการแทรกเป็นชุด และเราปรับให้เหมาะสมผ่านอัลกอริธึมการเพิ่มประสิทธิภาพ hi/lo

ประเด็นสำคัญ:

GenerationType.SEQUENCE แทน GenerationType.IDENTITYhi/lo เพื่อดึงค่า hi ในฐานข้อมูลไปกลับ (ค่า hi มีประโยชน์สำหรับการสร้างตัวระบุในหน่วยความจำตามจำนวน/ที่กำหนด จนกว่าคุณจะใช้ตัวระบุในหน่วยความจำไม่หมดก็ไม่จำเป็น เพื่อเรียก สวัสดี อีกครั้ง)pooled และ pooled-lo (นี่คือการปรับให้เหมาะสมของ hi/lo ที่อนุญาตให้บริการภายนอกใช้ฐานข้อมูลโดยไม่ทำให้เกิดข้อผิดพลาดของคีย์การทำซ้ำ)spring.datasource.hikari.data-source-properties.reWriteBatchedInserts=true ตัวอย่างผลลัพธ์:

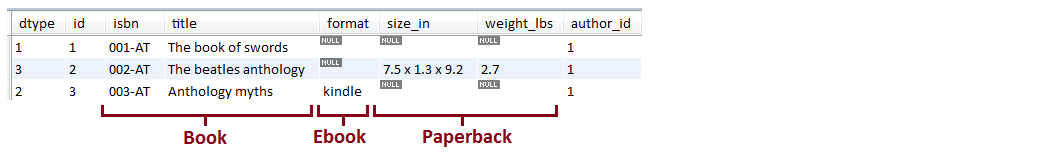

SINGLE_TABLE คำอธิบาย: แอปพลิเคชันนี้คือตัวอย่างการใช้กลยุทธ์การสืบทอด JPA Single Table ( SINGLE_TABLE )

ประเด็นสำคัญ:

@Inheritance(strategy=InheritanceType.SINGLE_TABLE) )@NotNull และ MySQLTINYINT ตัวอย่างผลลัพธ์ (ด้านล่างเป็นตารางเดียวที่ได้รับจาก 3 เอนทิตี):

คำอธิบาย: แอปพลิเคชั่นนี้เป็นตัวอย่างของการนับและยืนยันคำสั่ง SQL ที่ถูกทริกเกอร์ "เบื้องหลัง" มีประโยชน์มากในการนับคำสั่ง SQL เพื่อให้แน่ใจว่าโค้ดของคุณไม่ได้สร้างคำสั่ง SQL มากขึ้นอย่างที่คุณคิด (เช่น สามารถตรวจพบ N+1 ได้ง่ายโดยการยืนยันจำนวนคำสั่งที่คาดหวัง)

ประเด็นสำคัญ:

pom.xml ให้เพิ่มการพึ่งพาสำหรับไลบรารี DataSource-Proxy และไลบรารี db-util ของ Vlad MihalceaProxyDataSourceBuilder ด้วย countQuery()SQLStatementCountValidator.reset()INSERT , UPDATE , DELETE และ SELECT ผ่าน assertInsert/Update/Delete/Select/Count(long expectedNumberOfSql) ตัวอย่างผลลัพธ์ (เมื่อจำนวน SQL ที่คาดหวังไม่เท่ากับความเป็นจริง ข้อยกเว้นจะเกิดขึ้น):

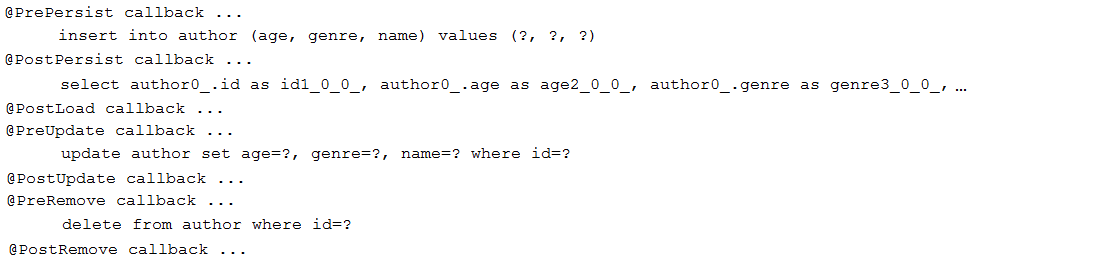

คำอธิบาย: แอปพลิเคชันนี้เป็นตัวอย่างการตั้งค่าการเรียกกลับ JPA ( Pre/PostPersist , Pre/PostUpdate , Pre/PostRemove และ PostLoad )

ประเด็นสำคัญ:

void และไม่มีการโต้แย้ง ตัวอย่างผลลัพธ์:

@MapsId สำหรับการแชร์ตัวระบุในความสัมพันธ์ @OneToOne คำอธิบาย: แทนที่จะใช้ @OneToOne แบบทิศทางเดียว/สองทิศทาง ปกติ ควรพึ่งพา @OneToOne และ @MapsId แบบทิศทางเดียวจะดีกว่า แอปพลิเคชันนี้เป็นข้อพิสูจน์แนวคิด

ประเด็นสำคัญ:

@MapsId บนฝั่งลูก@JoinColumn เพื่อปรับแต่งชื่อของคอลัมน์คีย์หลัก@OneToOne @MapsId จะแชร์คีย์หลักกับตารางหลัก (คุณสมบัติ id ทำหน้าที่เป็นทั้งคีย์หลักและคีย์ต่างประเทศ)บันทึก:

@MapsId สามารถใช้กับ @ManyToOne ได้เช่นกันSqlResultSetMapping และ EntityManager คำอธิบาย: การดึงข้อมูลเกินความจำเป็นมีแนวโน้มที่จะถูกลงโทษด้านประสิทธิภาพ การใช้ DTO ช่วยให้เราสามารถดึงเฉพาะข้อมูลที่จำเป็นเท่านั้น ในแอปพลิเคชันนี้เราใช้ SqlResultSetMapping และ EntityManager

ประเด็นสำคัญ:

SqlResultSetMapping และ EntityManagerSqlResultSetMapping และ NamedNativeQuery หมายเหตุ: หากคุณต้องการใช้หลักการตั้งชื่อ {EntityName}.{RepositoryMethodName} เพียงสร้างวิธีอินเทอร์เฟซของพื้นที่เก็บข้อมูลที่มีชื่อเดียวกันกับแบบสอบถามที่มีชื่อดั้งเดิม ให้ข้ามแอปพลิเคชันนี้และตรวจสอบอันนี้

คำอธิบาย: การดึงข้อมูลเกินความจำเป็นมีแนวโน้มที่จะถูกลงโทษด้านประสิทธิภาพ การใช้ DTO ช่วยให้เราสามารถดึงเฉพาะข้อมูลที่จำเป็นเท่านั้น ในแอปพลิเคชันนี้เราใช้ SqlResultSetMapping , NamedNativeQuery

ประเด็นสำคัญ:

SqlResultSetMapping , NamedNativeQueryjavax.persistence.Tuple และ Native SQL คำอธิบาย: การดึงข้อมูลเกินความจำเป็นมีแนวโน้มที่จะถูกลงโทษด้านประสิทธิภาพ การใช้ DTO ช่วยให้เราสามารถดึงเฉพาะข้อมูลที่จำเป็นเท่านั้น ในแอปพลิเคชันนี้ เราใช้ javax.persistence.Tuple และ Native SQL

ประเด็นสำคัญ:

java.persistence.Tuple ในที่เก็บ Spring และทำเครื่องหมายคิวรีเป็น nativeQuery = truejavax.persistence.Tuple และ JPQL คำอธิบาย: การดึงข้อมูลเกินความจำเป็นมีแนวโน้มที่จะถูกลงโทษด้านประสิทธิภาพ การใช้ DTO ช่วยให้เราสามารถดึงเฉพาะข้อมูลที่จำเป็นเท่านั้น ในแอปพลิเคชันนี้ เราใช้ javax.persistence.Tuple และ JPQL

ประเด็นสำคัญ:

java.persistence.Tuple ในพื้นที่เก็บข้อมูล Springคำอธิบาย: การดึงข้อมูลเกินความจำเป็นมีแนวโน้มที่จะถูกลงโทษด้านประสิทธิภาพ การใช้ DTO ช่วยให้เราสามารถดึงเฉพาะข้อมูลที่จำเป็นเท่านั้น ในแอปพลิเคชันนี้ เราอาศัย Constructor Expression และ JPQL

ประเด็นสำคัญ:

SELECT new com.bookstore.dto.AuthorDto(a.name, a.age) FROM Author a ดูเพิ่มเติมที่:

วิธีดึงข้อมูล DTO ผ่านกลไกตัวสร้างแบบสอบถามและ Spring Data Query

| หากคุณต้องการเจาะลึกสูตรประสิทธิภาพที่เปิดเผยในพื้นที่เก็บข้อมูลนี้ ฉันแน่ใจว่าคุณจะต้องชอบหนังสือของฉัน "Spring Boot Persistence Best Practices" | หากคุณต้องการเคล็ดลับและภาพประกอบเกี่ยวกับปัญหาประสิทธิภาพการคงอยู่ของ Java มากกว่า 100 รายการ "คู่มือภาพประกอบประสิทธิภาพ Java Persistence" เหมาะสำหรับคุณ |

|

|

ResultTransformer และ Native SQL คำอธิบาย: การดึงข้อมูลเกินความจำเป็นมีแนวโน้มที่จะได้รับโทษด้านประสิทธิภาพ การใช้ DTO ช่วยให้เราสามารถดึงเฉพาะข้อมูลที่จำเป็นเท่านั้น ในแอปพลิเคชันนี้ เราใช้ Hibernate, ResultTransformer และ Native SQL

ประเด็นสำคัญ:

AliasToBeanConstructorResultTransformer สำหรับ DTO โดยไม่มีตัวตั้งค่า แต่มีตัวสร้างTransformers.aliasToBean() สำหรับ DTO พร้อมตัวตั้งค่าEntityManager.createNativeQuery() และ unwrap(org.hibernate.query.NativeQuery.class)ResultTransformer จะเลิกใช้แล้ว แต่จนกว่าจะมีการเปลี่ยนใหม่ (อาจเป็นใน Hibernate 6.0) ก็สามารถใช้งานได้ (อ่านเพิ่มเติม)ResultTransformer และ JPQL คำอธิบาย: การดึงข้อมูลเกินความจำเป็นมีแนวโน้มที่จะได้รับโทษด้านประสิทธิภาพ การใช้ DTO ช่วยให้เราสามารถดึงเฉพาะข้อมูลที่จำเป็นเท่านั้น ในแอปพลิเคชันนี้เราใช้ Hibernate, ResultTransformer และ JPQL

ประเด็นสำคัญ:

AliasToBeanConstructorResultTransformer สำหรับ DTO โดยไม่มีตัวตั้งค่า พร้อมด้วยตัวสร้างTransformers.aliasToBean() สำหรับ DTO พร้อมตัวตั้งค่าEntityManager.createQuery() และ unwrap(org.hibernate.query.Query.class)ResultTransformer จะเลิกใช้แล้ว แต่จนกว่าจะมีการเปลี่ยนใหม่ (ใน Hibernate 6.0) ก็สามารถใช้งานได้ (อ่านเพิ่มเติม)คำอธิบาย: การดึงข้อมูลเกินความจำเป็นมีแนวโน้มที่จะถูกลงโทษด้านประสิทธิภาพ การใช้ DTO ช่วยให้เราสามารถดึงเฉพาะข้อมูลที่จำเป็นเท่านั้น ในแอปพลิเคชันนี้ เราอาศัยมุมมองเอนทิตี Blaze-Persistence

ประเด็นสำคัญ:

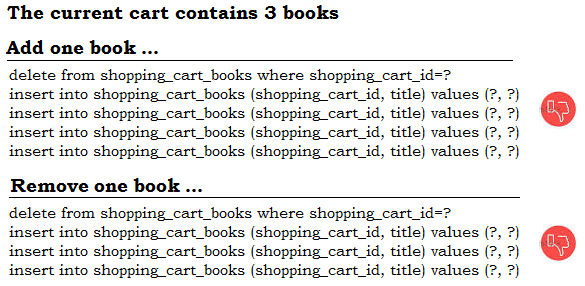

pom.xml การขึ้นต่อกันเฉพาะของ Blaze-PersistenceCriteriaBuilderFactory และ EntityViewManagerEntityViewRepositoryfindAll() , findOne() เป็นต้น@ElementCollection ปกติ (ไม่มี @OrderColumn ) ทำงานอย่างไร คำอธิบาย: แอปพลิเคชั่นนี้เปิดเผยบทลงโทษด้านประสิทธิภาพที่เป็นไปได้ของการใช้ @ElementCollection ในกรณีนี้ โดยไม่มี @OrderColumn ดังที่คุณเห็นในรายการถัดไป (34) การเพิ่ม @OrderColumn สามารถลดการลงโทษด้านประสิทธิภาพบางอย่างได้

ประเด็นสำคัญ:

@ElementCollection ไม่มีคีย์หลัก@ElementCollection ถูกแมปในตารางแยกต่างหาก@ElementCollection เมื่อคุณมีส่วนแทรก/ลบจำนวนมากในคอลเลกชันนี้ การแทรก/การลบจะทำให้ไฮเบอร์เนตลบแถวตารางที่มีอยู่ทั้งหมด ประมวลผลคอลเลกชันในหน่วยความจำ และแทรกแถวตารางที่เหลืออีกครั้งเพื่อสะท้อนคอลเลกชันจากหน่วยความจำ ตัวอย่างผลลัพธ์:

@ElementCollection ด้วย @OrderColumn ทำงานอย่างไร คำอธิบาย: แอปพลิเคชันนี้เปิดเผยบทลงโทษด้านประสิทธิภาพของการใช้ @ElementCollection ในกรณีนี้ด้วย @OrderColumn แต่อย่างที่คุณเห็นในแอปพลิเคชันนี้ (เมื่อเปรียบเทียบกับรายการที่ 33) การเพิ่ม @OrderColumn สามารถลดบทลงโทษด้านประสิทธิภาพบางอย่างได้ เมื่อการดำเนินการเกิดขึ้นใกล้กับส่วนท้ายของคอลเลกชัน (เช่น เพิ่ม/ลบที่/จากจุดสิ้นสุดของคอลเลกชัน) โดยหลักแล้ว องค์ประกอบทั้งหมดที่อยู่ก่อนรายการเพิ่ม/ลบจะไม่ถูกแตะต้อง ดังนั้นจึงสามารถละเว้นการปรับประสิทธิภาพการทำงานได้หากเราส่งผลกระทบต่อแถวใกล้กับส่วนท้ายของคอลเลกชัน

ประเด็นสำคัญ:

@ElementCollection ไม่มีคีย์หลัก@ElementCollection ถูกแมปในตารางแยกต่างหาก@ElementCollection กับ @OrderColumn เมื่อคุณมีส่วนแทรกและการลบจำนวนมากใกล้กับส่วนท้ายของคอลเลกชัน ตัวอย่างผลลัพธ์:

หมายเหตุ: ก่อนที่จะอ่านรายการนี้ลองดูว่า Hibernate5Module ไม่ใช่สิ่งที่คุณกำลังมองหาหรือไม่

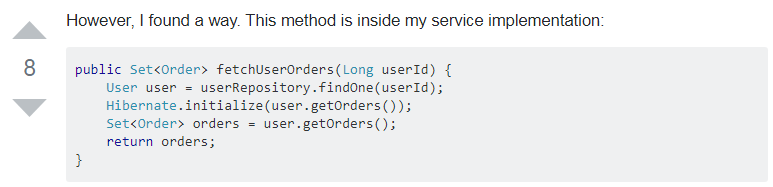

คำอธิบาย: รูปแบบการป้องกัน Open-Session ใน View ถูกเปิดใช้งานตามค่าเริ่มต้นใน SpringBoot ตอนนี้ ลองจินตนาการถึงความสัมพันธ์ที่ขี้เกียจ (เช่น @OneToMany ) ระหว่างสองเอนทิตี Author และ Book (ผู้เขียนได้เชื่อมโยงหนังสือมากกว่า) จากนั้น จุดสิ้นสุดของคอนโทรลเลอร์ REST จะดึงข้อมูล Author โดยไม่มี Book ที่เกี่ยวข้อง แต่มุมมอง (แจ็คสัน) บังคับให้มีการโหลด Book ที่เกี่ยวข้องอย่างเกียจคร้านเช่นกัน เนื่องจาก OSIV จะจัดหา Session ที่เปิดไว้แล้ว การเริ่มต้นพรอกซีจึงเกิดขึ้นได้สำเร็จ แนวทางแก้ไขเพื่อหลีกเลี่ยงการลงโทษด้านประสิทธิภาพนี้เริ่มต้นโดยการปิดใช้งาน OSIV นอกจากนี้ ให้เริ่มต้นการเชื่อมโยงแบบ Lazy ที่ไม่ได้ดึงข้อมูลไว้อย่างชัดเจน ด้วยวิธีนี้ View จะไม่บังคับให้โหลดแบบ Lazy Loading

ประเด็นสำคัญ:

application.properties การตั้งค่านี้: spring.jpa.open-in-view=falseAuthor และเริ่มต้น Book ที่เกี่ยวข้องอย่างชัดเจนด้วยค่า (ค่าเริ่มต้น) (เช่น null )@JsonInclude(Include.NON_EMPTY) บนระดับเอนทิตีนี้เพื่อหลีกเลี่ยงการแสดงผล null หรือสิ่งที่ถือว่าว่างเปล่าใน JSON ผลลัพธ์ หมายเหตุ: หากเปิดใช้งาน OSIV นักพัฒนายังคงสามารถเริ่มต้นการเชื่อมโยง Lazy ที่ไม่ได้ดึงข้อมูลได้ด้วยตนเอง ตราบใดที่เขาทำสิ่งนี้นอกธุรกรรมเพื่อหลีกเลี่ยงการฟลัช แต่ทำไมสิ่งนี้ถึงได้ผล? เนื่องจาก Session เปิดอยู่ เหตุใดการเริ่มต้นการเชื่อมโยงของเอนทิตีที่ได้รับการจัดการด้วยตนเองจึงไม่ทำให้เกิดการฟลัช คำตอบสามารถพบได้ในเอกสารประกอบของ OpenSessionInViewFilter ซึ่งระบุว่า: โดยค่าเริ่มต้น ตัวกรองนี้จะไม่ล้าง Hibernate Session โดยที่โหมดล้างตั้งค่าเป็น FlushMode.NEVER ถือว่าใช้ร่วมกับธุรกรรมชั้นบริการที่ดูแลการฟลัช: ตัวจัดการธุรกรรมที่ใช้งานอยู่จะเปลี่ยนโหมดฟลัชชั่วคราวเป็น FlushMode.AUTO ในระหว่างการทำธุรกรรมอ่าน-เขียน โดยโหมดฟลัชจะรีเซ็ตเป็น FlushMode.NEVER ในตอนท้าย ของแต่ละธุรกรรม หากคุณต้องการใช้ตัวกรองนี้โดยไม่มีธุรกรรม ให้พิจารณาเปลี่ยนโหมดฟลัชเริ่มต้น (ผ่านคุณสมบัติ "flushMode")

คำอธิบาย: แอปพลิเคชันนี้เป็นข้อพิสูจน์แนวคิดในการใช้ Spring Projections (DTO) และการรวมภายในที่เขียนผ่าน JPQL และ SQL ดั้งเดิม (สำหรับ MySQL)

ประเด็นสำคัญ:

Author และ Book ในการเชื่อมโยง @OneToMany แบบสองทิศทาง (ขี้เกียจ))resources/data-mysql.sql )AuthorNameBookTitle.java )

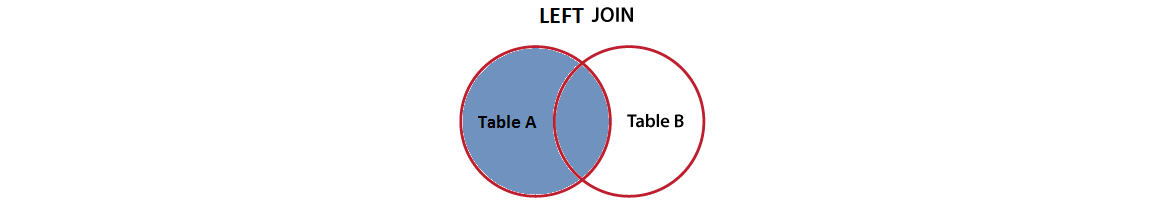

คำอธิบาย: แอปพลิเคชันนี้เป็นข้อพิสูจน์แนวคิดในการใช้ Spring Projections (DTO) และการรวมด้านซ้ายที่เขียนผ่าน JPQL และ SQL ดั้งเดิม (สำหรับ MySQL)

ประเด็นสำคัญ:

Author และ Book ในสมาคม @OneToMany สองทิศทาง (ขี้เกียจ))resources/data-mysql.sql )AuthorNameBookTitle.java )

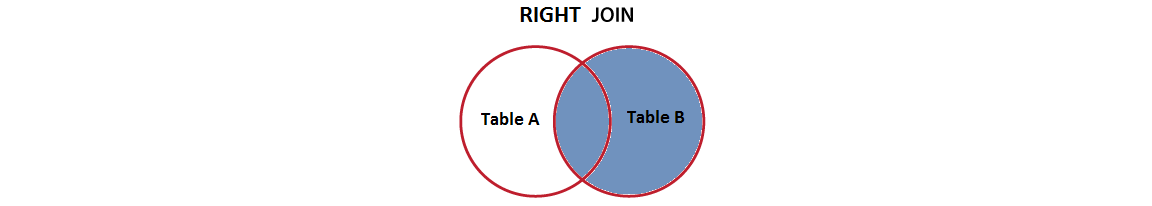

คำอธิบาย: แอปพลิเคชั่นนี้เป็นหลักฐานของแนวคิดสำหรับการใช้การคาดการณ์ฤดูใบไม้ผลิ (DTO) และการเข้าร่วมขวาที่เขียนผ่าน JPQL และ SQL ดั้งเดิม (สำหรับ MySQL)

ประเด็นสำคัญ:

Author และ Book ในสมาคม @OneToMany สองทิศทาง (ขี้เกียจ))resources/data-mysql.sql )AuthorNameBookTitle.java )

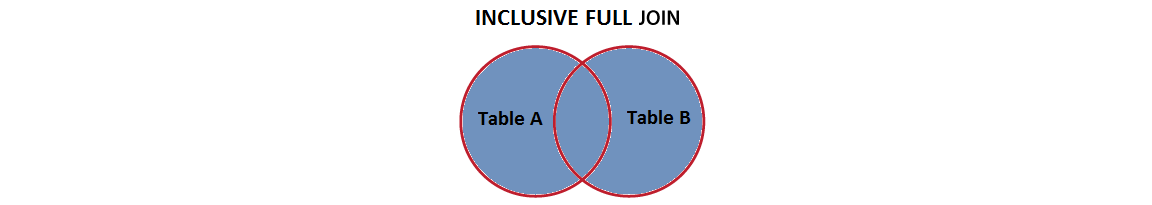

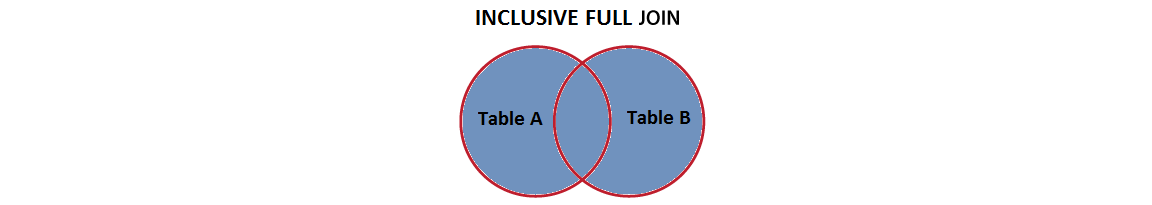

คำอธิบาย: แอปพลิเคชันนี้เป็นหลักฐานของแนวคิดสำหรับการใช้การคาดการณ์ฤดูใบไม้ผลิ (DTO) และรวมเข้าด้วยกันอย่างเต็มรูปแบบเขียนผ่าน JPQL และ SQL ดั้งเดิม (สำหรับ PostgreSQL)

ประเด็นสำคัญ:

Author และ Book ในสมาคม @OneToMany สองทิศทาง (ขี้เกียจ))resources/data-mysql.sql )AuthorNameBookTitle.java )| หากคุณต้องการการดำน้ำลึกลงไปในสูตรการแสดงที่เปิดเผยในที่เก็บนี้ฉันมั่นใจว่าคุณจะรักหนังสือของฉัน | หากคุณต้องการเคล็ดลับและภาพประกอบของปัญหาประสิทธิภาพการคงอยู่ของ Java มากกว่า 100 รายการแล้ว |

|

|

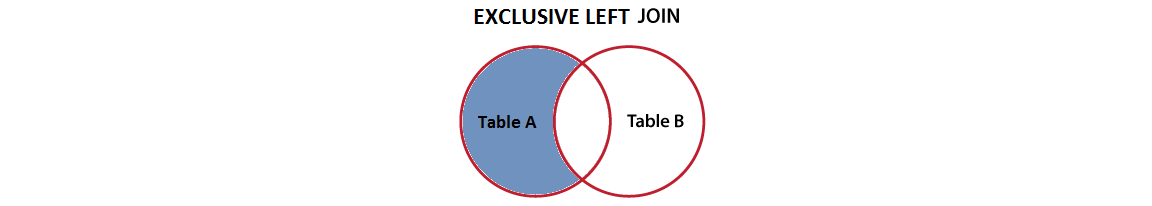

คำอธิบาย: แอปพลิเคชันนี้เป็นหลักฐานของแนวคิดสำหรับการใช้การคาดการณ์ฤดูใบไม้ผลิ (DTO) และการเข้าร่วมซ้ายสุดพิเศษที่เขียนผ่าน JPQL และ SQL ดั้งเดิม (สำหรับ MySQL)

ประเด็นสำคัญ:

Author และ Book ในสมาคม @OneToMany สองทิศทาง (ขี้เกียจ))resources/data-mysql.sql )AuthorNameBookTitle.java )

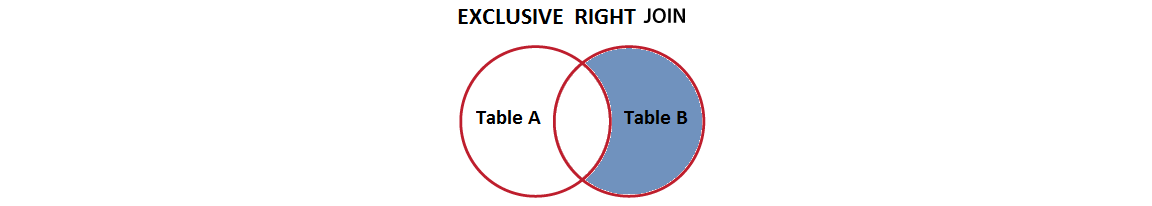

คำอธิบาย: แอปพลิเคชันนี้เป็นหลักฐานของแนวคิดสำหรับการใช้การคาดการณ์ฤดูใบไม้ผลิ (DTO) และการเข้าร่วมที่ถูกต้องพิเศษที่เขียนผ่าน JPQL และ SQL ดั้งเดิม (สำหรับ MySQL)

ประเด็นสำคัญ:

Author และ Book ในสมาคม @OneToMany สองทิศทาง (ขี้เกียจ))resources/data-mysql.sql )AuthorNameBookTitle.java )

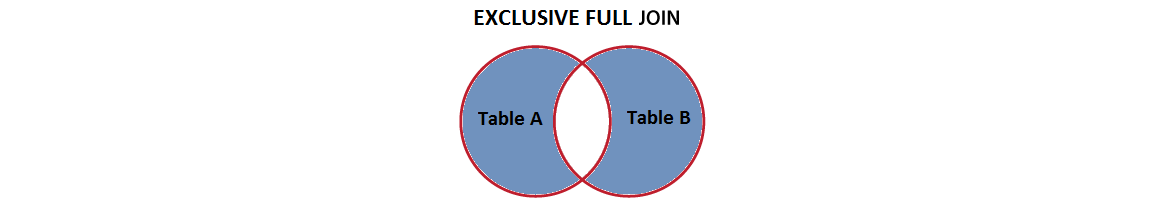

คำอธิบาย: แอปพลิเคชันนี้เป็นหลักฐานของแนวคิดสำหรับการใช้การคาดการณ์ฤดูใบไม้ผลิ (DTO) และการเข้าร่วมเต็มรูปแบบพิเศษที่เขียนผ่าน JPQL และ SQL ดั้งเดิม (สำหรับ PostgreSQL)

ประเด็นสำคัญ:

Author และ Book ในสมาคม @OneToMany สองทิศทาง (ขี้เกียจ))resources/data-mysql.sql )AuthorNameBookTitle.java )คำอธิบาย: แอปพลิเคชันนี้เป็นหลักฐานของแนวคิดสำหรับการใช้ตะขอหลังสปริงโพสต์คอมมิวนิสต์และวิธีการที่พวกเขาอาจส่งผลกระทบต่อประสิทธิภาพการคงอยู่ของเลเยอร์

ประเด็นสำคัญ:

คำอธิบาย: แอปพลิเคชันนี้เป็นหลักฐานของแนวคิดสำหรับการใช้การคาดการณ์ฤดูใบไม้ผลิ (DTO) และเข้าร่วมเอนทิตีที่ไม่เกี่ยวข้อง Hibernate 5.1 แนะนำการเข้าร่วมอย่างชัดเจนในเอนทิตีที่ไม่เกี่ยวข้องและไวยากรณ์และพฤติกรรมคล้ายกับคำสั่ง SQL JOIN

ประเด็นสำคัญ:

Author และ Book ที่ไม่เกี่ยวข้อง)resources/data-mysql.sql )BookstoreDto )@EqualsAndHashCode และ @Data ในเอนทิตีและวิธีการแทนที่ equals() และ hashCode() คำอธิบาย: เอนทิตีควรใช้ equals() และ hashCode() ตามที่นี่ แนวคิดหลักคือไฮเบอร์เนตต้องการให้เอนทิตีเท่ากับตัวเองในการเปลี่ยนสถานะทั้งหมด ( ชั่วคราว , แนบ , แยกออก และ ลบออก ) การใช้ Lombok @EqualsAndHashCode (หรือ @Data ) จะไม่เคารพข้อกำหนดนี้

ประเด็นสำคัญ:

หลีกเลี่ยงวิธีการเหล่านี้

@EqualsAndHashCode (เอนทิตี: LombokDefaultBook , การทดสอบ: LombokDefaultEqualsAndHashCodeTest )@EqualsAndHashCode กับคีย์หลักเท่านั้น (เอนทิตี: LombokIdBook , ทดสอบ: LombokEqualsAndHashCodeWithIdOnlyTest )equals() และ hashCode() (เอนทิตี: DefaultBook , ทดสอบ: DefaultEqualsAndHashCodeTest )equals() และ hashCode() ที่มีเฉพาะตัวระบุที่สร้างฐานข้อมูล (เอนทิตี: IdBook , ทดสอบ: IdEqualsAndHashCodeTest )ชอบวิธีการเหล่านี้

BusinessKeyBook , การทดสอบ: BusinessKeyEqualsAndHashCodeTest )@NaturalId (เอนทิตี: NaturalIdBook , การทดสอบ: NaturalIdEqualsAndHashCodeTest )IdManBook , การทดสอบ: IdManEqualsAndHashCodeTest )IdGenBook , ทดสอบ: IdGenEqualsAndHashCodeTest )

LazyInitializationException ผ่าน JOIN FETCHดูเพิ่มเติมที่:

คำอธิบาย: โดยทั่วไปเมื่อเราได้รับ LazyInitializationException เรามักจะปรับเปลี่ยนประเภทการดึงข้อมูลการเชื่อมโยงจาก LAZY ถึง EAGER แย่มาก! นี่คือกลิ่นรหัส วิธีที่ดีที่สุดในการหลีกเลี่ยงข้อยกเว้นนี้คือการพึ่งพา JOIN FETCH (หากคุณวางแผนที่จะแก้ไขเอนทิตีที่ดึงมา) หรือ JOIN + DTO (หากข้อมูลที่ดึงมานั้นถูกอ่านเท่านั้น) JOIN FETCH ช่วยให้การเชื่อมโยงเริ่มต้นพร้อมกับวัตถุหลักของพวกเขาโดยใช้ SELECT เดียว สิ่งนี้มีประโยชน์อย่างยิ่งสำหรับการดึงคอลเลกชันที่เกี่ยวข้อง

แอปพลิเคชันนี้เป็นตัวอย่าง JOIN FETCH เพื่อหลีกเลี่ยงการใช้ LazyInitializationException

ประเด็นสำคัญ:

Author และ Book ใน @OneToMany Lazy-Bidirectional Association)JOIN FETCH เพื่อดึงผู้เขียนรวมถึงหนังสือของเขาJOIN FETCH (หรือ JOIN ) เพื่อดึงหนังสือรวมถึงผู้เขียน ตัวอย่างเอาต์พุต:

คำอธิบาย: นี่คือตัวอย่างการบูตฤดูใบไม้ผลิตามบทความต่อไปนี้ เป็นการใช้งานการทำงานของตัวอย่างของ VLAD ขอแนะนำให้อ่านบทความนั้น

ประเด็นสำคัญ:

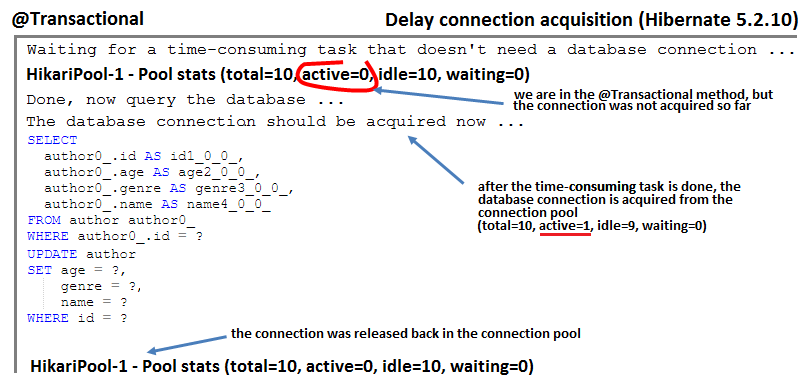

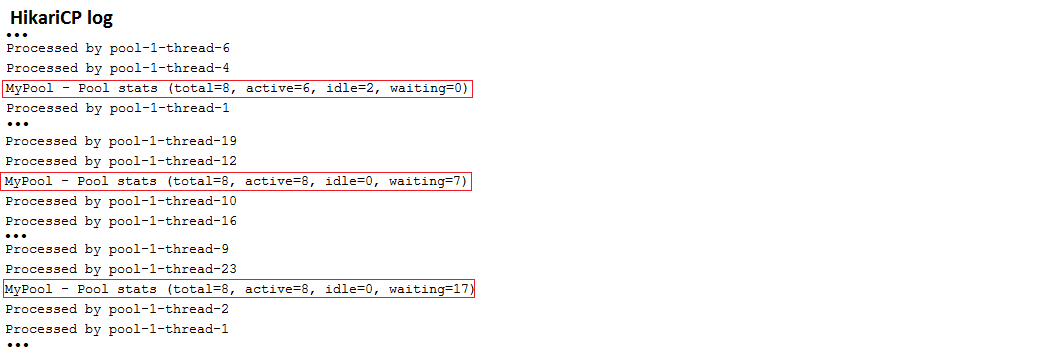

คำอธิบาย: นี่คือตัวอย่างการบูตฤดูใบไม้ผลิที่ใช้ประโยชน์จาก Hibernate 5.2.10 ความสามารถในการชะลอการรับการเชื่อมต่อตามต้องการ โดยค่าเริ่มต้นในโหมด ทรัพยากรท้องถิ่น การเชื่อมต่อฐานข้อมูลจะถูก quried ทันทีหลังจากเรียกวิธีการที่มีคำอธิบายประกอบด้วย @Transactional หากวิธีนี้มีงานที่ใช้เวลานานก่อนที่คำสั่ง SQL ครั้งแรกการเชื่อมต่อจะถูกเปิดไว้โดยไม่มีอะไรเลย แต่ไฮเบอร์เนต 5.2.10 ช่วยให้เราสามารถชะลอการได้มาซึ่งการเชื่อมต่อตามต้องการ ตัวอย่างนี้ขึ้นอยู่กับ Hikaricp เป็นพูลการเชื่อมต่อเริ่มต้นสำหรับการบูตฤดูใบไม้ผลิ

ประเด็นสำคัญ:

spring.datasource.hikari.auto-commit=false ใน application.propertiesspring.jpa.properties.hibernate.connection.provider_disables_autocommit=true ใน application.properties ตัวอย่างเอาต์พุต:

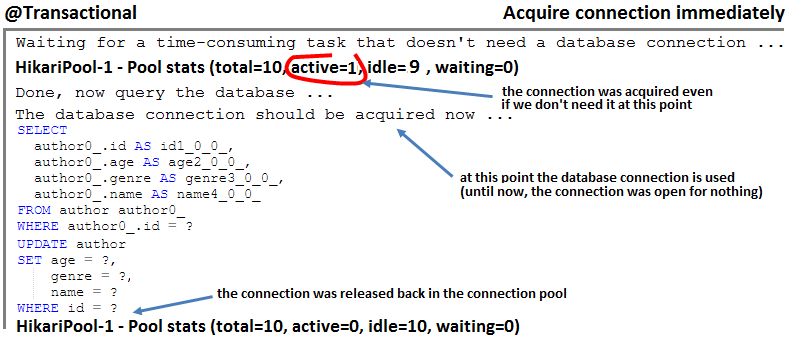

hi/lo หมายเหตุ: หากระบบภายนอกแอปพลิเคชันของคุณจำเป็นต้องแทรกแถวในตารางของคุณอย่าพึ่งพาอัลกอริทึม hi/lo เนื่องจากในกรณีเช่นนี้อาจทำให้เกิดข้อผิดพลาดที่เกิดจากการสร้างตัวระบุซ้ำ พึ่งพาอัลกอริทึม pooled หรือ pooled-lo (การเพิ่มประสิทธิภาพของ hi/lo )

คำอธิบาย: นี่เป็นตัวอย่างการบูตสปริงของการใช้อัลกอริทึม hi/lo สำหรับการสร้างตัวระบุ 1,000 ตัวใน 10 ฐานข้อมูล RoundTrips สำหรับการแบตช์ 1,000 เม็ดมีส่วนร่วมในแบทช์ 30

ประเด็นสำคัญ:

SEQUENCE (เช่นใน PostgreSQL)hi/lo เช่นเดียวกับใน Author.java Entity ตัวอย่างเอาต์พุต:

| หากคุณต้องการการดำน้ำลึกลงไปในสูตรการแสดงที่เปิดเผยในที่เก็บนี้ฉันมั่นใจว่าคุณจะรักหนังสือของฉัน | หากคุณต้องการเคล็ดลับและภาพประกอบของปัญหาประสิทธิภาพการคงอยู่ของ Java มากกว่า 100 รายการแล้ว |

|

|

@ManyToMany Association คำอธิบาย: แอปพลิเคชันนี้เป็นหลักฐานของแนวคิดว่ามันถูกต้องอย่างไรในการใช้สมาคม @ManyToMany แบบสองทิศทางจากมุมมองการปฏิบัติงาน

ประเด็นสำคัญ:

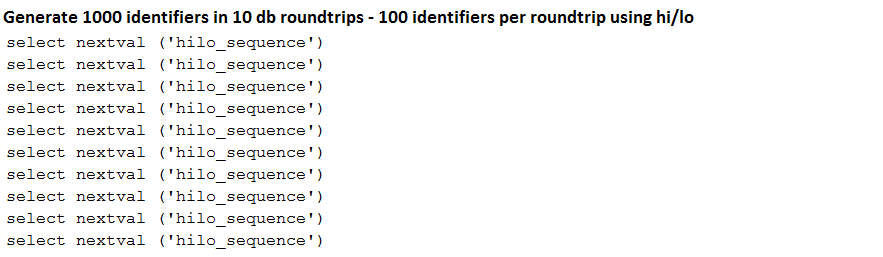

mappedByList ที่ไม่ได้ SetCascadeType.PERSIST และ CascadeType.MERGE แต่หลีกเลี่ยง CascadeType.REMOVE/ALL@ManyToMany ขี้เกียจโดยค่าเริ่มต้น; ให้มันด้วยวิธีนี้!@NaturalId )) และ/หรือตัวระบุที่สร้างฐานข้อมูลและการแทนที่ (ทั้งสองด้าน) อย่างถูกต้อง equals() และวิธีการ hashCode() เช่นเดียวกับที่นี่toString() ให้ให้ความสนใจกับการมีส่วนร่วมเฉพาะสำหรับแอตทริบิวต์พื้นฐานที่ดึงมาเมื่อเอนทิตีถูกโหลดจากฐานข้อมูลSet แทน List ใน @ManyToMany Associations คำอธิบาย: นี่เป็นตัวอย่างการบูตฤดูใบไม้ผลิของการลบแถวในกรณีของ @ManyToMany แบบสองทิศทางโดยใช้ List ตาม Set ข้อสรุปคือ Set นั้นดีกว่ามาก! สิ่งนี้ใช้กับทิศทางเดียวเช่นกัน!

ประเด็นสำคัญ:

Set มีประสิทธิภาพมากกว่า List ตัวอย่างเอาต์พุต:

log4jdbcคำอธิบาย: ดูรายละเอียดการสืบค้นผ่าน log4jdbc

ประเด็นสำคัญ:

pom.xml ให้เพิ่มการพึ่งพา log4jdbc ตัวอย่างผลลัพธ์:

คำอธิบาย: ดูพารามิเตอร์การเชื่อมโยง/สกัดคำสั่งที่เตรียมไว้ผ่าน TRACE

ประเด็นสำคัญ:

application.properties เพิ่ม: logging.level.org.hibernate.type.descriptor.sql=TRACE ตัวอย่างผลลัพธ์:

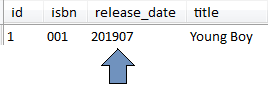

java.time.YearMonth เป็น Integer หรือ Date ผ่านห้องสมุดประเภทไฮเบอร์เนต คำอธิบาย: ประเภทไฮเบอร์เนตเป็นชุดของประเภทพิเศษที่ไม่รองรับโดยค่าเริ่มต้นใน Hibernate Core หนึ่งในประเภทเหล่านี้คือ java.time.YearMonth นี่คือแอปพลิเคชั่นสปริงบูตที่ใช้ประเภทไฮเบอร์เนตเพื่อจัดเก็บ YearMonth นี้ในฐานข้อมูล MySQL เป็นจำนวนเต็มหรือวันที่

ประเด็นสำคัญ:

pom.xml@TypeDef เพื่อทำแผนที่ typeClass กับ defaultForType ตัวอย่างเอาต์พุต:

หมายเหตุ : การใช้ฟังก์ชั่น SQL ในส่วน WHERE (ไม่อยู่ในส่วน SELECT ) ของการสืบค้นใน JPA 2.1 สามารถทำได้ผ่าน function() ตามที่นี่

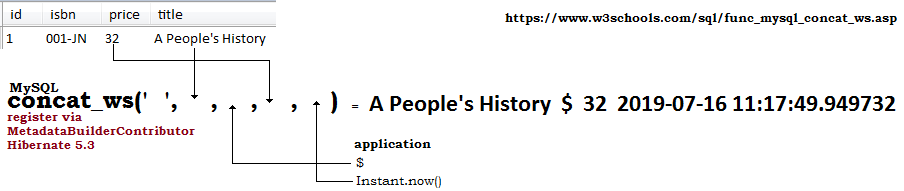

คำอธิบาย: การพยายามใช้ฟังก์ชั่น SQL (มาตรฐานหรือกำหนด) ในการสืบค้น JPQL อาจส่งผลให้มีข้อยกเว้นหาก Hibernate จะไม่รู้จักและไม่สามารถแยกวิเคราะห์การสืบค้น JPQL ได้ ตัวอย่างเช่นฟังก์ชั่น MySQL, concat_ws ไม่ได้รับการยอมรับจาก Hibernate แอปพลิเคชั่นนี้เป็นแอปพลิเคชันสปริงบูตที่ใช้ Hibernate 5.3 ซึ่งลงทะเบียนฟังก์ชั่น concat_ws ผ่าน MetadataBuilderContributor และแจ้ง Hibernate เกี่ยวกับมันผ่านคุณสมบัติ metadata_builder_contributor ตัวอย่างนี้ใช้ @Query และ EntityManager เช่นกันเพื่อให้คุณสามารถเห็นกรณีการใช้งานสองกรณี

ประเด็นสำคัญ:

MetadataBuilderContributor และลงทะเบียนฟังก์ชัน concat_ws mysqlapplication.properties ให้ตั้งค่า spring.jpa.properties.hibernate.metadata_builder_contributor เพื่อชี้ให้เห็นถึงการใช้งาน MetadataBuilderContributor ตัวอย่างเอาต์พุต:

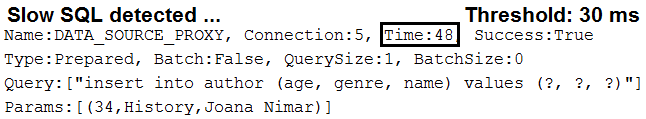

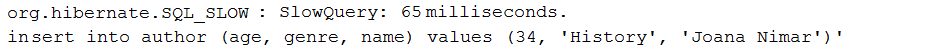

คำอธิบาย: แอปพลิเคชันนี้เป็นตัวอย่างของการบันทึกการสืบค้นช้าเท่านั้นผ่าน DataSource-Proxy การสืบค้นช้าเป็นแบบสอบถามที่มีเวลาดำเนินการใหญ่กว่าเกณฑ์เฉพาะในมิลลิวินาที

ประเด็นสำคัญ:

pom.xml การพึ่งพา dataSource-proxyDataSourceDataSource ผ่าน ProxyFactory และการใช้ MethodInterceptorafterQuery() ตัวอย่างเอาต์พุต:

SELECT COUNT subquery และ Page<dto> คำอธิบาย: แอปพลิเคชันนี้จะดึงข้อมูลเป็น Page<dto> ผ่านการจัดฟันแบบสปริงชดเชย ส่วนใหญ่ข้อมูลที่ควรได้รับการ paginated เป็นข้อมูล แบบอ่านอย่างเดียว การดึงข้อมูลลงในเอนทิตีควรทำเฉพาะในกรณีที่เราวางแผนที่จะแก้ไขข้อมูลนั้นดังนั้นการดึงข้อมูล อ่านเท่านั้น เป็น Page<entity> ไม่ดีกว่าเนื่องจากอาจจบลงด้วยการลงโทษประสิทธิภาพที่สำคัญ การ SELECT COUNT สำหรับการนับจำนวนระเบียนทั้งหมดเป็นคำถามย่อยของ SELECT หลัก ดังนั้นจะมีฐานข้อมูลเดียวกลับไปที่สองแทนที่จะเป็นสองฐานข้อมูล (โดยทั่วไปจะมีแบบสอบถามหนึ่งแบบที่จำเป็นสำหรับการดึงข้อมูลและอีกอันหนึ่งสำหรับการนับจำนวนระเบียนทั้งหมด)

ประเด็นสำคัญ:

PagingAndSortingRepositoryList<dto>List<dto> และ Pageable ที่เหมาะสมในการสร้าง Page<dto>SELECT COUNT คำถามย่อยและ List<dto> คำอธิบาย: แอปพลิเคชันนี้ดึงข้อมูลเป็น List<dto> ผ่านการจัดฟันแบบสปริงชดเชย ส่วนใหญ่ข้อมูลที่ควรได้รับการ paginated เป็นข้อมูล แบบอ่านอย่างเดียว การดึงข้อมูลลงในเอนทิตีควรทำเฉพาะในกรณีที่เราวางแผนที่จะแก้ไขข้อมูลนั้นดังนั้นการดึงข้อมูล อ่านเท่านั้น เป็น List<entity> ไม่ดีกว่าเนื่องจากอาจจบลงด้วยการลงโทษประสิทธิภาพที่สำคัญ การ SELECT COUNT สำหรับการนับจำนวนระเบียนทั้งหมดเป็นคำถามย่อยของ SELECT หลัก ดังนั้นจะมีฐานข้อมูลเดียวกลับไปที่สองแทนที่จะเป็นสองฐานข้อมูล (โดยทั่วไปจะมีแบบสอบถามหนึ่งแบบที่จำเป็นสำหรับการดึงข้อมูลและอีกอันหนึ่งสำหรับการนับจำนวนระเบียนทั้งหมด)

ประเด็นสำคัญ:

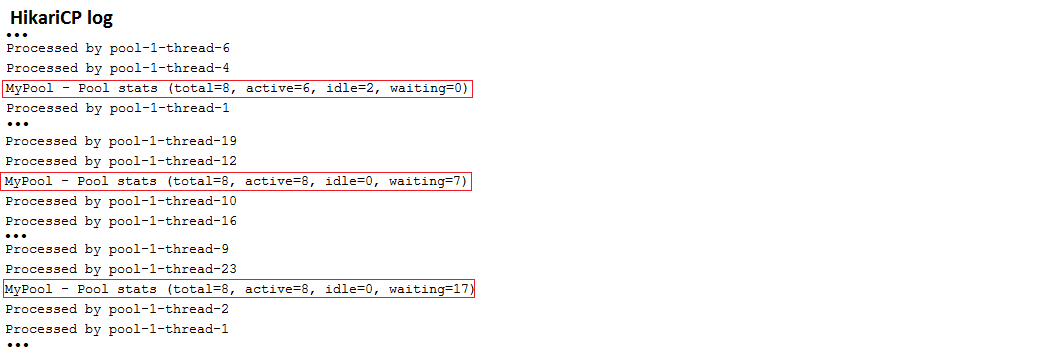

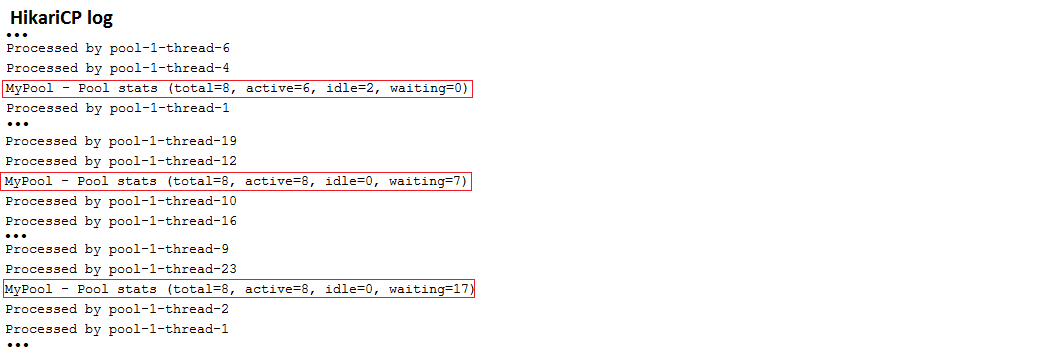

PagingAndSortingRepositoryList<dto> หากคุณใช้ spring-boot-starter-jdbc หรือ spring-boot-starter-data-jpa "Starters" คุณจะได้รับการพึ่งพา Hikaricp โดยอัตโนมัติ

หมายเหตุ: วิธีที่ดีที่สุดในการปรับพารามิเตอร์การเชื่อมต่อพารามิเตอร์ประกอบด้วยการใช้ Flexy Pool โดย Vlad Mihalcea Via Flexy Pool คุณสามารถค้นหาการตั้งค่าที่ดีที่สุดที่รักษาประสิทธิภาพสูงของกลุ่มการเชื่อมต่อของคุณ

คำอธิบาย: นี่คือแอปพลิเคชั่น Kickoff ที่ตั้งค่า Hikaricp ผ่าน application.properties เท่านั้น jdbcUrl ถูกตั้งค่าสำหรับฐานข้อมูล MySQL สำหรับวัตถุประสงค์ในการทดสอบแอปพลิเคชันใช้ ExecutorService สำหรับการจำลองผู้ใช้ที่เกิดขึ้นพร้อมกัน ตรวจสอบรายงาน HICKARICP เปิดเผยสถานะการเชื่อมต่อพูล

ประเด็นสำคัญ:

application.properties อาศัย spring.datasource.hikari.* เพื่อกำหนดค่า hikaricp ตัวอย่างผลลัพธ์:

| หากคุณต้องการการดำน้ำลึกลงไปในสูตรการแสดงที่เปิดเผยในที่เก็บนี้ฉันมั่นใจว่าคุณจะรักหนังสือของฉัน | หากคุณต้องการเคล็ดลับและภาพประกอบของปัญหาประสิทธิภาพการคงอยู่ของ Java มากกว่า 100 รายการแล้ว |

|

|

DataSourceBuilder หากคุณใช้ spring-boot-starter-jdbc หรือ spring-boot-starter-data-jpa "Starters" คุณจะได้รับการพึ่งพา Hikaricp โดยอัตโนมัติ

หมายเหตุ: วิธีที่ดีที่สุดในการปรับพารามิเตอร์การเชื่อมต่อพารามิเตอร์ประกอบด้วยการใช้ Flexy Pool โดย Vlad Mihalcea Via Flexy Pool คุณสามารถค้นหาการตั้งค่าที่ดีที่สุดที่รักษาประสิทธิภาพสูงของกลุ่มการเชื่อมต่อของคุณ

คำอธิบาย: นี่คือแอปพลิเคชั่น Kickoff ที่ตั้งค่า Hikaricp ผ่าน DataSourceBuilder jdbcUrl ถูกตั้งค่าสำหรับฐานข้อมูล MySQL สำหรับวัตถุประสงค์ในการทดสอบแอปพลิเคชันใช้ ExecutorService สำหรับการจำลองผู้ใช้ที่เกิดขึ้นพร้อมกัน ตรวจสอบรายงาน HICKARICP เปิดเผยสถานะการเชื่อมต่อพูล

ประเด็นสำคัญ:

application.properties กำหนดค่า hikaricp ผ่านคำนำหน้าแบบกำหนดเองเช่น app.datasource.*@Bean ที่ส่งคืน DataSource ตัวอย่างผลลัพธ์:

แอปพลิเคชันนี้มีรายละเอียดในบทความ dzone นี้

DataSourceBuilderหมายเหตุ: วิธีที่ดีที่สุดในการปรับพารามิเตอร์การเชื่อมต่อพารามิเตอร์ประกอบด้วยการใช้ Flexy Pool โดย Vlad Mihalcea Via Flexy Pool คุณสามารถค้นหาการตั้งค่าที่ดีที่สุดที่รักษาประสิทธิภาพสูงของกลุ่มการเชื่อมต่อของคุณ

คำอธิบาย: นี่คือแอปพลิเคชั่น Kickoff ที่ตั้งค่า BONECP ผ่าน DataSourceBuilder jdbcUrl ถูกตั้งค่าสำหรับฐานข้อมูล MySQL สำหรับวัตถุประสงค์ในการทดสอบแอปพลิเคชันใช้ ExecutorService สำหรับการจำลองผู้ใช้ที่เกิดขึ้นพร้อมกัน

ประเด็นสำคัญ:

pom.xml เพิ่มการพึ่งพา bonecpapplication.properties กำหนดค่า BONECP ผ่านคำนำหน้าแบบกำหนดเองเช่น app.datasource.*@Bean ที่ส่งคืน DataSource ตัวอย่างผลลัพธ์:

DataSourceBuilderหมายเหตุ: วิธีที่ดีที่สุดในการปรับพารามิเตอร์การเชื่อมต่อพารามิเตอร์ประกอบด้วยการใช้ Flexy Pool โดย Vlad Mihalcea Via Flexy Pool คุณสามารถค้นหาการตั้งค่าที่ดีที่สุดที่รักษาประสิทธิภาพสูงของกลุ่มการเชื่อมต่อของคุณ

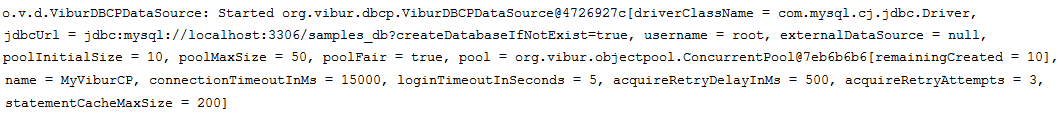

คำอธิบาย: นี่คือแอปพลิเคชั่น Kickoff ที่ตั้งค่า ViburdBCP ผ่าน DataSourceBuilder jdbcUrl ถูกตั้งค่าสำหรับฐานข้อมูล MySQL สำหรับวัตถุประสงค์ในการทดสอบแอปพลิเคชันใช้ ExecutorService สำหรับการจำลองผู้ใช้ที่เกิดขึ้นพร้อมกัน

ประเด็นสำคัญ:

pom.xml เพิ่มการพึ่งพา viburdbcpapplication.properties กำหนดค่า viburdbcp ผ่านคำนำหน้าแบบกำหนดเองเช่น app.datasource.*@Bean ที่ส่งคืน DataSource ตัวอย่างผลลัพธ์:

DataSourceBuilderหมายเหตุ: วิธีที่ดีที่สุดในการปรับพารามิเตอร์การเชื่อมต่อพารามิเตอร์ประกอบด้วยการใช้ Flexy Pool โดย Vlad Mihalcea Via Flexy Pool คุณสามารถค้นหาการตั้งค่าที่ดีที่สุดที่รักษาประสิทธิภาพสูงของกลุ่มการเชื่อมต่อของคุณ

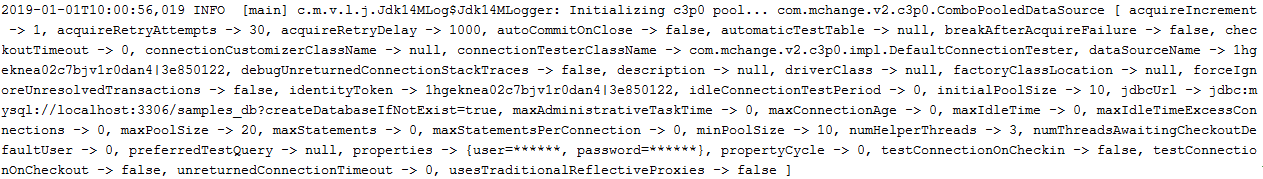

คำอธิบาย: นี่คือแอปพลิเคชั่น Kickoff ที่ตั้งค่า C3P0 ผ่าน DataSourceBuilder jdbcUrl ถูกตั้งค่าสำหรับฐานข้อมูล MySQL สำหรับวัตถุประสงค์ในการทดสอบแอปพลิเคชันใช้ ExecutorService สำหรับการจำลองผู้ใช้ที่เกิดขึ้นพร้อมกัน

ประเด็นสำคัญ:

pom.xml เพิ่มการพึ่งพา C3p0application.properties กำหนดค่า C3P0 ผ่านคำนำหน้าแบบกำหนดเองเช่น app.datasource.*@Bean ที่ส่งคืน DataSource ตัวอย่างผลลัพธ์:

DataSourceBuilderหมายเหตุ: วิธีที่ดีที่สุดในการปรับพารามิเตอร์การเชื่อมต่อพารามิเตอร์ประกอบด้วยการใช้ Flexy Pool โดย Vlad Mihalcea Via Flexy Pool คุณสามารถค้นหาการตั้งค่าที่ดีที่สุดที่รักษาประสิทธิภาพสูงของกลุ่มการเชื่อมต่อของคุณ

คำอธิบาย: นี่คือแอปพลิเคชั่น Kickoff ที่ตั้งค่า DBCP2 ผ่าน DataSourceBuilder jdbcUrl ถูกตั้งค่าสำหรับฐานข้อมูล MySQL สำหรับวัตถุประสงค์ในการทดสอบแอปพลิเคชันใช้ ExecutorService สำหรับการจำลองผู้ใช้ที่เกิดขึ้นพร้อมกัน

ประเด็นสำคัญ:

pom.xml เพิ่มการพึ่งพา DBCP2application.properties กำหนดค่า DBCP2 ผ่านคำนำหน้าแบบกำหนดเองเช่น app.datasource.*@Bean ที่ส่งคืน DataSourceDataSourceBuilderหมายเหตุ: วิธีที่ดีที่สุดในการปรับพารามิเตอร์การเชื่อมต่อพารามิเตอร์ประกอบด้วยการใช้ Flexy Pool โดย Vlad Mihalcea Via Flexy Pool คุณสามารถค้นหาการตั้งค่าที่ดีที่สุดที่รักษาประสิทธิภาพสูงของกลุ่มการเชื่อมต่อของคุณ

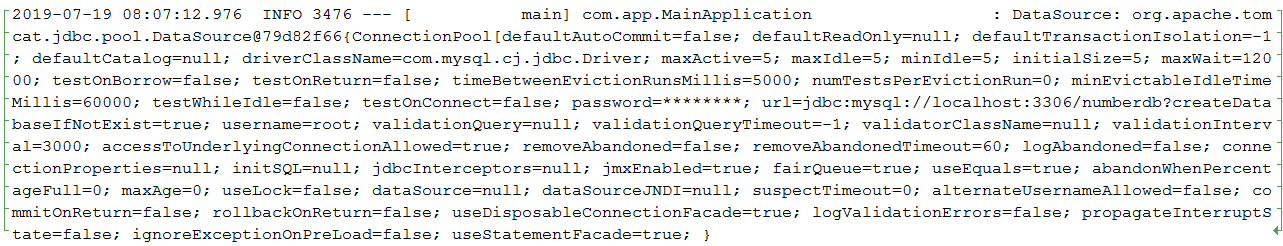

คำอธิบาย: นี่คือแอปพลิเคชั่น Kickoff ที่ตั้งค่า Tomcat ผ่าน DataSourceBuilder jdbcUrl ถูกตั้งค่าสำหรับฐานข้อมูล MySQL สำหรับวัตถุประสงค์ในการทดสอบแอปพลิเคชันใช้ ExecutorService สำหรับการจำลองผู้ใช้ที่เกิดขึ้นพร้อมกัน

ประเด็นสำคัญ:

pom.xml เพิ่มการพึ่งพา Tomcatapplication.properties กำหนดค่า tomcat ผ่านคำนำหน้าแบบกำหนดเองเช่น app.datasource.*@Bean ที่ส่งคืน DataSource ตัวอย่างผลลัพธ์:

หมายเหตุ: วิธีที่ดีที่สุดในการปรับพารามิเตอร์การเชื่อมต่อพารามิเตอร์ประกอบด้วยการใช้ Flexy Pool โดย Vlad Mihalcea Via Flexy Pool คุณสามารถค้นหาการตั้งค่าที่ดีที่สุดที่รักษาประสิทธิภาพสูงของกลุ่มการเชื่อมต่อของคุณ

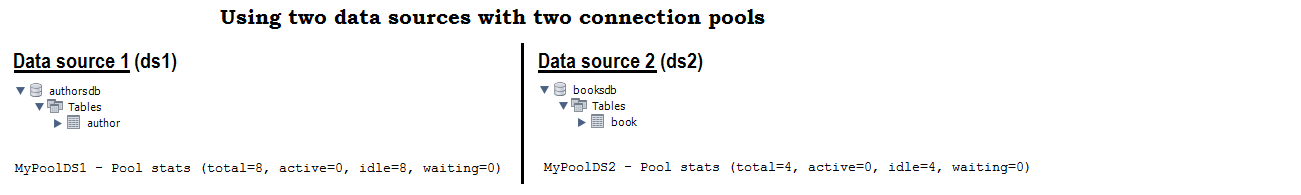

คำอธิบาย: นี่คือแอปพลิเคชั่น Kickoff ที่ใช้แหล่งข้อมูลสองแหล่ง (ฐานข้อมูล MySQL สองฐานหนึ่งชื่อ authorsdb และหนึ่งชื่อ booksdb ) พร้อมพูลเชื่อมต่อสองพูล (แต่ละฐานข้อมูลใช้พูลเชื่อมต่อ Hikaricp ของตัวเองพร้อมการตั้งค่าที่แตกต่างกัน) จากรายการข้างต้นนั้นค่อนข้างง่ายในการกำหนดค่าพูลการเชื่อมต่อสองกลุ่มจากผู้ให้บริการสองรายที่แตกต่างกันเช่นกัน

ประเด็นสำคัญ:

application.properties กำหนดค่าพูลการเชื่อมต่อ Hikaricp สองตัวผ่านคำนำหน้าสองคำนำที่กำหนดเองเช่น app.datasource.ds1 และ app.datasource.ds2@Bean ที่ส่งคืน DataSource แรกและทำเครื่องหมายเป็น @Primary@Bean อื่นที่ส่งคืน DataSource ที่สองEntityManagerFactory และชี้ให้เห็นแพ็คเกจเพื่อสแกนสำหรับแต่ละชุดEntityManager ในแพ็คเกจที่ถูกต้อง ตัวอย่างผลลัพธ์:

หมายเหตุ : หากคุณต้องการให้คุณให้ API ที่คล่องแคล่วโดยไม่ต้องเปลี่ยนตัวตั้งตัวตั้งค่าให้พิจารณารายการนี้

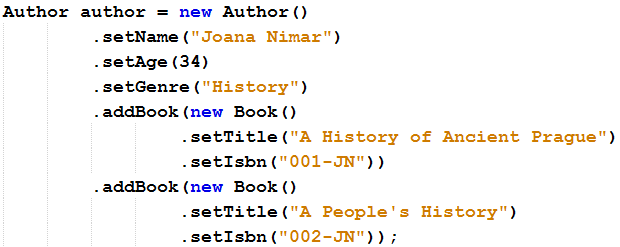

คำอธิบาย: นี่คือแอปพลิเคชันตัวอย่างที่เปลี่ยนวิธีการตั้งค่าเอนทิตีเพื่อเพิ่มขีดความสามารถ API ที่คล่องแคล่ว

ประเด็นสำคัญ:

this แทนที่จะเป็น void ใน setters ตัวอย่าง API ที่คล่องแคล่ว:

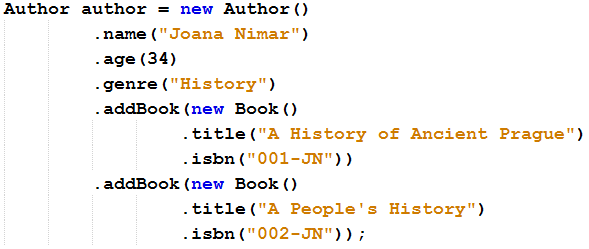

หมายเหตุ : หากคุณต้องการให้คุณให้ API ที่คล่องแคล่วโดยการเปลี่ยนตัวตั้งค่าให้พิจารณารายการนี้

คำอธิบาย: นี่คือแอปพลิเคชันตัวอย่างที่เพิ่มวิธีการเพิ่มเติมในเอนทิตี (เช่นสำหรับ setName เราเพิ่ม name ) วิธีการเพื่อเพิ่มขีดความสามารถ API ที่คล่องแคล่ว

ประเด็นสำคัญ:

this แทนที่จะ void ตัวอย่าง API ที่คล่องแคล่ว:

| หากคุณต้องการการดำน้ำลึกลงไปในสูตรการแสดงที่เปิดเผยในที่เก็บนี้ฉันมั่นใจว่าคุณจะรักหนังสือของฉัน | หากคุณต้องการเคล็ดลับและภาพประกอบของปัญหาประสิทธิภาพการคงอยู่ของ Java มากกว่า 100 รายการแล้ว |

|

|

Slice<T> findAll() ส่วนใหญ่อาจเป็นทั้งหมดที่คุณต้องการ: วิธีดึง Slice<entity> / Slice<dto> ผ่าน fetchAll / fetchAllDto

การใช้งาน Slice<T> findAll() :

"SELECT e FROM " + entityClass.getSimpleName() + " e;"CriteriaBuilder มินิมัลลิสSort ดังนั้นจึงเป็นไปได้Sort และ Specification ข้อมูลสปริงข้อมูลSort LockModeType QueryHints SpecificationPageable และ/หรือ Specification โดยการขยาย SimpleJpaRepository จากข้อมูลฤดูใบไม้ผลิ Bascially การใช้งานนี้เป็นสิ่งเดียวที่ส่งคืน Page<T> แทนที่จะเป็น Slice<T> แต่มันไม่ได้ทริก SELECT COUNT เพิ่มเติมเนื่องจากมันถูกกำจัดโดยการเอาชนะ Page<T> readPage(...) จากวิธีการ SimpleJpaRepository ข้อเสียเปรียบหลักคือโดยการรักษา Page<T> คุณไม่ทราบว่ามีหน้าถัดไปหรือหน้าปัจจุบันเป็นครั้งสุดท้าย อย่างไรก็ตามมีวิธีแก้ปัญหาที่จะมีสิ่งนี้เช่นกัน ในการใช้งานนี้คุณไม่สามารถตั้งค่า LockModeType หรือคำแนะนำการสืบค้นได้ เรื่องราว : Spring Boot ให้กลไกการเพจในตัว ชดเชย ที่ส่งคืน Page หรือ Slice API เหล่านี้แต่ละตัวแสดงหน้าข้อมูลและข้อมูลเมตาบางส่วน ความแตกต่างที่สำคัญคือ Page นั้นมีจำนวนระเบียนทั้งหมดในขณะที่ Slice สามารถบอกได้ว่ามีหน้าอื่นเท่านั้น สำหรับ Page Spring Boot มีวิธี findAll() ที่สามารถใช้เป็นอาร์กิวเมนต์ Pageable และ/หรือ Specification หรือ Example ในการสร้าง Page ที่มีจำนวนระเบียนทั้งหมดวิธีนี้จะกระตุ้นการ SELECT COUNT ถัดจากแบบสอบถามที่ใช้เพื่อดึงข้อมูลของหน้าปัจจุบัน นี่อาจเป็นบทลงโทษประสิทธิภาพเนื่องจากแบบสอบถาม SELECT COUNT จะถูกเรียกใช้ทุกครั้งที่เราขอหน้า เพื่อหลีกเลี่ยงคำถามพิเศษนี้ Spring Boot ให้ API ที่ผ่อนคลายมากขึ้น Slice API การใช้ Slice แทน Page จะช่วยขจัดความต้องการของแบบสอบถาม SELECT COUNT พิเศษนี้และส่งคืนหน้า (บันทึก) และข้อมูลเมตาบางส่วนที่ไม่มีจำนวนระเบียนทั้งหมด ดังนั้นในขณะที่ Slice ไม่ทราบจำนวนระเบียนทั้งหมด แต่ก็ยังสามารถบอกได้ว่ามีหน้าอื่นหลังจากที่ปัจจุบันหรือนี่คือหน้าสุดท้าย ปัญหาคือ Slice ทำงานได้ดีสำหรับการสืบค้นที่มี SQL WHERE (รวมถึงสิ่งที่ใช้กลไกการค้นหาแบบสอบถามที่สร้างขึ้นในข้อมูลฤดูใบไม้ผลิ) แต่มัน ไม่ได้ผล สำหรับ findAll() วิธีนี้จะยังคงส่งคืน Page แทน Slice ดังนั้นตัวเลือก SELECT COUNT จะถูกเรียกใช้สำหรับ Slice<T> findAll(...); -

คำอธิบาย: นี่คือชุดแอปพลิเคชั่นตัวอย่างที่ให้วิธีการ Slice<T> findAll(...) เรามีจากการใช้งานมินิมัลลิสต์ที่ต้องอาศัยการสืบค้น hardcoded เป็น: "SELECT e FROM " + entityClass.getSimpleName() + " e"; (สูตรนี้) ไปยังการใช้งานที่กำหนดเองที่รองรับการเรียงลำดับข้อมูลจำเพาะโหมดล็อคและคำแนะนำการสืบค้นไปยังการใช้งานที่ต้องอาศัยการขยาย SimpleJpaRepository

ประเด็นสำคัญ:

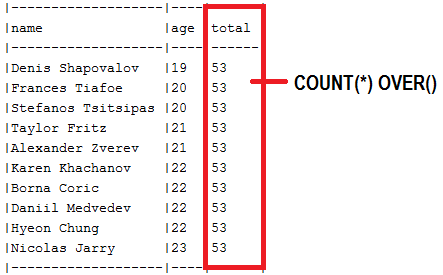

abstract ที่แสดง Slice<T> findAll(...) วิธีการ ( SlicePagingRepositoryImplementationfindAll() เพื่อส่งคืน Slice<T> (หรือ Page<T> แต่ไม่มีจำนวนองค์ประกอบทั้งหมด)SliceImpl ( Slice<T> ) หรือ PageImpl ( Page<T> ) โดยไม่มีจำนวนองค์ประกอบทั้งหมดreadSlice() ใหม่หรือแทนที่หน้า SimpleJpaRepository#readPage() เพื่อหลีกเลี่ยง SELECT COUNTAuthor.class ) ไปยังคลาส abstract นี้ผ่านที่เก็บคลาส ( AuthorRepository )COUNT(*) OVER และส่งคืน List<dto> คำอธิบาย: โดยทั่วไปแล้วในการปนเปื้อนออฟเซ็ตมีการสืบค้นหนึ่งอันที่จำเป็นสำหรับการดึงข้อมูลและอีกหนึ่งรายการสำหรับการนับจำนวนบันทึกทั้งหมด แต่เราสามารถดึงข้อมูลนี้ในฐานข้อมูลฐานข้อมูลเดียวผ่านการ SELECT COUNT SubQuery ที่ซ้อนกันใน SELECT หลัก ยิ่งไปกว่านั้นสำหรับผู้ขายฐานข้อมูลที่รองรับ ฟังก์ชั่นหน้าต่าง มีวิธีแก้ปัญหาที่อาศัย COUNT(*) OVER() เช่นเดียวกับในแอปพลิเคชันนี้ที่ใช้ฟังก์ชั่นหน้าต่างนี้ในแบบสอบถามดั้งเดิมกับ SELECT COUNT 8 .

ประเด็นสำคัญ:

COUNT(*) OVER() ตัวอย่าง:

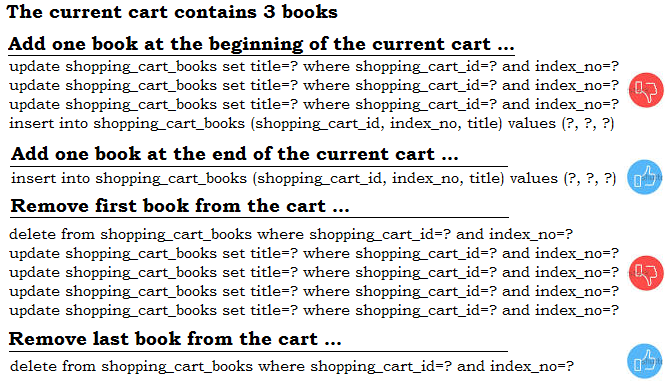

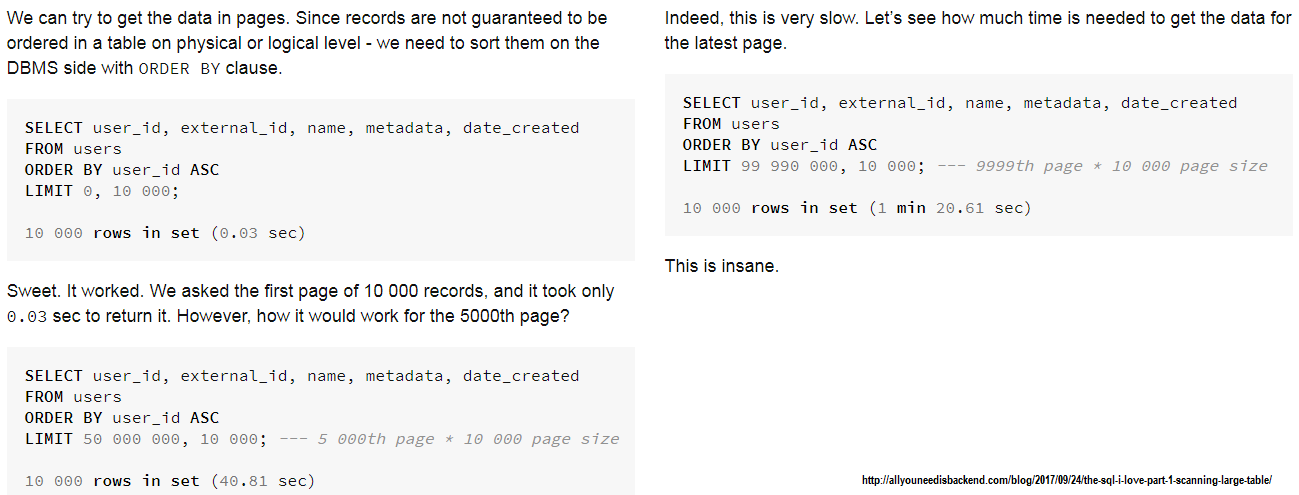

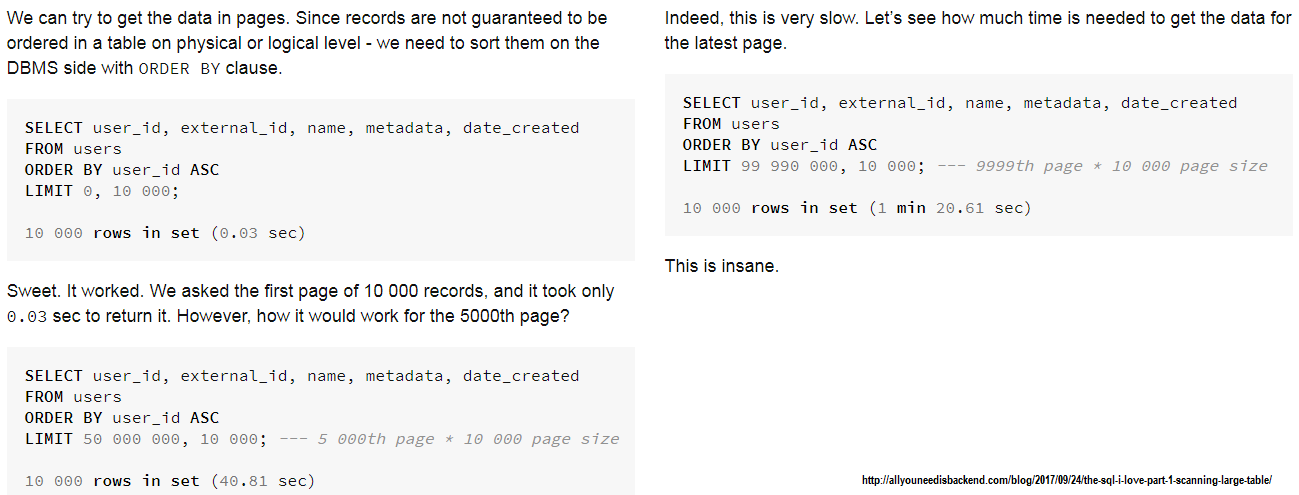

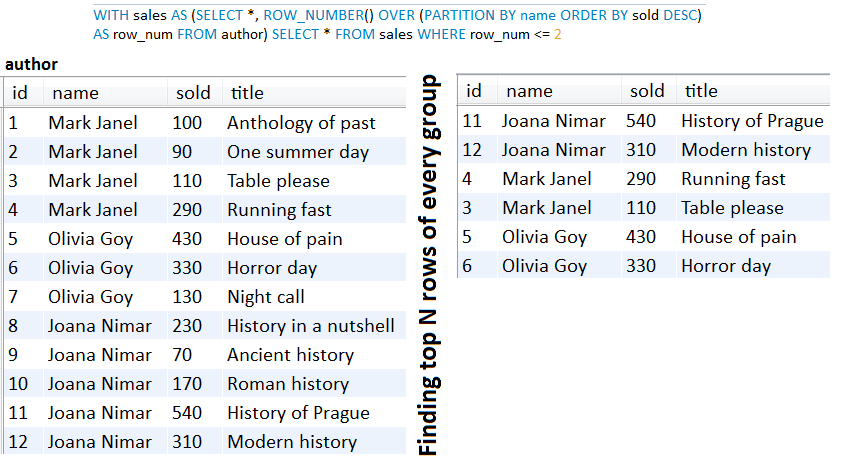

คำอธิบาย: เมื่อเราพึ่งพาการเพจ ออฟเซ็ต เรามีการลงโทษประสิทธิภาพที่เกิดจากการทิ้งบันทึก N ก่อนที่จะถึง ชดเชย ที่ต้องการ N ที่ใหญ่กว่านำไปสู่การลงโทษประสิทธิภาพที่สำคัญ เมื่อเรามี N ขนาดใหญ่ดีกว่าที่จะพึ่งพาการแบ่งหน้า คีย์ ซึ่งรักษาเวลา "คงที่" สำหรับชุดข้อมูลขนาดใหญ่ เพื่อที่จะเข้าใจว่า การชดเชย ไม่ดีสามารถดำเนินการได้โปรดตรวจสอบบทความนี้:

ภาพหน้าจอจากบทความนั้น (การปน เปื้อนออฟเซ็ต ):

ต้องรู้ว่ามีบันทึกเพิ่มเติมหรือไม่?

โดยธรรมชาติแล้ว คีย์เซ็ต ไม่ได้ใช้ SELECT COUNT เพื่อดึงจำนวนระเบียนทั้งหมด แต่ด้วยการปรับแต่งเล็กน้อยเราสามารถพูดได้อย่างง่ายดายว่ามีเร็กคอร์ดมากขึ้นดังนั้นจึงแสดงปุ่มประเภท Next Page ส่วนใหญ่ถ้าคุณต้องการสิ่งนั้นให้พิจารณาแอปพลิเคชันนี้ที่มีจุดสุดยอดอยู่ด้านล่าง:

public AuthorView fetchNextPage(long id, int limit) {

List<Author> authors = authorRepository.fetchAll(id, limit + 1);

if (authors.size() == (limit + 1)) {

authors.remove(authors.size() - 1);

return new AuthorView(authors, true);

}

return new AuthorView(authors, false);

}

หรือเช่นนี้ (พึ่งพา Author.toString() วิธี):

public Map<List<Author>, Boolean> fetchNextPage(long id, int limit) {

List<Author> authors = authorRepository.fetchAll(id, limit + 1);

if(authors.size() == (limit + 1)) {

authors.remove(authors.size() -1);

return Collections.singletonMap(authors, true);

}

return Collections.singletonMap(authors, false);

}

ปุ่ม Previous Page สามารถใช้งานได้อย่างง่ายดายตามระเบียนแรก

ประเด็นสำคัญ:

id )WHERE และ ORDER BY คำสั่งของ SQL ของคุณคำอธิบาย: นี่คือตัวอย่างการปน เปื้อนของ สปริงชดเชยสปริงแบบคลาสสิก อย่างไรก็ตามไม่แนะนำให้ใช้วิธีการนี้ในการผลิตเนื่องจากบทลงโทษผลการปฏิบัติงานอธิบายเพิ่มเติม

เมื่อเราพึ่งพาการปน เปื้อนชดเชย เรามีการลงโทษประสิทธิภาพที่เกิดจากการทิ้งเร็กคอร์ด N ก่อนที่จะถึง การชดเชย ที่ต้องการ N ที่ใหญ่กว่านำไปสู่การลงโทษประสิทธิภาพที่สำคัญ การลงโทษอีกอย่างคือ SELECT พิเศษที่จำเป็นในการนับจำนวนบันทึกทั้งหมด เพื่อที่จะเข้าใจว่าการปน เปื้อนออฟเซ็ต ไม่ดีสามารถดำเนินการได้โปรดตรวจสอบบทความนี้ ภาพหน้าจอจากบทความนั้นอยู่ด้านล่าง: อย่างไรก็ตามบางทีตัวอย่างนี้อาจจะสุดขั้วเล็กน้อย สำหรับชุดข้อมูลที่ค่อนข้างเล็กการปน เปื้อนออฟเซ็ต นั้นไม่เลวร้ายนัก (มันอยู่ใกล้กับประสิทธิภาพของการแบ่งหน้า ของคีย์ ) และเนื่องจาก Spring Boot ให้การสนับสนุนในตัวสำหรับการปัดยวด ชดเชย ผ่าน

อย่างไรก็ตามบางทีตัวอย่างนี้อาจจะสุดขั้วเล็กน้อย สำหรับชุดข้อมูลที่ค่อนข้างเล็กการปน เปื้อนออฟเซ็ต นั้นไม่เลวร้ายนัก (มันอยู่ใกล้กับประสิทธิภาพของการแบ่งหน้า ของคีย์ ) และเนื่องจาก Spring Boot ให้การสนับสนุนในตัวสำหรับการปัดยวด ชดเชย ผ่าน Page API จึงใช้งานง่ายมาก อย่างไรก็ตามขึ้นอยู่กับกรณีเราสามารถเพิ่มประสิทธิภาพการปน เปื้อนออฟเซ็ต เล็กน้อยเช่นในตัวอย่างต่อไปนี้:

ดึงหน้าเป็น Page :

COUNT(*) OVER และส่งคืน Page<dto>COUNT(*) OVER และส่งคืน Page<entity> > ผ่านคอลัมน์พิเศษSELECT COUNT SubQuery และกลับมาแล้ว Page<dto>SELECT COUNT SubQuery และกลับมา Page<entity> ผ่านคอลัมน์พิเศษSELECT COUNT Subquery และกลับมา Page<projection> แผนที่เอนทิตีและจำนวนระเบียนทั้งหมดผ่านการฉายภาพ ดึงหน้าเป็น List :

COUNT(*) OVER และส่งคืน List<dto>COUNT(*) OVER และส่งคืน List<entity> ผ่านคอลัมน์พิเศษSELECT COUNT จำนวนคำถามย่อยและ List<dto>SELECT COUNT SubQuery และ Return List<entity> ผ่านคอลัมน์พิเศษSELECT COUNT Subquery และ return List<projection> แผนที่เอนทิตีและจำนวนระเบียนทั้งหมดผ่านการฉายภาพแต่: หากการปน เปื้อนชดเชย ทำให้คุณมีปัญหาด้านประสิทธิภาพและคุณตัดสินใจที่จะไปกับการปนเปื้อน ของคีย์เซ็ต โปรดตรวจสอบที่นี่ (การแบ่งหน้า ของกุญแจ )

จุดสำคัญของการแบ่งหน้า แบบชดเชย แบบคลาสสิก:

PagingAndSortingRepositoryPage<entity>ตัวอย่างของการแบ่งหน้า แบบชดเชย แบบคลาสสิก:

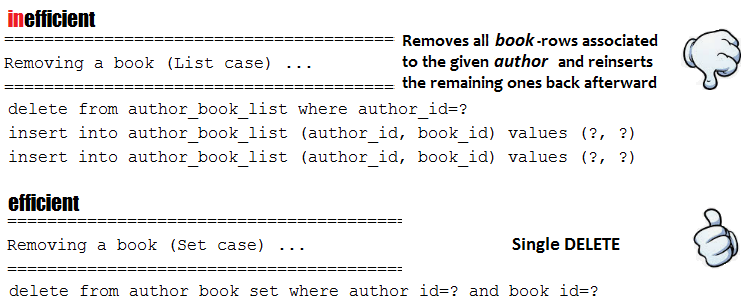

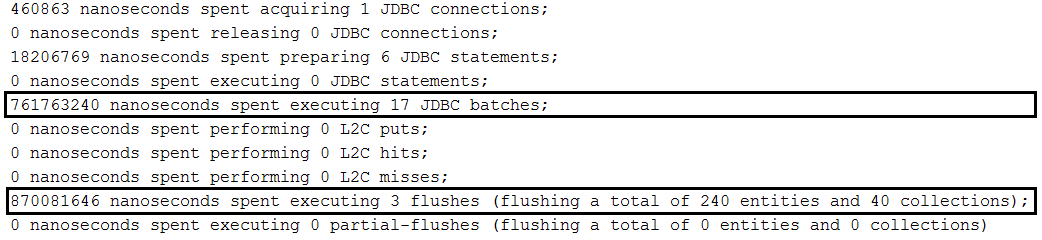

findAll(Pageable) โดยไม่ต้องเรียงลำดับ:repository.findAll(PageRequest.of(page, size));findAll(Pageable) ด้วยการเรียงลำดับ:repository.findAll(PageRequest.of(page, size, new Sort(Sort.Direction.ASC, "name")));Page<Author> findByName(String name, Pageable pageable);Page<Author> queryFirst10ByName(String name, Pageable pageable); คำอธิบาย: สมมติว่าเรามีความสัมพันธ์แบบหนึ่งต่อหลายคนระหว่าง Author และ Book เมื่อเราบันทึกผู้เขียนเราบันทึกหนังสือของเขาเช่นกันด้วยการเรียงซ้อนทั้งหมด/คงอยู่ เราต้องการสร้างกลุ่มผู้แต่งพร้อมหนังสือและบันทึกไว้ในฐานข้อมูล (เช่นฐานข้อมูล MySQL) โดยใช้เทคนิคแบทช์ By default, this will result in batching each author and the books per author (one batch for the author and one batch for the books, another batch for the author and another batch for the books, and so on). In order to batch authors and books, we need to order inserts as in this application.

Key points: Beside all setting specific to batching inserts in MySQL, we need to set up in application.properties the following property: spring.jpa.properties.hibernate.order_inserts=true

Example without ordered inserts:

Example with ordered inserts:

Implementations:

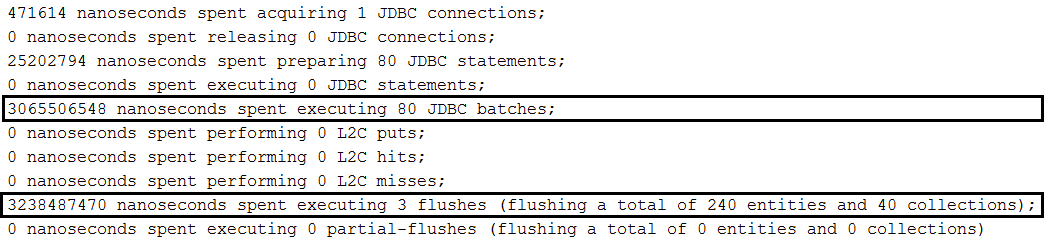

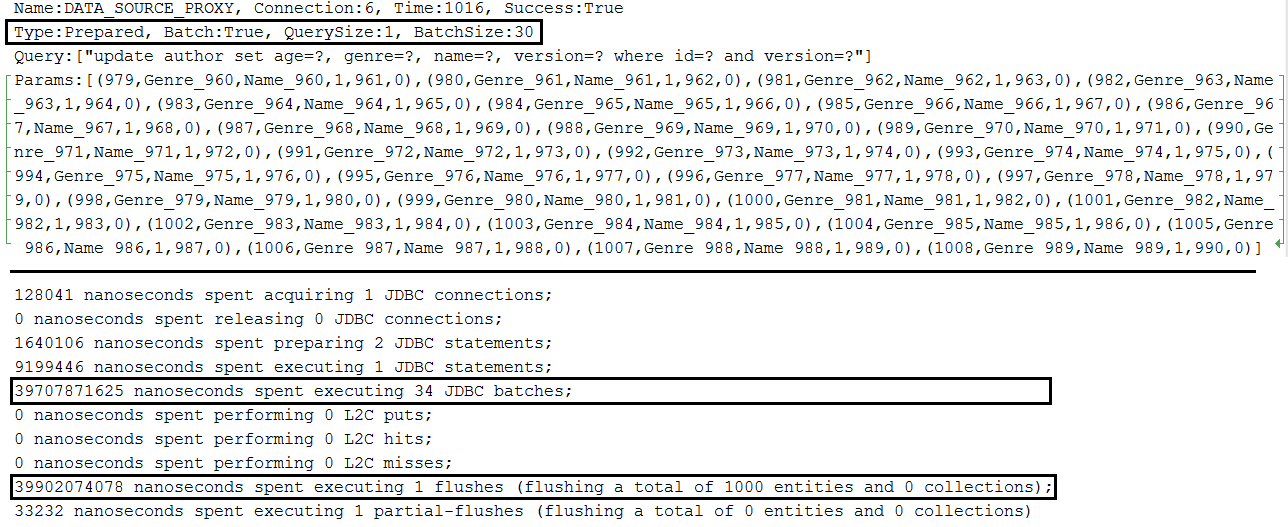

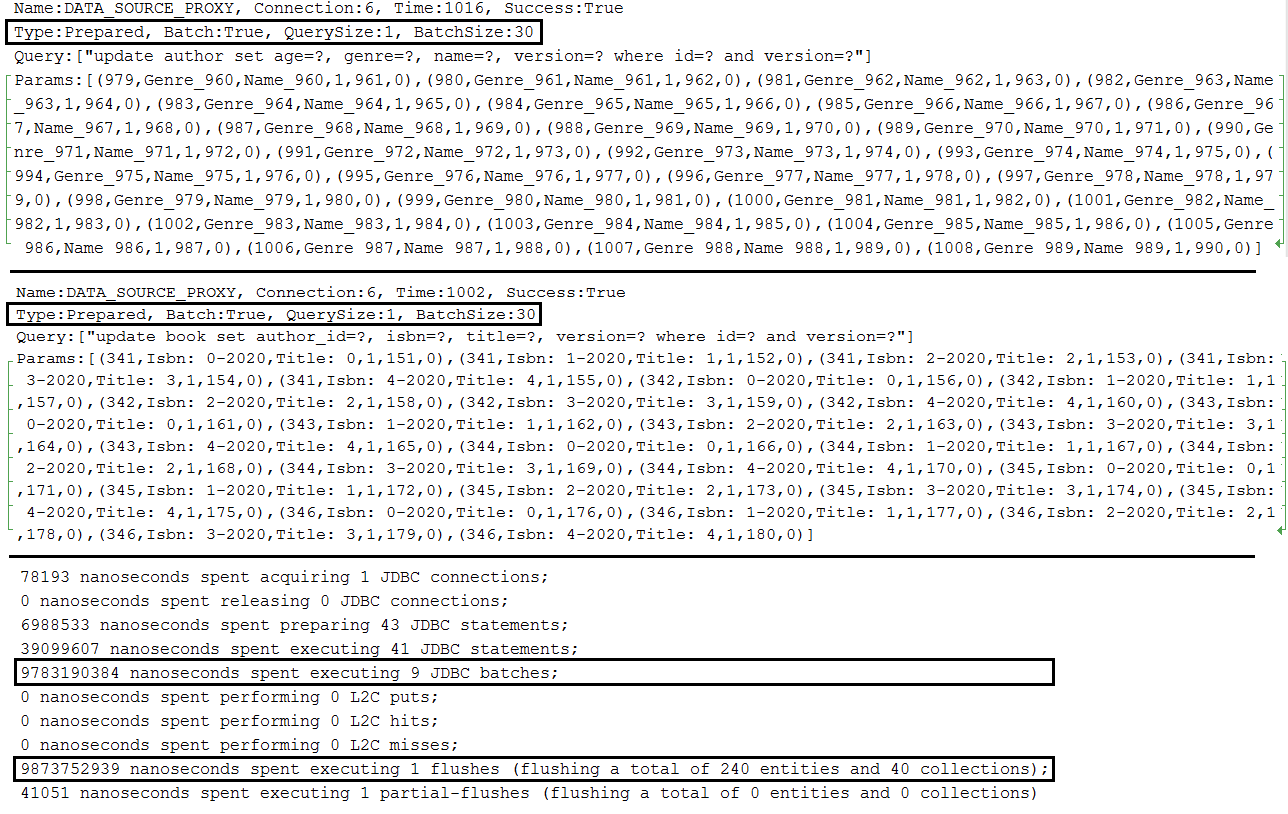

Description: Batch updates in MySQL.

ประเด็นสำคัญ:

application.properties set spring.jpa.properties.hibernate.jdbc.batch_sizeapplication.properties set JDBC URL with rewriteBatchedStatements=true (optimization for MySQL, statements get rewritten into a single string buffer and sent in a single request)application.properties set JDBC URL with cachePrepStmts=true (enable caching and is useful if you decide to set prepStmtCacheSize , prepStmtCacheSqlLimit , etc as well; without this setting the cache is disabled)application.properties set JDBC URL with useServerPrepStmts=true (this way you switch to server-side prepared statements (may lead to signnificant performance boost))spring.jpa.properties.hibernate.order_updates=true to optimize the batching by ordering อัปเดตapplication.properties a setting for enabling batching for versioned entities during update and delete operations (entities that contains @Version for implicit optimistic locking); this setting is: spring.jpa.properties.hibernate.jdbc.batch_versioned_data=true ; starting with Hibernate 5, this setting should be true by default Output example for single entity:

Output example for parent-child relationship:

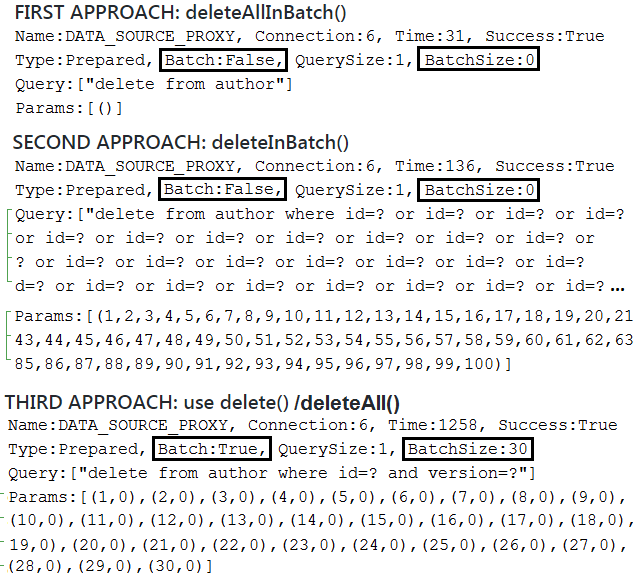

Description: Batch deletes that don't involve associations in MySQL.

Note: Spring deleteAllInBatch() and deleteInBatch() don't use delete batching and don't take advantage of automatic optimstic locking mechanism to prevent lost updates (eg, @Version is ignored). They rely on Query.executeUpdate() to trigger bulk operations. These operations are fast, but Hibernate doesn't know which entities are removed, therefore, the Persistence Context is not updated accordingly (it's up to you to flush (before delete) and close/clear (after delete) the Persistence Context accordingly to avoid issues created by unflushed (if any) or outdated (if any) entities). The first one ( deleteAllInBatch() ) simply triggers a delete from entity_name statement and is very useful for deleting all records. The second one ( deleteInBatch() ) triggers a delete from entity_name where id=? or id=? or id=? ... statement, therefore, is prone to cause issues if the generated DELETE statement exceedes the maximum accepted size. This issue can be controlled by deleting the data in chunks, relying on IN operator, and so on. Bulk operations are faster than batching which can be achieved via the deleteAll() , deleteAll(Iterable<? extends T> entities) or delete() method. Behind the scene, the two flavors of deleteAll() relies on delete() . The delete() / deleteAll() methods rely on EntityManager.remove() therefore the Persistence Context is synchronized accordingly. Moreover, if automatic optimstic locking mechanism (to prevent lost updates ) is enabled then it will be used.

Key points for regular delete batching:

deleteAll() , deleteAll(Iterable<? extends T> entities) or delete() methodapplication.properties set spring.jpa.properties.hibernate.jdbc.batch_sizeapplication.properties set JDBC URL with rewriteBatchedStatements=true (optimization for MySQL, statements get rewritten into a single string buffer and sent in a single request)application.properties set JDBC URL with cachePrepStmts=true (enable caching and is useful if you decide to set prepStmtCacheSize , prepStmtCacheSqlLimit , etc as well; without this setting the cache is disabled)application.properties set JDBC URL with useServerPrepStmts=true (this way you switch to server-side prepared statements (may lead to signnificant performance boost))application.properties a setting for enabling batching for versioned entities during update and delete operations (entities that contains @Version for implicit optimistic locking); this setting is: spring.jpa.properties.hibernate.jdbc.batch_versioned_data=true ; starting with Hibernate 5, this setting should be true by default Output example:

Description: Batch deletes in MySQL via orphanRemoval=true .

Note: Spring deleteAllInBatch() and deleteInBatch() don't use delete batching and don't take advantage of cascading removal, orphanRemoval and automatic optimstic locking mechanism to prevent lost updates (eg, @Version is ignored). They rely on Query.executeUpdate() to trigger bulk operations. These operations are fast, but Hibernate doesn't know which entities are removed, therefore, the Persistence Context is not updated accordingly (it's up to you to flush (before delete) and close/clear (after delete) the Persistence Context accordingly to avoid issues created by unflushed (if any) or outdated (if any) entities). The first one ( deleteAllInBatch() ) simply triggers a delete from entity_name statement and is very useful for deleting all records. The second one ( deleteInBatch() ) triggers a delete from entity_name where id=? or id=? or id=? ... statement, therefore, is prone to cause issues if the generated DELETE statement exceedes the maximum accepted size. This issue can be controlled by deleting the data in chunks, relying on IN operator, and so on. Bulk operations are faster than batching which can be achieved via the deleteAll() , deleteAll(Iterable<? extends T> entities) or delete() method. Behind the scene, the two flavors of deleteAll() relies on delete() . The delete() / deleteAll() methods rely on EntityManager.remove() therefore the Persistence Context is synchronized accordingly. If automatic optimstic locking mechanism (to prevent lost updates ) is enabled then it will be used. Moreover, cascading removals and orphanRemoval works as well.

Key points for using deleteAll()/delete() :

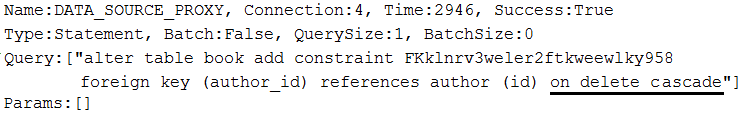

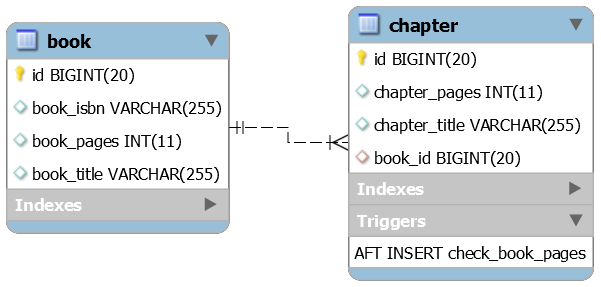

Author entity and each author can have several Book ( one-to-many )orphanRemoval=true and CascadeType.ALLBook from the corresponding AuthororphanRemoval=true to enter into the scene; thanks to this setting, all disassociated books will be deleted; the generated DELETE statements are batched (if orphanRemoval is set to false , a bunch of updates will be executed instead of deletes)Author via the deleteAll() or delete() method (since we have dissaciated all Book , the Author deletion will take advantage of batching as well)ON DELETE CASCADE Description: Batch deletes in MySQL via ON DELETE CASCADE . Auto-generated database schema will contain the ON DELETE CASCADE directive.

Note: Spring deleteAllInBatch() and deleteInBatch() don't use delete batching and don't take advantage of cascading removal, orphanRemoval and automatic optimistic locking mechanism to prevent lost updates (eg, @Version is ignored), but both of them take advantage on ON DELETE CASCADE and are very efficient. They trigger bulk operations via Query.executeUpdate() , therefore, the Persistence Context is not synchronized accordingly (it's up to you to flush (before delete) and close/clear (after delete) the Persistence Context accordingly to avoid issues created by unflushed (if any) or outdated (if any) entities). The first one simply triggers a delete from entity_name statement, while the second one triggers a delete from entity_name where id=? or id=? or id=? ... คำแถลง. For delete in batches rely on deleteAll() , deleteAll(Iterable<? extends T> entities) or delete() method. Behind the scene, the two flavors of deleteAll() relies on delete() . Mixing batching with database automatic actions ( ON DELETE CASCADE ) will result in a partially synchronized Persistent Context.

ประเด็นสำคัญ:

Author entity and each author can have several Book ( one-to-many )orphanRemoval or set it to falseCascadeType.PERSIST and CascadeType.MERGE@OnDelete(action = OnDeleteAction.CASCADE) next to @OneToManyspring.jpa.properties.hibernate.dialect to org.hibernate.dialect.MySQL5InnoDBDialect (or, MySQL8Dialect )deleteFoo() methods that uses bulk and batching deletes as wellOutput example:

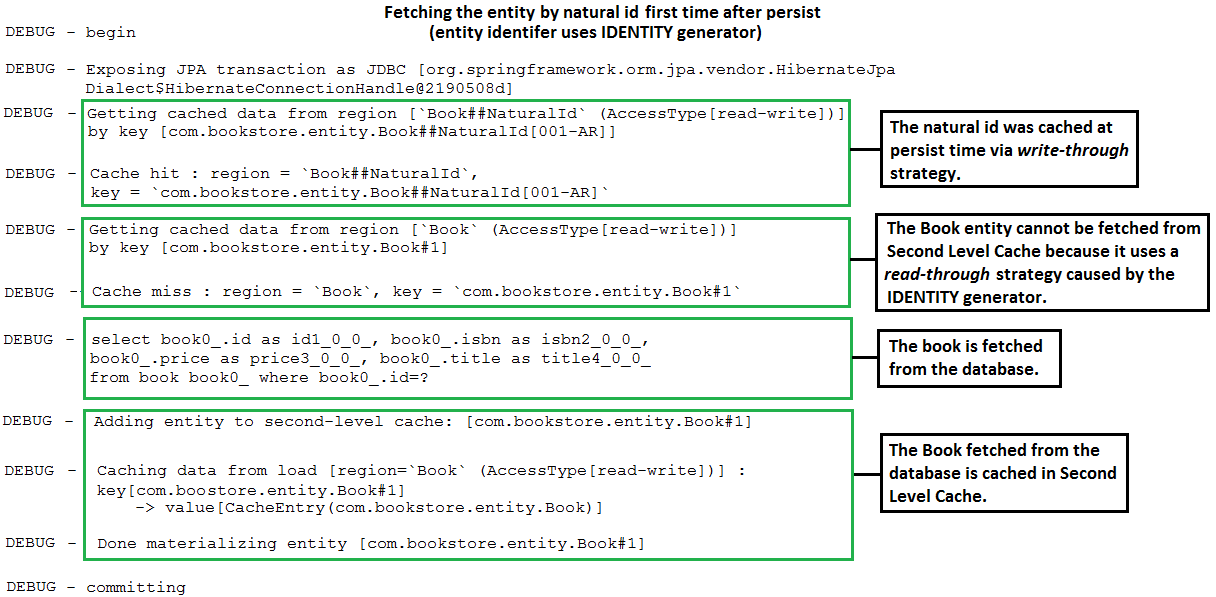

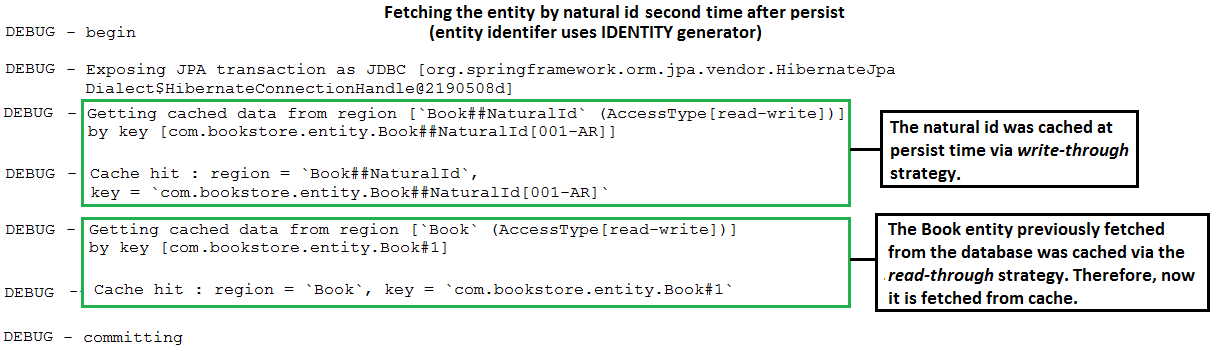

@NaturalId In Spring Boot Style Alternative implementation: In case that you want to avoid extending SimpleJpaRepository check this implementation.

Description: This is a SpringBoot application that maps a natural business key using Hibernate @NaturalId . This implementation allows us to use @NaturalId as it was provided by Spring.

ประเด็นสำคัญ:

Book ), mark the properties (business keys) that should act as natural IDs with @NaturalId ; commonly, there is a single such property, but multiple are suppored as well as here@NaturalId(mutable = false) and @Column(nullable = false, updatable = false, unique = true, ...)@NaturalId(mutable = true) and @Column(nullable = false, updatable = true, unique = true, ...)equals() and hashCode() using the natural id(s)@NoRepositoryBean interface ( NaturalRepository ) to define two methods, named findBySimpleNaturalId() and findByNaturalId()NaturalRepositoryImpl ) relying on Hibernate, Session , bySimpleNaturalId() and byNaturalId() methods@EnableJpaRepositories(repositoryBaseClass = NaturalRepositoryImpl.class) to register this implementation as the base classfindBySimpleNaturalId() or findByNaturalId()| If you need a deep dive into the performance recipes exposed in this repository then I am sure that you will love my book "Spring Boot Persistence Best Practices" | If you need a hand of tips and illustrations of 100+ Java persistence performance issues then "Java Persistence Performance Illustrated Guide" is for you. |

|

|

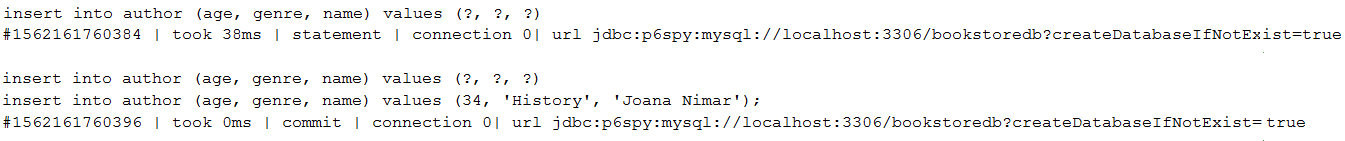

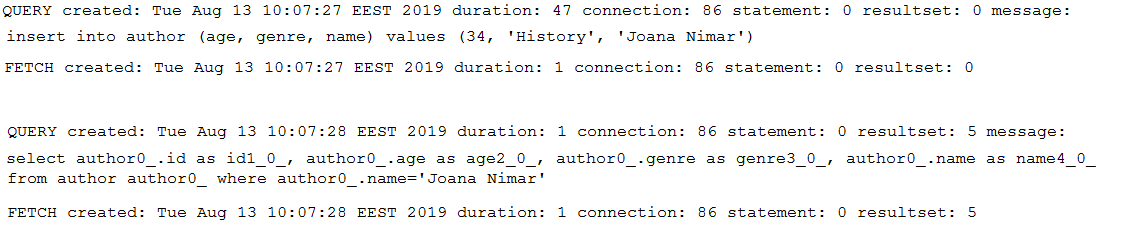

Description: This is a Spring Boot application that uses P6Spy. P6Spy is a framework that enables database data to be seamlessly intercepted and logged with no code changes to the application.

ประเด็นสำคัญ:

pom.xml , add the P6Spy Maven dependencyapplication.properties , set up JDBC URL as, jdbc:p6spy:mysql://localhost:3306/db_usersapplication.properties , set up driver class name as, com.p6spy.engine.spy.P6SpyDriverspy.properties (this file contains P6Spy configurations); in this application, the logs will be outputed to console, but you can easy switch to a file; more details about P6Spy configurations can be found in documentation ตัวอย่างผลลัพธ์:

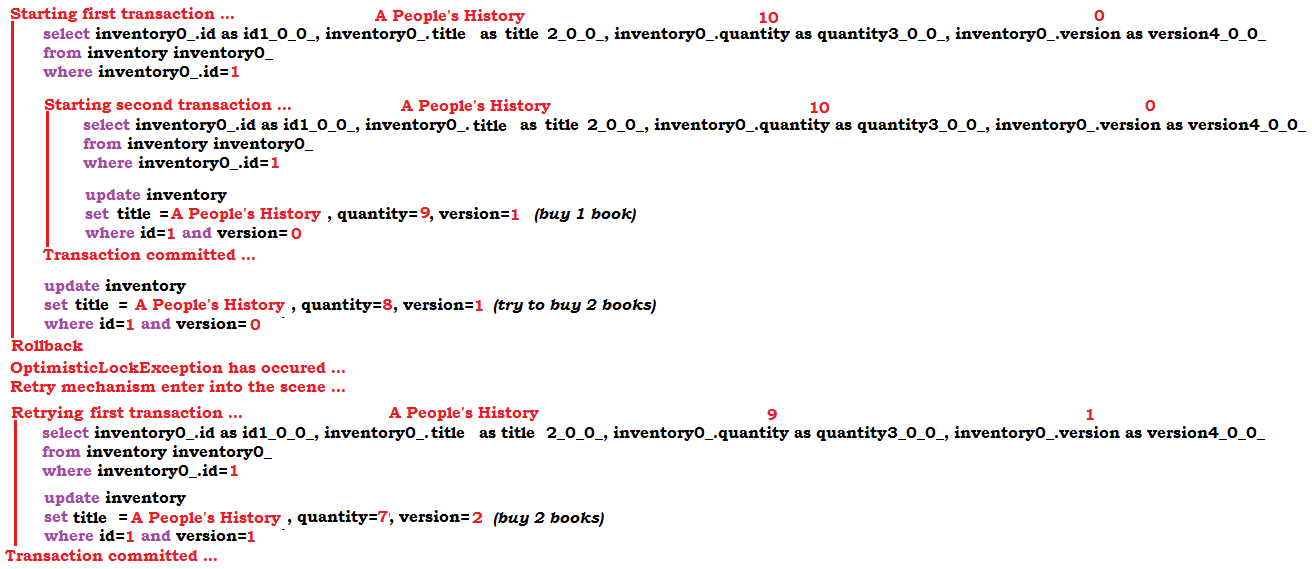

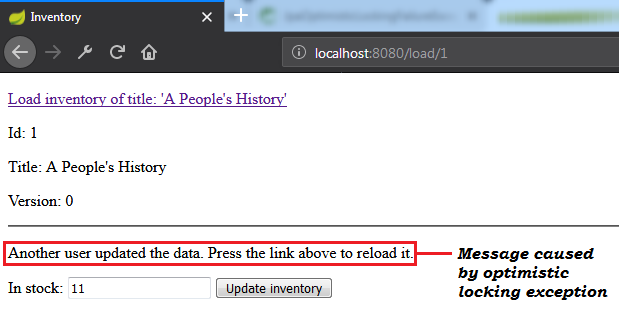

OptimisticLockException Exception ( @Version ) Note: Optimistic locking mechanism via @Version works for detached entities as well.

Description: This is a Spring Boot application that simulates a scenario that leads to an optimistic locking exception. When such exception occur, the application retry the corresponding transaction via db-util library developed by Vlad Mihalcea.

ประเด็นสำคัญ:

pom.xml , add the db-util dependencyOptimisticConcurrencyControlAspect bean@Transactional ) that is prone to throw (or that calls a method that is prone to throw (this method can be annotated with @Transactional )) an optimistic locking exception with @Retry(times = 10, on = OptimisticLockingFailureException.class) ตัวอย่างผลลัพธ์:

OptimisticLockException Exception (Hibernate Version-less Optimistic Locking Mechanism)Note: Optimistic locking mechanism via Hibernate version-less doesn't work for detached entities (don't close the Persistent Context).

Description: This is a Spring Boot application that simulates a scenario that leads to an optimistic locking exception (eg, in Spring Boot, OptimisticLockingFailureException ) via Hibernate version-less optimistic locking. When such exception occur, the application retry the corresponding transaction via db-util library developed by Vlad Mihalcea.

ประเด็นสำคัญ:

pom.xml , add the db-util library dependencyOptimisticConcurrencyControlAspect beanInventory ) with @DynamicUpdate and @OptimisticLocking(type = OptimisticLockType.DIRTY)@Transactional ) that is prone to throw (or that calls a method that is prone to throw (this method can be annotated with @Transactional )) an optimistic locking exception with @Retry(times = 10, on = OptimisticLockingFailureException.class)Note: You may also like to read the recipe, "How To Create DTO Via Spring Data Projections"

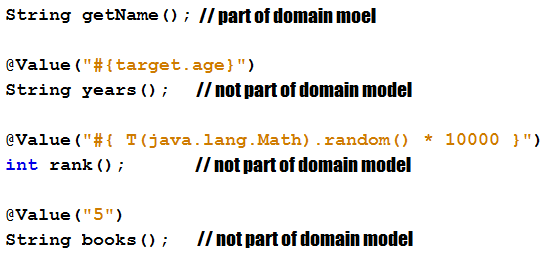

Description: This is an application sample that fetches only the needed columns from the database via Spring Data Projections (DTO) and enrich the result via virtual properties.

ประเด็นสำคัญ:

name and ageAuthorNameAge , use the @Value and Spring SpEL to point to a backing property from the domain model (in this case, the domain model property age is exposed via the virtual property years )AuthorNameAge , use the @Value and Spring SpEL to enrich the result with two virtual properties that don't have a match in the domain model (in this case, rank and books ) Output example:

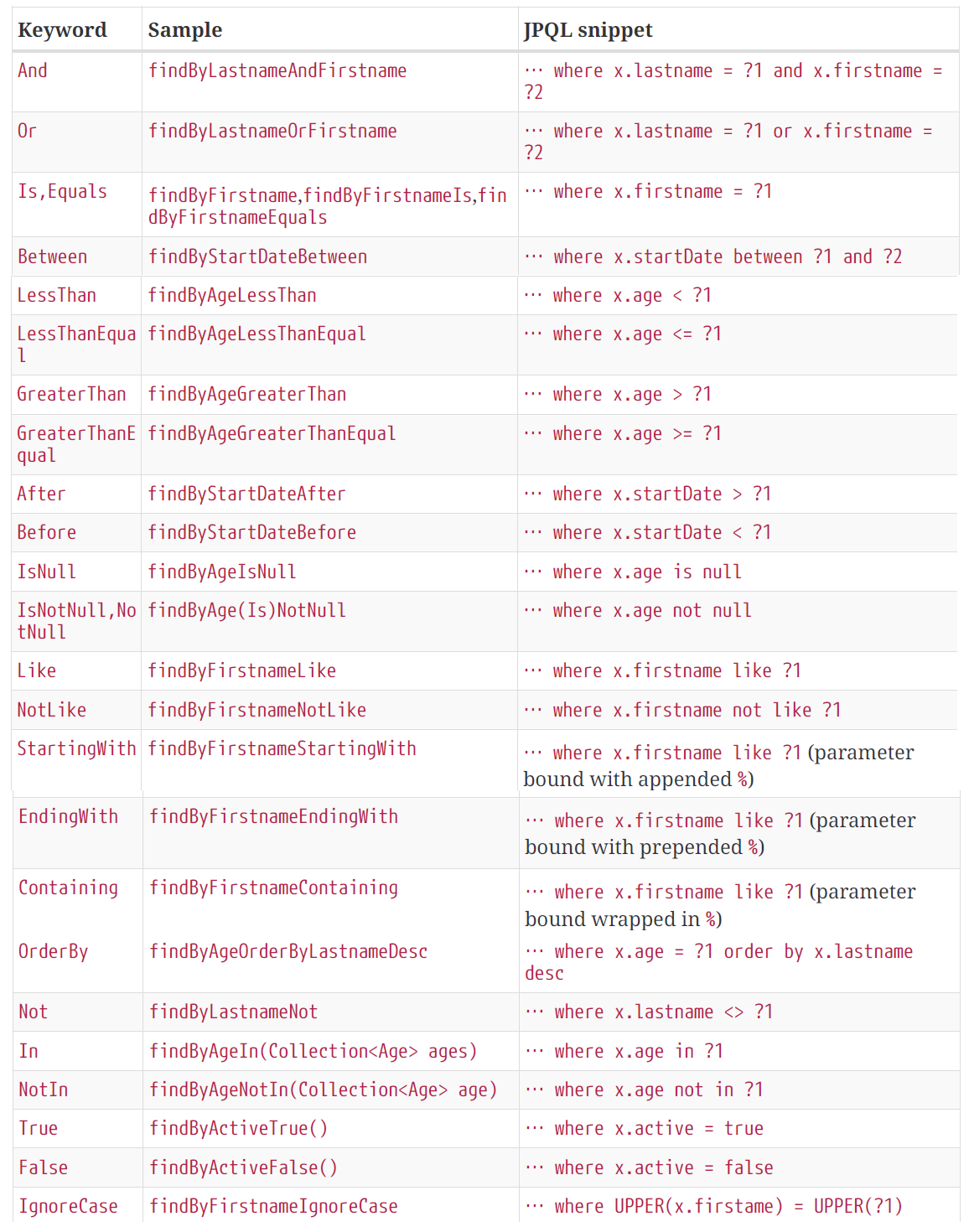

Description: Spring Data comes with the query creation mechanism for JPA that is capable to interpret a query method name and convert it into a SQL query in the proper dialect. This is possible as long as we respect the naming conventions of this mechanism. This is an application that exploit this mechanism to write queries that limit the result size. Basically, the name of the query method instructs Spring Data how to add the LIMIT (or similar clauses depending on the RDBMS) clause to the generated SQL queries.

ประเด็นสำคัญ:

AuthorRepository ) ตัวอย่าง:

- List<Author> findFirst5ByAge(int age);

- List<Author> findFirst5ByAgeGreaterThanEqual(int age);

- List<Author> findFirst5ByAgeLessThan(int age);

- List<Author> findFirst5ByAgeOrderByNameDesc(int age);

- List<Author> findFirst5ByGenreOrderByAgeAsc(String genre);

- List<Author> findFirst5ByAgeGreaterThanEqualOrderByNameAsc(int age);

- List<Author> findFirst5ByGenreAndAgeLessThanOrderByNameDesc(String genre, int age);

- List<AuthorDto> findFirst5ByOrderByAgeAsc();

- Page<Author> queryFirst10ByName(String name, Pageable p);

- Slice<Author> findFirst10ByName(String name, Pageable p);

The list of supported keywords is listed below:

schema-*.sql In MySQL Note: As a rule, in real applications avoid generating schema via hibernate.ddl-auto or set it to validate . Use schema-*.sql file or better Flyway or Liquibase migration tools.

Description: This application is an example of using schema-*.sql to generate a schema(database) in MySQL.

ประเด็นสำคัญ:

application.properties , set the JDBC URL (eg, spring.datasource.url=jdbc:mysql://localhost:3306/bookstoredb?createDatabaseIfNotExist=true )application.properties , disable DDL auto (just don't add explicitly the hibernate.ddl-auto setting)application.properties , instruct Spring Boot to initialize the schema from schema-mysql.sql fileschema-*.sql And Match Entities To Them Via @Table In MySQL Note: As a rule, in real applications avoid generating schema via hibernate.ddl-auto or set it to validate . Use schema-*.sql file or better Flyway or Liquibase .

Description: This application is an example of using schema-*.sql to generate two databases in MySQL. The databases are matched at entity mapping via @Table .

ประเด็นสำคัญ:

application.properties , set the JDBC URL without the database, eg, spring.datasource.url=jdbc:mysql://localhost:3306application.properties , disable DDL auto (just don't specify hibernate.ddl-auto )aaplication.properties , instruct Spring Boot to initialize the schema from schema-mysql.sql fileAuthor entity, specify that the corresponding table ( author ) is in the database authorsdb via @Table(schema="authorsdb")Book entity, specify that the corresponding table ( book ) is in the database booksdb via @Table(schema="booksdb")Output example:

Author results in the following SQL: insert into authorsdb.author (age, genre, name) values (?, ?, ?)Book results the following SQL: insert into booksdb.book (isbn, title) values (?, ?)Note: For web-applications, pagination should be the way to go, not streaming. But, if you choose streaming then keep in mind the golden rule: keep th result set as small as posible. Also, keep in mind that the Execution Plan might not be as efficient as when using SQL-level pagination.

Description: This application is an example of streaming the result set via Spring Data and MySQL. This example can be adopted for databases that fetches the entire result set in a single roundtrip causing performance penalties.

ประเด็นสำคัญ:

@Transactional(readOnly=true) )Integer.MIN_VALUE (recommended in MySQL))Statement fetch-size to Integer.MIN_VALUE , or add useCursorFetch=true to the JDBC URL and set Statement fetch-size to a positive integer (eg, 30)createDatabaseIfNotExist Note: For production, don't rely on hibernate.ddl-auto (or counterparts) to export schema DDL to the database. Simply remove (disable) hibernate.ddl-auto or set it to validate . Rely on Flyway or Liquibase.

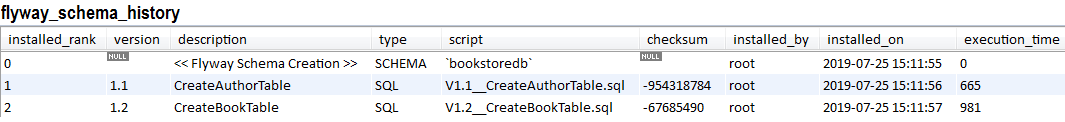

Description: This application is an example of migrating a MySQL database via Flyway when the database exists (it is created before migration via MySQL specific parameter, createDatabaseIfNotExist=true ).

ประเด็นสำคัญ:

pom.xml , add the Flyway dependencyspring.jpa.hibernate.ddl-autoapplication.properties , set the JDBC URL as follows: jdbc:mysql://localhost:3306/bookstoredb?createDatabaseIfNotExist=trueclasspath:db/migrationV1.1__Description.sql , V1.2__Description.sql , ...spring.flyway.schemas Note: For production, don't rely on hibernate.ddl-auto (or counterparts) to export schema DDL to the database. Simply remove (disable) hibernate.ddl-auto or set it to validate . Rely on Flyway or Liquibase.

Description: This application is an example of migrating a MySQL database when the database is created by Flyway via spring.flyway.schemas . In this case, the entities should be annotated with @Table(schema = "bookstoredb") or @Table(catalog = "bookstoredb") . Here, the database name is bookstoredb .

ประเด็นสำคัญ:

pom.xml , add the Flyway dependencyspring.jpa.hibernate.ddl-autoapplication.properties , set the JDBC URL as follows: jdbc:mysql://localhost:3306/application.properties , add spring.flyway.schemas=bookstoredb , where bookstoredb is the database that should be created by Flyway (feel free to add your own database name)@Table(schema/catalog = "bookstoredb")classpath:db/migrationV1.1__Description.sql , V1.2__Description.sql , ... Output of migration history example:

| If you need a deep dive into the performance recipes exposed in this repository then I am sure that you will love my book "Spring Boot Persistence Best Practices" | If you need a hand of tips and illustrations of 100+ Java persistence performance issues then "Java Persistence Performance Illustrated Guide" is for you. |

|

|

Note: For production don't rely on hibernate.ddl-auto to create your schema. Remove (disable) hibernate.ddl-auto or set it to validate . Rely on Flyway or Liquibase.

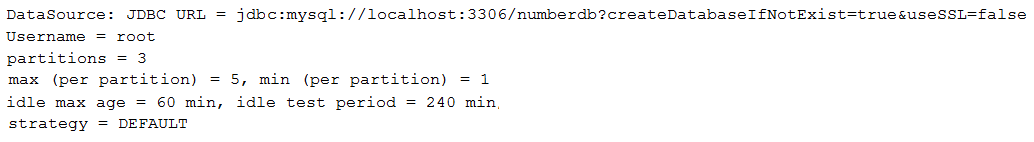

Description: This application is an example of auto-creating and migrating schemas for MySQL and PostgreSQL. In addition, each data source uses its own HikariCP connection pool. In case of MySQL, where schema = database , we auto-create the schema ( authorsdb ) based on createDatabaseIfNotExist=true . In case of PostgreSQL, where a database can have multiple schemas, we use the default postgres database and auto-create in it the schema, booksdb . For this we rely on Flyway, which is capable to create a missing schema.

ประเด็นสำคัญ:

pom.xml , add the Flyway dependencyspring.jpa.hibernate.ddl-auto or set it to validateapplication.properties , configure the JDBC URL for MySQL as, jdbc:mysql://localhost:3306/authorsdb?createDatabaseIfNotExist=true and for PostgreSQL as, jdbc:postgresql://localhost:5432/postgres?currentSchema=booksdbapplication.properties , set spring.flyway.enabled=false to disable default behaviorDataSource for MySQL and one for PostgreSQLFlywayDataSource for MySQL and one for PostgreSQLEntityManagerFactory for MySQL and one for PostgreSQLdbmigrationmysqldbmigrationpostgresql Note: For production, don't rely on hibernate.ddl-auto (or counterparts) to export schema DDL to the database. Simply remove (disable) hibernate.ddl-auto or set it to validate . Rely on Flyway or Liquibase.

Description: This application is an example of auto-creating and migrating two schemas in PostgreSQL using Flyway. In addition, each data source uses its own HikariCP connection pool. In case of PostgreSQL, where a database can have multiple schemas, we use the default postgres database and auto-create two schemas, authors and books . For this we rely on Flyway, which is capable to create the missing schemas.

ประเด็นสำคัญ:

pom.xml , add the Flyway dependencyspring.jpa.hibernate.ddl-auto or set it to validateapplication.properties , configure the JDBC URL for books as jdbc:postgresql://localhost:5432/postgres?currentSchema=books and for authors as jdbc:postgresql://localhost:5432/postgres?currentSchema=authorsapplication.properties , set spring.flyway.enabled=false to disable default behaviorDataSource , one for books and one for authorsFlywayDataSource , one for books and one for authorsEntityManagerFactory , one for books and one for authorsbooks , place the migration SQLs files in dbmigrationbooksauthors , place the migration SQLs files in dbmigrationauthorsJOIN FETCH an @ElementCollection Description: This application is an example applying JOIN FETCH to fetch an @ElementCollection .

ประเด็นสำคัญ:

@ElementCollection is loaded lazy, keep it lazyJOIN FETCH in the repository@Subselect ) in a Spring Boot Application Note: Consider using @Subselect only if using DTO, DTO and extra queries, or map a database view to an entity is not a solution.

Description: This application is an example of mapping an entity to a query via Hibernate, @Subselect . Mainly, we have two entities in a bidirectional one-to-many association. An Author has wrote several Book . The idea is to write a read-only query to fetch from Author only some fields (eg, DTO), but to have the posibility to call getBooks() and fetch the Book in a lazy manner as well. As you know, a classic DTO cannot be used, since such DTO is not managed and we cannot navigate the associations (don't support any managed associations to other entities). Via Hibernate @Subselect we can map a read-only and immutable entity to a query. This time, we can lazy navigate the associations.

ประเด็นสำคัญ:

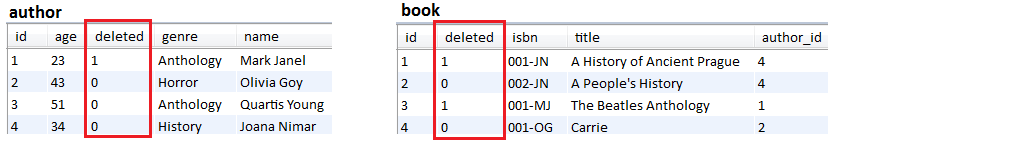

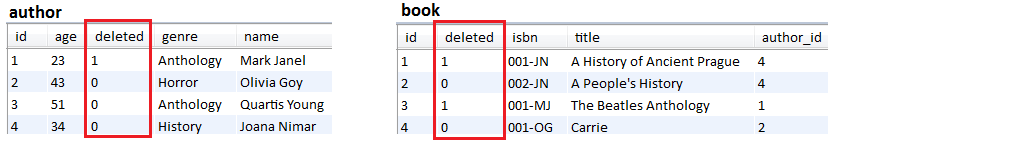

Author (including association to Book )@Immutable since no write operations are allowed@Synchronize@Subselect to write the needed query, map an entity to an SQL queryDescription: This application is an example of using Hibernate soft deletes in a Spring Boot application.

ประเด็นสำคัญ:

abstract class BaseEntity with a field named deletedAuthor and Book entities) that should take advantage of soft deletes should extend BaseEntity@Where annotation like this: @Where(clause = "deleted = false")@SQLDelete annotation to trigger UPDATE SQLs in place of DELETE SQLs, as follows: @SQLDelete(sql = "UPDATE author SET deleted = true WHERE id = ?") Output example:

DataSourceBuilder If you use the spring-boot-starter-jdbc or spring-boot-starter-data-jpa "starters", you automatically get a dependency to HikariCP

Note: The best way to tune the connection pool parameters consist in using Flexy Pool by Vlad Mihalcea. Via Flexy Pool you can find the optim settings that sustain high-performance of your connection pool.

Description: This is a kickoff application that set up HikariCP via DataSourceBuilder . The jdbcUrl is set up for a MySQL database. For testing purposes, the application uses an ExecutorService for simulating concurrent users. Check the HickariCP report revealing the connection pool status.

ประเด็นสำคัญ:

@Bean that returns the DataSource programmaticallyDescription: Auditing is useful for maintaining history records. This can later help us in tracking user activities.

ประเด็นสำคัญ:

abstract base entity (eg, BaseEntity ) and annotate it with @MappedSuperclass and @EntityListeners({AuditingEntityListener.class})@CreatedDate protected LocalDateTime created;@LastModifiedDate protected LocalDateTime lastModified;@CreatedBy protected U createdBy;@LastModifiedBy protected U lastModifiedBy;@EnableJpaAuditing(auditorAwareRef = "auditorAware")AuditorAware (this is needed for persisting the user that performed the modification; use Spring Security to return the currently logged-in user)@Beanspring.jpa.hibernate.ddl-auto=create )Description: Auditing is useful for maintaining history records. This can later help us in tracking user activities.

ประเด็นสำคัญ:

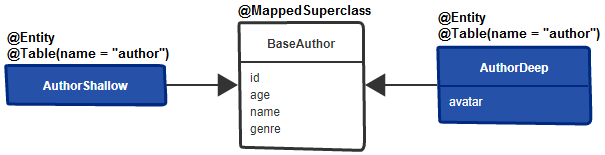

@Audited@AuditTable to rename the table used for auditingValidityAuditStrategy for fast database reads, but slower writes (slower than the default DefaultAuditStrategy )Description: By default, the attributes of an entity are loaded eager (all at once). This application is an alternative to How To Use Hibernate Attribute Lazy Loading from here. This application uses a base class to isolate the attributes that should be loaded eagerly and subentities (entities that extends the base class) for isolating the attributes that should be loaded on demand.

ประเด็นสำคัญ:

BaseAuthor , and annotate it with @MappedSuperclassAuthorShallow subentity of BaseAuthor and don't add any attribute in it (this will inherit the attributes from the superclass)AuthorDeep subentity of BaseAuthor and add to it the attributes that should be loaded on demand (eg, avatar )@Table(name = "author")AuthorShallowRepository and AuthorDeepRepositoryRun the following requests (via BookstoreController):

localhost:8080/authors/shallowlocalhost:8080/authors/deepCheck as well:

Description: Fetching more data than needed is prone to performance penalities. Using DTO allows us to extract only the needed data. In this application we rely on constructor and Spring Data Query Builder Mechanism.

ประเด็นสำคัญ:

ดูเพิ่มเติมที่:

Dto Via Constructor Expression and JPQL

| If you need a deep dive into the performance recipes exposed in this repository then I am sure that you will love my book "Spring Boot Persistence Best Practices" | If you need a hand of tips and illustrations of 100+ Java persistence performance issues then "Java Persistence Performance Illustrated Guide" is for you. |

|

|

JOIN Description: Using JOIN is very useful for fetching DTOs (data that is never modified, not in the current or subsequent requests). For example, consider two entities, Author and Book in a lazy-bidirectional @OneToMany association. And, we want to fetch a subset of columns from the parent table ( author ) and a subset of columns from the child table ( book ). This job is a perfect fit for JOIN which can pick up columns from different tables and build a raw result set. This way we fetch only the needed data. Moreover, we may want to serve the result set in pages (eg, via LIMIT ). This application contains several approaches for accomplishing this task with offset pagination.

ประเด็นสำคัญ:

Page (with SELECT COUNT and COUNT(*) OVER() window function)Slice and ListDENSE_RANK() for avoiding the truncation of the result set (an author can be fetched with only a subset of his books)LEFT JOIN FETCHดูเพิ่มเติมที่:

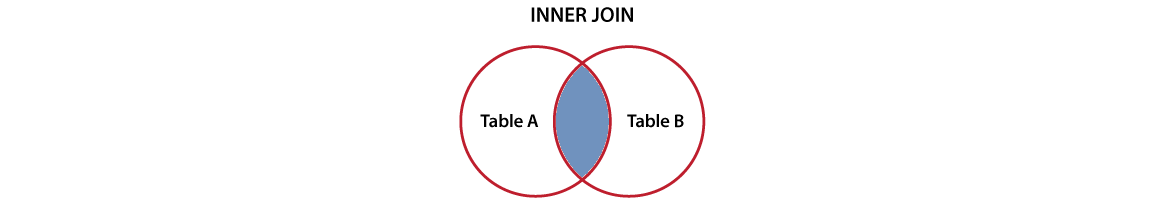

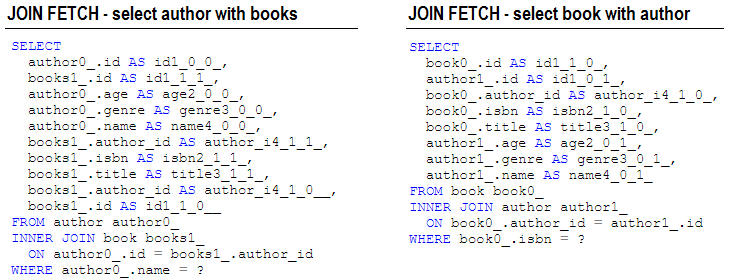

Description: Let's assume that we have two entities engaged in a one-to-many (or many-to-many) lazy bidirectional (or unidirectional) relationship (eg, Author has more Book ). And, we want to trigger a single SELECT that fetches all Author and the corresponding Book . This is a job for JOIN FETCH which is converted behind the scene into a INNER JOIN . Being an INNER JOIN , the SQL will return only Author that have Book . If we want to return all Author , including those that doesn't have Book , then we can rely on LEFT JOIN FETCH . Similar, we can fetch all Book , including those with no registered Author . This can be done via LEFT JOIN FETCH or LEFT JOIN .

ประเด็นสำคัญ:

Author and Book in a one-to-many lazy bidirectional relationship)LEFT JOIN FETCH to fetch all authors and books (fetch authors even if they don't have registered books)LEFT JOIN FETCH to fetch all books and authors (fetch books even if they don't have registered authors)JOIN VS. JOIN FETCHดูเพิ่มเติมที่:

Description: This is an application meant to reveal the differences between JOIN and JOIN FETCH . The important thing to keep in mind is that, in case of LAZY fetching, JOIN will not be capable to initialize the associated collections along with their parent objects using a single SQL SELECT . On the other hand, JOIN FETCH is capable to accomplish this kind of task. But, don't underestimate JOIN , because JOIN is the proper choice when we need to combine/join the columns of two (or more) tables in the same query, but we don't need to initialize the associated collections on the returned entity (eg, very useful for fetching DTO).

ประเด็นสำคัญ:

Author and Book in a one-to-many lazy-bidirectional relationship)JOIN and JOIN FETCH to fetch an author including his booksJOIN to fetch a book (1)JOIN to fetch a book including its author (2)JOIN FETCH to fetch a book including its authorNotice that:

JOIN , fetching Book of Author requires additional SELECT statements being prone to N+1 performance penaltyJOIN (1), fetching Author of Book requires additional SELECT statements being prone to N+1 performance penaltyJOIN (2), fetching Author of Book works exactly as JOIN FETCH (requires a single SELECT )JOIN FETCH , fetching each Author of a Book requires a single SELECT Description: If, for some reason, you need an entity in your Spring projection (DTO), then this application shows you how to do it via an example. In this case, there are two entities, Author and Book , involved in a lazy bidirectional one-to-many association (it can be other association as well, or even no materialized association). And, we want to fetch in a Spring projection the authors as entities, Author , and the title of the books.

ประเด็นสำคัญ:

Author and Book in a one-to-many lazy bidirectional relationship)public Author getAuthor() and public String getTitle() Description: If, for some reason, you need an entity in your Spring projection (DTO), then this application shows you how to do it via an example. In this case, there are two entities, Author and Book , that have no materialized association between them, but, they share the genre attribute. We use this attribute to join authors with books via JPQL. And, we want to fetch in a Spring projection the authors as entities, Author , and the title of the books.

ประเด็นสำคัญ: