ควบคุมการเคลื่อนไหว

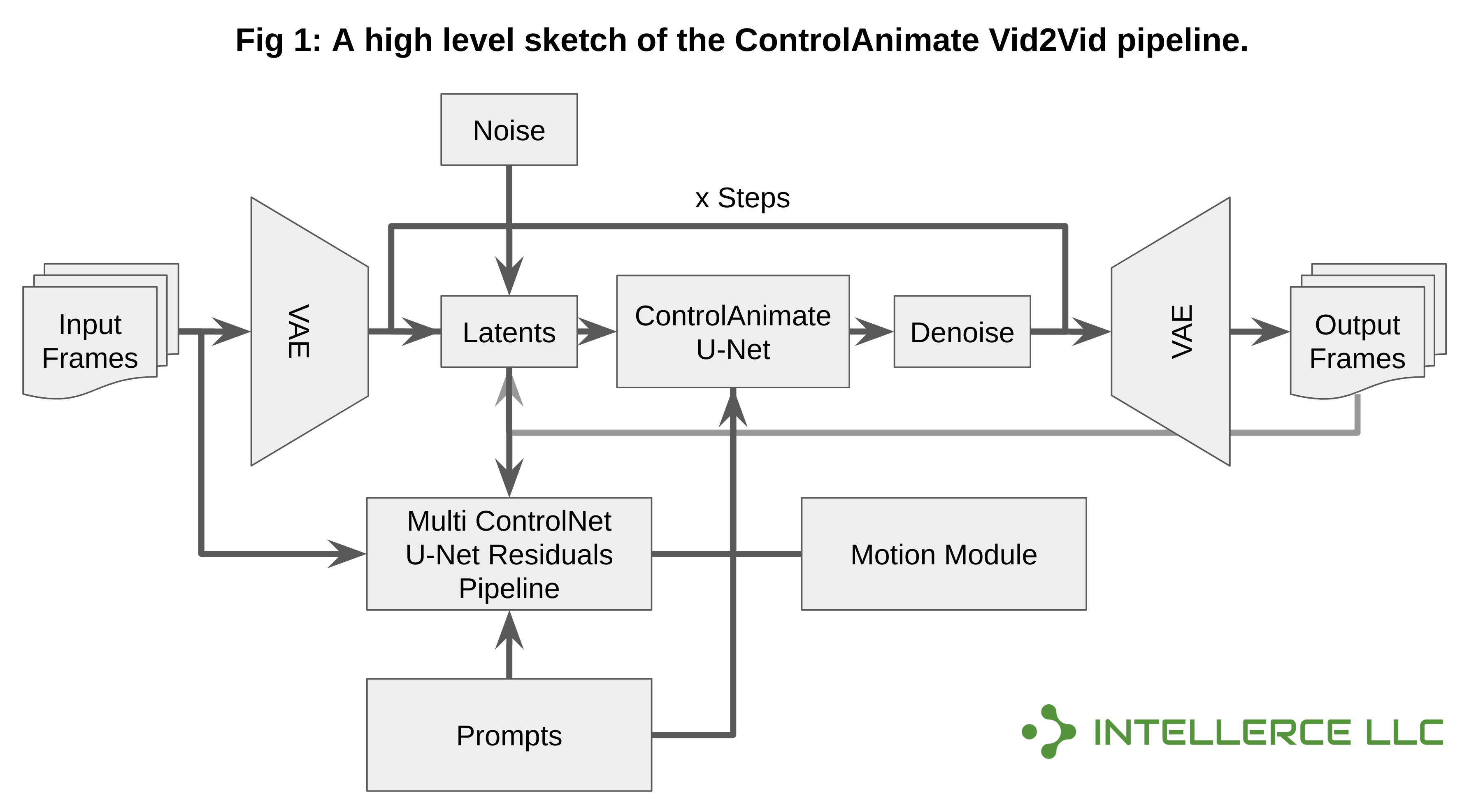

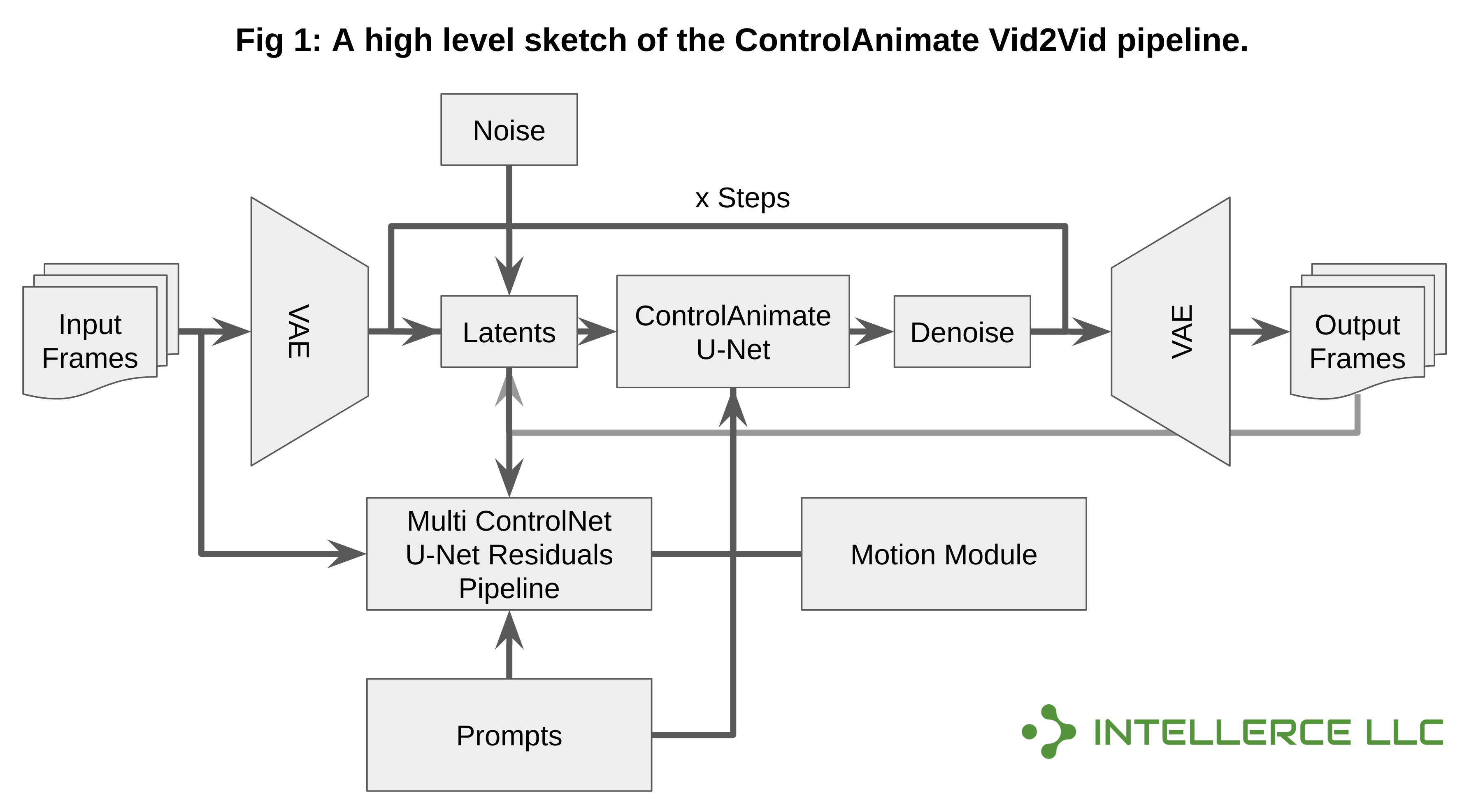

- การรวม AnimateDiff เข้ากับ Multi-ControlNet และ Img2Img สำหรับแอปพลิเคชัน Vid2Vid ไลบรารีขนาดเล็กนี้เน้นไปที่แอปพลิเคชัน Vid2Vid เป็นพิเศษโดยใช้ ControlNet (หรือ Multi-ControlNet) เพื่อเป็นแนวทางในการสร้างวิดีโอและ AnimateDiff เพื่อความสอดคล้อง

- นอกจากนี้ยังใช้ Img2Img เพื่อสร้างวิดีโอที่สอดคล้องกันมากขึ้น (หลังจากยุคแรก) เช่นเดียวกับ AnimateDiff อนุญาตให้ใช้โมเดล DreamBooth/LoRA นอกเหนือจากโมเดลพื้นฐาน Stable Diffusion 1.5

- นี่เป็นการเปิดตัวครั้งแรก ดังนั้นโปรดคาดหวังถึงปัญหาและข้อบกพร่องที่อาจเกิดขึ้น ยินดีรับข้อเสนอแนะข้อเสนอแนะและการร้องขอคุณสมบัติ

ข่าว

- 20 พ.ย. 2023 - รองรับ IP-Adapter, xformers และ Color Matching แล้ว!

- 12 พ.ย. 2023 - รองรับ LCM-LoRA และ ControlNet แล้วสำหรับการผสมผสานทั้งหมด!

- 7 พ.ย. 2023 - รองรับ Latent Consistency Model (LCM) แล้ว - ประสิทธิภาพเพิ่มขึ้น 10 เท่า!

คุณสมบัติที่รองรับ

- - อะแดปเตอร์ IP (ใช้สำหรับเพิ่มความคล้ายคลึงกันของชุดของเฟรม AnimateDiff)

- - โมเดลความคงตัวแฝง LoRA (LCM-LoRA)

- - แบบจำลองความสอดคล้องแฝง (LCM) เนทิฟ

- - Multi-ControlNet สามารถใช้ร่วมกับ LCM ฯลฯ ได้

- - การถ่วงน้ำหนักและคำสั่งแบบยาว (บังคับ)

- - ดรีมบูธ และ LoRA

- - การแก้ไข FFMPEG

- - การจับคู่สีระหว่างแบทช์เพื่อความสม่ำเสมอที่ดีขึ้น

- - การทับซ้อนกันที่แฝงอยู่ (Img2Img & ControlNet) และการทับซ้อนกันของเฟรม (การผสม)

- - การเพิ่มประสิทธิภาพและการลดขนาดใบหน้า (GFPGAN & RealESRGAN)

- - อัตราเฟรมที่กำหนดเอง ระยะเวลา และการสุ่มตัวอย่างความละเอียดของวิดีโออินพุต

- - เปิดใช้งาน xformers แล้ว

ความเข้ากันได้และข้อกำหนด

- โค้ดเบสนี้ได้รับการทดสอบบน Linux (Ubuntu 22.04) เท่านั้น ได้รับการทดสอบบนเครื่อง Intel ที่ใช้ NVIDIA Gefore RTX 3090 (24 GB VRAM) และต้องการ RAM อย่างน้อย 16 GB

การติดตั้ง

- ตรวจสอบให้แน่ใจว่าคุณได้ติดตั้ง Anaconda แล้ว (https://www.anaconda.com/download)

- ตรวจสอบให้แน่ใจว่าติดตั้งและตั้งค่า FFMPEG อย่างถูกต้อง (คุณสามารถทำตามคำแนะนำเหล่านี้สำหรับการติดตั้ง: "Guide 1" และหากยังมีปัญหาอยู่: "Guide 2" - คุณสามารถตั้งค่าเส้นทาง FFMPEG ใน configs/prompts yaml ไฟล์)

git clone [email protected]:intellerce/controlanimate.git

cd ControlAnimate

bash download.sh

conda env create -f env.yml

Vid2Vid

- หลังจากตั้งค่าไฟล์กำหนดค่า 'configs/prompts/SampleConfig.yaml' แล้ว ให้เรียกใช้สิ่งต่อไปนี้ (อย่าลืมชี้ไปที่ไฟล์วิดีโออินพุตที่ถูกต้อง):

conda activate controlanimate

bash start.sh

ทดสอบกับเครื่องที่มี RTX 3090 ตัวเดียว

การถ่วงน้ำหนักทันที

- การถ่วงน้ำหนักแบบทันทีจะขึ้นอยู่กับ Compel คุณสามารถใช้ + หรือ (...)+ เพื่อความสำคัญหรือเพิ่มน้ำหนักได้ดังนี้: (cat)1.2 ในทำนองเดียวกัน คุณสามารถใช้เครื่องหมายลบ (-) เพื่อลดน้ำหนักหรือใช้น้ำหนักที่ต่ำกว่า 1. โปรดดูที่ https:// github.com/damian0815/compel/blob/main/Reference.md สำหรับข้อมูลเพิ่มเติม

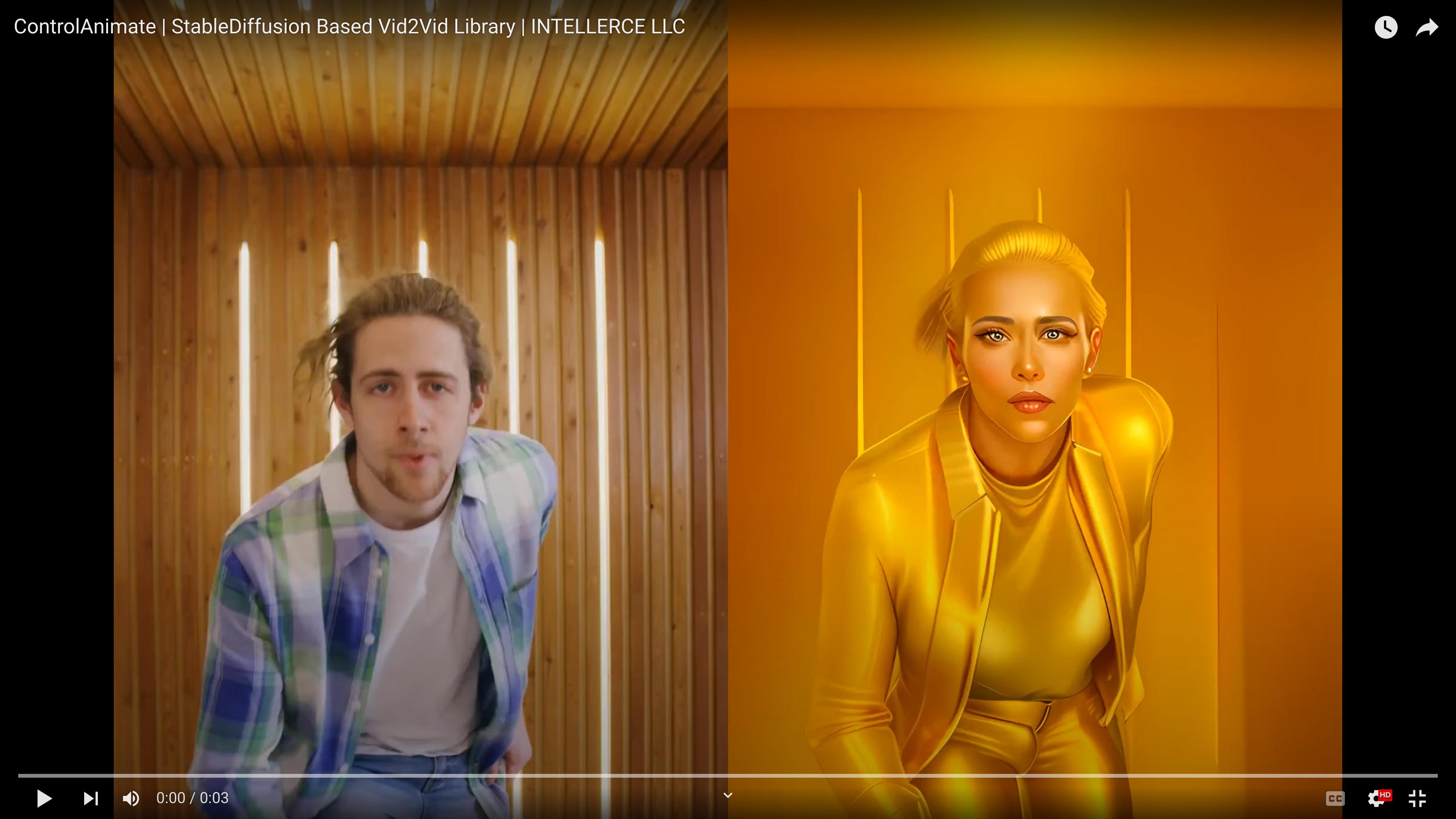

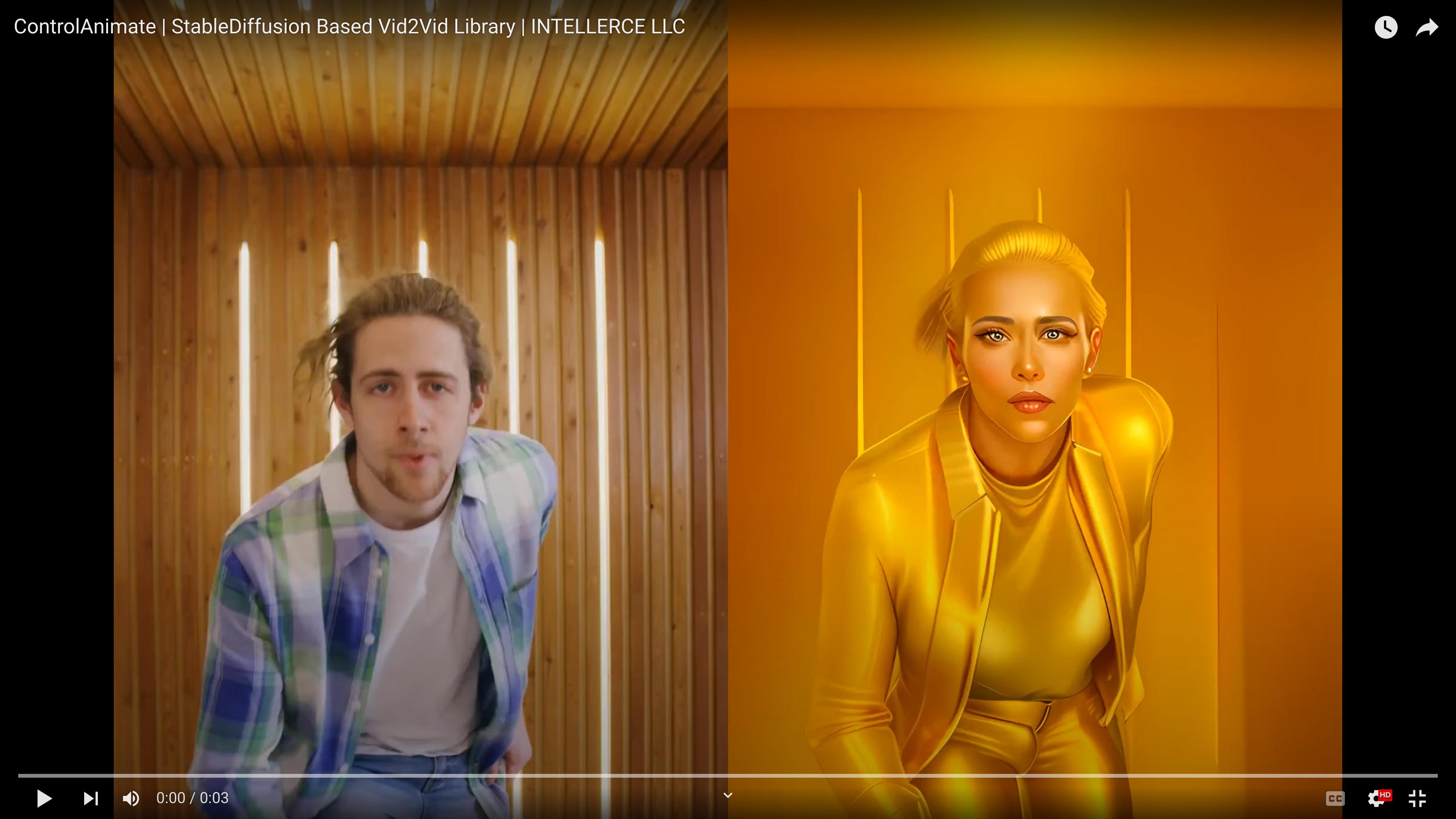

ผลลัพธ์

- ControlNet สี่รายการและการทับซ้อนกันที่แฝงอยู่ (configs/prompts/SampleConfig.yaml)

- LCM (ไม่มี ControlNet) (configs/prompts/SampleConfigLCM.yaml)

- LCM-LoRA + Multi-ControlNet (configs/prompts/SampleConfigLCMLoRA.yaml)

- อะแดปเตอร์ IP + LCM-LoRA + Multi-ControlNet (configs/prompts/SampleConfigIPAdapter.yaml)

สิ่งที่ต้องทำ

ติดต่อเรา

ฮาเหม็ด โอมิดวาร์, Ph.D. : [email protected]

วาฮิเดห์ อาคลากี, Ph.D. : [email protected]

ใบอนุญาต

codebase นี้เผยแพร่ภายใต้ลิขสิทธิ์ Apache v2.0 สำหรับใบอนุญาตของฐานรหัสที่พื้นที่เก็บข้อมูลนี้ใช้อยู่ โปรดดูที่หน้า Github/เว็บไซต์ที่เกี่ยวข้อง

รับทราบ

โค้ดเบสนี้สร้างขึ้นและ/หรือได้รับแรงบันดาลใจจากแหล่งเก็บข้อมูลต่อไปนี้: AnimateDiff Diffusers IP-Adapter Video2Video Color Matcher

ผู้เขียนขอขอบคุณ Kalin Ovtcharov (Extropolis Corp.) สำหรับข้อเสนอแนะและข้อเสนอแนะอันล้ำค่า