กรอบการประเมินสำหรับแบบจำลองภาษาขนาดใหญ่หลายภาษา

Repo นี้ประกอบด้วยชุดข้อมูลเบนช์มาร์กและสคริปต์การประเมินผลสำหรับ Multilingual Large Language Models (LLM) ชุดข้อมูลเหล่านี้สามารถใช้เพื่อประเมินโมเดลใน 26 ภาษาที่แตกต่างกัน และครอบคลุมงานที่แตกต่างกันสามงาน: ARC, HellaSwag และ MMLU สิ่งนี้เปิดตัวโดยเป็นส่วนหนึ่งของกรอบงาน Okapi ของเราสำหรับ LLM ที่ปรับแต่งตามคำสั่งหลายภาษา พร้อมด้วยการเรียนรู้เสริมจากความคิดเห็นของมนุษย์

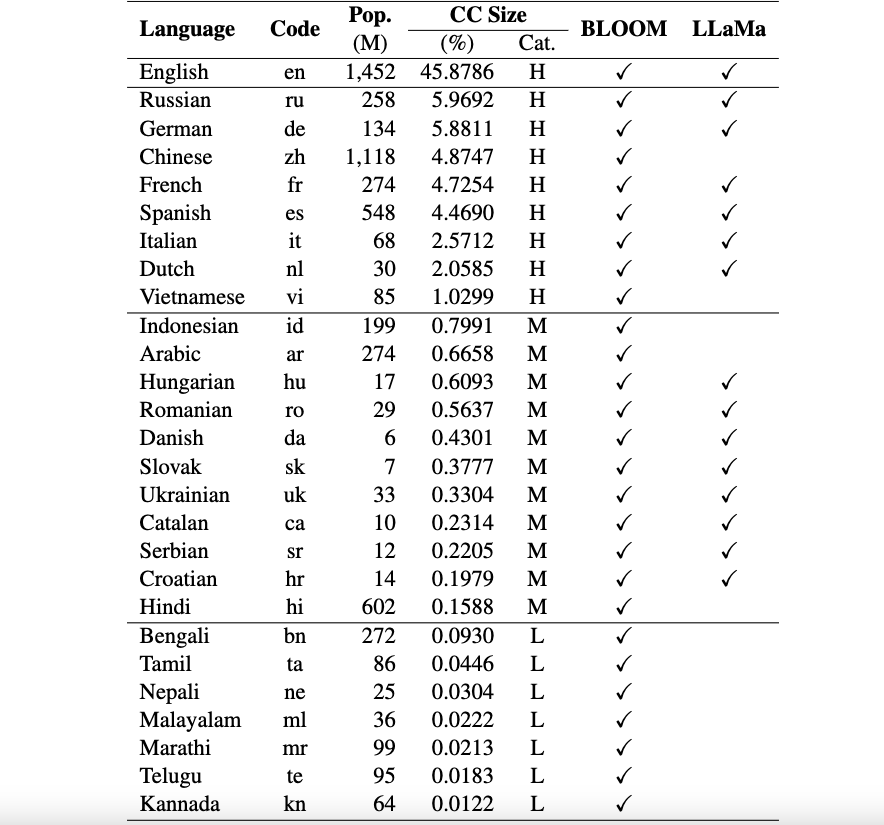

ปัจจุบันชุดข้อมูลของเรารองรับ 26 ภาษา: รัสเซีย เยอรมัน จีน ฝรั่งเศส สเปน อิตาลี ดัตช์ เวียดนาม อินโดนีเซีย อาหรับ ฮังการี โรมาเนีย เดนมาร์ก สโลวัก ยูเครน คาตาลัน เซอร์เบีย โครเอเชีย ฮินดี เบงกาลี ทมิฬ เนปาล มาลายาลัม มราฐี เตลูกู และกันนาดา

ชุดข้อมูลเหล่านี้แปลจากชุดข้อมูล ARC, HellaSwag และ MMLU ดั้งเดิมเป็นภาษาอังกฤษโดยใช้ ChatGPT เอกสารทางเทคนิคของเราสำหรับ Okapi เพื่ออธิบายชุดข้อมูลพร้อมกับผลการประเมินสำหรับ LLM หลายภาษา (เช่น BLOOM, LLaMa และโมเดล Okapi ของเรา) สามารถพบได้ที่นี่

ประกาศการใช้งานและใบอนุญาต : กรอบการประเมินของเรามีจุดมุ่งหมายและได้รับอนุญาตสำหรับใช้ในการวิจัยเท่านั้น ชุดข้อมูลเป็น CC BY NC 4.0 (อนุญาตเฉพาะการใช้งานที่ไม่ใช่เชิงพาณิชย์) ซึ่งไม่ควรนำไปใช้นอกวัตถุประสงค์การวิจัย

หากต้องการติดตั้ง lm-eval จากสาขาหลักของพื้นที่เก็บข้อมูลของเรา ให้รัน:

git clone https://github.com/nlp-uoregon/mlmm-evaluation.git

cd mlmm-evaluation

pip install -e " .[multilingual] " ประการแรก คุณต้องดาวน์โหลดชุดข้อมูลการประเมินหลายภาษาโดยใช้สคริปต์ต่อไปนี้:

bash scripts/download.shหากต้องการประเมินโมเดลของคุณในสามงาน คุณสามารถใช้สคริปต์ต่อไปนี้:

bash scripts/run.sh [LANG] [YOUR-MODEL-PATH]ตัวอย่างเช่น หากคุณต้องการประเมินโมเดล Okapi ของเวียดนาม คุณสามารถเรียกใช้:

bash scripts/run.sh vi uonlp/okapi-vi-bloomเรารักษากระดานผู้นำเพื่อติดตามความคืบหน้าของ LLM หลายภาษา

กรอบงานของเราสืบทอดส่วนใหญ่มาจาก repo การประเมิน lm จาก EleutherAI โปรดอ้างอิง repo ของพวกเขาด้วยหากคุณใช้รหัส

หากคุณใช้ข้อมูล โมเดล หรือโค้ดในพื้นที่เก็บข้อมูลนี้ โปรดอ้างอิง:

@article { dac2023okapi ,

title = { Okapi: Instruction-tuned Large Language Models in Multiple Languages with Reinforcement Learning from Human Feedback } ,

author = { Dac Lai, Viet and Van Nguyen, Chien and Ngo, Nghia Trung and Nguyen, Thuat and Dernoncourt, Franck and Rossi, Ryan A and Nguyen, Thien Huu } ,

journal = { arXiv e-prints } ,

pages = { arXiv--2307 } ,

year = { 2023 }

}