ACM MM'18 ผลงานนักเรียนที่ดีที่สุด

โครงการ Multi-Human Parsing ของกลุ่มการเรียนรู้และการมองเห็น (LV) มหาวิทยาลัยแห่งชาติสิงคโปร์ (NUS) ได้รับการเสนอเพื่อผลักดันขอบเขตของความเข้าใจด้วยภาพอย่างละเอียดของมนุษย์ในที่เกิดเหตุฝูงชน

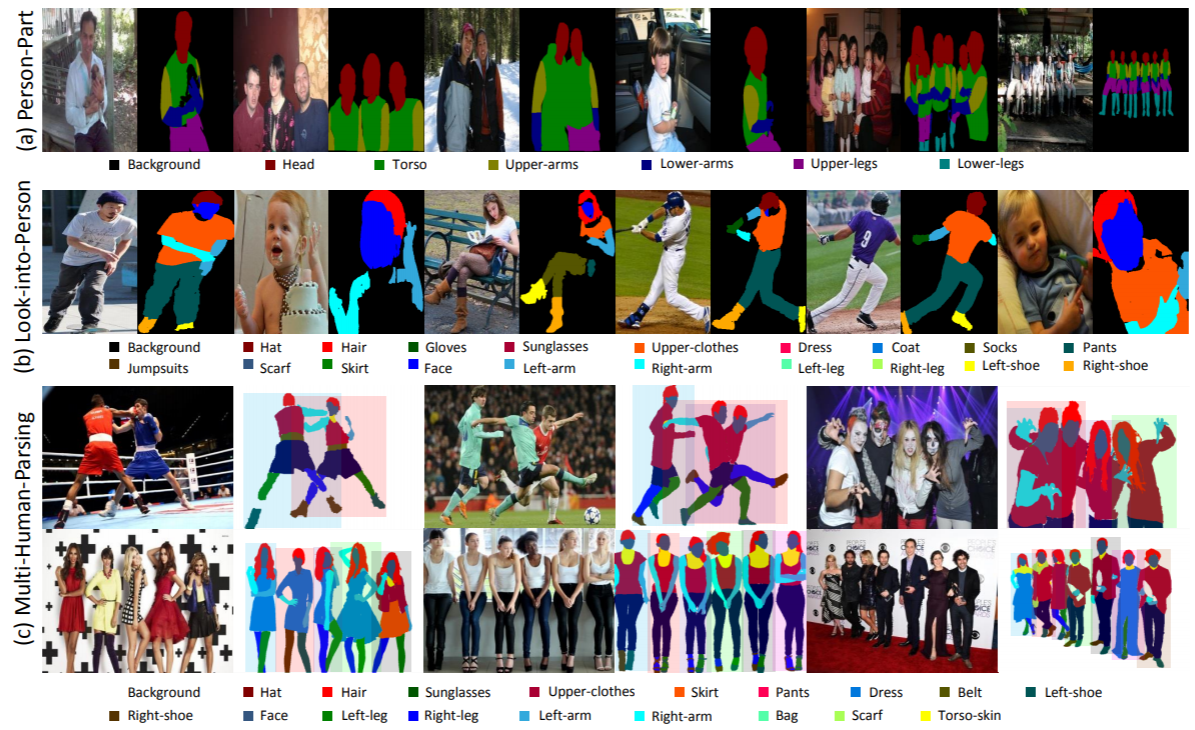

การแยกวิเคราะห์แบบหลายมนุษย์แตกต่างอย่างมากจากงานการรู้จำวัตถุที่กำหนดไว้อย่างดีแบบดั้งเดิม เช่น การตรวจจับวัตถุ ซึ่งให้การคาดการณ์ตำแหน่งของวัตถุในระดับหยาบเท่านั้น (กล่องขอบเขต) การแบ่งส่วนอินสแตนซ์ ซึ่งจะคาดการณ์เฉพาะมาสก์ระดับอินสแตนซ์โดยไม่มีข้อมูลโดยละเอียดเกี่ยวกับส่วนต่างๆ ของร่างกายและหมวดหมู่แฟชั่น การแยกวิเคราะห์โดยมนุษย์ ซึ่งดำเนินการตามการคาดการณ์พิกเซลระดับหมวดหมู่ โดยไม่แยกแยะความแตกต่างระหว่างตัวตน

ในสถานการณ์โลกแห่งความเป็นจริง การตั้งค่าของบุคคลหลายคนที่มีการโต้ตอบจะสมจริงและเป็นเรื่องปกติมากขึ้น ดังนั้นงาน ชุดข้อมูลที่เกี่ยวข้อง และวิธีการพื้นฐานในการพิจารณาทั้งข้อมูลความหมายที่ละเอียดของแต่ละบุคคล ตลอดจนความสัมพันธ์และการโต้ตอบของคนทั้งกลุ่มจึงเป็นที่ต้องการอย่างมาก

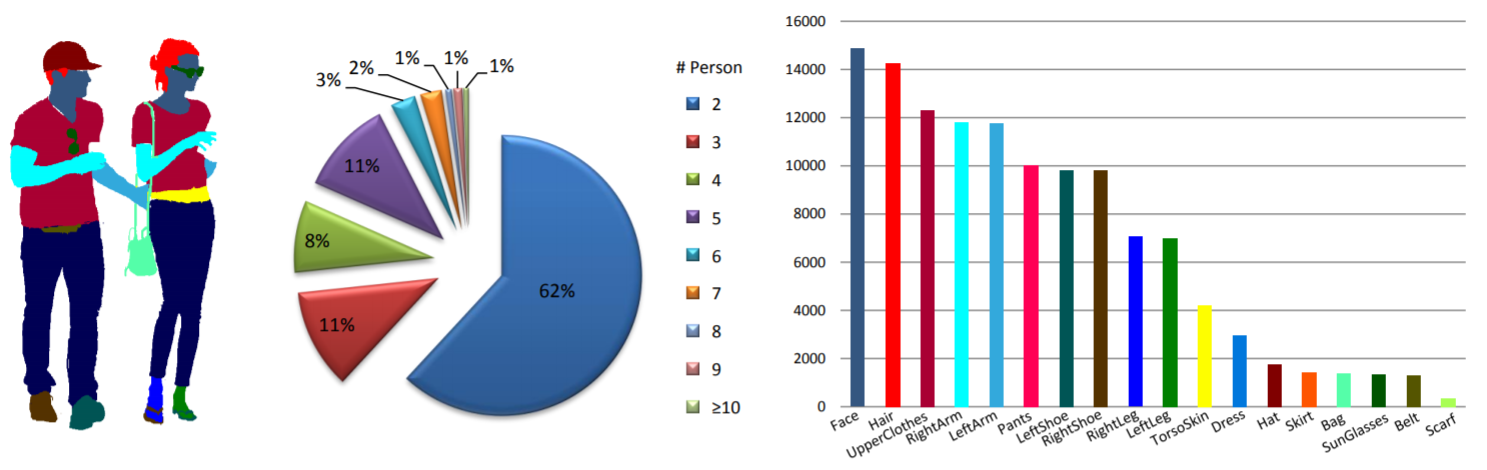

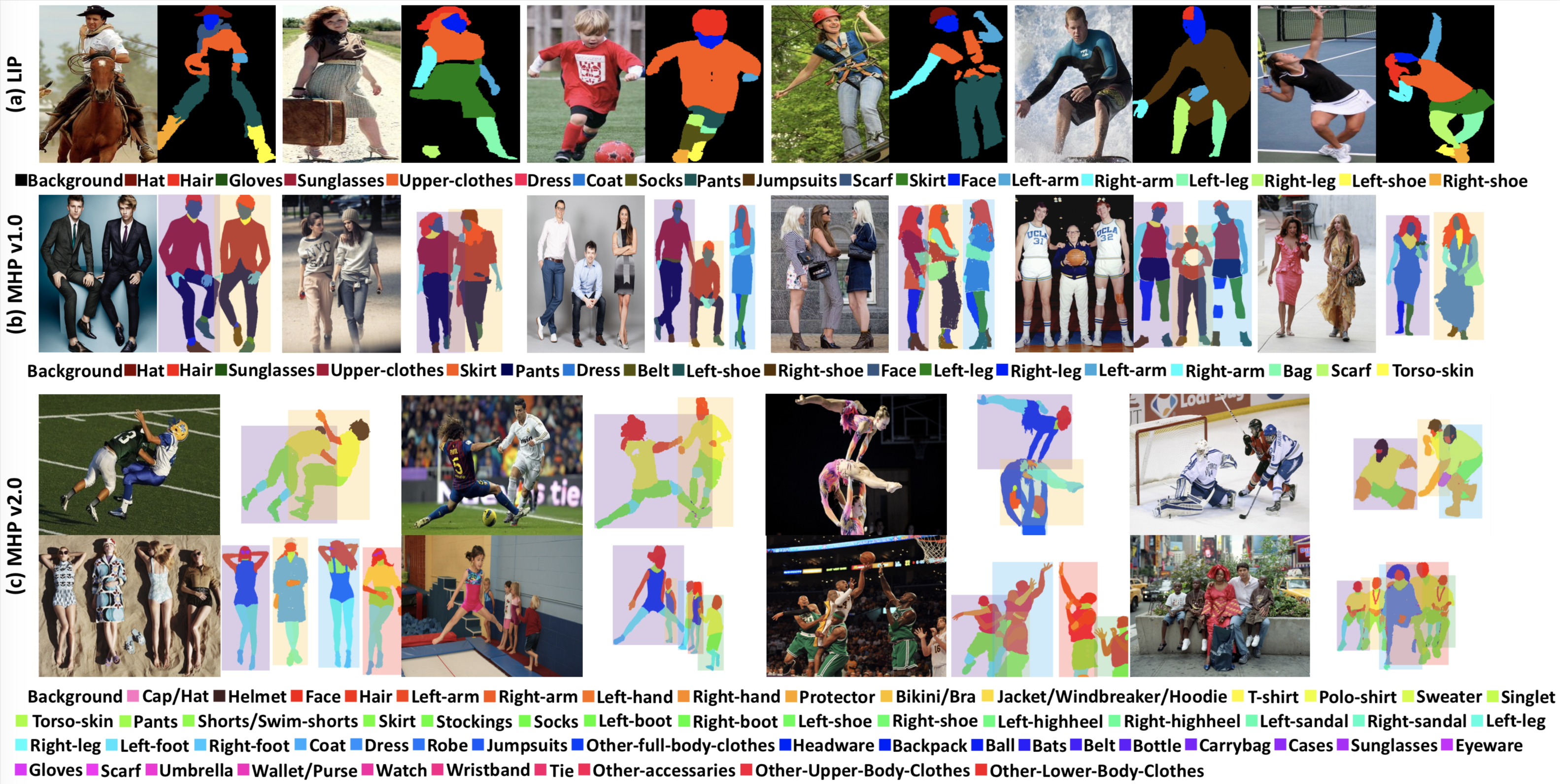

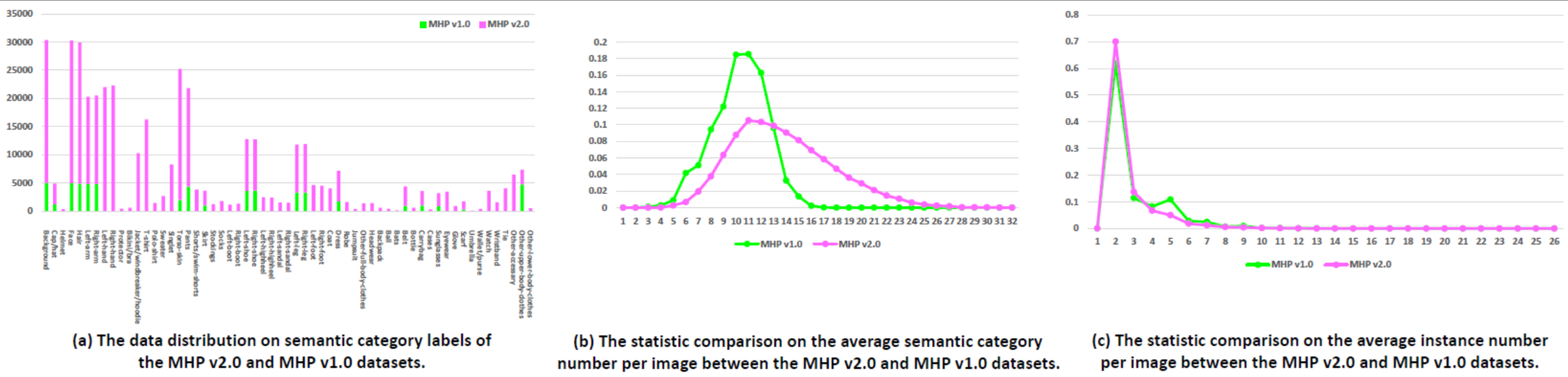

สถิติ: ชุดข้อมูล MHP v1.0 ประกอบด้วยรูปภาพ 4,980 ภาพ โดยแต่ละภาพมีบุคคลอย่างน้อยสองคน (โดยเฉลี่ยคือ 3 คน) เราสุ่มเลือกรูปภาพ 980 รูปพร้อมคำอธิบายประกอบที่เกี่ยวข้องเป็นชุดทดสอบ ส่วนที่เหลือเป็นชุดฝึกอบรม 3,000 ภาพ และชุดตรวจสอบความถูกต้อง 1,000 ภาพ ในแต่ละกรณี จะมีการกำหนดหมวดหมู่ความหมาย 18 หมวดหมู่และใส่คำอธิบายประกอบ ยกเว้นหมวดหมู่ "พื้นหลัง" เช่น "หมวก" "ผม" "แว่นกันแดด" "เสื้อผ้าส่วนบน" "กระโปรง" "กางเกง" "ชุดเดรส" " เข็มขัด”, “รองเท้าซ้าย”, “รองเท้าขวา”, “ใบหน้า”, “ขาซ้าย”, “ขาขวา”, “แขนซ้าย”, “แขนขวา”, “กระเป๋า”, “ผ้าพันคอ” และ “หนังลำตัว” แต่ละอินสแตนซ์มีชุดคำอธิบายประกอบที่สมบูรณ์เมื่อใดก็ตามที่หมวดหมู่ที่เกี่ยวข้องปรากฏในรูปภาพปัจจุบัน

ข่าววีแชท

ดาวน์โหลด: ชุดข้อมูล MHP v1.0 มีให้ที่ google drive และ baidu drive (รหัสผ่าน: cmtp)

โปรดดูเอกสาร MHP v1.0 ของเรา (ส่งไปยัง IJCV) สำหรับรายละเอียดเพิ่มเติม

สถิติ: ชุดข้อมูล MHP v2.0 ประกอบด้วยรูปภาพ 25,403 ภาพ โดยแต่ละภาพมีบุคคลอย่างน้อยสองคน (โดยเฉลี่ยคือ 3 คน) เราสุ่มเลือกรูปภาพ 5,000 ภาพพร้อมคำอธิบายประกอบที่เกี่ยวข้องเป็นชุดทดสอบ ส่วนที่เหลือเป็นชุดฝึกอบรม 15,403 ภาพ และชุดตรวจสอบความถูกต้อง 5,000 ภาพ ในแต่ละกรณี จะมีการกำหนดหมวดหมู่ความหมาย 58 หมวดหมู่และใส่คำอธิบายประกอบ ยกเว้นหมวดหมู่ "พื้นหลัง" เช่น "หมวก/หมวก" "หมวกกันน็อค" "ใบหน้า" "ผม" "แขนซ้าย" "แขนขวา" "มือซ้าย", "มือขวา", "อุปกรณ์ป้องกัน", "บิกินี่/บรา", "แจ็กเก็ต/เสื้อกันลม/เสื้อมีฮู้ด", "เสื้อยืด", "เสื้อโปโล", "สเวตเตอร์", "เสื้อกล้าม", "ผิวหนังลำตัว", "กางเกง", "กางเกงขาสั้น/กางเกงว่ายน้ำ", "กระโปรง", "ถุงน่อง", "ถุงเท้า", "รองเท้าบู๊ตซ้าย", "รองเท้าบู๊ตขวา", "รองเท้าซ้าย" , "รองเท้าขวา", "รองเท้าส้นสูงซ้าย", "รองเท้าส้นสูงขวา", "รองเท้าซ้าย", "รองเท้าขวา", "ขาซ้าย", "ขาขวา", "เท้าซ้าย", "เท้าขวา", "เสื้อคลุม", "ชุดเดรส", "เสื้อคลุม", "ชุดจั๊มสูท", "เสื้อผ้าเต็มตัวอื่นๆ", "หมวก", "กระเป๋าเป้สะพายหลัง", "ลูกบอล", "ค้างคาว", "เข็มขัด", "ขวด", "กระเป๋าถือ", "เคส", "แว่นกันแดด", "แว่นตา", "ถุงมือ", "ผ้าพันคอ", "ร่ม", "กระเป๋าสตางค์/กระเป๋าเงิน", “นาฬิกา” “สายรัดข้อมือ” “เน็คไท” “เครื่องประดับอื่นๆ” “เสื้อผ้าท่อนบนอื่นๆ” และ “เสื้อผ้าท่อนล่างอื่นๆ” แต่ละอินสแตนซ์มีชุดคำอธิบายประกอบที่สมบูรณ์เมื่อใดก็ตามที่หมวดหมู่ที่เกี่ยวข้องปรากฏในรูปภาพปัจจุบัน ยิ่งไปกว่านั้น มนุษย์ 2 มิติโพสท่าโดยมีจุดสำคัญหนาแน่น 16 จุด ("ไหล่ขวา", "ข้อศอกขวา", "ข้อมือขวา", "ไหล่ซ้าย", "ข้อศอกซ้าย", "ข้อมือซ้าย", "ขวา- สะโพก", "เข่าขวา", "ข้อเท้าขวา", "สะโพกซ้าย", "เข่าซ้าย", "ข้อเท้าซ้าย", "หัว", "คอ", "กระดูกสันหลัง" และ "กระดูกเชิงกราน" แต่ละจุดสำคัญจะมีธงระบุว่ามองเห็นได้ 0/ปิดบัง 1/อยู่นอกภาพ-2 หรือไม่ และยังมีกล่องขอบเขตส่วนหัวและอินสแตนซ์เพื่ออำนวยความสะดวกในการวิจัยการประมาณค่าแบบหลายท่าของมนุษย์

ดาวน์โหลด: ชุดข้อมูล MHP v2.0 มีให้ที่ google drive และ baidu drive (รหัสผ่าน: uxrb)

โปรดดูรายละเอียดเพิ่มเติมในเอกสาร MHP v2.0 (ACM MM'18 Best Student Paper)

การแยกวิเคราะห์แบบหลายบุคคล: เราใช้ตัวชี้วัดที่ยึดมนุษย์เป็นศูนย์กลางสองตัวสำหรับการประเมินการแยกวิเคราะห์แบบหลายมนุษย์ ซึ่งเริ่มแรกจะรายงานโดยเอกสาร MHP v1.0 ของเรา ตัวชี้วัดสองตัวคือความแม่นยำเฉลี่ยตามชิ้นส่วน (AP p ) (%) และเปอร์เซ็นต์ของชิ้นส่วนความหมายที่แยกวิเคราะห์อย่างถูกต้อง (PCP) (%) สำหรับโค้ดการประเมินผล โปรดดูที่โฟลเดอร์ "การประเมินผล" ใต้พื้นที่เก็บข้อมูล "Multi-Human-Parsing_MHP" ของเรา

การประมาณท่าทางแบบหลายมนุษย์: ตาม MPII เราใช้การวัดการประเมิน mAP (%)

เราได้จัดการประชุมเชิงปฏิบัติการ CVPR 2018 เรื่องความเข้าใจด้วยการมองเห็นของมนุษย์ในฉากฝูงชน (VUHCS 2018) เวิร์คช็อปนี้ได้รับความร่วมมือจาก NUS, CMU และ SYSU จาก VUHCS 2017 เราได้เสริมความแข็งแกร่งให้กับเวิร์กชอปนี้ด้วยการเพิ่ม 5 แทร็กการแข่งขัน: การแยกวิเคราะห์มนุษย์แบบคนเดียว การแยกวิเคราะห์มนุษย์แบบหลายคน การประมาณท่าทางแบบคนเดียว การประมาณท่าทางแบบหลายมนุษย์ และแบบละเอียด การแยกวิเคราะห์มนุษย์หลายคนแบบละเอียด

การส่งผลการแข่งขันและลีดเดอร์บอร์ด

ข่าววีแชท

โปรดปรึกษาและพิจารณาอ้างอิงเอกสารต่อไปนี้:

@article{zhao2018understanding,

title={Understanding Humans in Crowded Scenes: Deep Nested Adversarial Learning and A New Benchmark for Multi-Human Parsing},

author={Zhao, Jian and Li, Jianshu and Cheng, Yu and Zhou, Li and Sim, Terence and Yan, Shuicheng and Feng, Jiashi},

journal={arXiv preprint arXiv:1804.03287},

year={2018}

}

@article{li2017towards,

title={Multi-Human Parsing in the Wild},

author={Li, Jianshu and Zhao, Jian and Wei, Yunchao and Lang, Congyan and Li, Yidong and Sim, Terence and Yan, Shuicheng and Feng, Jiashi},

journal={arXiv preprint arXiv:1705.07206},

year={2017}

}