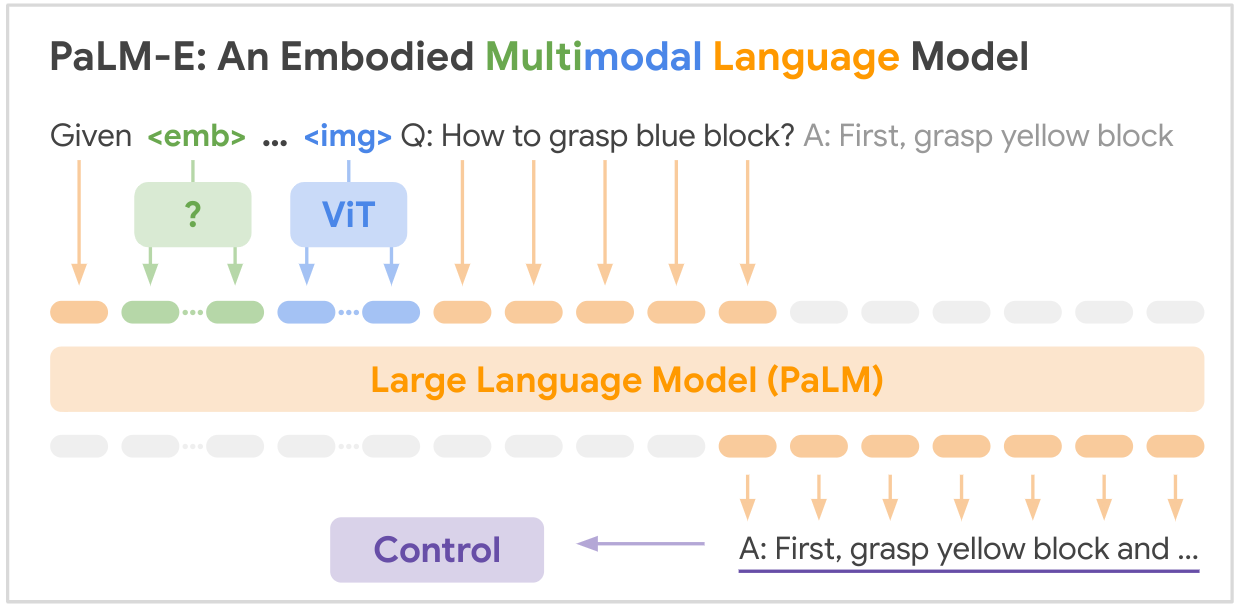

นี่คือการใช้งานแบบโอเพ่นซอร์สของโมเดลพื้นฐานหลายรูปแบบ SOTA "PALM-E: โมเดลภาษาหลายภาษาที่เป็นตัวเป็นตน" จาก Google PALM-E เป็นแบบจำลองหลายรูปแบบที่รวบรวมขนาดใหญ่เพียงตัวเดียว ซึ่งสามารถจัดการกับงานการให้เหตุผลแบบรวมศูนย์ได้หลากหลาย จาก รูปแบบการสังเกตที่หลากหลาย ในหลายรูปลักษณ์ และอื่นๆ แสดงให้เห็นการถ่ายทอดเชิงบวก: โมเดลได้รับประโยชน์จากการฝึกอบรมร่วมกันที่หลากหลายทั่วทั้งโดเมนภาษา การมองเห็น และภาษาภาพในระดับอินเทอร์เน็ต

ลิงก์กระดาษ: PaLM-E: โมเดลภาษาต่อเนื่องหลายรูปแบบที่เป็นตัวเป็นตน

pip install palme import torch

from palme . model import PalmE

#usage

img = torch . randn ( 1 , 3 , 256 , 256 )

caption = torch . randint ( 0 , 20000 , ( 1 , 1024 ))

model = PalmE ()

output = model ( img , caption )

print ( output . shape ) # (1, 1024, 20000)

นี่คือตารางสรุปของชุดข้อมูลหลักที่กล่าวถึงในรายงาน:

| ชุดข้อมูล | งาน | ขนาด | ลิงค์ |

|---|---|---|---|

| แทมป์ | การวางแผนการจัดการด้วยหุ่นยนต์ VQA | 96,000 ฉาก | ชุดข้อมูลที่กำหนดเอง |

| ตารางภาษา | การวางแผนการจัดการหุ่นยนต์ | ชุดข้อมูลที่กำหนดเอง | ลิงค์ |

| การจัดการมือถือ | การวางแผนการนำทางและการจัดการด้วยหุ่นยนต์ VQA | ลำดับที่ 2912 | อิงตามชุดข้อมูล SayCan |

| เว็บLI | การดึงข้อความรูปภาพ | คู่คำบรรยายภาพ 66M | ลิงค์ |

| VQAv2 | การตอบคำถามด้วยภาพ | คำถาม 1.1 ล้านข้อเกี่ยวกับรูปภาพ COCO | ลิงค์ |

| ตกลง-VQA | การตอบคำถามด้วยภาพซึ่งต้องใช้ความรู้จากภายนอก | 14,031 คำถามเกี่ยวกับภาพ COCO | ลิงค์ |

| โคโค่ | คำบรรยายภาพ | รูปภาพ 330,000 ภาพพร้อมคำบรรยาย | ลิงค์ |

| วิกิพีเดีย | คลังข้อความ | ไม่มี | ลิงค์ |

ชุดข้อมูลวิทยาการหุ่นยนต์ที่สำคัญได้รับการรวบรวมสำหรับงานนี้โดยเฉพาะ ในขณะที่ชุดข้อมูลภาษาการมองเห็นที่ใหญ่กว่า (WebLI, VQAv2, OK-VQA, COCO) เป็นเกณฑ์มาตรฐานในสาขานั้น ชุดข้อมูลมีตั้งแต่ตัวอย่างนับหมื่นตัวอย่างสำหรับโดเมนหุ่นยนต์ไปจนถึงหลายสิบล้านตัวอย่างสำหรับข้อมูลภาษาวิสัยทัศน์ระดับอินเทอร์เน็ต

ต้องการความฉลาดของคุณ! เข้าร่วมกับเราและร่วมกันทำให้ PALM-E สร้างแรงบันดาลใจมากยิ่งขึ้น:

- แก้ไข, ? การปรับปรุง เอกสาร หรือแนวคิด ยินดีต้อนรับทุกท่าน! มากำหนดอนาคตของ AI จับมือกัน

@article{driess2023palme,

title={PALM-E: An Embodied Multimodal Language Model},

author={Driess, Danny and Xia, Fei and Sajjadi, Mehdi S. M. and Lynch, Corey and Chowdhery, Aakanksha and Ichter, Brian and Wahid, Ayzaan and Tompson, Jonathan and Vuong, Quan and Yu, Tianhe and Huang, Wenlong and Chebotar, Yevgen and Sermanet, Pierre and Duckworth, Daniel and Levine, Sergey and Vanhoucke, Vincent and Hausman, Karol and Toussaint, Marc and Greff, Klaus and Zeng, Andy and Mordatch, Igor and Florence, Pete},

journal={arXiv preprint arXiv:2303.03378},

year={2023},

url={https://doi.org/10.48550/arXiv.2303.03378}

}