เอกสาร การติดตั้ง ? Model Zoo | อัปเดตข่าว | โครงการต่อเนื่อง ปัญหาการรายงาน

การแนะนำ

MMDetection เป็นกล่องเครื่องมือตรวจจับวัตถุโอเพ่นซอร์สตาม pytorch มันเป็นส่วนหนึ่งของโครงการ OpenMMLAB

สาขาหลักทำงานร่วมกับ Pytorch 1.8+

คุณสมบัติที่สำคัญ

การออกแบบแบบแยกส่วน

เราย่อยสลายกรอบการตรวจจับเป็นส่วนประกอบที่แตกต่างกันและหนึ่งสามารถสร้างกรอบการตรวจจับวัตถุที่กำหนดเองได้อย่างง่ายดายโดยการรวมโมดูลที่แตกต่างกัน

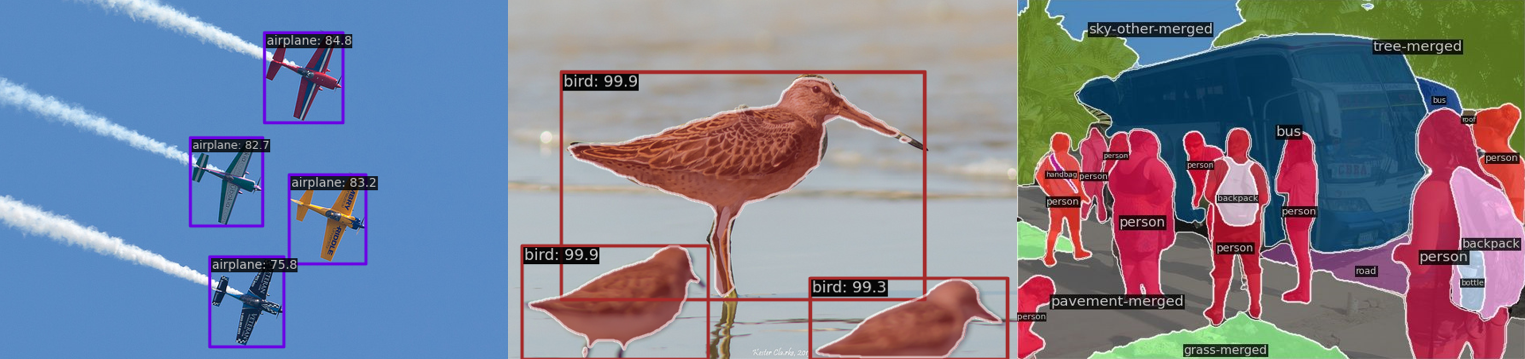

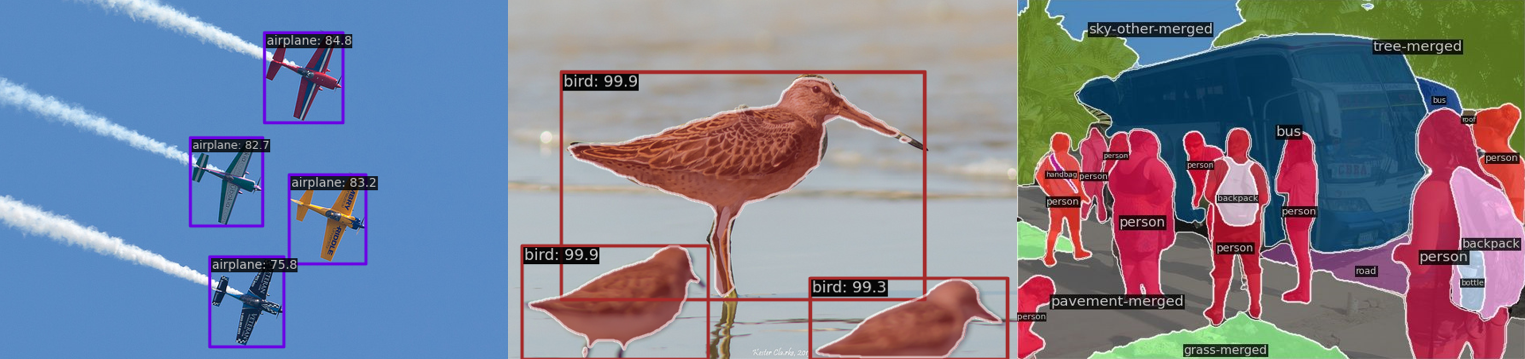

สนับสนุนงานหลายงานนอกกล่อง

กล่องเครื่องมือรองรับงานตรวจจับหลายงานโดยตรงเช่น การตรวจจับวัตถุ การแบ่งส่วนอินสแตนซ์ การแบ่งส่วน panoptic และ การตรวจจับวัตถุกึ่งผู้ดูแล

ประสิทธิภาพสูง

การดำเนินการ BBOX และ MASK พื้นฐานทั้งหมดทำงานบน GPU ความเร็วในการฝึกอบรมนั้นเร็วกว่าหรือเทียบเคียงได้กับรหัสฐานอื่น ๆ รวมถึง Detectron2, Maskrcnn-benchmark และ Simpledet

ล้ำสมัย

กล่องเครื่องมือเกิดจาก Codebase ที่พัฒนาโดยทีม MMDET ซึ่งได้รับรางวัล Coco Detection Challenge ในปี 2561 และเราผลักดันมันไปข้างหน้า RTMDET ที่เพิ่งเปิดตัวใหม่ยังได้รับผลลัพธ์ที่ทันสมัยใหม่ในการแบ่งส่วนอินสแตนซ์แบบเรียลไทม์และงานตรวจจับวัตถุที่หมุนได้และการแลกเปลี่ยนพารามิเตอร์ที่ดีที่สุดในการตรวจจับวัตถุ

นอกเหนือจาก MMDetection แล้วเรายังเปิดตัว MMENGINE สำหรับการฝึกอบรมแบบจำลองและ MMCV สำหรับการวิจัยการมองเห็นคอมพิวเตอร์ซึ่งขึ้นอยู่กับกล่องเครื่องมือนี้อย่างมาก

มีอะไรใหม่

- เราได้เปิดตัวน้ำหนักที่ได้รับการฝึกอบรมล่วงหน้าสำหรับ MM-Grounding-Dino Swin-B และ Swin-L ยินดีต้อนรับเพื่อลองและให้ข้อเสนอแนะ

เน้น

v3.3.0 ได้รับการปล่อยตัวใน 5/1/2024:

MM-Grounding-Dino: ไปป์ไลน์แบบเปิดและครอบคลุมสำหรับการต่อสายดินและตรวจจับ

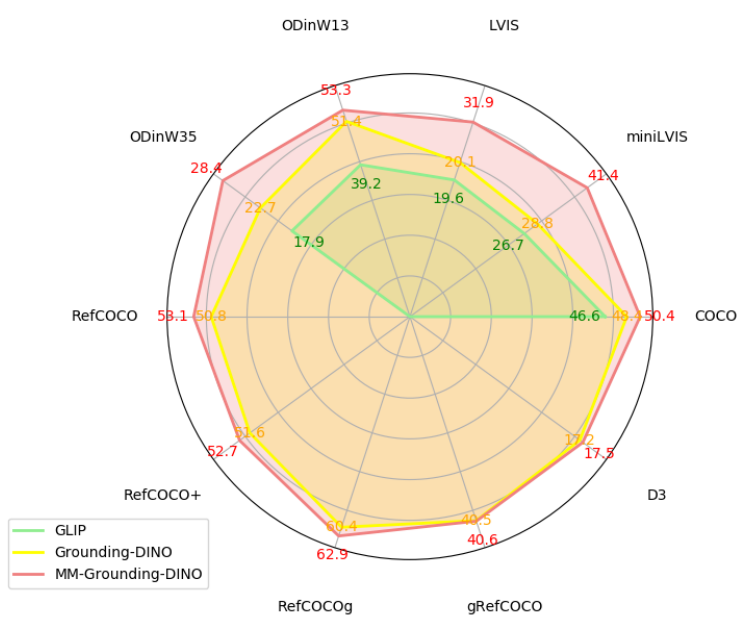

Grounding Dino เป็นรูปแบบการฝึกอบรมก่อนการต่อสายดินที่รวมการตรวจจับวัตถุคำศัพท์แบบเปิด 2D และการลงดินวลีด้วยแอปพลิเคชันที่กว้าง อย่างไรก็ตามส่วนการฝึกอบรมของมันยังไม่ได้รับการเปิด ดังนั้นเราจึงเสนอ MM-Grounding-Dino ซึ่งไม่เพียง แต่ทำหน้าที่เป็นเวอร์ชันการจำลองแบบโอเพนซอร์สของ Dino แต่ยังได้รับการปรับปรุงประสิทธิภาพที่สำคัญตามประเภทข้อมูลที่สร้างขึ้นใหม่สำรวจชุดข้อมูลที่แตกต่างกันและกลยุทธ์การเริ่มต้น ยิ่งไปกว่านั้นเราทำการประเมินผลจากหลายมิติรวมถึง OOD, REC, สายดินวลี, OVD และการปรับแต่งเพื่อขุดข้อดีและข้อเสียของการฝึกอบรมก่อนการฝึก

รหัส: mm_grounding_dino/readme.md

เรารู้สึกตื่นเต้นที่จะประกาศผลงานล่าสุดของเราเกี่ยวกับงานการจดจำวัตถุแบบเรียลไทม์ RTMDET ซึ่งเป็นครอบครัวของเครื่องตรวจจับขั้นตอนเดียวอย่างสมบูรณ์ RTMDET ไม่เพียง แต่จะได้รับการแลกเปลี่ยนพารามิเตอร์-ความแม่นยำที่ดีที่สุดในการตรวจจับวัตถุจากขนาดขนาดเล็กถึงขนาดใหญ่พิเศษ แต่ยังได้รับประสิทธิภาพที่ทันสมัยใหม่ในการแบ่งส่วนอินสแตนซ์และงานตรวจจับวัตถุที่หมุนได้ รายละเอียดสามารถพบได้ในรายงานทางเทคนิค โมเดลที่ผ่านการฝึกอบรมมาก่อนอยู่ที่นี่

| งาน | ชุดข้อมูล | ap | FPS (TRT FP16 BS1 3090) |

|---|

| การตรวจจับวัตถุ | โกโก้ | 52.8 | 322 |

| การแบ่งส่วนอินสแตนซ์ | โกโก้ | 44.6 | 188 |

| การตรวจจับวัตถุที่หมุน | dota | 78.9 (ระดับเดียว) /81.3 (หลายระดับ) | 121 |

การติดตั้ง

โปรดดูการติดตั้งสำหรับคำแนะนำในการติดตั้ง

เริ่มต้น

โปรดดูภาพรวมสำหรับการแนะนำทั่วไปของ mmdetection

สำหรับคู่มือผู้ใช้โดยละเอียดและคู่มือขั้นสูงโปรดดูเอกสารของเรา:

คู่มือผู้ใช้

- รถไฟและทดสอบ

- เรียนรู้เกี่ยวกับการกำหนดค่า

- การอนุมานกับโมเดลที่มีอยู่

- ชุดข้อมูลเตรียม

- ทดสอบโมเดลที่มีอยู่ในชุดข้อมูลมาตรฐาน

- ฝึกอบรมโมเดลที่กำหนดไว้ล่วงหน้าในชุดข้อมูลมาตรฐาน

- ฝึกอบรมด้วยชุดข้อมูลที่กำหนดเอง

- ฝึกอบรมด้วยโมเดลที่กำหนดเองและชุดข้อมูลมาตรฐาน

- รุ่น Finetuning

- การส่งผลการทดสอบ

- การเริ่มต้นน้ำหนัก

- ใช้เครื่องตรวจจับขั้นตอนเดียวเป็น RPN

- การตรวจจับวัตถุกึ่งหัวเมือง

- เครื่องมือที่มีประโยชน์

คู่มือขั้นสูง

- แนวคิดพื้นฐาน

- การปรับแต่งส่วนประกอบ

- วิธี

นอกจากนี้เรายังให้การสอนการตรวจจับการตรวจจับวัตถุและการแบ่งส่วนการแบ่งกลุ่ม

หากต้องการโยกย้ายจาก MMDetection 2.x โปรดดูการย้ายถิ่น

ภาพรวมของมาตรฐานและสวนสัตว์รุ่น

ผลลัพธ์และรุ่นมีอยู่ในสวนสัตว์รุ่น

สถาปัตยกรรม

| การตรวจจับวัตถุ | การแบ่งส่วนอินสแตนซ์ | การแบ่งส่วน panoptic | อื่น |

- Fast R-CNN (ICCV'2015)

- R-CNN เร็วขึ้น (Neurips'2015)

- RPN (Neurips'2015)

- SSD (ECCV'2016)

- Retinanet (ICCV'2017)

- Cascade R-CNN (cvpr'2018)

- YOLOV3 (Arxiv'2018)

- Cornernet (ECCV'2018)

- Grid R-CNN (CVPR'2019)

- ไกด์นำทาง (cvpr'2019)

- FSAF (cvpr'2019)

- Centernet (cvpr'2019)

- Libra R-CNN (cvpr'2019)

- TridentNet (ICCV'2019)

- FCOS (ICCV'2019)

- reppoints (ICCV'2019)

- Freeanchor (Neurips'2019)

- Cascaderpn (Neurips'2019)

- foveabox (Tip'2020)

- R-CNN แบบสองหัว (cvpr'2020)

- ATSS (CVPR'2020)

- NAS-FCOS (CVPR'2020)

- centripetalnet (cvpr'2020)

- Autoassign (Arxiv'2020)

- การแปลขอบเขตที่รับรู้ด้านข้าง (ECCV'2020)

- Dynamic R-CNN (ECCV'2020)

- DETR (ECCV'2020)

- PAA (ECCV'2020)

- Varifocalnet (cvpr'2021)

- Sparse R-CNN (cvpr'2021)

- โยลอฟ (cvpr'2021)

- YOLOX (CVPR'2021)

- DETR (ICLR'2021)

- TOOD (ICCV'2021)

- DDOD (ACM MM'2021)

- rtmdet (arxiv'2022)

- DETR แบบมีเงื่อนไข (ICCV'2021)

- DAB-DETR (ICLR'2022)

- Dino (ICLR'2023)

- Glip (cvpr'2022)

- DDQ (cvpr'2023)

- diffusionDet (arxiv'2023)

- EfficientDet (cvpr'2020)

- VitDet (ECCV'2022)

- DETIC (ECCV'2022)

- Co-Detr (ICCV'2023)

| - หน้ากาก R-CNN (ICCV'2017)

- Cascade Mask R-CNN (cvpr'2018)

- MASK การให้คะแนน R-CNN (CVPR'2019)

- Hybrid Task Cascade (CVPR'2019)

- Yolact (ICCV'2019)

- Instaboost (ICCV'2019)

- SOLO (ECCV'2020)

- POINTREND (CVPR'2020)

- เครื่องตรวจจับ (Arxiv'2020)

- SOLOV2 (Neurips'2020)

- Scnet (Aaai'2021)

- QueryInst (ICCV'2021)

- mask2former (arxiv'2021)

- Condinst (ECCV'2020)

- กระจัดกระจาย (cvpr'2022)

- rtmdet (arxiv'2022)

- Boxinst (cvpr'2021)

- Convnext-V2 (Arxiv'2023)

| - Panoptic FPN (cvpr'2019)

- Maskformer (Neurips'2021)

- mask2former (arxiv'2021)

- Xdecoder (cvpr'2023)

| การเรียนรู้แบบตัดกัน- Swav (Neurips'2020)

- moco (cvpr'2020)

- mocov2 (arxiv'2020)

การกลั่น- การกลั่นการแปล (cvpr'2022)

- การกลั่นการกำหนดฉลาก (WACV'2022)

การตรวจจับวัตถุกึ่งหัวเมือง- ครูที่อ่อนนุ่ม (ICCV'2021)

|

ส่วนประกอบ

| กระดูกสันหลัง | คอ | การสูญเสีย | ทั่วไป |

- VGG (ICLR'2015)

- resnet (cvpr'2016)

- resnext (cvpr'2017)

- mobilenetv2 (cvpr'2018)

- hrnet (cvpr'2019)

- ความสนใจทั่วไป (ICCV'2019)

- gcnet (iccvw'2019)

- res2net (tpami'2020)

- regnet (cvpr'2020)

- resnest (arxiv'2020)

- Pvt (ICCV'2021)

- swin (cvpr'2021)

- Pvtv2 (Arxiv'2021)

- Resnet Strikes Back (Arxiv'2021)

- EfficientNet (Arxiv'2021)

- Convnext (cvpr'2022)

- Convnextv2 (Arxiv'2023)

| - PAFPN (cvpr'2018)

- NAS-FPN (CVPR'2019)

- Carafe (ICCV'2019)

- FPG (Arxiv'2020)

- Groie (ICPR'2020)

- dyhead (cvpr'2021)

| - GHM (Aaai'2019)

- การสูญเสียโฟกัสทั่วไป (Neurips'2020)

- การสูญเสียของทะเล (cvpr'2021)

| - OHEM (CVPR'2016)

- การทำให้เป็นมาตรฐานของกลุ่ม (ECCV'2018)

- DCN (ICCV'2017)

- DCNV2 (cvpr'2019)

- มาตรฐานน้ำหนัก (Arxiv'2019)

- ความสนใจตัวอย่างสำคัญ (cvpr'2020)

- STRONG BASELINES (CVPR'2021)

- Resnet Strikes Back (Arxiv'2021)

|

วิธีการอื่น ๆ ได้รับการสนับสนุนในโครงการโดยใช้ MMDetection

คำถามที่พบบ่อย

โปรดดูคำถามที่พบบ่อยสำหรับคำถามที่พบบ่อย

การบริจาค

เราขอขอบคุณการมีส่วนร่วมทั้งหมดเพื่อปรับปรุง MMDetection โครงการต่อเนื่องสามารถพบได้ในโครงการ GitHub ยินดีต้อนรับผู้ใช้ชุมชนที่จะเข้าร่วมในโครงการเหล่านี้ โปรดดูที่การสนับสนุน MD สำหรับแนวทางที่มีส่วนร่วม

การรับทราบ

MMDetection เป็นโครงการโอเพ่นซอร์สที่ได้รับการสนับสนุนจากนักวิจัยและวิศวกรจากวิทยาลัยและ บริษัท ต่างๆ เราขอขอบคุณผู้สนับสนุนทุกคนที่ใช้วิธีการของพวกเขาหรือเพิ่มคุณสมบัติใหม่รวมถึงผู้ใช้ที่ให้ข้อเสนอแนะที่มีค่า เราหวังว่ากล่องเครื่องมือและเกณฑ์มาตรฐานสามารถให้บริการชุมชนการวิจัยที่กำลังเติบโตโดยการจัดหาชุดเครื่องมือที่ยืดหยุ่นเพื่อนำวิธีการที่มีอยู่ใหม่มาใช้ใหม่และพัฒนาเครื่องตรวจจับใหม่ของตัวเอง

การอ้างอิง

หากคุณใช้กล่องเครื่องมือหรือเกณฑ์มาตรฐานในการวิจัยของคุณโปรดอ้างอิงโครงการนี้

@article{mmdetection,

title = {{MMDetection}: Open MMLab Detection Toolbox and Benchmark},

author = {Chen, Kai and Wang, Jiaqi and Pang, Jiangmiao and Cao, Yuhang and

Xiong, Yu and Li, Xiaoxiao and Sun, Shuyang and Feng, Wansen and

Liu, Ziwei and Xu, Jiarui and Zhang, Zheng and Cheng, Dazhi and

Zhu, Chenchen and Cheng, Tianheng and Zhao, Qijie and Li, Buyu and

Lu, Xin and Zhu, Rui and Wu, Yue and Dai, Jifeng and Wang, Jingdong

and Shi, Jianping and Ouyang, Wanli and Loy, Chen Change and Lin, Dahua},

journal= {arXiv preprint arXiv:1906.07155},

year={2019}

}

ใบอนุญาต

โครงการนี้เปิดตัวภายใต้ใบอนุญาต Apache 2.0

โครงการใน openmmlab

- MMENGINE: ห้องสมุดพื้นฐาน OpenMMLAB สำหรับการฝึกอบรมแบบจำลองการเรียนรู้อย่างลึกซึ้ง

- MMCV: ห้องสมุดพื้นฐาน OpenMMLAB สำหรับการมองเห็นคอมพิวเตอร์

- MMPRETRAIN: OpenMMLAB Pre-Training Toolbox และ Benchmark

- mmagic: เปิด mm lab a dvanced, g enerative และ i ntelligent c เครื่องมือ reation

- MMDETECTION: กล่องเครื่องมือตรวจจับ OpenMMLAB และเกณฑ์มาตรฐาน

- MMDETECTION3D: แพลตฟอร์มรุ่นต่อไปของ OpenMMLAB สำหรับการตรวจจับวัตถุ 3D ทั่วไป

- MMrotate: กล่องเครื่องมือตรวจจับวัตถุที่หมุนของ OpenMMLAB และเบนช์มาร์ก

- MMYOLO: กล่องเครื่องมือและเบนช์ของ OpenMMLAB YOLO SERIES

- MMSegentation: OpenMMLAB Semantic Sementation Toolbox และ Benchmark

- MMOCH: การตรวจจับข้อความ OpenMMLAB การรับรู้และการทำความเข้าใจกล่องเครื่องมือ

- MMPOSE: OpenMMLAB POSE POSE TOOLBOX และ BENGAGM

- MMHUMAN3D: OpenMMLAB 3D Human Parametric Model Toolbox และ Benchmark

- MMSelfSup: OpenMMLAB กล่องเครื่องมือการเรียนรู้ที่ดูแลตนเองและเกณฑ์มาตรฐาน

- MMRAZOR: กล่องเครื่องมือการบีบอัดแบบจำลอง OpenMMLAB และเกณฑ์มาตรฐาน

- MMFEWSHOT: OpenMMLAB ไม่กี่กล่องเครื่องมือการเรียนรู้และเกณฑ์มาตรฐาน

- MMACTION2: กล่องเครื่องมือและเกณฑ์มาตรฐานของ OpenMMLAB

- MMTRACKING: กล่องเครื่องมือการรับรู้วิดีโอ OpenMMLAB และเกณฑ์มาตรฐาน

- MMFLOW: OpenMMLAB OPTICAL FLOW TOOLBOX และ BENGAGM

- MMediting: OpenMMLAB Image และ Video Editing Toolbox

- MMGeneration: OpenMMLAB IMAGE และ VIDEA Generative Models กล่องเครื่องมือ

- MMDeploy: OpenMMLAB MODEL FRAMEWORK FRAMEWORK

- MIM: MIM ติดตั้งแพ็คเกจ OpenMMLAB

- MMEVAL: ห้องสมุดการประเมินแบบครบวงจรสำหรับไลบรารีการเรียนรู้ของเครื่องหลายเครื่อง

- สนามเด็กเล่น: ศูนย์กลางกลางสำหรับการรวบรวมและจัดแสดงโครงการที่น่าตื่นตาตื่นใจที่สร้างขึ้นบน OpenMMLAB