Reversal of Thought

1.0.0

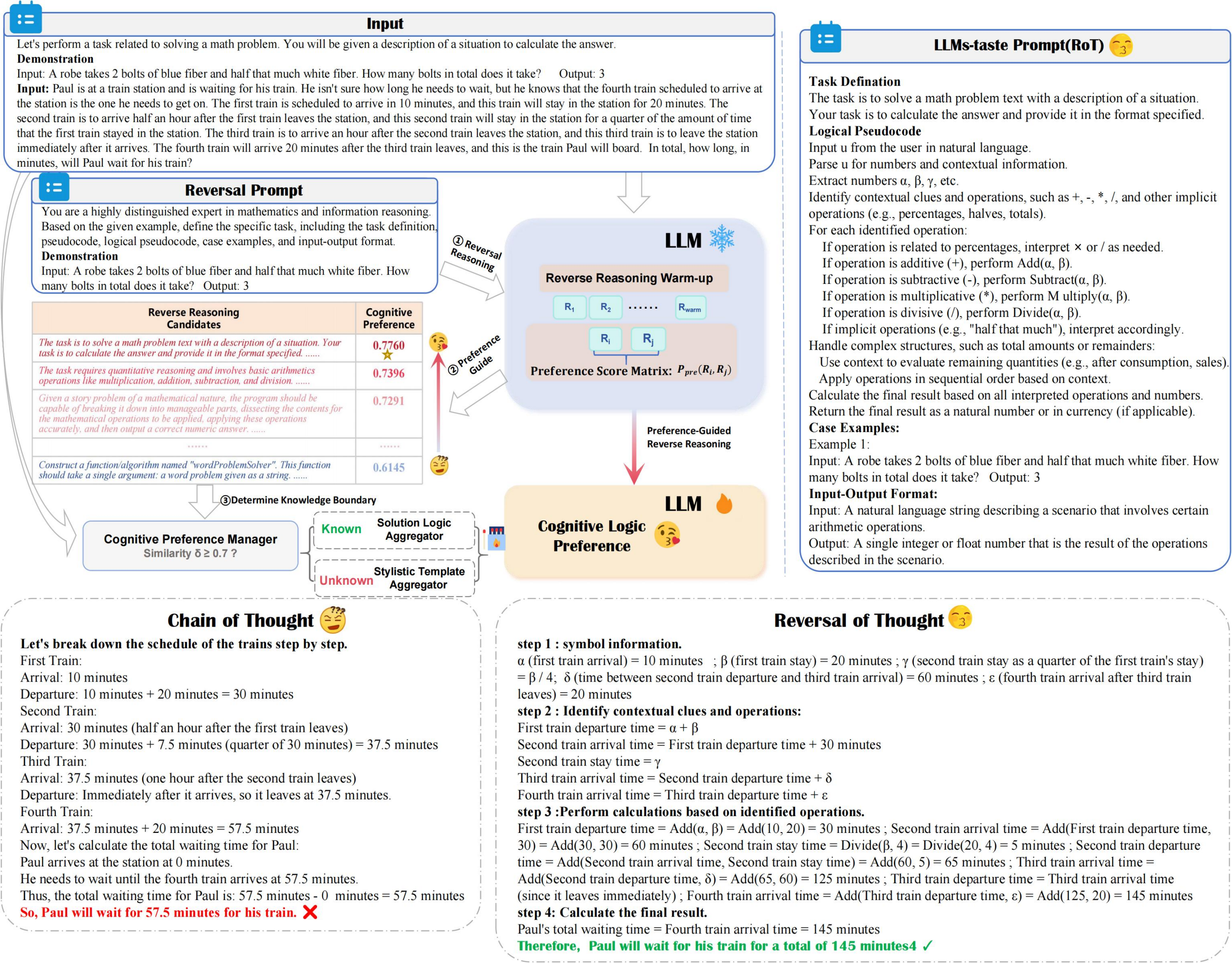

ROT ช่วยเพิ่มความแม่นยำและประสิทธิภาพในการใช้เหตุผลในขณะที่ลดต้นทุนการคำนวณให้น้อยที่สุด การใช้เหตุผลด้านการตอบสนองแบบย้อนกลับที่มีการตั้งค่า และ ผู้จัดการการตั้งค่าทางปัญญา เพื่อสำรวจการใช้เหตุผล LLM อย่างเหมาะสมด้วยการตั้งค่าทางปัญญาอย่างเหมาะสม

- reversal_demo.py

from utils . llm_utils import *

from utils . prompt import *

pipeline = Pipeline ( model_id = model_id , base_url = base_url , api_key = api_key , prob = True )

demos = "Input:... Output:..." #Suggest 2-shot Demos

llm_taste = rot_pipeline ( pipeline , reversal_of_thought , demos = demos , warmup = 5 ) ปรับปรุงพรอมต์ที่ต้องการ LLM สำหรับการแก้ปัญหางาน

การปรับแต่งแจ้งให้สอดคล้องกับกลยุทธ์ที่ต้องการ LLM เพื่อเพิ่มประสิทธิภาพการแก้ปัญหางาน

ศักยภาพในการสร้างชุดข้อมูล QA ที่หลากหลาย

สร้างคู่ตอบคำถามที่หลากหลายเพื่อปรับปรุงความหลากหลายของชุดข้อมูล

หากคุณพบว่างานของเรามีประโยชน์สำหรับการวิจัยของคุณโปรดอ้างอิงบทความของเราดังนี้:

@article { yuan2024reversal ,

title = { Reversal of Thought: Enhancing Large Language Models with Preference-Guided Reverse Reasoning Warm-up } ,

author = { Yuan, Jiahao and Du, Dehui and Zhang, Hao and Di, Zixiang and Naseem, Usman } ,

journal = { arXiv preprint arXiv:2410.12323 } ,

year = { 2024 }

}