Awesome-llms-datasets

- สรุปชุดข้อมูลที่เป็นตัวแทน LLMS ที่มีอยู่ในห้ามิติ: Corpora การฝึกอบรมก่อน, ชุดข้อมูลคำสั่งการปรับแต่ง, ชุดข้อมูลการตั้งค่า, ชุดข้อมูลการประเมินผลและชุดข้อมูล NLP แบบดั้งเดิม (อัปเดตปกติ)

- มีการเพิ่มส่วนชุดข้อมูลใหม่: ชุดข้อมูลภาษาขนาดใหญ่หลายรูปแบบ (MLLMS) ชุดข้อมูลชุดข้อมูล Augmented Generation (RAG) (อัปเดตค่อยๆ)

กระดาษ

กระดาษ "ชุดข้อมูลสำหรับแบบจำลองภาษาขนาดใหญ่: การสำรวจที่ครอบคลุม" ได้รับการปล่อยตัว (2024/2)

เชิงนามธรรม:

บทความนี้เริ่มต้นในการสำรวจในชุดข้อมูลรูปแบบภาษาขนาดใหญ่ (LLM) ซึ่งมีบทบาทสำคัญในความก้าวหน้าที่น่าทึ่งของ LLMS ชุดข้อมูลทำหน้าที่เป็นโครงสร้างพื้นฐานพื้นฐานที่คล้ายคลึงกับระบบรากที่ค้ำจุนและบำรุงรักษาการพัฒนาของ LLM ดังนั้นการตรวจสอบชุดข้อมูลเหล่านี้จึงเป็นหัวข้อสำคัญในการวิจัย เพื่อที่จะจัดการกับการขาดภาพรวมที่ครอบคลุมและการวิเคราะห์อย่างละเอียดของชุดข้อมูล LLM และเพื่อให้ได้ข้อมูลเชิงลึกเกี่ยวกับสถานะปัจจุบันและแนวโน้มในอนาคตการสำรวจนี้รวมและจัดหมวดหมู่พื้นฐานพื้นฐานของชุดข้อมูล LLM จากห้ามุมมอง: (1) ก่อน การฝึกอบรม Corpora; (2) ชุดข้อมูลการปรับแต่งการเรียนการสอน (3) ชุดข้อมูลการตั้งค่า (4) ชุดข้อมูลการประเมินผล (5) ชุดข้อมูลการประมวลผลภาษาธรรมชาติแบบดั้งเดิม (NLP) การสำรวจแสดงให้เห็นถึงความท้าทายที่เกิดขึ้นและชี้ให้เห็นถึงช่องทางที่เป็นไปได้สำหรับการสอบสวนในอนาคต นอกจากนี้ยังมีการตรวจสอบที่ครอบคลุมเกี่ยวกับทรัพยากรชุดข้อมูลที่มีอยู่รวมถึงสถิติจากชุดข้อมูล 444 ชุดครอบคลุม 8 หมวดหมู่ภาษาและครอบคลุม 32 โดเมน ข้อมูลจาก 20 มิติรวมอยู่ในสถิติชุดข้อมูล ขนาดข้อมูลทั้งหมดที่สำรวจเกิน 774.5 TB สำหรับการฝึกอบรมก่อนการฝึกอบรมและอินสแตนซ์ 700m สำหรับชุดข้อมูลอื่น ๆ เรามุ่งมั่นที่จะนำเสนอภูมิทัศน์ทั้งหมดของชุดข้อมูลข้อความ LLM ซึ่งทำหน้าที่เป็นข้อมูลอ้างอิงที่ครอบคลุมสำหรับนักวิจัยในสาขานี้และมีส่วนร่วมในการศึกษาในอนาคต

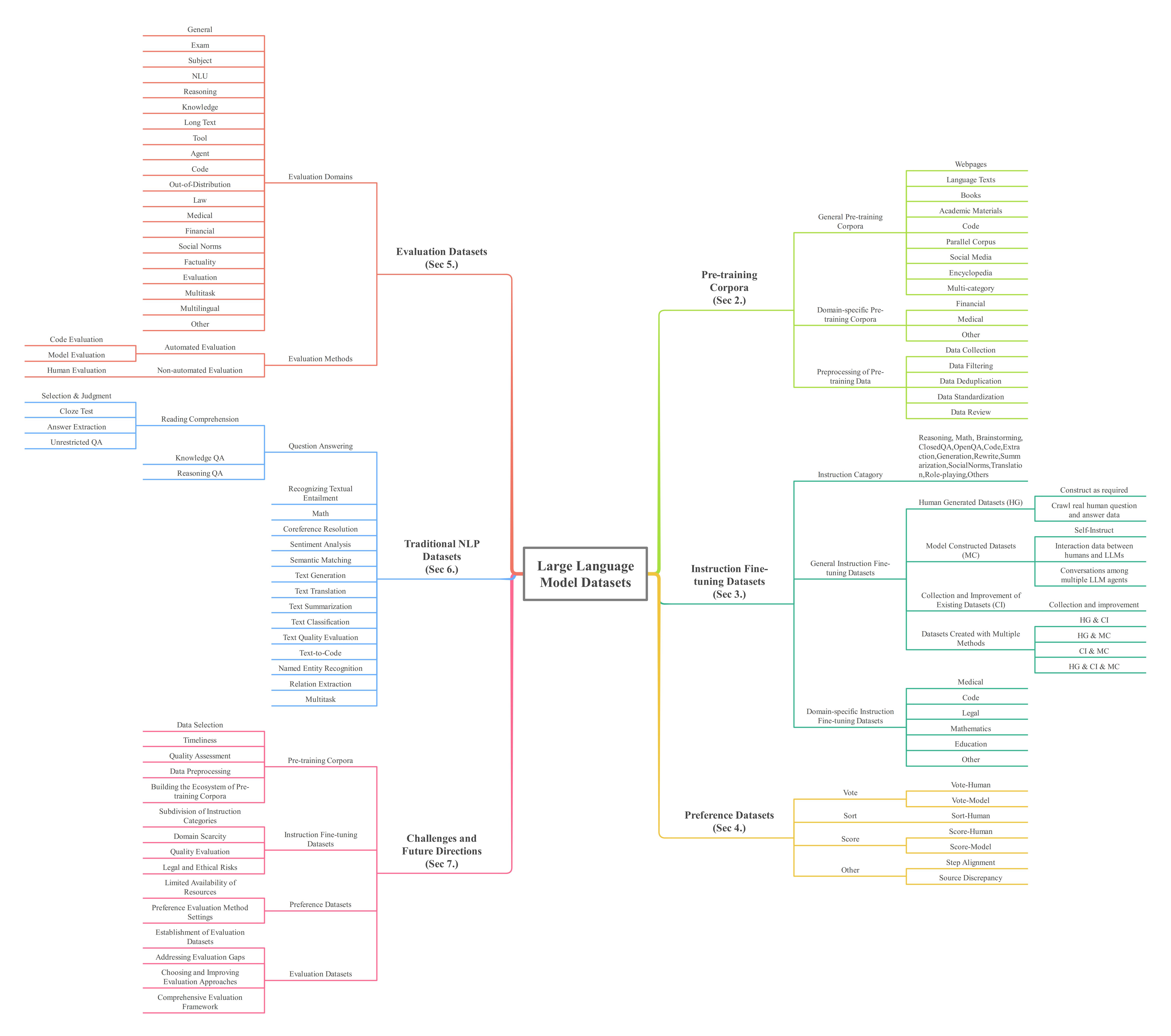

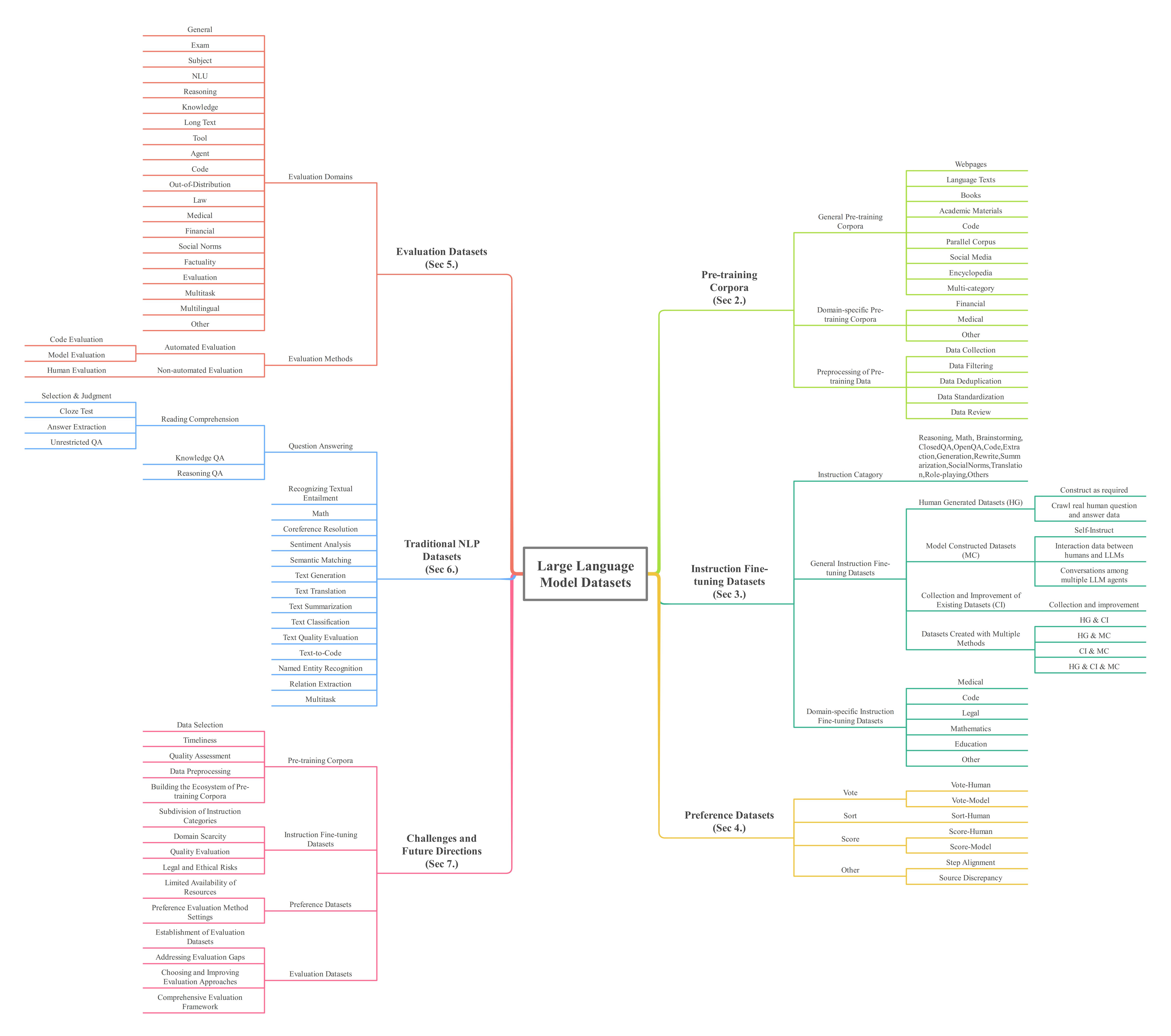

รูปที่ 1 สถาปัตยกรรมโดยรวมของการสำรวจ ซูมเข้าเพื่อดูที่ดีขึ้น

โมดูลข้อมูลชุดข้อมูล

ต่อไปนี้เป็นบทสรุปของโมดูลข้อมูลชุดข้อมูล

- ชื่อคอร์ปัส/ชุดข้อมูล

- ผู้จัดพิมพ์

- เวลาปล่อยเวลา

- “ x” หมายถึงเดือนที่ไม่รู้จัก

- ขนาด

- สาธารณะหรือไม่

- “ ทั้งหมด” หมายถึงโอเพ่นซอร์สเต็ม;

- “ บางส่วน” หมายถึงโอเพ่นซอร์สบางส่วน

- “ ไม่” หมายถึงไม่ใช่โอเพนซอร์ส

- ใบอนุญาต

- ภาษา

- “ en” หมายถึงภาษาอังกฤษ

- “ ZH” หมายถึงภาษาจีน

- “ AR” หมายถึงภาษาอาหรับ

- “ ES” หมายถึงภาษาสเปน

- “ ru” หมายถึงรัสเซีย;

- “ เดอ” หมายถึงภาษาเยอรมัน

- “ KO” หมายถึงเกาหลี

- “ LT” หมายถึงลิทัวเนีย;

- “ FA” หมายถึงเปอร์เซีย/ฟาร์ซี;

- “ PL” หมายถึงภาษาการเขียนโปรแกรม

- “ Multi” ระบุหลายภาษาและจำนวนในวงเล็บระบุจำนวนภาษาที่รวมอยู่ด้วย

- วิธีการก่อสร้าง

- “ HG” หมายถึงชุดข้อมูล/ชุดข้อมูลที่มนุษย์สร้างขึ้น

- “ MC” หมายถึงชุดข้อมูลที่สร้างขึ้นในคลังข้อมูล/ชุดข้อมูล

- “ CI” หมายถึงการรวบรวมและปรับปรุงชุดข้อมูล/ชุดข้อมูลที่มีอยู่

- หมวดหมู่

- แหล่งที่มา

- โดเมน

- หมวดหมู่คำสั่ง

- วิธีการประเมินผล

- “ VO” หมายถึงการลงคะแนน;

- “ ดังนั้น” บ่งบอกถึงการเรียงลำดับ;

- “ SC” ระบุคะแนน;

- “ -H” ระบุว่าดำเนินการโดยมนุษย์;

- “ -m” ระบุว่าดำเนินการโดยแบบจำลอง

- ประเภทคำถาม

- “ SQ” หมายถึงคำถามส่วนตัว

- “ OQ” หมายถึงคำถามที่มีวัตถุประสงค์

- “ Multi” หมายถึงประเภทคำถามหลายประเภท

- วิธีการประเมินผล

- “ CE” ระบุการประเมินรหัส

- “ เขา” บ่งบอกถึงการประเมินผลของมนุษย์

- “ ฉัน” หมายถึงการประเมินแบบจำลอง

- จุดสนใจ

- จำนวนหมวดหมู่การประเมิน/หมวดหมู่ย่อย

- หมวดการประเมินผล

- จำนวนหมวดหมู่เอนทิตี (งาน ner)

- จำนวนหมวดหมู่ความสัมพันธ์ (งาน RE)

การเปลี่ยนแปลง

- (2024/01/17) สร้างพื้นที่เก็บข้อมูลชุด ข้อมูลที่ยอดเยี่ยม-llms-datasets

- (2024/02/02) แก้ไขข้อมูลสำหรับชุดข้อมูลบางชุด เพิ่ม Dolma (การฝึกอบรมก่อนการฝึกอบรมทั่วไป Corpora การฝึกอบรมทั่วไป | หลายหมวดหมู่)

- (2024/02/15) เพิ่ม คอลเลกชัน AYA (ชุดข้อมูลการปรับแต่งการเรียนการสอน | ชุดข้อมูลการปรับแต่งการปรับแต่งทั่วไป | HG & CI & MC); ชุดข้อมูล AYA (ชุดข้อมูลการปรับแต่งการเรียนการสอน | ชุดข้อมูลการปรับแต่งการปรับแต่งทั่วไป | HG)

- (2024/02/22) เพิ่ม OpenMathInstruct-1 (ชุดข้อมูลการปรับแต่งการเรียนการสอน | ชุดข้อมูลการปรับแต่งเฉพาะโดเมนการปรับแต่งการปรับแต่ง | คณิตศาสตร์); Finben (ชุดข้อมูลการประเมินผล | การเงิน)

- (2024/04/05)

- เพิ่มส่วนชุดข้อมูลใหม่: (1) ชุดข้อมูลภาษาขนาดใหญ่หลายรูปแบบ (MLLMS) (2) ชุดข้อมูล Augmented Generation (RAG) ดึงข้อมูล

- เพิ่ม MMRS-1M (ชุดข้อมูล MLLMS | ชุดข้อมูลการปรับแต่งคำสั่ง); VideoChat2-IT (ชุดข้อมูล MLLMS | ชุดข้อมูลการปรับแต่งคำสั่ง); InstructDoc (ชุดข้อมูล MLLMS | ชุดข้อมูลการปรับแต่งคำสั่ง); ข้อมูล Allava-4V (ชุดข้อมูล MLLMS | ชุดข้อมูลการปรับแต่งคำสั่ง); MVBENCH (ชุดข้อมูล MLLMS | ชุดข้อมูลการประเมินผล); Olympiadbench (ชุดข้อมูล MLLMS | ชุดข้อมูลการประเมินผล); MMMU (ชุดข้อมูล MLLMS | ชุดข้อมูลการประเมินผล)

- เพิ่ม ชุดเบนช์เบนช์ (ชุดข้อมูลการประเมินผล | แพลตฟอร์มการประเมินผล); OpenLLM LEADERBOARD (ชุดข้อมูลการประเมินผล | แพลตฟอร์มการประเมินผล); OpenCompass (ชุดข้อมูลการประเมินผล | แพลตฟอร์มการประเมินผล); MTEB LEADERBOARD (ชุดข้อมูลการประเมินผล | แพลตฟอร์มการประเมินผล); C-MTEB LEADERBOARD (ชุดข้อมูลการประเมินผล | แพลตฟอร์มการประเมินผล)

- เพิ่ม NAH (Needle-in-A-Haystack) (ชุดข้อมูลการประเมินผล | ข้อความยาว); Tooleyes (ชุดข้อมูลการประเมินผล | เครื่องมือ); Uhgeval (ชุดข้อมูลการประเมินผล | ข้อเท็จจริง); Clongeval (ชุดข้อมูลการประเมินผล | ข้อความยาว)

- เพิ่ม MathPile (การฝึกอบรมก่อนการฝึกอบรมเฉพาะด้านการฝึกอบรมก่อนการฝึกอบรม Corpora | คณิตศาสตร์); Wanjuan-CC (การฝึกอบรมล่วงหน้า Corpora | Corpora ก่อนการฝึกอบรมทั่วไป | หน้าเว็บ)

- เพิ่ม IEPILE (ชุดข้อมูลการปรับแต่งคำสั่ง | ชุดข้อมูลการปรับแต่งการปรับแต่งทั่วไป | CI); Instructie (ชุดข้อมูลการปรับแต่งการเรียนการสอน | ชุดข้อมูลการปรับแต่งการปรับแต่งทั่วไป | HG)

- เพิ่ม crud-rag (ชุดข้อมูล RAG); Wikieval (ชุดข้อมูล RAG); RGB (ชุดข้อมูล RAG); RAG-Instruct-Benchmark-Tester (ชุดข้อมูล RAG); ARES (ชุดข้อมูล RAG)

- (2024/04/06)

- เพิ่ม GPQA (ชุดข้อมูลการประเมินผล | หัวเรื่อง); MGSM (ชุดข้อมูลการประเมินผล | หลายภาษา); Halueval-wild (ชุดข้อมูลการประเมินผล | ข้อเท็จจริง); CMATH (ชุดข้อมูลการประเมินผล | หัวเรื่อง); FINEMATH (ชุดข้อมูลการประเมินผล | หัวเรื่อง); QA เรียลไทม์ (ชุดข้อมูลการประเมินผล | ข้อเท็จจริง); WYWEB (ชุดข้อมูลการประเมินผล | หัวเรื่อง); ChineseFactEval (ชุดข้อมูลการประเมินผล | ข้อเท็จจริง); การนับดาว (ชุดข้อมูลการประเมินผล | ข้อความยาว)

- เพิ่ม Slimpajama (การฝึกอบรมก่อนการฝึกอบรมทั่วไป Corpora การฝึกอบรมทั่วไป | หลายหมวดหมู่); MASSIVETEXT (การฝึกอบรมก่อนการฝึกอบรมทั่วไป CORPORA | หลายหมวดหมู่); MADLAD-400 (Corpora ฝึกอบรมก่อนการฝึกอบรมทั่วไป Corpora | หน้าเว็บ); Minerva (การฝึกอบรมล่วงหน้า Corpora | Corpora ก่อนการฝึกอบรมทั่วไป | หลายหมวดหมู่); Ccaligned (การฝึกอบรมล่วงหน้า Corpora | Corpora ก่อนการฝึกอบรมทั่วไป | คลังข้อมูลขนาน); Wikimatrix (การฝึกอบรมล่วงหน้า Corpora | Corpora ก่อนการฝึกอบรมทั่วไป | คลังข้อมูลขนาน); OpenWebMath (การฝึกอบรมล่วงหน้า Corpora | Corpora การฝึกอบรมเฉพาะด้านโดเมน | คณิตศาสตร์)

- เพิ่ม WebQuestions (ชุดข้อมูล NLP แบบดั้งเดิม | ตอบคำถาม | ความรู้ QA)

- เพิ่ม Alce (ชุดข้อมูล RAG)

- เพิ่ม Alphafin (ชุดข้อมูลการปรับแต่งคำสั่ง | ชุดข้อมูลการปรับแต่งเฉพาะโดเมนการปรับแต่งการปรับแต่ง | อื่น ๆ ); COIG-CQIA (ชุดข้อมูลการปรับแต่งการเรียนการสอน | ชุดข้อมูลการปรับแต่งการปรับแต่งทั่วไป | HG & CI)

- (2024/06/15)

- เพิ่ม เบาะแส (ชุดข้อมูลการประเมินผล | การแพทย์); CHC-bench (ชุดข้อมูลการประเมินผล | ทั่วไป); CIF-BENCH (ชุดข้อมูลการประเมินผล | ทั่วไป); ACLUE (ชุดข้อมูลการประเมินผล | เรื่อง); LESC (ชุดข้อมูลการประเมินผล | NLU); AlignBench (ชุดข้อมูลการประเมินผล | มัลติทาสก์); Sciknoweval (ชุดข้อมูลการประเมินผล | หัวเรื่อง)

- เพิ่ม MAP-CC (การฝึกอบรมล่วงหน้า Corpora | Corpora ก่อนการฝึกอบรมทั่วไป | หลายหมวดหมู่); Fineweb (การฝึกอบรมก่อนการฝึกอบรมทั่วไปการฝึกอบรมทั่วไป | หน้าเว็บ); CCI 2.0 (Corpora ฝึกอบรมก่อนการฝึกอบรมก่อนการฝึกอบรมทั่วไป | หน้าเว็บ)

- เพิ่ม WildChat (ชุดข้อมูลการปรับแต่งคำสั่ง | MC)

- เพิ่ม OpenHerMesPreferences (ชุดข้อมูลการตั้งค่า | เรียงลำดับ); huozi_rlhf_data (ชุดข้อมูลการตั้งค่า | โหวต); Helpsteer (ชุดข้อมูลการตั้งค่า | คะแนน); HelpSteer2 (ชุดข้อมูลการตั้งค่า | คะแนน)

- เพิ่ม MMT-BENCH (ชุดข้อมูล MLLMS | ชุดข้อมูลการประเมินผล); Moscar (ชุดข้อมูล MLLMS | Pre-Training Corpora); MM-NIAH (ชุดข้อมูล MLLMS | ชุดข้อมูลการประเมินผล)

- เพิ่ม CRAG (ชุดข้อมูล RAG)

- (2024/08/29)

- เพิ่ม GameBench (ชุดข้อมูลการประเมินผล | การใช้เหตุผล); Halludial (ชุดข้อมูลการประเมินผล | ข้อเท็จจริง); WildBench (ชุดข้อมูลการประเมินผล | ทั่วไป); DomaineVal (ชุดข้อมูลการประเมินผล | รหัส); Sysbench (ชุดข้อมูลการประเมินผล | ทั่วไป); Kobest (ชุดข้อมูลการประเมินผล | NLU); Sarcasmbench (ชุดข้อมูลการประเมินผล | NLU); C 3 Bench (ชุดข้อมูลการประเมินผล | หัวเรื่อง); TableBench (ชุดข้อมูลการประเมินผล | การใช้เหตุผล); Awablegaleval (ชุดข้อมูลการประเมินผล | กฎหมาย)

- เพิ่ม MultitRust (ชุดข้อมูล MLLMS | ชุดข้อมูลการประเมินผล); OBELISC (ชุดข้อมูล MLLMS | Pre-Training Corpora); ชุดข้อมูล Multimed (MLLMS | ชุดข้อมูลการประเมินผล)

- เพิ่ม DCLM (การฝึกอบรมก่อนการฝึกอบรมทั่วไป Corpora | เว็บเพจ)

- เพิ่ม Lithuanian-Qa-V1 (ชุดข้อมูลการปรับแต่งการเรียนการสอน | CI & MC); Reinstruct (ชุดข้อมูลการปรับแต่งการเรียนการสอน | HG & CI & MC); Kollm-converations (ชุดข้อมูลการปรับแต่งการเรียนการสอน | CI)

- (2024/09/04)

- เพิ่ม longwriter-6k (ชุดข้อมูลการปรับแต่งการเรียนการสอน | CI & MC)

- เพิ่ม Medtrinity-25M (ชุดข้อมูล MLLMS | ชุดข้อมูลการประเมินผล); MMIU (ชุดข้อมูล MLLMS | ชุดข้อมูลการประเมินผล)

- เพิ่ม Expository-Prose-V1 (การฝึกอบรมก่อนการฝึกอบรมทั่วไป Corpora การฝึกอบรมทั่วไป | หลายหมวดหมู่)

- เพิ่ม Debateqa (ชุดข้อมูลการประเมินผล | ความรู้); Needlebench (ชุดข้อมูลการประเมินผล | ข้อความยาว); Arabicmmlu (ชุดข้อมูลการประเมินผล | หัวเรื่อง); PERSIANMMLU (ชุดข้อมูลการประเมินผล | หัวเรื่อง); TMMLU+ (ชุดข้อมูลการประเมินผล | หัวเรื่อง)

- เพิ่ม Rageval (ชุดข้อมูล RAG); LFRQA (ชุดข้อมูล RAG); MultiHop-Rag (ชุดข้อมูล RAG)

- เราจะเผยแพร่ข้อมูลชุดข้อมูลในรูปแบบ CSV

สารบัญ

- Corpora ฝึกอบรมล่วงหน้า

- บริษัท ฝึกอบรมก่อนการฝึกอบรมทั่วไป

- หน้าเว็บ

- ข้อความภาษา

- หนังสือ

- สื่อการศึกษา

- รหัส

- คลังขนาน

- โซเชียลมีเดีย

- สารานุกรม

- หลายหมวดหมู่

- Corpora ก่อนการฝึกอบรมเฉพาะโดเมน

- การเงิน

- ทางการแพทย์

- คณิตศาสตร์

- อื่น

- ชุดข้อมูลการปรับแต่งการปรับแต่ง

- ชุดข้อมูลการปรับแต่งการปรับแต่งทั่วไป

- ชุดข้อมูลที่มนุษย์สร้างขึ้น (HG)

- ชุดข้อมูลที่สร้างขึ้นรุ่น (MC)

- การรวบรวมและปรับปรุงชุดข้อมูลที่มีอยู่ (CI)

- HG & CI

- HG & MC

- CI & MC

- HG & CI & MC

- ชุดข้อมูลการปรับแต่งคำสั่งเฉพาะโดเมน

- ทางการแพทย์

- รหัส

- ถูกกฎหมาย

- คณิตศาสตร์

- การศึกษา

- อื่น

- ชุดข้อมูลการตั้งค่า

- วิธีการประเมินผล

- ลงคะแนนเสียง

- เรียงลำดับ

- คะแนน

- อื่น

- ชุดข้อมูลการประเมินผล

- ทั่วไป

- การสอบ

- เรื่อง

- NLU

- การให้เหตุผล

- ความรู้

- ข้อความยาว

- เครื่องมือ

- ตัวแทน

- รหัส

- อู๊ด

- กฎ

- ทางการแพทย์

- การเงิน

- บรรทัดฐานทางสังคม

- ข้อเท็จจริง

- การประเมิน

- มัลติทาสก์

- พูดได้หลายภาษา

- อื่น

- แพลตฟอร์มการประเมินผล

- ชุดข้อมูล NLP แบบดั้งเดิม

- ตอบคำถาม

- การอ่านความเข้าใจ

- การเลือกและการตัดสิน

- การทดสอบปิดบัง

- คำตอบการสกัด

- QA ไม่ จำกัด

- QA ความรู้

- การให้เหตุผล QA

- การรับรู้ถึงข้อความที่เป็นข้อความ

- คณิตศาสตร์

- ความละเอียด coreference

- การวิเคราะห์ความเชื่อมั่น

- การจับคู่ความหมาย

- การสร้างข้อความ

- การแปลข้อความ

- การสรุปข้อความ

- การจำแนกข้อความ

- การประเมินคุณภาพข้อความ

- ข้อความเป็นรหัส

- การจดจำเอนทิตีชื่อ

- การสกัดความสัมพันธ์

- มัลติทาสก์

- ชุดข้อมูลโมเดลภาษาขนาดใหญ่หลายรูปแบบ (MLLMS)

- Corpora ฝึกอบรมล่วงหน้า

- ชุดข้อมูลการปรับแต่งการปรับแต่ง

- ชุดข้อมูลการประเมินผล

- ชุดข้อมูล Augmented Generation (RAG) ดึงข้อมูล

Corpora ฝึกอบรมล่วงหน้า

Corpora ฝึกอบรมล่วงหน้าเป็นคอลเลกชันขนาดใหญ่ของข้อมูลข้อความที่ใช้ในระหว่างกระบวนการฝึกอบรมล่วงหน้าของ LLM

บริษัท ฝึกอบรมก่อนการฝึกอบรมทั่วไป

Corpora การฝึกอบรมก่อนการฝึกอบรมทั่วไปเป็นชุดข้อมูลขนาดใหญ่ที่ประกอบด้วยข้อความที่กว้างขวางจากโดเมนและแหล่งข้อมูลที่หลากหลาย ลักษณะหลักของพวกเขาคือเนื้อหาข้อความไม่ได้ จำกัด อยู่ในโดเมนเดียวทำให้พวกเขาเหมาะสมกว่าสำหรับการฝึกอบรมแบบจำลองพื้นฐานทั่วไป Corpora ถูกจัดประเภทตามหมวดหมู่ข้อมูล

รูปแบบข้อมูลชุดข้อมูล:

- Dataset name Release Time | Public or Not | Language | Construction Method | Paper | Github | Dataset | Website

- Publisher:

- Size:

- License:

- Source:

หน้าเว็บ

CC-Stories 2018-6 | ไม่ใช่ | en | CI | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Google Brain

- ขนาด: 31 GB

- ใบอนุญาต: -

- ที่มา: การรวบรวมข้อมูลทั่วไป

CC100 2020-7 | ทั้งหมด | Multi (100) | CI | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: Facebook AI

- ขนาด: 2.5 TB

- ใบอนุญาต: ข้อกำหนดการใช้งานทั่วไปการใช้งาน

- ที่มา: การรวบรวมข้อมูลทั่วไป

Cluecorpus2020 2020-3 | ทั้งหมด | ZH | CI | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: องค์กรเบาะแส

- ขนาด: 100 GB

- ใบอนุญาต: MIT

- ที่มา: การรวบรวมข้อมูลทั่วไป

รวบรวมข้อมูลทั่วไป 2007-X | ทั้งหมด | มัลติ | HG | เว็บไซต์

- สำนักพิมพ์: การรวบรวมข้อมูลทั่วไป

- ขนาด: -

- ใบอนุญาต: ข้อกำหนดการใช้งานทั่วไปการใช้งาน

- ที่มา: ข้อมูลการรวบรวมข้อมูลเว็บ

Culturax 2023-9 | ทั้งหมด | Multi (167) | CI | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: มหาวิทยาลัยโอเรกอนและคณะ

- ขนาด: 27 TB

- ใบอนุญาต: ใบอนุญาต MC4 และออสการ์

- ที่มา: MC4, Oscar

C4 2019-10 | ทั้งหมด | en | CI | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: Google Research

- ขนาด: 12.68 TB

- ใบอนุญาต: ODC-by & เงื่อนไขการใช้งานทั่วไปการใช้งาน

- ที่มา: การรวบรวมข้อมูลทั่วไป

MC4 2021-6 | ทั้งหมด | Multi (108) | CI | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: Google Research

- ขนาด: 251 GB

- ใบอนุญาต: ODC-by & เงื่อนไขการใช้งานทั่วไปการใช้งาน

- ที่มา: การรวบรวมข้อมูลทั่วไป

ออสการ์ 22.01 2022-1 | ทั้งหมด | Multi (151) | CI | กระดาษ | ชุดข้อมูล เว็บไซต์

- สำนักพิมพ์: inria

- ขนาด: 8.41 TB

- ใบอนุญาต: CC0

- ที่มา: การรวบรวมข้อมูลทั่วไป

RealNews 2019-5 | ทั้งหมด | en | CI | กระดาษ | คนอื่น ๆ

- สำนักพิมพ์: มหาวิทยาลัยวอชิงตันและคณะ

- ขนาด: 120 GB

- ใบอนุญาต: Apache-2.0

- ที่มา: การรวบรวมข้อมูลทั่วไป

Redpajama-V2 2023-10 | ทั้งหมด | Multi (5) | CI | GitHub | ชุดข้อมูล เว็บไซต์

- สำนักพิมพ์: คอมพิวเตอร์ร่วมกัน

- ขนาด: 30.4 โทเค็น

- ใบอนุญาต: ข้อกำหนดการใช้งานทั่วไปการใช้งาน

- ที่มา: การรวบรวมข้อมูลทั่วไป, C4, ฯลฯ

RefinedWeb 2023-6 | บางส่วน en | CI | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: ทีม Falcon LLM

- ขนาด: 5,000 GB

- ใบอนุญาต: ODC-by-1.0

- ที่มา: การรวบรวมข้อมูลทั่วไป

Wudaocorpora-text 2021-6 | บางส่วน ZH | HG | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: Baai และคณะ

- ขนาด: 200 GB

- ใบอนุญาต: MIT

- ที่มา: หน้าเว็บจีน

Wanjuan-CC 2024-2 | บางส่วน en | HG | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: ห้องปฏิบัติการข่าวกรองของเซี่ยงไฮ้

- ขนาด: โทเค็น 1 T

- ใบอนุญาต: CC-by-4.0

- ที่มา: การรวบรวมข้อมูลทั่วไป

MADLAD-400 2023-9 | ทั้งหมด | Multi (419) | HG | กระดาษ | GitHub | ชุดข้อมูล

- Publisher: Google Deepmind และคณะ

- ขนาด: โทเค็น 2.8 T

- ใบอนุญาต: ODL-by

- ที่มา: การรวบรวมข้อมูลทั่วไป

Fineweb 2024-4 | ทั้งหมด | en | CI | ชุดข้อมูล

- สำนักพิมพ์: huggingfacefw

- ขนาด: โทเค็น 15 TB

- ใบอนุญาต: ODC-by-1.0

- ที่มา: การรวบรวมข้อมูลทั่วไป

CCI 2.0 2024-4 | ทั้งหมด | ZH | HG | ชุดข้อมูล 1 | ชุดข้อมูล 2

- สำนักพิมพ์: Baai

- ขนาด: 501 GB

- ใบอนุญาต: การใช้งาน CCI

- ที่มา: หน้าเว็บจีน

DCLM 2024-6 | ทั้งหมด | en | CI | กระดาษ | GitHub | ชุดข้อมูล เว็บไซต์

- สำนักพิมพ์: มหาวิทยาลัยวอชิงตันและคณะ

- ขนาด: 279.6 TB

- ใบอนุญาต: ข้อกำหนดการใช้งานทั่วไปการใช้งาน

- ที่มา: การรวบรวมข้อมูลทั่วไป

ข้อความภาษา

ANC 2003-X | ทั้งหมด | en | HG | เว็บไซต์

- สำนักพิมพ์: มูลนิธิวิทยาศาสตร์แห่งชาติสหรัฐอเมริกาและคณะ

- ขนาด: -

- ใบอนุญาต: -

- ที่มา: ตำราภาษาอังกฤษอเมริกัน

BNC 1994-X | ทั้งหมด | en | HG | เว็บไซต์

- สำนักพิมพ์: สำนักพิมพ์มหาวิทยาลัยออกซ์ฟอร์ดและคณะ

- ขนาด: 4124 ข้อความ

- ใบอนุญาต: -

- ที่มา: ข้อความภาษาอังกฤษอังกฤษ

News-Crawl 2019-1 | ทั้งหมด | Multi (59) | HG | ชุดข้อมูล

- สำนักพิมพ์: Ukri และคณะ

- ขนาด: 110 GB

- ใบอนุญาต: CC0

- ที่มา: หนังสือพิมพ์

หนังสือ

Archive ของ Anna 2023-X | ทั้งหมด | มัลติ | HG | เว็บไซต์

- สำนักพิมพ์: แอนนา

- ขนาด: 586.3 TB

- ใบอนุญาต: -

- ที่มา: Sci-Hub, Library Genesis, Z-Library ฯลฯ

Bookcorpusopen 2021-5 | ทั้งหมด | en | CI | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Jack Bandy และคณะ

- ขนาด: หนังสือ 17,868 เล่ม

- ใบอนุญาต: ข้อกำหนดในการให้บริการ smashwords

- ที่มา: Toronto Book Corpus

PG-19 2019-11 | ทั้งหมด | en | HG | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: DeepMind

- ขนาด: 11.74 GB

- ใบอนุญาต: Apache-2.0

- ที่มา: Project Gutenberg

Project Gutenberg 1971-X | ทั้งหมด | มัลติ | HG | เว็บไซต์

- สำนักพิมพ์: Ibiblio และคณะ

- ขนาด: -

- ใบอนุญาต: โครงการกูเทนเบิร์ก

- ที่มา: ข้อมูล ebook

SMASHWORDS 2008-X | ทั้งหมด | มัลติ | HG | เว็บไซต์

- สำนักพิมพ์: Draft2Digital และคณะ

- ขนาด: -

- ใบอนุญาต: ข้อกำหนดในการให้บริการ smashwords

- ที่มา: ข้อมูล ebook

Toronto Book Corpus 2015-6 | ไม่ใช่ | en | HG | กระดาษ | เว็บไซต์

- สำนักพิมพ์: มหาวิทยาลัยโตรอนโตและคณะ

- ขนาด: หนังสือ 11,038 เล่ม

- ใบอนุญาต: ข้อกำหนดการให้บริการ MIT & SMASHWORDS

- ที่มา: smashwords

สื่อการศึกษา

รหัส

BigQuery 2022-3 | ไม่ใช่ | PL | CI | กระดาษ | คนอื่น ๆ

- สำนักพิมพ์: Salesforce Research

- ขนาด: 341.1 GB

- ใบอนุญาต: Apache-2.0

- ที่มา: BigQuery

GitHub 2008-4 | ทั้งหมด | PL | HG | เว็บไซต์

- สำนักพิมพ์: Microsoft

- ขนาด: -

- ใบอนุญาต: -

- ที่มา: โครงการรหัสต่างๆ

Phi-1 2023-6 | ไม่ใช่ | en & pl | HG & MC | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: Microsoft Research

- ขนาด: โทเค็น 7 B

- ใบอนุญาต: CC-BY-NC-SA-3.0

- ที่มา: The Stack, Stackoverflow, GPT-3.5 Generation

สแต็ค 2022-11 | ทั้งหมด | PL (358) | HG | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: ServiceNow Research และคณะ

- ขนาด: 6 TB

- ใบอนุญาต: ข้อกำหนดของใบอนุญาตเดิม

- ที่มา: ไฟล์ซอร์สโค้ดที่ได้รับอนุญาตอย่างอนุญาต

คลังขนาน

MTP 2023-9 | ทั้งหมด | en & zh | HG & CI | ชุดข้อมูล

- สำนักพิมพ์: Baai

- ขนาด: 1.3 TB

- ใบอนุญาต: โปรโตคอลการใช้ข้อมูล BAAI

- ที่มา: คู่ข้อความคู่ขนานภาษาจีน-อังกฤษบนเว็บ

Multiun 2010-5 | ทั้งหมด | Multi (7) | HG | กระดาษ | เว็บไซต์

- สำนักพิมพ์: ศูนย์วิจัยของเยอรมันเพื่อปัญญาประดิษฐ์ (DFKI) GmbH

- ขนาด: 4353 MB

- ใบอนุญาต: -

- ที่มา: เอกสารของสหประชาชาติ

Paracrawl 2020-7 | ทั้งหมด | Multi (42) | HG | กระดาษ | เว็บไซต์

- สำนักพิมพ์: Prompsit และคณะ

- ขนาด: 59996 ไฟล์

- ใบอนุญาต: CC0

- ที่มา: ข้อมูลการรวบรวมข้อมูลเว็บ

Uncorpus v1.0 2016-5 | ทั้งหมด | Multi (6) | HG | กระดาษ | เว็บไซต์

- สำนักพิมพ์: สหประชาชาติและคณะ

- ขนาด: 799276 ไฟล์

- ใบอนุญาต: -

- ที่มา: เอกสารของสหประชาชาติ

Ccaligned 2020-11 | ทั้งหมด | Multi (138) | HG | กระดาษ | ชุดข้อมูล

- Publisher: Facebook AI และคณะ

- ขนาด: 392 M URL คู่

- ใบอนุญาต: -

- ที่มา: การรวบรวมข้อมูลทั่วไป

Wikimatrix 2021-4 | ทั้งหมด | Multi (85) | HG | กระดาษ | GitHub | ชุดข้อมูล

- Publisher: Facebook AI และคณะ

- ขนาด: 134 M ประโยคคู่ขนาน

- ใบอนุญาต: CC-by-SA

- ที่มา: Wikipedia

โซเชียลมีเดีย

OpenWebText 2019-4 | ทั้งหมด | en | HG | เว็บไซต์

- สำนักพิมพ์: มหาวิทยาลัยบราวน์

- ขนาด: 38 GB

- ใบอนุญาต: CC0

- ที่มา: Reddit

Pushshift Reddit 2020-1 | ทั้งหมด | en | CI | กระดาษ | เว็บไซต์

- สำนักพิมพ์: pushshift.io และคณะ

- ขนาด: 2 TB

- ใบอนุญาต: -

- ที่มา: Reddit

Reddit 2005-6 | ทั้งหมด | en | HG | เว็บไซต์

- สำนักพิมพ์: Condé Nast Digital และคณะ

- ขนาด: -

- ใบอนุญาต: -

- ที่มา: โพสต์โซเชียลมีเดีย

Stackexchange 2008-9 | ทั้งหมด | en | HG | ชุดข้อมูล เว็บไซต์

- สำนักพิมพ์: Exchange Stack

- ขนาด: -

- ใบอนุญาต: CC-BY-SA-4.0

- ที่มา: คำถามชุมชนและข้อมูลคำตอบ

WebText 2019-2 | บางส่วน en | HG | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Openai

- ขนาด: 40 GB

- ใบอนุญาต: MIT

- ที่มา: Reddit

Zhihu 2011-1 | ทั้งหมด | ZH | HG | เว็บไซต์

- สำนักพิมพ์: ปักกิ่ง Zhizhe Tianxia Technology Co. , Ltd

- ขนาด: -

- ใบอนุญาต: ข้อตกลงผู้ใช้ Zhihu

- ที่มา: โพสต์โซเชียลมีเดีย

สารานุกรม

Baidu Baike 2008-4 | ทั้งหมด | ZH | HG | เว็บไซต์

- สำนักพิมพ์: Baidu

- ขนาด: -

- ใบอนุญาต: ข้อตกลงผู้ใช้ Baidu Baike

- ที่มา: ข้อมูลเนื้อหาสารานุกรม

Tigerbot-Wiki 2023-5 | ทั้งหมด | ZH | HG | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Tigerbot

- ขนาด: 205 MB

- ใบอนุญาต: Apache-2.0

- ที่มา: Baidu Baike

Wikipedia 2001-1 | ทั้งหมด | มัลติ | HG | ชุดข้อมูล เว็บไซต์

- สำนักพิมพ์: มูลนิธิ Wikimedia

- ขนาด: -

- ใบอนุญาต: CC-BY-SA-3.0 & GFDL

- ที่มา: ข้อมูลเนื้อหาสารานุกรม

หลายหมวดหมู่

ภาษาอาหรับ 2022 2022-12 | ทั้งหมด | AR | HG & CI | ชุดข้อมูล

- สำนักพิมพ์: Baai และคณะ

- ขนาด: 201.9 GB

- ใบอนุญาต: CC-BY-SA-4.0

- ที่มา: Arabicweb, Oscar, CC100 ฯลฯ

MNBVC 2023-1 | ทั้งหมด | ZH | HG & CI | GitHub | ชุดข้อมูล

- สำนักพิมพ์: ชุมชน Liwu

- ขนาด: 20811 GB

- ใบอนุญาต: MIT

- ที่มา: หนังสือภาษาจีนหน้าเว็บวิทยานิพนธ์ ฯลฯ

Redpajama-V1 2023-4 | ทั้งหมด | มัลติ | HG & CI | GitHub | ชุดข้อมูล

- สำนักพิมพ์: คอมพิวเตอร์ร่วมกัน

- ขนาด: โทเค็น 1.2 T

- ใบอนุญาต: -

- ที่มา: การรวบรวมข้อมูลทั่วไป, GitHub, หนังสือ ฯลฯ

ราก 2023-3 | บางส่วน Multi (59) | HG & CI | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: Hugging Face และคณะ

- ขนาด: 1.61 TB

- ใบอนุญาต: Bloom Open-Rail-M

- ที่มา: Oscar, GitHub ฯลฯ

กอง 2021-1 | ทั้งหมด | en | HG & CI | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Eleutherai

- ขนาด: 825.18 GB

- ใบอนุญาต: MIT

- ที่มา: หนังสือ, arxiv, gitHub ฯลฯ

tigerbot_pretrain_en 2023-5 | บางส่วน en | CI | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Tigerbot

- ขนาด: 51 GB

- ใบอนุญาต: Apache-2.0

- ที่มา: หนังสือภาษาอังกฤษหน้าเว็บ en-wiki ฯลฯ

tigerbot_pretrain_zh 2023-5 | บางส่วน ZH | HG | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Tigerbot

- ขนาด: 55 GB

- ใบอนุญาต: Apache-2.0

- ที่มา: หนังสือจีน, หน้าเว็บ, Zh-Wiki ฯลฯ

Wanjuantext-1.0 2023-8 | ทั้งหมด | ZH | HG | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: ห้องปฏิบัติการเซี่ยงไฮ้ AI

- ขนาด: 1094 GB

- ใบอนุญาต: CC-by-4.0

- ที่มา: หน้าเว็บ, สารานุกรม, หนังสือ, ฯลฯ

Dolma 2024-1 | ทั้งหมด | en | HG & CI | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: AI2 และคณะ

- ขนาด: 11519 GB

- ใบอนุญาต: ข้อตกลง MR

- ที่มา: Project Gutenberg, C4, Reddit ฯลฯ

SLIMPAJAMA 2023-6 | ทั้งหมด | en | HG & CI | GitHub | ชุดข้อมูล เว็บไซต์

- สำนักพิมพ์: Cerebras และคณะ

- ขนาด: โทเค็น 627 B

- ใบอนุญาต: -

- ที่มา: การรวบรวมข้อมูลทั่วไป, C4, GitHub ฯลฯ

Massivetext 2021-12 | ไม่ใช่ | มัลติ | HG & CI | กระดาษ

- ผู้เผยแพร่: Google DeepMind

- ขนาด: 10.5 TB

- ใบอนุญาต: -

- ที่มา: MassiveWeb, C4, หนังสือ ฯลฯ

Minerva 2022-6 | ไม่ใช่ | en | HG | กระดาษ

- สำนักพิมพ์: Google Research

- ขนาด: โทเค็น 38.5 B

- ใบอนุญาต: -

- ที่มา: arxiv, หน้าเว็บ ฯลฯ

MAP-CC 2024-4 | ทั้งหมด | ZH | HG | กระดาษ | GitHub | ชุดข้อมูล เว็บไซต์

- สำนักพิมพ์: ชุมชนการวิจัยการฉายภาพศิลปะหลายรูปแบบและคณะ

- ขนาด: 840.48 B โทเค็น

- ใบอนุญาต: CC-BY-NC-ND-4.0

- ที่มา: การรวบรวมข้อมูลทั่วไปของจีนสารานุกรมจีนหนังสือจีน ฯลฯ

Expository-Prose-V1 2024-8 | ทั้งหมด | en | HG & CI | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Pints.ai Labs

- ขนาด: โทเค็น 56 B

- ใบอนุญาต: MIT

- ที่มา: Arxiv, Wikipedia, Gutenberg ฯลฯ

Corpora ก่อนการฝึกอบรมเฉพาะโดเมน

Corpora ก่อนการฝึกอบรมเฉพาะโดเมนเป็นชุดข้อมูล LLM ที่ปรับแต่งสำหรับฟิลด์หรือหัวข้อเฉพาะ ประเภทของคลังข้อมูลมักใช้ในขั้นตอนการฝึกอบรมก่อนการฝึกอบรมของ LLMS Corpora ถูกจัดประเภทตามโดเมนข้อมูล

รูปแบบข้อมูลชุดข้อมูล:

- Dataset name Release Time | Public or Not | Language | Construction Method | Paper | Github | Dataset | Website

- Publisher:

- Size:

- License:

- Source:

- Category:

- Domain:

การเงิน

BBT-Fincorpus 2023-2 | บางส่วน ZH | HG | กระดาษ | GitHub | เว็บไซต์

- สำนักพิมพ์: Fudan University และคณะ

- ขนาด: 256 GB

- ใบอนุญาต: -

- ที่มา: ประกาศ บริษัท รายงานการวิจัยทางการเงิน

- หมวดหมู่: Multi

- โดเมน: การเงิน

Fincorpus 2023-9 | ทั้งหมด | ZH | HG | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Du Xiaaman

- ขนาด: 60.36 GB

- ใบอนุญาต: Apache-2.0

- ที่มา: การประกาศของ บริษัท ข่าวการเงินคำถามการสอบทางการเงิน

- หมวดหมู่: Multi

- โดเมน: การเงิน

Finglm 2023-7 | ทั้งหมด | ZH | HG | คนอื่น ๆ

- สำนักพิมพ์: ความรู้ Atlas และคณะ

- ขนาด: 69 GB

- ใบอนุญาต: Apache-2.0

- ที่มา: รายงานประจำปีของ บริษัท จดทะเบียน

- หมวดหมู่: ข้อความภาษา

- โดเมน: การเงิน

Tigerbot-Ealing 2023-5 | ทั้งหมด | ZH | HG | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Tigerbot

- ขนาด: 488 MB

- ใบอนุญาต: Apache-2.0

- ที่มา: รายงานทางการเงิน

- หมวดหมู่: ข้อความภาษา

- โดเมน: การเงิน

Tigerbot-Research 2023-5 | ทั้งหมด | ZH | HG | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Tigerbot

- ขนาด: 696 MB

- ใบอนุญาต: Apache-2.0

- ที่มา: รายงานการวิจัย

- หมวดหมู่: ข้อความภาษา

- โดเมน: การเงิน

ทางการแพทย์

คณิตศาสตร์

Proof-Pile-2 2023-10 | ทั้งหมด | en | HG & CI | กระดาษ | GitHub | ชุดข้อมูล เว็บไซต์

- สำนักพิมพ์: Princeton University และคณะ

- ขนาด: โทเค็น 55 B

- ใบอนุญาต: -

- ที่มา: Arxiv, OpenWebMath, พีชคณิต

- หมวดหมู่: Multi

- โดเมน: คณิตศาสตร์

Mathpile 2023-12 | ทั้งหมด | en | HG | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: มหาวิทยาลัยเซี่ยงไฮ้ Jiao Tong และคณะ

- ขนาด: โทเค็น 9.5 B

- ใบอนุญาต: CC-BY-NC-SA-4.0

- ที่มา: ตำราเรียน, วิกิพีเดีย, Proofwiki, Commoncrawl, Stackexchange, arxiv

- หมวดหมู่: Multi

- โดเมน: คณิตศาสตร์

OpenWebMath 2023-10 | ทั้งหมด | en | HG | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: มหาวิทยาลัยโตรอนโตและคณะ

- ขนาด: 14.7 B โทเค็น

- ใบอนุญาต: ODC-by-1.0

- ที่มา: การรวบรวมข้อมูลทั่วไป

- หมวดหมู่: หน้าเว็บ

- โดเมน: คณิตศาสตร์

อื่น

ชุดข้อมูลการปรับแต่งการปรับแต่ง

ชุดข้อมูลการปรับแต่งการเรียนการสอนประกอบด้วยชุดของคู่ข้อความประกอบด้วย "อินพุตคำสั่ง" และ "คำตอบเอาต์พุต" “ อินพุตคำสั่ง” แสดงถึงคำขอที่มนุษย์ทำกับโมเดล มีคำแนะนำหลายประเภทเช่นการจำแนกประเภทการสรุปการถอดความ ฯลฯ “ คำตอบผลลัพธ์” คือการตอบสนองที่สร้างขึ้นโดยแบบจำลองตามคำสั่งและสอดคล้องกับความคาดหวังของมนุษย์

ชุดข้อมูลการปรับแต่งการปรับแต่งทั่วไป

ชุดข้อมูลการปรับแต่งการปรับแต่งทั่วไปมีหมวดหมู่คำสั่งอย่างน้อยหนึ่งประเภทโดยไม่มีข้อ จำกัด ของโดเมนโดยมีจุดประสงค์เพื่อเพิ่มความสามารถในการติดตามคำสั่งของ LLM ในงานทั่วไป ชุดข้อมูลถูกจัดประเภทตามวิธีการก่อสร้าง

รูปแบบข้อมูลชุดข้อมูล:

- Dataset name Release Time | Public or Not | Language | Construction Method | Paper | Github | Dataset | Website

- Publisher:

- Size:

- License:

- Source:

- Instruction Category:

ชุดข้อมูลที่มนุษย์สร้างขึ้น (HG)

Databricks-Dolly-15K 2023-4 | ทั้งหมด | en | HG | ชุดข้อมูล เว็บไซต์

- Publisher: Databricks

- ขนาด: 15011 อินสแตนซ์

- ใบอนุญาต: CC-BY-SA-3.0

- ที่มา: สร้างด้วยตนเองตามหมวดหมู่คำสั่งที่แตกต่างกัน

- หมวดหมู่คำแนะนำ: หลาย

คำแนะนำ WILD_V2 2023-6 | ทั้งหมด | en & zh | HG | คนอื่น ๆ

- สำนักพิมพ์: มหาวิทยาลัยแห่งชาติสิงคโปร์

- ขนาด: 110k อินสแตนซ์

- ใบอนุญาต: -

- ที่มา: รวบรวมบนเว็บ

- หมวดหมู่คำแนะนำ: หลาย

LCCC 2020-8 | ทั้งหมด | ZH | HG | กระดาษ | คนอื่น ๆ

- สำนักพิมพ์: มหาวิทยาลัย Tsinghua และคณะ

- ขนาด: 12m อินสแตนซ์

- ใบอนุญาต: MIT

- ที่มา: รวบรวมข้อมูลการโต้ตอบของผู้ใช้บนโซเชียลมีเดีย

- หมวดหมู่คำแนะนำ: หลาย

OASST1 2023-4 | ทั้งหมด | Multi (35) | HG | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: OpenAssistant

- ขนาด: 161443 อินสแตนซ์

- ใบอนุญาต: Apache-2.0

- ที่มา: สร้างและใส่คำอธิบายประกอบโดยมนุษย์

- หมวดหมู่คำแนะนำ: หลาย

OL-CC 2023-6 | ทั้งหมด | ZH | HG | ชุดข้อมูล

- สำนักพิมพ์: Baai

- ขนาด: 11655 อินสแตนซ์

- ใบอนุญาต: Apache-2.0

- ที่มา: สร้างและใส่คำอธิบายประกอบโดยมนุษย์

- หมวดหมู่คำแนะนำ: หลาย

Zhihu-Kol 2023-3 | ทั้งหมด | ZH | HG | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Wangrui6

- ขนาด: 1006218 อินสแตนซ์

- ใบอนุญาต: MIT

- ที่มา: รวบรวมข้อมูลจาก Zhihu

- หมวดหมู่คำแนะนำ: หลาย

ชุดข้อมูล AYA 2024-2 | ทั้งหมด | Multi (65) | HG | กระดาษ | ชุดข้อมูล เว็บไซต์

- สำนักพิมพ์: Cohere for AI Community และคณะ

- ขนาด: 204k อินสแตนซ์

- ใบอนุญาต: Apache-2.0

- ที่มา: รวบรวมและใส่คำอธิบายประกอบด้วยตนเองผ่านแพลตฟอร์ม AYA Annotation

- หมวดหมู่คำแนะนำ: หลาย

อาจารย์ 2023-5 | ทั้งหมด | en & zh | HG | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: มหาวิทยาลัยเจ้อเจียงและคณะ

- ขนาด: 371700 อินสแตนซ์

- ใบอนุญาต: MIT

- ที่มา: Baidu Baike, Wikipedia

- หมวดหมู่คำสั่ง: การสกัด

ชุดข้อมูลที่สร้างขึ้นรุ่น (MC)

Alpaca_data 2023-3 | ทั้งหมด | en | MC | คนอื่น ๆ

- สำนักพิมพ์: Stanford Alpaca

- ขนาด: อินสแตนซ์ 52K

- ใบอนุญาต: Apache-2.0

- ที่มา: สร้างโดย text-davinci-003 พร้อมพรอมต์ APLACA_DATA

- หมวดหมู่คำแนะนำ: หลาย

belle_generated_chat 2023-5 | ทั้งหมด | ZH | MC | GitHub | ชุดข้อมูล

- สำนักพิมพ์: เบลล์

- ขนาด: 396004 อินสแตนซ์

- ใบอนุญาต: GPL-3.0

- ที่มา: สร้างโดย CHATGPT

- หมวดหมู่คำแนะนำ: รุ่น

belle_multiturn_chat 2023-5 | ทั้งหมด | ZH | MC | GitHub | ชุดข้อมูล

- สำนักพิมพ์: เบลล์

- ขนาด: 831036 อินสแตนซ์

- ใบอนุญาต: GPL-3.0

- ที่มา: สร้างโดย CHATGPT

- หมวดหมู่คำแนะนำ: หลาย

belle_train_0.5m_cn 2023-4 | ทั้งหมด | ZH | MC | GitHub | ชุดข้อมูล

- สำนักพิมพ์: เบลล์

- ขนาด: 519255 อินสแตนซ์

- ใบอนุญาต: GPL-3.0

- ที่มา: สร้างโดย text-davinci-003

- หมวดหมู่คำแนะนำ: หลาย

belle_train_1m_cn 2023-4 | ทั้งหมด | ZH | MC | GitHub | ชุดข้อมูล

- สำนักพิมพ์: เบลล์

- ขนาด: 917424 อินสแตนซ์

- ใบอนุญาต: GPL-3.0

- ที่มา: สร้างโดย text-davinci-003

- หมวดหมู่คำแนะนำ: หลาย

belle_train_2m_cn 2023-5 | ทั้งหมด | ZH | MC | GitHub | ชุดข้อมูล

- สำนักพิมพ์: เบลล์

- ขนาด: 2m อินสแตนซ์

- ใบอนุญาต: GPL-3.0

- ที่มา: สร้างโดย CHATGPT

- หมวดหมู่คำแนะนำ: หลาย

belle_train_3.5m_cn 2023-5 | ทั้งหมด | ZH | MC | GitHub | ชุดข้อมูล

- สำนักพิมพ์: เบลล์

- ขนาด: 3606402 อินสแตนซ์

- ใบอนุญาต: GPL-3.0

- ที่มา: สร้างโดย CHATGPT

- หมวดหมู่คำแนะนำ: หลาย

อูฐ 2023-3 | ทั้งหมด | Multi & PL | MC | กระดาษ | GitHub | ชุดข้อมูล เว็บไซต์

- สำนักพิมพ์: Kaust

- ขนาด: 1659328 อินสแตนซ์

- ใบอนุญาต: CC-BY-NC-4.0

- ที่มา: บทสนทนาที่สร้างโดยตัวแทน GPT-3.5-turbo สองตัว

- หมวดหมู่คำแนะนำ: หลาย

chatgpt_corpus 2023-6 | ทั้งหมด | ZH | MC | คนอื่น ๆ

- สำนักพิมพ์: Plexpt

- ขนาด: 3270K อินสแตนซ์

- ใบอนุญาต: GPL-3.0

- ที่มา: สร้างโดย GPT-3.5-turbo

- หมวดหมู่คำแนะนำ: หลาย

คำแนะนำ WILD_V1 2023-3 | ทั้งหมด | en & zh | MC | คนอื่น ๆ

- สำนักพิมพ์: มหาวิทยาลัยแห่งชาติสิงคโปร์

- ขนาด: 104k อินสแตนซ์

- ใบอนุญาต: -

- ที่มา: สร้างโดย OpenAI API

- หมวดหมู่คำแนะนำ: หลาย

LMSYS-Chat-1M 2023-9 | ทั้งหมด | มัลติ | MC | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: UC Berkeley และคณะ

- ขนาด: 1m อินสแตนซ์

- ใบอนุญาต: ใบอนุญาต LMSYS-Chat-1M

- ที่มา: สร้างโดย LLM หลายตัว

- หมวดหมู่คำแนะนำ: หลาย

MOSS_002_SFT_DATA 2023-4 | ทั้งหมด | en & zh | MC | GitHub | ชุดข้อมูล

- สำนักพิมพ์: มหาวิทยาลัย Fudan

- ขนาด: 1161137 อินสแตนซ์

- ใบอนุญาต: CC-BY-NC-4.0

- ที่มา: สร้างโดย text-davinci-003

- หมวดหมู่คำแนะนำ: หลาย

MOSS_003_SFT_DATA 2023-4 | ทั้งหมด | en & zh | MC | GitHub | ชุดข้อมูล

- สำนักพิมพ์: มหาวิทยาลัย Fudan

- ขนาด: 1074551 อินสแตนซ์

- ใบอนุญาต: CC-BY-NC-4.0

- ที่มา: ข้อมูลการสนทนาจาก MOSS-002 และสร้างโดย GPT-3.5-turbo

- หมวดหมู่คำแนะนำ: หลาย

moss_003_sft_plugin_data 2023-4 | บางส่วน en & zh | MC | GitHub | ชุดข้อมูล

- สำนักพิมพ์: มหาวิทยาลัย Fudan

- ขนาด: 300k อินสแตนซ์

- ใบอนุญาต: CC-BY-NC-4.0

- ที่มา: สร้างโดยปลั๊กอินและ LLMS

- หมวดหมู่คำแนะนำ: หลาย

OpenChat 2023-7 | ทั้งหมด | en | MC | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: มหาวิทยาลัย Tsinghua และคณะ

- ขนาด: 70k อินสแตนซ์

- ใบอนุญาต: MIT

- ที่มา: ShareGpt

- หมวดหมู่คำแนะนำ: หลาย

Redgpt-Dataset-V1-CN 2023-4 | บางส่วน ZH | MC | คนอื่น ๆ

- สำนักพิมพ์: Da-Southampton

- ขนาด: 50k อินสแตนซ์

- ใบอนุญาต: Apache-2.0

- ที่มา: สร้างโดย LLMS

- หมวดหมู่คำแนะนำ: หลาย

Instruct ตัวเอง 2022-12 | ทั้งหมด | en | MC | กระดาษ | คนอื่น ๆ

- สำนักพิมพ์: มหาวิทยาลัยวอชิงตันและคณะ

- ขนาด: 52445 อินสแตนซ์

- ใบอนุญาต: Apache-2.0

- ที่มา: สร้างโดย GPT-3

- หมวดหมู่คำแนะนำ: หลาย

Sharechat 2023-4 | ทั้งหมด | มัลติ | MC | เว็บไซต์

- สำนักพิมพ์: Sharechat

- ขนาด: 90k อินสแตนซ์

- ใบอนุญาต: CC0

- ที่มา: ShareGpt

- หมวดหมู่คำแนะนำ: หลาย

Sharegpt-Chinese-English-90K 2023-7 | ทั้งหมด | en & zh | MC | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Shareai

- ขนาด: 90k อินสแตนซ์

- ใบอนุญาต: Apache-2.0

- ที่มา: ShareGpt

- หมวดหมู่คำแนะนำ: หลาย

ShareGPT90K 2023-4 | ทั้งหมด | en | MC | ชุดข้อมูล

- สำนักพิมพ์: Ryokoai

- ขนาด: 90k อินสแตนซ์

- ใบอนุญาต: CC0

- ที่มา: ShareGpt

- หมวดหมู่คำแนะนำ: หลาย

Ultachat 2023-5 | ทั้งหมด | en | MC | กระดาษ | คนอื่น ๆ

- สำนักพิมพ์: มหาวิทยาลัย Tsinghua

- ขนาด: 1468352 อินสแตนซ์

- ใบอนุญาต: CC-BY-NC-4.0

- ที่มา: บทสนทนาที่สร้างโดยตัวแทน CHATGPT สองคน

- หมวดหมู่คำแนะนำ: หลาย

คำแนะนำที่ผิดธรรมชาติ 2022-12 | ทั้งหมด | en | MC | กระดาษ | คนอื่น ๆ

- สำนักพิมพ์: มหาวิทยาลัยเทลอาวีฟและคณะ

- ขนาด: 240670 อินสแตนซ์

- ใบอนุญาต: MIT

- ที่มา: สร้างโดย LLMS

- หมวดหมู่คำแนะนำ: หลาย

WebGLM-QA 2023-6 | ทั้งหมด | en | MC | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: มหาวิทยาลัย Tsinghua และคณะ

- ขนาด: 44979 อินสแตนซ์

- ใบอนุญาต: Apache-2.0

- แหล่งที่มา: สร้าง WebGLM-QA ผ่าน LLM in-context bootstrapping

- หมวดหมู่คำแนะนำ: เปิด QA

Wizard_evol_instruct_196K 2023-6 | ทั้งหมด | en | MC | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Microsoft และคณะ

- ขนาด: อินสแตนซ์ 196k

- ใบอนุญาต: -

- ที่มา: พัฒนาคำแนะนำผ่านวิธีการพัฒนา

- หมวดหมู่คำแนะนำ: หลาย

Wizard_evol_instruct_70k 2023-5 | ทั้งหมด | en | MC | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Microsoft และคณะ

- ขนาด: 70k อินสแตนซ์

- ใบอนุญาต: -

- ที่มา: พัฒนาคำแนะนำผ่านวิธีการพัฒนา

- หมวดหมู่คำแนะนำ: หลาย

Wildchat 2024-5 | บางส่วน มัลติ | MC | กระดาษ | ชุดข้อมูล

- สำนักพิมพ์: Cornell University และคณะ

- ขนาด: 1039785 อินสแตนซ์

- ใบอนุญาต: ใบอนุญาตผลกระทบ AI2

- ที่มา: การสนทนาระหว่างผู้ใช้และ chatgpt, GPT-4

- หมวดหมู่คำแนะนำ: หลาย

การรวบรวมและปรับปรุงชุดข้อมูลที่มีอยู่ (CI)

CrossFit 2021-4 | ทั้งหมด | en | CI | กระดาษ | คนอื่น ๆ

- สำนักพิมพ์: มหาวิทยาลัยเซาเทิร์นแคลิฟอร์เนีย

- ขนาด: 269 ชุดข้อมูล

- ใบอนุญาต: -

- ที่มา: การรวบรวมและปรับปรุงชุดข้อมูล NLP ต่างๆ

- หมวดหมู่คำแนะนำ: หลาย

Dialogstudio 2023-7 | ทั้งหมด | en | CI | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Salesforce AI และคณะ

- ขนาด: 87 ชุดข้อมูล

- ใบอนุญาต: Apache-2.0

- ที่มา: การรวบรวมและปรับปรุงชุดข้อมูล NLP ต่างๆ

- หมวดหมู่คำแนะนำ: หลาย

Dynosaur 2023-5 | ทั้งหมด | en | CI | กระดาษ | GitHub | ชุดข้อมูล เว็บไซต์

- สำนักพิมพ์: UCLA และคณะ

- ขนาด: 801900 อินสแตนซ์

- ใบอนุญาต: Apache-2.0

- ที่มา: การรวบรวมและปรับปรุงชุดข้อมูล NLP ต่างๆ

- หมวดหมู่คำแนะนำ: หลาย

Flan-Mini 2023-7 | ทั้งหมด | en | CI | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: มหาวิทยาลัยเทคโนโลยีและการออกแบบสิงคโปร์

- ขนาด: อินสแตนซ์ 1.34m

- ใบอนุญาต: CC

- ที่มา: การรวบรวมและปรับปรุงชุดข้อมูลการปรับแต่งการเรียนการสอนที่หลากหลาย

- หมวดหมู่คำแนะนำ: หลาย

Flan 2021 2021-9 | ทั้งหมด | มัลติ | CI | กระดาษ | คนอื่น ๆ

- สำนักพิมพ์: Google Research

- ขนาด: 62 ชุดข้อมูล

- ใบอนุญาต: Apache-2.0

- ที่มา: การรวบรวมและปรับปรุงชุดข้อมูล NLP ต่างๆ

- หมวดหมู่คำแนะนำ: หลาย

Flan 2022 2023-1 | บางส่วน มัลติ | CI | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Google Research

- ขนาด: ชุดข้อมูล 1836

- ใบอนุญาต: Apache-2.0

- ที่มา: การรวบรวมและปรับปรุงชุดข้อมูลการปรับแต่งการเรียนการสอนที่หลากหลาย

- หมวดหมู่คำแนะนำ: หลาย

InstressDial 2022-5 | ทั้งหมด | en | CI | กระดาษ | คนอื่น ๆ

- สำนักพิมพ์: Carnegie Mellon University

- ขนาด: 59 ชุดข้อมูล

- ใบอนุญาต: Apache-2.0

- ที่มา: การรวบรวมและปรับปรุงชุดข้อมูล NLP ต่างๆ

- หมวดหมู่คำแนะนำ: หลาย

คำแนะนำจากธรรมชาติ 2021-4 | ทั้งหมด | en | CI | กระดาษ | GitHub | ชุดข้อมูล

- สำนักพิมพ์: Allen Institute สำหรับ AI และคณะ

- ขนาด: 61 ชุดข้อมูล

- ใบอนุญาต: Apache-2.0

- ที่มา: การรวบรวมและปรับปรุงชุดข้อมูล NLP ต่างๆ

- หมวดหมู่คำแนะนำ: หลาย

OIG 2023-3 | ทั้งหมด | en | CI | ชุดข้อมูล

- สำนักพิมพ์: Laion

- ขนาด: 3878622 อินสแตนซ์

- ใบอนุญาต: Apache-2.0

- ที่มา: การรวบรวมและปรับปรุงชุดข้อมูลต่างๆ

- หมวดหมู่คำแนะนำ: หลาย

Open-platypus 2023-8 | ทั้งหมด | en | CI | กระดาษ | GitHub | ชุดข้อมูล เว็บไซต์

- สำนักพิมพ์: มหาวิทยาลัยบอสตัน

- ขนาด: 24926 อินสแตนซ์

- ใบอนุญาต: -

- ที่มา: การรวบรวมและปรับปรุงชุดข้อมูลต่างๆ

- หมวดหมู่คำแนะนำ: หลาย

Bench Opt-Iml 2022-12 | ไม่ใช่ | มัลติ | CI | กระดาษ | คนอื่น ๆ

- สำนักพิมพ์: Meta AI

- ขนาด: ชุดข้อมูล 2000

- ใบอนุญาต: MIT

- ที่มา: การรวบรวมและปรับปรุงชุดข้อมูล NLP ต่างๆ

- หมวดหมู่คำแนะนำ: หลาย

Promptsource 2022-2 | All | EN | CI | Paper | คนอื่น ๆ

- Publisher: Brown University et al.

- Size: 176 datasets

- License: Apache-2.0

- Source: Collection and improvement of various NLP datasets

- Instruction Category: Multi

SUPER-NATURAL INSTRUCTIONS 2022-4 | All | Multi | CI | Paper | คนอื่น ๆ

- Publisher: Univ. of Washington et al.

- Size: 1616 datasets

- License: Apache-2.0

- Source: Collection and improvement of various NLP datasets

- Instruction Category: Multi

T0 2021-10 | All | EN | CI | Paper | Dataset1 | Dataset2

- Publisher: Hugging Face et al.

- Size: 62 datasets

- License: Apache-2.0

- Source: Collection and improvement of various NLP datasets

- Instruction Category: Multi

UnifiedSKG 2022-3 | All | EN | CI | Paper | คนอื่น ๆ

- Publisher: The University of Hong Kong et al.

- Size: 21 datasets

- License: Apache-2.0

- Source: Collection and improvement of various NLP datasets

- Instruction Category: Multi

xP3 2022-11 | All | Multi (46) | CI | Paper | คนอื่น ๆ

- Publisher: Hugging Face et al.

- Size: 82 datasets

- License: Apache-2.0

- Source: Collection and improvement of various NLP datasets

- Instruction Category: Multi

IEPile 2024-2 | All | EN & ZH | CI | Paper | Github | ชุดข้อมูล

- Publisher: Zhejiang University et al.

- Size: 33 datasets

- License: CC-BY-NC-SA-4.0

- Source: Collection and improvement of various IE datasets

- Instruction Category: Extraction

KOLLM-Conversations 2024-3 | All | KO | CI | ชุดข้อมูล

- Publisher: davidkim205

- Size: 1122566 instances

- License: Apache-2.0

- Source: Collection and improvement of Korean datasets

- Instruction Category: Multi

HG & CI

Firefly 2023-4 | All | ZH | HG & CI | Github | ชุดข้อมูล

- Publisher: YeungNLP

- Size: 1649399 instances

- ใบอนุญาต: -

- Source: Collect Chinese NLP datasets and manually generate data related to Chinese culture

- Instruction Category: Multi

LIMA-sft 2023-5 | All | EN | HG & CI | Paper | ชุดข้อมูล

- Publisher: Meta AI et al.

- Size: 1330 instances

- License: CC-BY-NC-SA

- Source: Manually select from various types of data

- Instruction Category: Multi

COIG-CQIA 2024-3 | All | ZH | HG & CI | Paper | ชุดข้อมูล

- Publisher: Shenzhen Institute of Advanced Technology et al.

- Size: 48375 instances

- ใบอนุญาต: -

- Source: Q&A communities, Wikipedia, examinations, existing NLP datasets

- Instruction Category: Multi

HG & MC

- InstructGPT-sft 2022-3 | Not | EN | HG & MC | กระดาษ

- Publisher: OpenAI

- Size: 14378 instances

- ใบอนุญาต: -

- Source: Platform Q&A data and manual labeling

- Instruction Category: Multi

CI & MC

Alpaca_GPT4_data 2023-4 | All | EN | CI & MC | Paper | คนอื่น ๆ

- Publisher: Microsoft Research

- Size: 52K instances

- License: Apache-2.0

- Source: Generated by GPT-4 with Aplaca_data prompts

- Instruction Category: Multi

Alpaca_GPT4_data_zh 2023-4 | All | ZH | CI & MC | Github | ชุดข้อมูล

- Publisher: Microsoft Research

- Size: 52K instances

- License: Apache-2.0

- Source: Generated by GPT-4 with Alpaca_data prompts translated into Chinese by ChatGPT

- Instruction Category: Multi

Bactrain-X 2023-5 | All | Multi (52) | CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: MBZUAI

- Size: 3484884 instances

- License: CC-BY-NC-4.0

- Source: Generated by GPT-3.5-Turbo with Aplaca_data and databricks-dolly-15K prompts translated into 51 languages by Google Translate API

- Instruction Category: Multi

Baize 2023-3 | Partial | EN | CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: University of California et al.

- Size: 210311 instances

- License: GPL-3.0

- Source: Sample seeds from specific datasets to create multi-turn dialogues using ChatGPT

- Instruction Category: Multi

GPT4All 2023-3 | All | EN | CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: nomic-ai

- Size: 739259 instances

- License: MIT

- Source: Generated by GPT-3.5-Turbo with other datasets' prompts

- Instruction Category: Multi

GuanacoDataset 2023-3 | All | Multi | CI & MC | Dataset | เว็บไซต์

- Publisher: JosephusCheung

- Size: 534530 instances

- License: GPL-3.0

- Source: Expand upon the initial 52K dataset from the Alpaca model

- Instruction Category: Multi

LaMini-LM 2023-4 | All | EN | CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: Monash University et al.

- Size: 2585615 instances

- License: CC-BY-NC-4.0

- Source: Generated by ChatGPT with synthetic and existing prompts

- Instruction Category: Multi

LogiCoT 2023-5 | All | EN & ZH | CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: Westlake University et al.

- Size: 604840 instances

- License: CC-BY-NC-ND-4.0

- Source: Expand the datasets using GPT-4

- Instruction Category: Reasoning

LongForm 2023-4 | All | EN | CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: LMU Munich et al.

- Size: 27739 instances

- License: MIT

- Source: Select documents from existing corpora and generating prompts for the documents using LLMs

- Instruction Category: Multi

Luotuo-QA-B 2023-5 | All | EN & ZH | CI & MC | Github | ชุดข้อมูล

- Publisher: Luotuo

- Size: 157320 instances

- License: Apache-2.0 & CC0

- Source: Use LLMs to generate Q&A pairs on CSL, arXiv, and CNN-DM datasets

- Instruction Category: Multi

OpenOrca 2023-6 | All | Multi | CI & MC | Paper | ชุดข้อมูล

- Publisher: Microsoft Researc

- Size: 4233923 instances

- License: MIT

- Source: Expand upon the Flan 2022 dataset using GPT-3.5-Turbo and GPT-4

- Instruction Category: Multi

Wizard_evol_instruct_zh 2023-5 | All | ZH | CI & MC | Github | ชุดข้อมูล

- Publisher: Central China Normal University et al.

- Size: 70K instances

- License: CC-BY-4.0

- Source: Generated by GPT with Wizard_evol_instruct prompts translated into Chinese

- Instruction Category: Multi

Lithuanian-QA-v1 2024-8 | All | LT | CI & MC | Paper | ชุดข้อมูล

- Publisher: Neurotechnology

- Size: 13848 instances

- License: CC-BY-4.0

- Source: Use ChatGPT to generate Q&A pairs on Wikipedia corpus

- Instruction Category: Multi

LongWriter-6K 2024-8 | All | EN & ZH | CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: Tsinghua University et al.

- Size: 6000 instances

- License: Apache-2.0

- Source: Generated by GPT-4o with open-source datasets' prompts

- Instruction Category: Multi

HG & CI & MC

COIG 2023-4 | All | ZH | HG & CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: BAAI

- Size: 191191 instances

- License: Apache-2.0

- Source: Translated instructions, Leetcode, Chinese exams, etc.

- Instruction Category: Multi

HC3 2023-1 | All | EN & ZH | HG & CI & MC | Paper | Github | Dataset1 | Dataset2

- Publisher: SimpleAI

- Size: 37175 instances

- License: CC-BY-SA-4.0

- Source: Human-Q&A pairs and ChatGPT-Q&A pairs from Q&A platforms, encyclopedias, etc.

- Instruction Category: Multi

Phoenix-sft-data-v1 2023-5 | All | Multi | HG & CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: The Chinese University of Hong Kong et al.

- Size: 464510 instances

- License: CC-BY-4.0

- Source: Collected multi-lingual instructions, post-translated multi-lingual instructions, self-generated user-centered multi-lingual instructions

- Instruction Category: Multi

TigerBot_sft_en 2023-5 | Partial | EN | HG & CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: TigerBot

- Size: 677117 instances

- License: Apache-2.0

- Source: Self-instruct, human-labeling, open-source data cleaning

- Instruction Category: Multi

TigerBot_sft_zh 2023-5 | Partial | ZH | HG & CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: TigerBot

- Size: 530705 instances

- License: Apache-2.0

- Source: Self-instruct, human-labeling, open-source data cleaning

- Instruction Category: Multi

Aya Collection 2024-2 | All | Multi (114) | HG & CI & MC | Paper | Dataset | เว็บไซต์

- Publisher: Cohere For AI Community et al.

- Size: 513M instances

- License: Apache-2.0

- Source: Templated data, Translated data and Aya Dataset

- Instruction Category: Multi

REInstruct 2024-8 | Not | EN | HG & CI & MC | Paper | คนอื่น ๆ

- Publisher: Chinese Information Processing Laboratory et al.

- Size: 35K instances

- ใบอนุญาต: -

- Source: Automatically constructing instruction data from the C4 corpus using a small amount of manually annotated seed instruction data

- Instruction Category: Multi

Domain-specific Instruction Fine-tuning Datasets

The domain-specific instruction fine-tuning datasets are constructed for a particular domain by formulating instructions that encapsulate knowledge and task types closely related to that domain.

Dataset information format:

- Dataset name Release Time | Public or Not | Language | Construction Method | Paper | Github | Dataset | Website

- Publisher:

- Size:

- License:

- Source:

- Instruction Category:

- Domain:

ทางการแพทย์

ChatDoctor 2023-3 | All | EN | HG & MC | Paper | Github | ชุดข้อมูล

- Publisher: University of Texas Southwestern Medical Center et al.

- Size: 115K instances

- License: Apache-2.0

- Source: Real conversations between doctors and patients & Generated by ChatGPT

- Instruction Category: Multi

- Domain: Medical

ChatMed_Consult_Dataset 2023-5 | All | ZH | MC | Github | ชุดข้อมูล

- Publisher: michael-wzhu

- Size: 549326 instances

- License: CC-BY-NC-4.0

- Source: Generated by GPT-3.5-Turbo

- Instruction Category: Multi

- Domain: Medical

CMtMedQA 2023-8 | All | ZH | HG | Paper | Github | ชุดข้อมูล

- Publisher: Zhengzhou University

- Size: 68023 instances

- License: MIT

- Source: Real conversations between doctors and patients

- Instruction Category: Multi

- Domain: Medical

DISC-Med-SFT 2023-8 | All | ZH | HG & CI | Paper | Github | Dataset | เว็บไซต์

- Publisher: Fudan University et al.

- Size: 464898 instances

- License: Apache-2.0

- Source: Open source datasets & Manually selected data

- Instruction Category: Multi

- Domain: Medical

HuatuoGPT-sft-data-v1 2023-5 | All | ZH | HG & MC | Paper | Github | ชุดข้อมูล

- Publisher: The Chinese University of Hong Kong et al.

- Size: 226042 instances

- License: Apache-2.0

- Source: Real conversations between doctors and patients & Generated by ChatGPT

- Instruction Category: Multi

- Domain: Medical

Huatuo-26M 2023-5 | Partial | ZH | CI | Paper | คนอื่น ๆ

- Publisher: The Chinese University of Hong Kong et al.

- Size: 26504088 instances

- License: Apache-2.0

- Source: Collection and improvement of various datasets

- Instruction Category: Multi

- Domain: Medical

MedDialog 2020-4 | All | EN & ZH | HG | Paper | คนอื่น ๆ

- Publisher: UC San Diego

- Size: 3.66M instances

- ใบอนุญาต: -

- Source: Real conversations between doctors and patients

- Instruction Category: Multi

- Domain: Medical

Medical Meadow 2023-4 | All | EN | HG & CI | Paper | Github | ชุดข้อมูล

- Publisher: University Hospital Aachen et al.

- Size: 160076 instances

- License: GPL-3.0

- Source: Crawl data from the Internet & Collection and improvement of various NLP datasets

- Instruction Category: Multi

- Domain: Medical

Medical-sft 2023-5 | All | EN & ZH | CI | Github | ชุดข้อมูล

- Publisher: Ming Xu

- Size: 2.07M instances

- License: Apache-2.0

- Source: Collection and improvement of various NLP datasets

- Instruction Category: Multi

- Domain: Medical

QiZhenGPT-sft-20k 2023-5 | Partial | ZH | CI | Github | ชุดข้อมูล

- Publisher: Zhejiang University

- Size: 20K instances

- License: GPL-3.0

- Source: Collection and improvement of various datasets

- Instruction Category: Multi

- Domain: Medical

ShenNong_TCM_Dataset 2023-6 | All | ZH | MC | Github | ชุดข้อมูล

- Publisher: michael-wzhu

- Size: 112565 instances

- License: Apache-2.0

- Source: Generated by ChatGPT

- Instruction Category: Multi

- Domain: Medical

รหัส

Code_Alpaca_20K 2023-3 | All | EN & PL | MC | Github | ชุดข้อมูล

- Publisher: Sahil Chaudhary

- Size: 20K instances

- License: Apache-2.0

- Source: Generated by Text-Davinci-003

- Instruction Category: Code

- Domain: Code

CodeContest 2022-3 | All | EN & PL | CI | Paper | คนอื่น ๆ

- Publisher: DeepMind

- Size: 13610 instances

- License: Apache-2.0

- Source: Collection and improvement of various datasets

- Instruction Category: Code

- Domain: Code

CommitPackFT 2023-8 | All | EN & PL (277) | HG | Paper | Github | ชุดข้อมูล

- Publisher: Bigcode

- Size: 702062 instances

- License: MIT

- Source: GitHub Action dump

- Instruction Category: Code

- Domain: Code

ToolAlpaca 2023-6 | All | EN & PL | HG & MC | Paper | คนอื่น ๆ

- Publisher: Chinese Information Processing Laboratory et al.

- Size: 3928 instances

- License: Apache-2.0

- Source: Manually filter APIs & Generated by ChatGPT

- Instruction Category: Code

- Domain: Code

ToolBench 2023-7 | All | EN & PL | HG & MC | Paper | คนอื่น ๆ

- Publisher: Tsinghua University et al.

- Size: 126486 instances

- License: Apache-2.0

- Source: Manually filter APIs & Generated by ChatGPT

- Instruction Category: Code

- Domain: Code

ถูกกฎหมาย

DISC-Law-SFT 2023-9 | Partial | ZH | HG & CI & MC | Paper | Github | เว็บไซต์

- Publisher: Fudan University et al.

- Size: 403K instances

- License: Apache-2.0

- Source: Open source datasets & Legal-related Text Content & Generated by GPT-3.5-Turbo

- Instruction Category: Multi

- Domain: Law

HanFei 1.0 2023-5 | All | ZH | - Github | ชุดข้อมูล

- Publisher: Chinese Academy of Sciences et al.

- Size: 255K instances

- License: Apache-2.0

- Source: Filter legal-related data according to rules

- Instruction Category: Multi

- Domain: Law

LawGPT_zh 2023-5 | Partial | ZH | CI & MC | Github | ชุดข้อมูล

- Publisher: Shanghai Jiao Tong University

- Size: 200K instances

- ใบอนุญาต: -

- Source: Real conversations & Generated by ChatGPT

- Instruction Category: Multi

- Domain: Law

Lawyer LLaMA_sft 2023-5 | Partial | ZH | CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: Peking Universit

- Size: 21476 instances

- License: Apache-2.0

- Source: Generated by ChatGPT with other datasets' prompts

- Instruction Category: Multi

- Domain: Law

คณิตศาสตร์

BELLE_School_Math 2023-5 | All | ZH | MC | Github | ชุดข้อมูล

- Publisher: BELLE

- Size: 248481 instances

- License: GPL-3.0

- Source: Generated by ChatGPT

- Instruction Category: Math

- Domain: Math

Goat 2023-5 | All | EN | HG | Paper | Github | ชุดข้อมูล

- Publisher: National University of Singapore

- Size: 1746300 instances

- License: Apache-2.0

- Source: Artificially synthesized data

- Instruction Category: Math

- Domain: Math

MWP 2021-9 | All | EN & ZH | CI | Paper | Github | ชุดข้อมูล

- Publisher: Xihua University et al.

- Size: 251598 instances

- License: MIT

- Source: Collection and improvement of various datasets

- Instruction Category: Math

- Domain: Math

OpenMathInstruct-1 2024-2 | All | EN | CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: NVIDIA

- Size: 1.8M instances

- License: NVIDIA License

- Source: GSM8K and MATH datasets (original questions); Generated using Mixtral-8×7B model

- Instruction Category: Math

- Domain: Math

การศึกษา

Child_chat_data 2023-8 | All | ZH | HG & MC | คนอื่น ๆ

- Publisher: Harbin Institute of Technology et al.

- Size: 5000 instances

- ใบอนุญาต: -

- Source: Real conversations & Generated by GPT-3.5-Turbo

- Instruction Category: Multi

- Domain: Education

Educhat-sft-002-data-osm 2023-7 | All | EN & ZH | CI | Paper | Github | ชุดข้อมูล

- Publisher: East China Normal University et al.

- Size: 4279419 instances

- License: CC-BY-NC-4.0

- Source: Collection and improvement of various datasets

- Instruction Category: Multi

- Domain: Education

TaoLi_data 2023-X | All | ZH | HG & CI | Github | ชุดข้อมูล

- Publisher: Beijing Language and Culture University et al.

- Size: 88080 instances

- License: Apache-2.0

- Source: Collection and improvement of various datasets & Manually extract dictionary data

- Instruction Category: Multi

- Domain: Education

อื่น

DISC-Fin-SFT 2023-10 | Partial | ZH | HG & CI & MC | Paper | Github | เว็บไซต์

- Publisher: Fudan University et al.

- Size: 246K instances

- License: Apache-2.0

- Source: Open source datasets & Manually collect financial data & ChatGPT assistance

- Instruction Category: Multi

- Domain: Financial

AlphaFin 2024-3 | All | EN & ZH | HG & CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: South China University of Technology et al.

- Size: 167362 instances

- License: Apache-2.0

- Source: Traditional research datasets, real-time financial data, handwritten CoT data

- Instruction Category: Multi

- Domain: Financial

GeoSignal 2023-6 | Partial | EN | HG & CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: Shanghai Jiao Tong University et al.

- Size: 22627272 instances

- License: Apache-2.0

- Source: Open source datasets & Geoscience-related Text Content & Generated by GPT-4

- Instruction Category: Multi

- Domain: Geoscience

MeChat 2023-4 | All | ZH | CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: Zhejiang University et al.

- Size: 56K instances

- License: CC0-1.0

- Source: Based on PsyQA dataset with the proposed SMILE method

- Instruction Category: Multi

- Domain: Mental Health

Mol-Instructions 2023-6 | All | EN | HG & CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: Zhejiang University et al.

- Size: 2043586 instances

- License: CC-BY-4.0

- Source: Molecule-oriented, Protein-oriented, Biomolecular text instructions

- Instruction Category: Multi

- Domain: Biology

Owl-Instruction 2023-9 | All | EN & ZH | HG & MC | Paper | คนอื่น ๆ

- Publisher: Beihang University et al.

- Size: 17858 instances

- ใบอนุญาต: -

- Source: Generated by GPT-4 & Manual verification

- Instruction Category: Multi

- Domain: IT

PROSOCIALDIALOG 2022-5 | All | EN | HG & MC | Paper | ชุดข้อมูล

- Publisher: Allenai

- Size: 165681 instances

- License: CC-BY-4.0

- Source: Generated by humans with GPT-3 created prompts

- Instruction Category: Social Norms

- Domain: Social Norms

TransGPT-sft 2023-7 | All | ZH | HG | Github | ชุดข้อมูล

- Publisher: Beijing Jiaotong University

- Size: 58057 instances

- License: Apache-2.0

- Source: Manually collect traffic-related data

- Instruction Category: Multi

- Domain: Transportation

Preference Datasets

Preference datasets are collections of instructions that provide preference evaluations for multiple responses to the same instruction input.

Preference Evaluation Methods

The preference evaluation methods for preference datasets can be categorized into voting, sorting, scoring, and other methods. Datasets are classified based on preference evaluation methods.

Dataset information format:

- Dataset name Release Time | Public or Not | Language | Construction Method | Paper | Github | Dataset | Website

- Publisher:

- Size:

- License:

- Domain:

- Instruction Category:

- Preference Evaluation Method:

- Source:

ลงคะแนนเสียง

Chatbot_arena_conversations 2023-6 | All | Multi | HG & MC | Paper | ชุดข้อมูล

- Publisher: UC Berkeley et al.

- Size: 33000 instances

- License: CC-BY-4.0 & CC-BY-NC-4.0

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: VO-H

- Source: Generated by twenty LLMs & Manual judgment

hh-rlhf 2022-4 | All | EN | HG & MC | Paper1 | Paper2 | Github | ชุดข้อมูล

- Publisher: Anthropic

- Size: 169352 instances

- License: MIT

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: VO-H

- Source: Generated by LLMs & Manual judgment

MT-Bench_human_judgments 2023-6 | All | EN | HG & MC | Paper | Github | Dataset | เว็บไซต์

- Publisher: UC Berkeley et al.

- Size: 3.3K instances

- License: CC-BY-4.0

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: VO-H

- Source: Generated by LLMs & Manual judgment

PKU-SafeRLHF 2023-7 | Partial | EN | HG & CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: Peking University

- Size: 361903 instances

- License: CC-BY-NC-4.0

- Domain: Social Norms

- Instruction Category: Social Norms

- Preference Evaluation Method: VO-H

- Source: Generated by LLMs & Manual judgment

SHP 2021-10 | All | EN | HG | Paper | Github | ชุดข้อมูล

- Publisher: Stanford

- Size: 385563 instances

- ใบอนุญาต: -

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: VO-H

- Source: Reddit data & Manual judgment

Zhihu_rlhf_3k 2023-4 | All | ZH | HG | ชุดข้อมูล

- Publisher: Liyucheng

- Size: 3460 instances

- License: CC-BY-2.0

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: VO-H

- Source: Zhihu data & Manual judgment

Summarize_from_Feedback 2020-9 | All | EN | HG & CI | Paper | ชุดข้อมูล

- Publisher: OpenAI

- Size: 193841 instances

- ใบอนุญาต: -

- Domain: News

- Instruction Category: Multi

- Preference Evaluation Method: VO-H & SC-H

- Source: Open source datasets & Manual judgment and scoring

CValues 2023-7 | All | ZH | MC | Paper | Github | ชุดข้อมูล

- Publisher: Alibaba Group

- Size: 145K instances

- License: Apache-2.0

- Domain: Social Norms

- Instruction Category: Social Norms

- Preference Evaluation Method: VO-M

- Source: Generated by LLMs & Evaluation by the reward model

huozi_rlhf_data 2024-2 | All | ZH | HG & MC | Github | ชุดข้อมูล

- Publisher: Huozi-Team

- Size: 16918 instances

- License: Apache-2.0

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: VO-H

- Source: Generated by Huozi model & Manual judgment

เรียงลำดับ

- OASST1_pairwise_rlhf_reward 2023-5 | All | Multi | CI | ชุดข้อมูล

- Publisher: Tasksource

- Size: 18918 instances

- License: Apache-2.0

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: SO-H

- Source: OASST1 datasets & Manual sorting

คะแนน

Stack-Exchange-Preferences 2021-12 | All | EN | HG | Paper | ชุดข้อมูล

- Publisher: Anthropic

- Size: 10807695 instances

- License: CC-BY-SA-4.0

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: SC-H

- Source: Stackexchange data & Manual scoring

WebGPT 2021-12 | All | EN | HG & CI | Paper | ชุดข้อมูล

- Publisher: OpenAI

- Size: 19578 instances

- ใบอนุญาต: -

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: SC-H

- Source: Open source datasets & Manual scoring

Alpaca_comparison_data 2023-3 | All | EN | MC | คนอื่น ๆ

- Publisher: Stanford Alpaca

- Size: 51K instances

- License: Apache-2.0

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: SC-M

- Source: Generated by three LLMs & GPT-4 scoring

Stable_Alignment 2023-5 | All | EN | MC | Paper | คนอื่น ๆ

- Publisher: Dartmouth College et al.

- Size: 169K instances

- License: Apache-2.0

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: SC-M

- Source: Generated by LLMs & Model scoring

UltraFeedback 2023-10 | All | EN | CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: Tsinghua University et al.

- Size: 63967 instances

- License: MIT

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: SC-M

- Source: Generated by seventeen LLMs & Model scoring

OpenHermesPreferences 2024-2 | All | EN | CI & MC | ชุดข้อมูล

- Publisher: Argilla et al.

- Size: 989490 instances

- ใบอนุญาต: -

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: SO-M

- Source: OpenHermes-2.5 dataset & Model sorting

HelpSteer 2023-11 | All | EN | HG & CI & MC | Paper | ชุดข้อมูล

- Publisher: NVIDIA

- Size: 37120 instances

- License: CC-BY-4.0

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: SC-H

- Source: Generated by LLMs & Manual judgment

HelpSteer2 2024-6 | All | EN | HG & CI & MC | Paper | Github | ชุดข้อมูล

- Publisher: NVIDIA

- Size: 21362 instances

- License: CC-BY-4.0

- Domain: General

- Instruction Category: Multi

- Preference Evaluation Method: SC-H

- Source: Generated by LLMs & Manual judgment

อื่น

Evaluation Datasets

Evaluation datasets are a carefully curated and annotated set of data samples used to assess the performance of LLMs across various tasks. Datasets are classified based on evaluation domains.

Dataset information format:

- Dataset name Release Time | Public or Not | Language | Construction Method | Paper | Github | Dataset | Website

- Publisher:

- Size:

- License:

- Question Type:

- Evaluation Method:

- Focus:

- Numbers of Evaluation Categories/Subcategories:

- Evaluation Category:

ทั่วไป

AlpacaEval 2023-5 | All | EN | CI & MC | Paper | Github | Dataset | เว็บไซต์

- Publisher: Stanford et al.

- Size: 805 instances

- License: Apache-2.0

- Question Type: SQ

- Evaluation Method: ME

- Focus: The performance on open-ended question answering

- Numbers of Evaluation Categories/Subcategories: 1/-

- Evaluation Category: Open-ended question answering

BayLing-80 2023-6 | All | EN & ZH | HG & CI | Paper | Github | ชุดข้อมูล

- Publisher: Chinese Academy of Sciences

- Size: 320 instances

- License: GPL-3.0

- Question Type: SQ

- Evaluation Method: ME

- Focus: Chinese-English language proficiency and multimodal interaction skills

- Numbers of Evaluation Categories/Subcategories: 9/-

- Evaluation Category: Writing, Roleplay, Common-sense, Fermi, Counterfactual, Coding, Math, Generic, Knowledge

BELLE_eval 2023-4 | All | ZH | HG & MC | Paper | คนอื่น ๆ

- Publisher: BELLE

- Size: 1000 instances

- License: Apache-2.0

- Question Type: SQ

- Evaluation Method: ME

- Focus: The performance of Chinese language models in following instructions

- Numbers of Evaluation Categories/Subcategories: 9/-

- Evaluation Category: Extract, Closed qa, Rewrite, Summarization, Generation, Classification, Brainstorming, Open qa, Others

CELLO 2023-9 | All | EN | HG | Paper | คนอื่น ๆ

- Publisher: Fudan University et al.

- Size: 523 instances

- ใบอนุญาต: -

- Question Type: SQ

- Evaluation Method: CE

- Focus: The ability of LLMs to understand complex instructions

- Numbers of Evaluation Categories/Subcategories: 2/10

- Evaluation Category: Complex task description, Complex input

MT-Bench 2023-6 | All | EN | HG | Paper | Github | เว็บไซต์

- Publisher: UC Berkeley et al.

- Size: 80 instances

- License: Apache-2.0

- Question Type: SQ

- Evaluation Method: ME

- Focus: The performance on open-ended question answering

- Numbers of Evaluation Categories/Subcategories: 8/-

- Evaluation Category: Writing, Roleplay, Reasoning, Math, Coding, Extraction, STEM, Humanities

SuperCLUE 2023-7 | Not | ZH | HG & MC | Paper | Github | Website1 | Website2

- Publisher: CLUE et al.

- Size: 3754 instances

- ใบอนุญาต: -

- Question Type: Multi

- Evaluation Method: HE & CE

- Focus: The performance in a Chinese context

- Numbers of Evaluation Categories/Subcategories: 2/-

- Evaluation Category: Open multi-turn open questions, OPT objective questions

Vicuna Evaluation 2023-3 | All | EN | HG | Github | Dataset | เว็บไซต์

- Publisher: LMSYS ORG

- Size: 80 instances

- License: Apache-2.0

- Question Type: SQ

- Evaluation Method: ME

- Focus: The performance on open-ended question answering

- Numbers of Evaluation Categories/Subcategories: 9/-

- Evaluation Category: Generic, Knowledge, Roleplay, Common-sense, Fermi, Counterfactual, Coding, Math, Writing

CHC-Bench 2024-4 | All | ZH | HG & CI | Paper | Github | Dataset | เว็บไซต์

- Publisher: Multimodal Art Projection Research Community et al.

- Size: 214 instances

- License: Apache-2.0

- Question Type: Multi

- Evaluation Method: ME

- Focus: Hard-case Chinese instructions understanding and following

- Numbers of Evaluation Categories/Subcategories: 8/-

- Evaluation Category: Writing, Humanity, Science, Role-playing, Reading Comprehension, Math, Hard Cases, Coding

CIF-Bench 2024-2 | Partial | ZH | HG & CI | Paper | Github | เว็บไซต์

- Publisher: University of Manchester et al.

- Size: 15K instances

- ใบอนุญาต: -

- Question Type: SQ

- Evaluation Method: CE & ME

- Focus: Evaluate the zero-shot generalizability of LLMs to the Chinese language

- Numbers of Evaluation Categories/Subcategories: 10/150

- Evaluation Category: Chinese culture, Classification, Code, Commonsense, Creative NLG, Evaluation, Grammar, Linguistic, Motion detection, NER

WildBench 2024-6 | All | EN | HG & CI | Paper | Github | Dataset | เว็บไซต์

- Publisher: Allen Institute for AI et al.

- Size: 1024 instances

- License: AI2 ImpACT License

- Question Type: SQ

- Evaluation Method: ME

- Focus: An automated evaluation framework designed to benchmark LLMs using challenging, real-world user queries.

- Numbers of Evaluation Categories/Subcategories: 11/-

- Evaluation Category: Information seeking, Coding & Debugging, Creative writing, Reasoning, Planning, Math, Editing, Data analysis, Role playing, Brainstorming, Advice seeking

SysBench 2024-8 | All | EN | HG | Paper | Github | ชุดข้อมูล

- Publisher: Peking University et al.

- Size: 500 instances

- ใบอนุญาต: -

- Question Type: SQ

- Evaluation Method: ME

- Focus: Systematically analyze system message following ability

- Numbers of Evaluation Categories/Subcategories: 3/-

- Evaluation Category: Constraint complexity, Instruction misalignment, Multi-turn stability

การสอบ

AGIEval 2023-4 | All | EN & ZH | HG & CI | Paper | Github | ชุดข้อมูล

- Publisher: Microsoft

- Size: 8062 instances

- License: MIT

- Question Type: OQ

- Evaluation Method: CE

- Focus: Human-centric standardized exams

- Numbers of Evaluation Categories/Subcategories: 7/20

- Evaluation Category: Gaokao, SAT, JEC, LSAT, LogiQA, AQuA-RAT, Math

GAOKAO-Bench 2023-5 | All | ZH | HG | Paper | คนอื่น ๆ

- Publisher: Fudan University et al.

- Size: 2811 instances

- License: Apache-2.0

- Question Type: Multi

- Evaluation Method: HE & CE

- Focus: Chinese Gaokao examination

- Numbers of Evaluation Categories/Subcategories: 10/-

- Evaluation Category: Chinese, Mathematics (2 categories), English, Physics, Chemistry, Biology, Politics, History, Geography

M3Exam 2023-6 | All | Multi (9) | HG | Paper | คนอื่น ๆ

- Publisher: Alibaba Group et al.

- Size: 12317 instances

- ใบอนุญาต: -

- Question Type: OQ

- Evaluation Method: CE

- Focus: The comprehensive abilities in a multilingual and multilevel context using real human exam questions

- Numbers of Evaluation Categories/Subcategories: 3/-

- Evaluation Category: Low, Mid, High

เรื่อง

ARB 2023-7 | All | EN | CI | Paper | คนอื่น ๆ

- Publisher: DuckAI et al.

- Size: 1207 instances

- License: MIT

- Question Type: Multi

- Evaluation Method: HE & ME

- Focus: Advanced reasoning problems in multiple fields

- Numbers of Evaluation Categories/Subcategories: 5/-

- Evaluation Category: Mathematics, Physics, Law, MCAT(Reading), MCAT(Science)

C-CLUE 2021-8 | All | ZH | HG | Github | เว็บไซต์

- Publisher: Tianjin University

- ขนาด: -

- License: CC-BY-SA-4.0

- Question Type: SQ

- Evaluation Method: CE

- Focus: Classical Chinese language understanding

- Numbers of Evaluation Categories/Subcategories: 2/-

- Evaluation Category: Named entity recognition, Relation extraction

C-Eval 2023-5 | All | ZH | HG & MC | Paper | Github | Dataset | เว็บไซต์

- Publisher: Shanghai Jiao Tong University

- Size: 13948 instances

- License: CC-BY-NC-SA-4.0

- Question Type: OQ

- Evaluation Method: CE

- Focus: The advanced knowledge and reasoning abilities in a Chinese context

- Numbers of Evaluation Categories/Subcategories: 4/52

- Evaluation Category: STEM, Social Science, Humanity, Other

CG-Eval 2023-8 | All | ZH | HG | Paper | Github | Dataset | เว็บไซต์

- Publisher: LanguageX AI Lab et al.

- Size: 11000 instances

- License: CC-BY-SA-4.0

- Question Type: SQ

- Evaluation Method: CE

- Focus: The generation capabilities of LLMs across various academic disciplines

- Numbers of Evaluation Categories/Subcategories: 6/55

- Evaluation Category: Science and engineering, Humanities and social sciences, Mathematical calculations, Medical practitioner qualification Examination, Judicial Examination, Certfied public accountant examination

LLMEVAL-3 2023-9 | Not | ZH | HG | Github | เว็บไซต์

- Publisher: Fudan University et al.

- Size: 200K instances

- ใบอนุญาต: -

- Question Type: SQ

- Evaluation Method: ME

- Focus: Subject-specific knowledge capability

- Numbers of Evaluation Categories/Subcategories: 13/-

- Evaluation Category: Philosophy, Economics, Law, Education, Literature, History, Science, Engineering, Agriculture, Medicine, Military science, Management, Fine arts

MMCU 2023-4 | All | ZH | HG | Paper | คนอื่น ๆ

- Publisher: LanguageX AI Lab

- Size: 11845 instances

- ใบอนุญาต: -

- Question Type: OQ

- Evaluation Method: CE

- Focus: Multidisciplinary abilities

- Numbers of Evaluation Categories/Subcategories: 4/25

- Evaluation Category: Medicine, Law, Psychology, Education

MMLU 2020-9 | All | EN | HG | Paper | คนอื่น ๆ

- Publisher: UC Berkeley et al.

- Size: 15908 instances

- License: MIT

- Question Type: OQ

- Evaluation Method: CE

- Focus: Knowledge in academic and professional domains

- Numbers of Evaluation Categories/Subcategories: 4/57

- Evaluation Category: Humanities, Social science, STEM, Other

M3KE 2023-5 | All | ZH | HG | Paper | Github | ชุดข้อมูล

- Publisher: Tianjin University et al.

- Size: 20477 instances

- License: Apache-2.0

- Question Type: OQ

- Evaluation Method: CE

- Focus: Multidisciplinary abilities

- Numbers of Evaluation Categories/Subcategories: 4/71

- Evaluation Category: Arts & Humanities, Social sciences, Natural sciences, Other

SCIBENCH 2023-7 | All | EN | HG | Paper | คนอื่น ๆ

- Publisher: University of California et al.

- Size: 695 instances

- License: MIT

- Question Type: SQ

- Evaluation Method: CE

- Focus: The performance in university-level science and engineering domains

- Numbers of Evaluation Categories/Subcategories: 3/10

- Evaluation Category: Physics, Chemistry, Math

ScienceQA 2022-9 | All | EN | HG | Paper | Github | เว็บไซต์

- Publisher: University of California et al.

- Size: 21208 instances

- License: CC-BY-NC-SA-4.0

- Question Type: OQ

- Evaluation Method: CE

- Focus: Science question-answering ability

- Numbers of Evaluation Categories/Subcategories: 3/26

- Evaluation Category: Natural science, Social science, Language science

TheoremQA 2023-5 | All | EN | HG | Paper | Github | ชุดข้อมูล

- Publisher: University of Waterloo et al.

- Size: 800 instances

- License: MIT

- Question Type: SQ

- Evaluation Method: CE

- Focus: Science subject question-answering ability

- Numbers of Evaluation Categories/Subcategories: 4/39

- Evaluation Category: Mathematics, Physics, Finance, CS & EE

XiezhiBenchmark 2023-6 | All | EN & ZH | HG & MC | Paper | คนอื่น ๆ

- Publisher: Fudan University et al.

- Size: 249587 instances

- License: CC-BY-NC-SA-4.0

- Question Type: OQ

- Evaluation Method: CE

- Focus: Multidisciplinary abilities

- Numbers of Evaluation Categories/Subcategories: 13/516

- Evaluation Category: Medicine, Literature, Economics, Agronomy, Science, Jurisprudence, History, Art studies, Philosophy, Pedagogy, Military science, Management, Engineering

CMMLU 2023-6 | All | ZH | HG | Paper | Github | ชุดข้อมูล

- Publisher: MBZUAI

- Size: 11528 instances

- License: CC-BY-NC-4.0

- Question Type: OQ

- Evaluation Method: CE

- Focus: The knowledge and reasoning capabilities within the Chinese context

- Numbers of Evaluation Categories/Subcategories: 5/67

- Evaluation Category: Social science, STEM, Humanities, China specific, Other

GPQA 2023-11 | All | EN | HG | Paper | Github | ชุดข้อมูล

- Publisher: New York University et al.

- Size: 448 instances

- License: CC-BY-4.0

- Question Type: OQ

- Evaluation Method: CE

- Focus: The disciplinary knowledge in the fields of biology, physics, and chemistry

- Numbers of Evaluation Categories/Subcategories: 3/16

- Evaluation Category: Biology, Physics, Chemistry